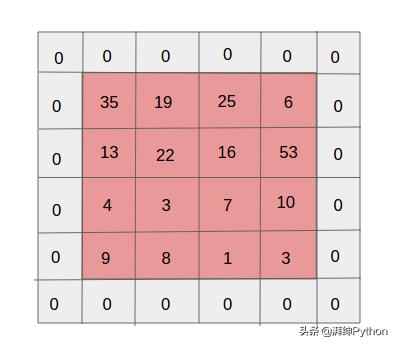

еЎ«е……еңЁиҫ“е…ҘеҚ·з§Ҝзҡ„еӨ–йғЁж·»еҠ йўқеӨ–зҡ„0 пјҢ д»ҘдҫҝеҚ·з§ҜжңҖз»Ҳе…·жңүдёҺиҫ“е…ҘзӣёеҗҢж•°йҮҸзҡ„иҫ“еҮә гҖӮ еҰӮжһңжҲ‘们дёҚдҪҝз”ЁеЎ«е…… пјҢ еҲҷеңЁжҜҸдёӘеҚ·з§ҜеұӮд№ӢеҗҺ пјҢ иҫ№з•ҢеӨ„зҡ„дҝЎжҒҜе°ҶдёўеӨұ пјҢ иҝҷе°ҶеҮҸе°ҸеҚ·з§Ҝзҡ„еӨ§е°Ҹд»ҘеҸҠжҖ§иғҪ гҖӮ

зұ»еһӢпјҡжңүж•ҲеЎ«е…… пјҢ зӣёеҗҢеЎ«е…… гҖӮ

еңЁжңүж•ҲеЎ«е……дёӯ пјҢ дёҺиҫ“е…ҘзӣёжҜ” пјҢ иҜҘзү№еҫҒзҡ„з»ҙеәҰйҷҚдҪҺ пјҢ иҖҢеңЁзӣёеҗҢеЎ«е……дёӯ пјҢ з»ҙеәҰеўһеҠ жҲ–дҝқжҢҒзӣёеҗҢ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

йӣ¶еЎ«е……

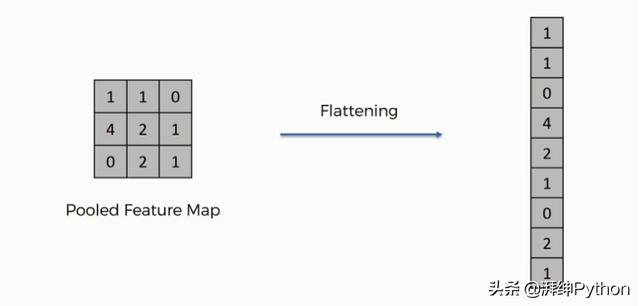

еұ•е№іпјҲFlattening пјүпјҡ

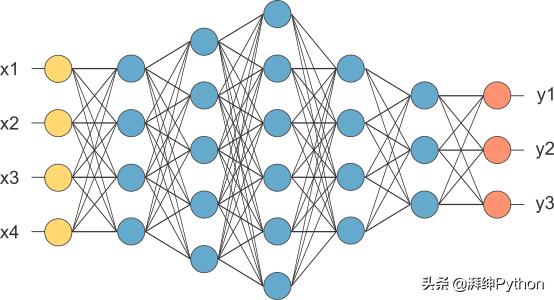

еңЁеә”з”ЁдәҶжүҖжңүдёҠиҝ°еұӮеҗҺ пјҢ жҲ‘们еҫ—еҲ°зҹ©йҳөеҪўејҸзҡ„жңҖз»Ҳиҫ“еҮә пјҢ дҪҶзҘһз»ҸзҪ‘з»ңйңҖиҰҒеҗ‘йҮҸеҪўејҸпјҲ1Dпјүзҡ„иҫ“е…Ҙж•°жҚ® пјҢ еӣ жӯӨжҲ‘们йңҖиҰҒе°ҶжҲ‘们зҡ„жұ еҢ–зҡ„зү№еҫҒжҳ е°„еұ•е№іжҲҗеҰӮдёӢеӣҫжүҖзӨәзҡ„еҲ— гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

е®Ңе…ЁиҝһжҺҘеұӮпјҲFully connected LayerпјүпјҲFCпјүпјҡ

еңЁиҝҷйҮҢ пјҢ жҲ‘们е°Ҷеұ•е№іж•°жҚ®жҸҗдҫӣз»ҷFCзҡ„иҫ“е…ҘеұӮпјҲдҫӢеҰӮ x1 пјҢ x2 ...пјү гҖӮ жҲ‘们еңЁдёӯй—ҙеұӮеә”з”ЁReLUзӯүжҝҖжҙ»еҮҪж•° гҖӮ

иҝҷйҮҢеҹәжң¬зҡ„зҘһз»ҸзҪ‘з»ңе·ҘдҪңеҸ‘з”ҹеғҸеҸҚеҗ‘дј ж’ӯ пјҢ дјҳеҢ– гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

жҝҖжҙ»еҮҪж•°пјҡ

еңЁдёӯй—ҙеұӮдёӯ пјҢ дјҳйҖүReLu пјҢ иҖҢеҜ№дәҺиҫ“еҮәеұӮ пјҢ еҲҷдҪҝз”ЁSoftmaxжҲ–sigmoid гҖӮ

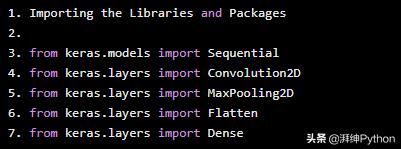

д»ҘдёӢжҳҜйғЁеҲҶд»Јз Ғеұ•зӨәпјҡ

Importing the Libraries and Packagesfrom keras.models import Sequentialfrom keras.layers import Convolution2Dfrom keras.layers import MaxPooling2Dfrom keras.layers import Flattenfrom keras.layers import Dense ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

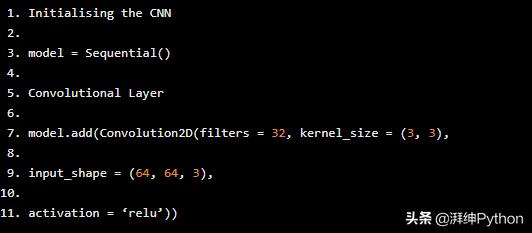

еҲӣе»әзҘһз»ҸзҪ‘з»ңзҡ„第дёҖжӯҘжҳҜдҪҝз”Ёkerasдёӯзҡ„йЎәеәҸзұ»еҲқе§ӢеҢ–зҪ‘з»ң гҖӮ

Initialising the CNNmodel = Sequential()Convolutional Layermodel.add(Convolution2D(filters = 32, kernel_size = (3, 3),input_shape = (64, 64, 3),activation = вҖҳreluвҖҷ)) ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

жұ еҢ–еұӮ

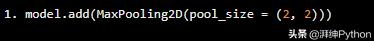

model.add(MaxPooling2D(pool_size = (2, 2))) ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

pool_sizeпјҡжұ еҢ–зӘ—еҸЈзҡ„еҪўзҠ¶ гҖӮ

еұ•е№іеұӮ

model.add(Flatten())е®Ңе…ЁиҝһжҺҘзҡ„еұӮ

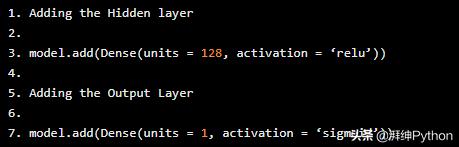

Adding the Hidden layermodel.add(Dense(units = 128, activation = вҖҳreluвҖҷ))Adding the Output Layermodel.add(Dense(units = 1, activation = вҖҳsigmoidвҖҷ)) ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

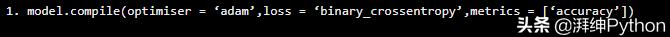

зј–иҜ‘CNN

model.compile(optimiser = вҖҳadamвҖҷ,loss = вҖҳbinary_crossentropyвҖҷ,metrics = [вҖҳaccuracyвҖҷ]) ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

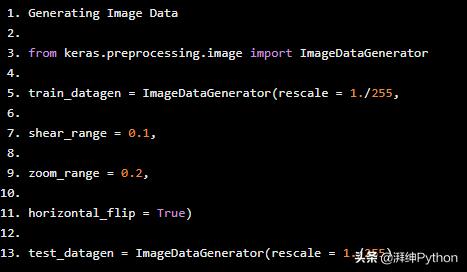

йҮҚиҰҒжҸҗзӨәпјҡ

еҰӮжһңи®ӯз»ғзҡ„ж•°жҚ®йқһеёёе°‘ пјҢ йӮЈд№ҲжҲ‘们еҸҜд»ҘйҖҡиҝҮеә”з”Ёзј©ж”ҫ пјҢ зҝ»иҪ¬еҺҹе§ӢеӣҫеғҸе’ҢеҲӣе»әж–°еӣҫеғҸзӯүж“ҚдҪңд»ҺзҺ°жңүж•°жҚ®еҲӣе»әж–°ж•°жҚ® гҖӮ

Generating Image Datafrom keras.preprocessing.image import ImageDataGeneratortrain_datagen = ImageDataGenerator(rescale = 1./255,shear_range = 0.1,zoom_range = 0.2,horizontal_flip = True)test_datagen = ImageDataGenerator(rescale = 1./255) ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

жҺЁиҚҗйҳ…иҜ»

- Windows10е°Ҷж°ёд№…еҲ йҷӨFlash PlayerпјҢдёҖеҠ 9и‘Ўиҗ„зҙ«й…ҚиүІдёҠжүӢеӣҫжӣқе…ү

- зү©иҒ”зҪ‘жӣҙеҠ жҷәиғҪе®үе…Ёпјҡз ”з©¶дәәе‘ҳејҖеҸ‘еҫ®еһӢзҘһз»ҸзҪ‘з»ңпјҢдҪ 家еҶ°з®ұд»ҘеҗҺд№ҹиғҪж·ұеәҰеӯҰд№ дәҶ

- Layer 2ж–№жЎҲвҖ”вҖ”DeFiеҸҜиғҪдёҚдјҡд»Һд»ҘеӨӘеқҠдёҠиҝҒеҫҷеҮәеҺ»дәҶ

- дёәд»Җд№ҲиҜҙеҚ·з§ҜзҘһз»ҸзҪ‘з»ңпјҢжҳҜж·ұеәҰеӯҰд№ з®—жі•еә”з”ЁжңҖжҲҗеҠҹзҡ„йўҶеҹҹд№ӢдёҖпјҹ

- жү©еұ•еӣҫзҘһз»ҸзҪ‘з»ңпјҡжҡҙеҠӣе ҶеҸ жЁЎеһӢж·ұеәҰ并дёҚеҸҜеҸ–

- иҫ“еҮәеұӮ|PyTorchеҸҜи§ҶеҢ–зҗҶи§ЈеҚ·з§ҜзҘһз»ҸзҪ‘з»ң

- еҹәдәҺзҘһз»ҸзҪ‘з»ңзҡ„йЈҺж јиҝҒ移зӣ®ж ҮжҚҹеӨұи§Јжһҗ

- дәәдҪ“|з”ЁдәҺеҚ•зӣ®3DдәәдҪ“е§ҝжҖҒдј°и®Ўзҡ„еұҖйғЁиҝһжҺҘзҪ‘з»ңпјҢе…ӢжңҚеӣҫеҚ·з§ҜзҪ‘з»ңйҷҗеҲ¶

- еӣҫзҘһз»ҸзҪ‘з»ңеҝ«йҖҹзҲҶеҸ‘пјҢжңҖж–°иҝӣеұ•йғҪеңЁиҝҷйҮҢдәҶ

- йә»зңҒзҗҶе·ҘеӯҰйҷўзҡ„зҘһз»ҸзҪ‘з»ңзҹҘйҒ“иҮӘе·ұд»Җд№Ҳж—¶еҖҷеҸҜд»Ҙиў«дҝЎд»»