жү©еұ•еӣҫзҘһз»ҸзҪ‘з»ңпјҡжҡҙеҠӣе ҶеҸ жЁЎеһӢж·ұеәҰ并дёҚеҸҜеҸ–

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

зј–иҜ‘ | Mr Bear

зј–иҫ‘ | йҷҲеӨ§й‘«

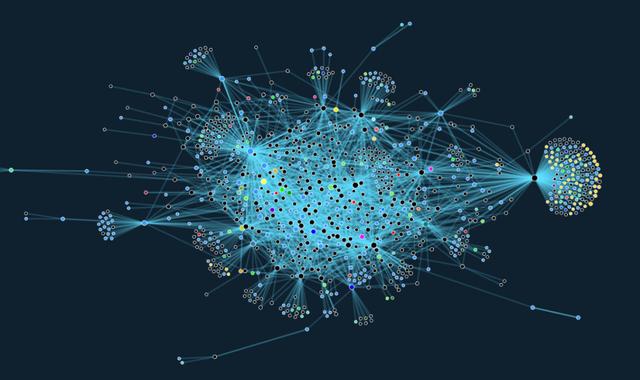

зӣ®еүҚ пјҢ йҳ»зўҚеӣҫзҘһз»ҸзҪ‘з»ңеңЁдёҡз•ҢеӨ§и§„жЁЎеә”з”Ёзҡ„жҢ‘жҲҳд№ӢдёҖжҳҜпјҡеӣҫзҘһз»ҸзҪ‘з»ңеҫҲйҡҫиў«жү©еұ•еҲ° Twitter зҡ„з”ЁжҲ·е…іжіЁе…ізі»еӣҫиҝҷзұ»еӨ§еһӢеӣҫдёҠ гҖӮ

иҠӮзӮ№д№Ӣй—ҙзҡ„зӣёдә’дҫқиө–е…ізі»дҪҝжҲ‘们еҫҲйҡҫе°ҶжҚҹеӨұеҮҪж•°еҲҶи§Јдёәеҗ„дёӘзӢ¬з«ӢиҠӮзӮ№зҡ„еҪұе“Қ гҖӮ

еңЁжң¬ж–Үдёӯ пјҢ жҲ‘们д»Ӣз»ҚдәҶTwitter з ”еҸ‘зҡ„дёҖз§Қз®ҖеҚ•зҡ„еӣҫзҘһз»ҸзҪ‘з»ңжһ¶жһ„ пјҢ иҜҘжһ¶жһ„еҸҜд»ҘеңЁеӨ§еһӢеӣҫдёҠжңүж•Ҳе·ҘдҪң гҖӮ

1 еӣҫзҘһз»ҸзҪ‘з»ңд»Ӣз»Қ

еӣҫзҘһз»ҸзҪ‘з»ңпјҲGNNпјүжҳҜдёҖзұ»иҝ‘е№ҙжқҘйҖҗжёҗе…ҙиө·зҡ„жңәеҷЁеӯҰд№ жЁЎеһӢ пјҢ е®ғиў«з”ЁдәҺеӯҰд№ еӣҫз»“жһ„зҡ„ж•°жҚ® гҖӮ GNN е·Із»Ҹиў«жҲҗеҠҹең°еә”з”ЁдәҺеҜ№еҗ„з§ҚдёҚеҗҢйўҶеҹҹпјҲеҢ…жӢ¬зӨҫдјҡ科еӯҰгҖҒи®Ўз®—жңәи§Ҷи§үе’ҢеӣҫеҪўеӯҰгҖҒзІ’еӯҗзү©зҗҶеӯҰгҖҒеҢ–еӯҰгҖҒеҢ»еӯҰзӯүпјүзҡ„е…ізі»е’ҢдәӨдә’зҡ„зі»з»ҹиҝӣиЎҢе»әжЁЎ гҖӮ

зӣҙеҲ°жңҖиҝ‘ пјҢ иҜҘйўҶеҹҹеҶ…еӨ§еӨҡж•°зҡ„з ”з©¶д»ҚйҮҚзӮ№е…іжіЁдәҺз ”еҸ‘ж–°еһӢ GNN жЁЎеһӢ пјҢ 并且еңЁе°ҸеһӢеӣҫпјҲдҫӢеҰӮ пјҢ д»…д»…еҢ…еҗ«еӨ§зәҰ 5K иҠӮзӮ№зҡ„еј•з”ЁзҪ‘з»ң Cora д»Қ然被е№ҝжіӣдҪҝз”ЁпјүдёҠжөӢиҜ•иҝҷдәӣжЁЎеһӢпјӣзӣёеҜ№жқҘиҜҙ пјҢ еӨ„зҗҶеӨ§и§„жЁЎеә”з”Ёзҡ„з ”з©¶е·ҘдҪңйІңжңүдәәж¶үи¶і гҖӮ

еҸҰдёҖж–№йқў пјҢ е·Ҙдёҡз•Ңзҡ„е®һйҷ…й—®йўҳеҫҖеҫҖйңҖиҰҒеӨ„зҗҶи¶…еӨ§и§„жЁЎзҡ„еӣҫпјҲдҫӢеҰӮ пјҢ еҢ…еҗ«ж•°зҷҫдёҮиҠӮзӮ№гҖҒж•°еҚҒдәҝжқЎиҫ№зҡ„ Twitter жҲ– Facebook зҡ„зӨҫдәӨзҪ‘з»ңпјү гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

еӨ§еӨҡж•°зҺ°жңүзҡ„ж–ҮзҢ®дёӯжҸҸиҝ°зҡ„ж–№жі•еңЁиҝҷж ·зҡ„еӨ§и§„жЁЎеә”з”ЁеңәжҷҜдёӢ并дёҚйҖӮз”Ё гҖӮ

з®ҖиҖҢиЁҖд№Ӣ пјҢ GNN йҖҡиҝҮиҒҡеҗҲеұҖйғЁйӮ»еұ…иҠӮзӮ№зҡ„зү№еҫҒжқҘиҝӣиЎҢж“ҚдҪң гҖӮ еҪ“дёӢжөҒиЎҢзҡ„еӣҫеҚ·з§ҜзҪ‘з»ңпјҲGCNпјүжЁЎеһӢйҖҡиҝҮе°Ҷ d з»ҙиҠӮзӮ№зү№еҫҒз»„з»ҮеңЁдёҖдёӘ nГ—d зҡ„зҹ©йҳө X дёӯпјҲе…¶дёӯ пјҢ n д»ЈиЎЁиҠӮзӮ№зҡ„дёӘж•°пјү пјҢ еңЁеӣҫдёҠе®һзҺ°дәҶдёҖз§ҚжңҖз®ҖеҚ•зҡ„зұ»дјјдәҺеҚ·з§Ҝзҡ„ж“ҚдҪң пјҢ е®ғе°ҶиҠӮзӮ№еұӮйқўдёҠзҡ„еҸҳжҚўдёҺзӣёйӮ»иҠӮзӮ№д№Ӣй—ҙзҡ„зү№еҫҒдј йҖ’иһҚеҗҲдәҶиө·жқҘ гҖӮ

Y = ReLU(AXW).

еңЁиҝҷйҮҢ пјҢ W жҳҜеҗ„иҠӮзӮ№д№Ӣй—ҙе…ұдә«зҡ„еҸҜеӯҰд№ зҡ„зҹ©йҳө пјҢ A жҳҜдёҖдёӘзәҝжҖ§дј ж’ӯз®—еӯҗ пјҢ зӣёеҪ“дәҺйӮ»еұ…иҠӮзӮ№зү№еҫҒзҡ„еҠ жқғе№іеқҮ гҖӮ жӯЈеҰӮеңЁдј з»ҹзҡ„еҚ·з§ҜзҘһз»ҸзҪ‘з»ңпјҲCNNпјүдёӯдёҖж · пјҢ жҲ‘们еҸҜд»Ҙе°ҶеӨҡеұӮе ҶеҸ зҡ„иҝҷз§ҚеҪўејҸеә”з”ЁеңЁеәҸеҲ—дёӯ гҖӮ

GNN еҸҜд»Ҙиў«и®ҫи®Ўз”ЁдәҺеңЁиҠӮзӮ№еұӮйқўдёҠпјҲдҫӢеҰӮ пјҢ жЈҖжөӢзӨҫдәӨзҪ‘з»ңдёӯзҡ„жҒ¶ж„Ҹз”ЁжҲ·пјүгҖҒиҫ№зҡ„еұӮйқўдёҠпјҲдҫӢеҰӮ пјҢ жҺЁиҚҗзі»з»ҹдёӯе…ёеһӢзҡ„еңәжҷҜвҖ”вҖ”й“ҫжҺҘйў„жөӢпјүгҖҒжҲ–ж•ҙдёӘеӣҫзҡ„еұӮйқўдёҠпјҲдҫӢеҰӮ пјҢ йў„жөӢеҲҶеӯҗеӣҫзҡ„еҢ–еӯҰжҖ§иҙЁпјүиҝӣиЎҢйў„жөӢ гҖӮ дҫӢеҰӮ пјҢ жҲ‘们еҸҜд»ҘдҪҝз”ЁеҰӮдёӢжүҖзӨәзҡ„еҸҢеұӮ GCN жү§иЎҢиҠӮзӮ№зә§еҲ«зҡ„еҲҶзұ»д»»еҠЎпјҡ

Y = softmax(A ReLU(AXW)WвҖҷ).

2 жү©еұ•еӣҫзҘһз»ҸзҪ‘з»ңзҡ„жҢ‘жҲҳжҖ§

дёәд»Җд№Ҳжү©еұ•еӣҫзҘһз»ҸзҪ‘з»ңеҚҒеҲҶе…·жңүжҢ‘жҲҳжҖ§е‘ўпјҹ

еңЁдёҠиҝ°иҠӮзӮ№зә§еҲ«зҡ„йў„жөӢй—®йўҳдёӯ пјҢ GNN дјҡеңЁж ·жң¬иҠӮзӮ№дёҠиҝӣиЎҢи®ӯз»ғ гҖӮ

еңЁдј з»ҹзҡ„жңәеҷЁеӯҰд№ зҺҜеўғдёӢ пјҢ йҖҡеёёеҒҮи®ҫж ·жң¬жҳҜд»Ҙз»ҹи®ЎдёҠзӣёзӢ¬з«Ӣзҡ„ж–№ејҸд»ҺжҹҗдёӘеҲҶеёғдёӯйҮҮж ·еҫ—еҲ°зҡ„ гҖӮ еҸҚиҝҮжқҘ пјҢ иҝҷж ·е°ұеҸҜд»Ҙе°ҶжҚҹеӨұеҮҪж•°еҲҶи§ЈдёәзӢ¬з«Ӣж ·жң¬зҡ„иҙЎзҢ® пјҢ 并йҮҮз”ЁйҡҸжңәдјҳеҢ–жҠҖжңҜ гҖӮ

然иҖҢ пјҢ еӣҫдёӯзҡ„иҠӮзӮ№жҳҜйҖҡиҝҮиҫ№зӣёдә’е…іиҒ”зҡ„ пјҢ иҝҷдҪҝеҫ—и®ӯз»ғйӣҶдёӯзҡ„ж ·жң¬еңЁз»ҹи®Ўж„Ҹд№үдёҠзӣёдә’дҫқиө– гҖӮ жӯӨеӨ– пјҢ з”ұдәҺиҠӮзӮ№д№Ӣй—ҙзҡ„з»ҹи®Ўдҫқиө–жҖ§ пјҢ йҮҮж ·иҝҮзЁӢеҸҜиғҪдјҡеј•е…ҘеҒҸзҪ® гҖӮ

дҫӢеҰӮ пјҢ иҝҷеҸҜиғҪдҪҝеҫ—дёҖдәӣиҠӮзӮ№жҲ–иҫ№еңЁи®ӯз»ғйӣҶдёӯжҜ”е…¶е®ғиҠӮзӮ№жҲ–иҫ№еҮәзҺ°еҫ—жӣҙйў‘з№Ғ пјҢ иҖҢжҲ‘们йңҖиҰҒжҒ°еҪ“ең°еә”еҜ№иҝҷз§ҚгҖҢеүҜдҪңз”ЁгҖҚ гҖӮ

жңҖеҗҺ пјҢ еҗҢж ·йҮҚиҰҒзҡ„жҳҜ пјҢ жҲ‘们йңҖиҰҒдҝқиҜҒйҮҮж ·еҫ—еҲ°зҡ„еӯҗеӣҫиғҪеӨҹдҝқз•ҷ GNN еҸҜд»ҘеҲ©з”Ёзҡ„жңүж„Ҹд№үзҡ„з»“жһ„ гҖӮ

еңЁи®ёеӨҡж—©жңҹзҡ„еӣҫзҘһз»ҸзҪ‘з»ңе·ҘдҪңдёӯ пјҢ 并жңӘиҖғиҷ‘дёҠиҝ°й—®йўҳпјҡиҜёеҰӮ GCNпјҲеӣҫеҚ·з§ҜзҪ‘з»ңпјүгҖҒChebNetгҖҒMoNet е’Ң GAT зӯүзҪ‘з»ңжһ¶жһ„йғҪжҳҜдҪҝз”Ёе…Ёжү№йҮҸжўҜеәҰдёӢйҷҚпјҲfull-batch gradient descentпјүз®—жі•и®ӯз»ғзҡ„ гҖӮ

иҝҷдҪҝжҲ‘们еҝ…йЎ»еңЁеҶ…еӯҳдёӯз»ҙжҢҒе…ЁйғЁеӣҫзҡ„йӮ»жҺҘзҹ©йҳөд»ҘеҸҠиҠӮзӮ№зү№еҫҒ гҖӮ еӣ жӯӨ пјҢ дёҖдёӘ L еұӮзҡ„ GCN жЁЎеһӢе°ұе…·жңүдәҶ O(Lnd2) зҡ„ж—¶й—ҙеӨҚжқӮеәҰе’Ң O(Lnd +Ld2) зҡ„з©әй—ҙеӨҚжқӮеәҰ пјҢ еҚідҪҝеҜ№дәҺеӨ§е°ҸйҖӮеәҰзҡ„еӣҫжқҘиҜҙ пјҢ иҝҷд№ҹжҳҜж— жі•жҺҘеҸ—зҡ„ гҖӮ

GraphSAGE жҳҜз ”з©¶еӣҫзҘһз»ҸзҪ‘и·Ҝзҡ„еҸҜжү©еұ•жҖ§й—®йўҳзҡ„第дёҖйЎ№е·ҘдҪң пјҢ е®ғжҳҜ Will Hamilton зӯүдәәж’°еҶҷзҡ„еҘ еҹәжҖ§и®әж–Ү гҖӮ GraphSAGE е°ҶйӮ»еұ…иҠӮзӮ№йҮҮж ·дёҺ mini-batch и®ӯз»ғз»“еҗҲдәҶиө·жқҘ пјҢ д»ҺиҖҢеңЁеӨ§и§„жЁЎеӣҫдёҠи®ӯз»ғ GNNпјҲгҖҢSAGEгҖҚжҢҮзҡ„жҳҜгҖҢйҮҮж ·дёҺиҒҡеҗҲгҖҚпјү гҖӮ

жҺЁиҚҗйҳ…иҜ»

- KensingtonеҸ‘еёғStudioDock е°ҶiPad Proжү©еұ•еқһдёҺж— зәҝе……з”өеҷЁзӣёз»“еҗҲ

- и…ҫи®ҜдёҺй•ҝдёүи§’G60科еҲӣиө°е»ҠвҖңзүөжүӢвҖқпјҡжү©еұ•з§‘еҲӣвҖңжңӢеҸӢеңҲвҖқжҺЁиҝӣеҹҺеёӮж•°еӯ—еҢ–иҪ¬еһӢ

- еҪұй©°еҸ‘еёғз»Ҹе…ёзүҲRTX 3090/3080пјҡжҡҙеҠӣж¶ЎиҪ®йЈҺжүҮжҲҗдәҶж–°жҪ®

- 欧зүҲGalaxy S21зі»еҲ—е°ҶдёҚж”ҜжҢҒ MicroSD еҚЎжү©еұ•

- AMDдё“еҲ©жі„еҜҶпјҡRDNA3жҳҫеҚЎжҡҙеҠӣе Ҷж ё

- жҲҙе°”WD19TBжү©еұ•еқһ иҪ»и–„еҠһе…¬еҘҪеё®жүӢ

- еӨ–жҺҘеҶ…зҪ®дёҖж ·еҝ«пјҒеёҢжҚ·Xbox Series XеӯҳеӮЁжү©еұ•еҚЎиҜ„жөӢ

- OPPOжӯЈеңЁз ”еҸ‘дёҖж¬ҫеұҸ幕еҸҜеһӮзӣҙжү©еұ•зҡ„жҷәиғҪжүӢжңә

- жө·еӨ–иҝҗиҗҘе•ҶжҡҙеҠӣеұҸи”Ҫе°ҸзұіеҸҢеҚЎеҠҹиғҪпјҢйҒӯеҲ°з”ЁжҲ·иө·иҜү

- WDиҘҝж•°жҺЁеҮәйӣ·з”ө3 SSDжү©еұ•еқһпјҢ2TBеӣәжҖҒ87W PDеҝ«е……