基于神经网络的风格迁移目标损失解析

文章插图

文章插图

今天我想谈谈神经类型的转移和卷积神经网络 。 已有相当多的文章和教程可供使用 。 有时内容只是复制 , 有些则提供了一种新颖的实现 。 它们的共同之处在于对细节的快速钻研 。 在我看来太具体了 。 不仅如此 , 通常还有一些实现细节 , 这使得将重点放在整体的主要概念上变得更加困难 。

这篇文章可以看作是对其他文章的概述和理解 , 以便在更高的层次上理解这个概念 。 我的意图是去掉一些实现细节 , 使其足够高 , 足以满足初学者的需要 , 并激发他们阅读原始研究论文和后续实现的好奇心 。

基于神经网络的风格迁移这个方法来自于论文《A Neural Algorithm of Artistic Style 》

在美术领域 , 特别是绘画领域 , 人们已经掌握了通过构图内容和图像风格之间复杂的相互作用来创造独特视觉体验的技能 。 到目前为止 , 这一过程的算法基础是未知的 , 也不存在具有类似能力的人工系统 。 然而 , 在CV的其他关键领域 , 如物体识别和人脸识别 , 最近通过一类被称为深度神经网络的启发视觉模型 , 证明了接近人类的表现 。 在此 , 我们介绍了一个基于深度神经网络的人工系统 , 它可以创建具有高感知质量的艺术图像 。

该系统使用神经表示来分离和重组任意图像的内容和风格 , 为艺术图像的创建提供了一种神经算法 。 此外 , 考虑到性能优化的人工神经网络与生物视觉之间惊人的相似性 , 我们的工作为理解人类如何创造和感知艺术图像的算法提供了一条道路 。

架构和流程概述关于CNN是如何处理神经类型转换的 , 有很多很好的可视化方法 。 我想自己画 , 但后来我意识到已经有很好的画板了 。 我将展示这些别人已经画好的图示

下面这些我认为是非常棒的 。

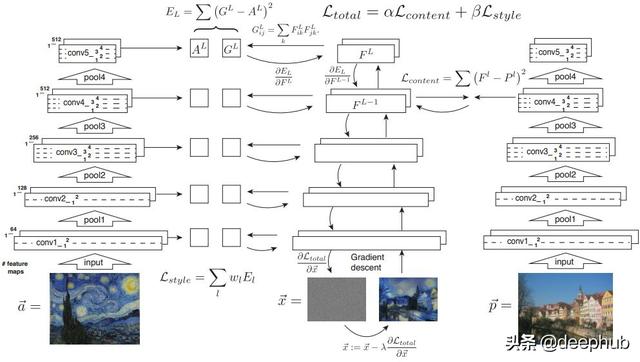

首先这一个 。 它完美地展示了损失是如何计算的 , 以及它是如何与整体结果相匹配的 。

文章插图

文章插图

来自mike gaos blog()

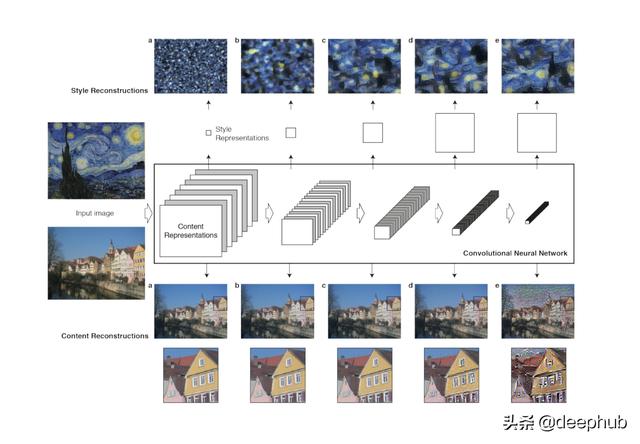

这个也不错 。 在不同的层上显示重建过程 。

文章插图

文章插图

该图来自原论文

为了理解后面的计算 , 有必要说明CNN的不同层代表什么 。

CNN的浅层倾向于检测低层次的特征 , 如边缘和简单的纹理 。 更深层次的层倾向于检测更高层次的特性 , 比如更复杂的纹理和对象类 。

因为生成的图像应具有与输入图像相似的内容 。建议在中间使用一层 , 以较高程度表示内容 。

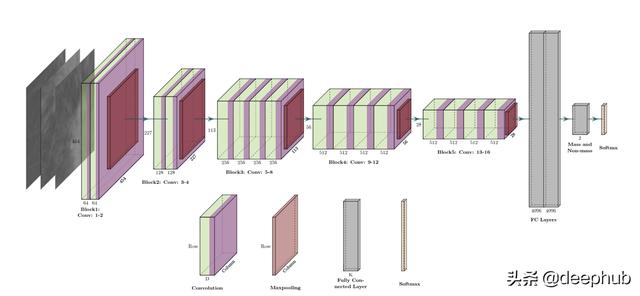

文章插图

文章插图

例VGG-19架构

迁移学习和风格迁移另一个重要的概念是使用预先训练好的网络 。 上面所展示的VGG-19 。 值得注意的是 , 我们使用了所谓的"迁移学习" 。

这里我们有两个概念来区分:

迁移学习

风格迁移

尽管两者都使用了"迁移"这个词 , 但从实现的角度来看 , 它们是完全不同的 。

转移学习:通过使用已建立的模型来创建新的解决方案 , 概念本身是非常有趣和有效的 。 在一种环境中学习到的东西被利用来提高在另一种环境中的泛化能力 。 这在计算机视觉中尤其有用 , 因为这些模型的计算和训练非常耗费资源 。 使用一个在巨大数据集上训练过的模型 , 其结果现在可以免费获得 , 这对于个体实验来说是非常好的 。

风格迁移:从概念上讲 , 最密切相关的是使用纹理转移实现艺术风格转移的方法 。然而 , 这些先前的方法主要依赖于非参数技术来直接操纵图像的像素表示 。相比之下 , 通过使用经过对象识别训练的深度神经网络 , 我们可以在特征空间中进行操作 , 以明确表示图像的高级内容 。

推荐阅读

- 华硕基于WRX80的主板现身 为AMD Ryzen Threadripper Pro打造

- 微软新版电子邮件客户端截图曝光:基于网页端Outlook

- 曝光 | 小鹏或春节前推送NGP更新,基于高精地图可自动变道

- 华为鸿蒙手机太难了!引发开发者大吐槽:为何没有自己独特风格?

- 基于Spring+Angular9+MySQL开发平台

- 14款华为手机/平板公测EMUI 11:全部基于麒麟980

- AI赋能,让消防、用电更“智慧”

- 基于安卓11打造!魅族17系列将升级全新Flyme 8

- 谷歌为用户提供了基于AR的虚拟化妆体验

- 智能化社区是智慧城市重要的组成部分