и®Ўз®—жңәи§Ҷи§ү"ж–°"иҢғејҸпјҡTransformer | NLPе’ҢCVиғҪз”ЁеҗҢдёҖз§ҚиҢғејҸжқҘиЎЁиҫҫеҗ—пјҹ( дә” )

з»ҸиҝҮдёҠйқўзҡ„и§ЈйҮҠ пјҢ жҲ‘们зҹҘйҒ“ е’Ң зҡ„зӮ№д№ҳжҳҜдёәдәҶеҫ—еҲ°дёҖдёӘattention score зҹ©йҳө пјҢ з”ЁжқҘеҜ№ иҝӣиЎҢжҸҗзӮј гҖӮе’Ң дҪҝз”ЁдёҚеҗҢзҡ„ , жқҘи®Ўз®— пјҢ еҸҜд»ҘзҗҶи§ЈдёәжҳҜеңЁдёҚеҗҢз©әй—ҙдёҠзҡ„жҠ•еҪұ гҖӮ

жӯЈеӣ дёәжңүдәҶиҝҷз§ҚдёҚеҗҢз©әй—ҙзҡ„жҠ•еҪұ пјҢ еўһеҠ дәҶиЎЁиҫҫиғҪеҠӣ пјҢ иҝҷж ·и®Ўз®—еҫ—еҲ°зҡ„attention scoreзҹ©йҳөзҡ„жіӣеҢ–иғҪеҠӣжӣҙй«ҳ гҖӮ

иҝҷйҮҢи§ЈйҮҠдёӢжҲ‘зҗҶи§Јзҡ„жіӣеҢ–иғҪеҠӣ пјҢ еӣ дёә е’Ң дҪҝз”ЁдәҶдёҚеҗҢзҡ„ , жқҘи®Ўз®— пјҢ еҫ—еҲ°зҡ„д№ҹжҳҜдёӨдёӘе®Ңе…ЁдёҚеҗҢзҡ„зҹ©йҳө пјҢ жүҖд»ҘиЎЁиҫҫиғҪеҠӣжӣҙејә гҖӮ

дҪҶжҳҜеҰӮжһңдёҚз”ЁпјҢ зӣҙжҺҘжӢҝ е’Ң зӮ№д№ҳзҡ„иҜқ пјҢ attention score зҹ©йҳөжҳҜдёҖдёӘеҜ№з§°зҹ©йҳө пјҢ жүҖд»ҘжіӣеҢ–иғҪеҠӣеҫҲе·® пјҢ иҝҷдёӘзҹ©йҳөеҜ№ иҝӣиЎҢжҸҗзӮј пјҢ ж•ҲжһңдјҡеҸҳе·® гҖӮ

иҜҰз»ҶеҲҶжһҗеҸҜд»ҘзңӢй“ҫжҺҘж–Үз«

еҰӮдҪ•Position EmbeddingжӣҙеҘҪпјҹ

зӣ®еүҚиҝҳжҳҜдёҖдёӘејҖж”ҫй—®йўҳ пјҢ зҹҘд№ҺдёҠжңүдёҖдәӣдјҳиҙЁзҡ„и®Ёи®ә пјҢ иҜҰз»ҶеҲҶжһҗеҸҜд»ҘзңӢй“ҫжҺҘж–Үз«

NLP:

CV:

ViTдёәд»Җд№ҲиҰҒеўһеҠ дёҖдёӘ[CLS]ж Үеҝ—дҪҚ? дёәд»Җд№Ҳе°Ҷ[CLS]ж Үеҝ—дҪҚеҜ№еә”зҡ„еҗ‘йҮҸдҪңдёәж•ҙдёӘеәҸеҲ—зҡ„иҜӯд№үиЎЁзӨә?

е’ҢBERTзӣёзұ»дјј пјҢ ViTеңЁеәҸеҲ—еүҚж·»еҠ дёҖдёӘеҸҜеӯҰд№ зҡ„[CLS]ж Үеҝ—дҪҚ гҖӮ д»ҘBERTдёәдҫӢ пјҢ BERTеңЁз¬¬дёҖеҸҘеүҚж·»еҠ дёҖдёӘ[CLS]ж Үеҝ—дҪҚ пјҢ жңҖеҗҺдёҖеұӮиҜҘж Үеҝ—дҪҚеҜ№еә”зҡ„еҗ‘йҮҸеҸҜд»ҘдҪңдёәж•ҙеҸҘиҜқзҡ„иҜӯд№үиЎЁзӨә пјҢ д»ҺиҖҢз”ЁдәҺдёӢжёёзҡ„еҲҶзұ»д»»еҠЎзӯү гҖӮ

е°Ҷ[CLS]ж Үеҝ—дҪҚеҜ№еә”зҡ„еҗ‘йҮҸдҪңдёәж•ҙдёӘж–Үжң¬зҡ„иҜӯд№үиЎЁзӨә пјҢ жҳҜеӣ дёәдёҺж–Үжң¬дёӯе·Іжңүзҡ„е…¶е®ғиҜҚзӣёжҜ” пјҢ иҝҷдёӘж— жҳҺжҳҫиҜӯд№үдҝЎжҒҜзҡ„з¬ҰеҸ·дјҡжӣҙвҖңе…¬е№івҖқең°иһҚеҗҲж–Үжң¬дёӯеҗ„дёӘиҜҚзҡ„иҜӯд№үдҝЎжҒҜ пјҢ д»ҺиҖҢжӣҙеҘҪзҡ„иЎЁзӨәж•ҙеҸҘиҜқзҡ„иҜӯд№ү гҖӮ

еҪ’зәіеҒҸеҘҪжҳҜд»Җд№Ҳпјҹ

еҪ’зәіеҒҸзҪ®еңЁжңәеҷЁеӯҰд№ дёӯжҳҜдёҖз§ҚеҫҲеҫ®еҰҷзҡ„жҰӮеҝөпјҡеңЁжңәеҷЁеӯҰд№ дёӯ пјҢ еҫҲеӨҡеӯҰд№ з®—жі•з»ҸеёёдјҡеҜ№еӯҰд№ зҡ„й—®йўҳеҒҡдёҖдәӣеҒҮи®ҫ пјҢ иҝҷдәӣеҒҮи®ҫе°ұз§°дёәеҪ’зәіеҒҸеҘҪ(Inductive Bias) гҖӮ

еҪ’зәіеҒҸзҪ®еҸҜд»ҘзҗҶи§Јдёә пјҢ д»ҺзҺ°е®һз”ҹжҙ»дёӯи§ӮеҜҹеҲ°зҡ„зҺ°иұЎдёӯеҪ’зәіеҮәдёҖе®ҡзҡ„规еҲҷ(heuristics) пјҢ 然еҗҺеҜ№жЁЎеһӢеҒҡдёҖе®ҡзҡ„зәҰжқҹ пјҢ д»ҺиҖҢеҸҜд»Ҙиө·еҲ°вҖңжЁЎеһӢйҖүжӢ©вҖқзҡ„дҪңз”Ё пјҢ еҚід»ҺеҒҮи®ҫз©әй—ҙдёӯйҖүжӢ©еҮәжӣҙз¬ҰеҗҲзҺ°е®һ规еҲҷзҡ„жЁЎеһӢ гҖӮ еҸҜд»ҘжҠҠеҪ’зәіеҒҸеҘҪзҗҶи§ЈдёәиҙқеҸ¶ж–ҜеӯҰд№ дёӯзҡ„вҖңе…ҲйӘҢвҖқ гҖӮ

еңЁж·ұеәҰеӯҰд№ дёӯ пјҢ д№ҹдҪҝз”ЁдәҶеҪ’зәіеҒҸеҘҪ гҖӮ еңЁCNNдёӯ пјҢ еҒҮи®ҫзү№еҫҒе…·жңүеұҖйғЁжҖ§(Locality)зҡ„зү№зӮ№ пјҢ еҚіжҠҠзӣёйӮ»зҡ„дёҖдәӣзү№еҫҒиһҚеҗҲеҲ°дёҖиө· пјҢ дјҡжӣҙе®№жҳ“еҫ—еҲ°вҖңи§ЈвҖқпјӣеңЁRNNдёӯ пјҢ еҒҮи®ҫжҜҸдёҖж—¶еҲ»зҡ„и®Ўз®—дҫқиө–дәҺеҺҶеҸІи®Ўз®—з»“жһңпјӣиҝҳжңүattentionжңәеҲ¶ пјҢ д№ҹжҳҜд»Һдәәзҡ„зӣҙи§үгҖҒз”ҹжҙ»з»ҸйӘҢеҪ’зәіеҫ—еҲ°зҡ„规еҲҷ гҖӮ

иҖҢTransformerеҸҜд»ҘйҒҝе…ҚCNNзҡ„еұҖйғЁжҖ§еҪ’зәіеҒҸеҘҪй—®йўҳ гҖӮ дёҫдёҖдёӘDETRдёӯзҡ„дҫӢеӯҗ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

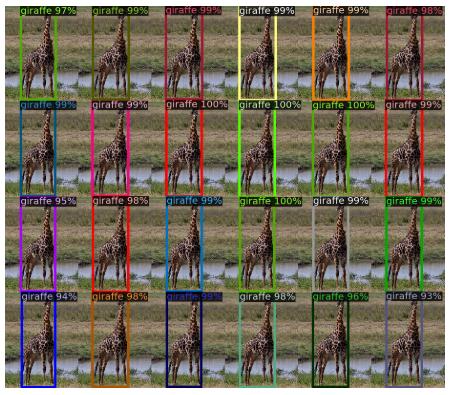

и®ӯз»ғйӣҶдёӯжІЎжңүи¶…иҝҮ13еҸӘй•ҝйўҲй№ҝзҡ„еӣҫеғҸ пјҢ DETRе®һйӘҢдёӯеҲӣе»әдәҶдёҖдёӘеҗҲжҲҗзҡ„еӣҫеғҸжқҘйӘҢиҜҒDETRзҡ„жіӣеҢ–иғҪеҠӣ пјҢ DERTеҸҜд»Ҙе®Ңе…ЁжүҫеҲ°еҗҲжҲҗзҡ„е…ЁйғЁ24еҸӘй•ҝйўҲй№ҝ гҖӮ иҝҷиҜҒе®һдәҶDETRйҒҝе…ҚдәҶCNNзҡ„еҪ’зәіеҒҸеҘҪй—®йўҳ гҖӮ

дәҢеҲҶеӣҫеҢ№й…Қ? еҢҲзүҷеҲ©з®—жі•пјҹ

з»ҷе®ҡдёҖдёӘдәҢеҲҶеӣҫG пјҢ еңЁGзҡ„дёҖдёӘеӯҗеӣҫMдёӯ пјҢ Mзҡ„иҫ№йӣҶ{E}дёӯзҡ„д»»ж„ҸдёӨжқЎиҫ№йғҪдёҚдҫқйҷ„дәҺеҗҢдёҖдёӘйЎ¶зӮ№ пјҢ еҲҷз§°MжҳҜдёҖдёӘеҢ№й…Қ гҖӮ жұӮдәҢеҲҶеӣҫжңҖеӨ§еҢ№й…ҚеҸҜд»Ҙз”ЁеҢҲзүҷеҲ©з®—жі• гҖӮ

иҜҰз»ҶеҲҶжһҗеҸҜд»ҘзңӢй“ҫжҺҘж–Үз«

BETRзҡ„positional embeddingгҖҒobject queriesе’ҢslotдёүиҖ…д№Ӣй—ҙжңүдҪ•е…ізі»пјҹ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

DETRеҸҜи§ҶеҢ–decoderйў„жөӢеҫ—еҲ°зҡ„20дёӘslot гҖӮ еҸҜд»Ҙи§ӮеҜҹеҲ°жҜҸдёӘslotеӯҰд№ еҲ°дәҶзү№е®ҡеҢәеҹҹзҡ„е°әеәҰеӨ§е°Ҹ гҖӮ Object queriesд»ҺиҝҷдёӘи§’еәҰзңӢ пјҢ е…¶е®һжңүзӮ№еғҸFaster-RCNNзӯүзӣ®ж ҮжЈҖжөӢеҷЁзҡ„anchor пјҢ з»“еҗҲencoderзҡ„positional embeddingдҝЎжҒҜи®©жҜҸдёӘslotеҫҖеӯҰд№ еҲ°зҡ„зү№е®ҡеҢәеҹҹеҺ»еҜ»жүҫзӣ®ж Ү гҖӮ

TransformerзӣёжҜ”дәҺCNNзҡ„дјҳзјәзӮ№?

дјҳзӮ№пјҡ

Transformerе…іжіЁе…ЁеұҖдҝЎжҒҜ пјҢ иғҪе»әжЁЎжӣҙеҠ й•ҝи·қзҰ»зҡ„дҫқиө–е…ізі» пјҢ иҖҢCNNе…іжіЁеұҖйғЁдҝЎжҒҜ пјҢ е…ЁеұҖдҝЎжҒҜзҡ„жҚ•жҚүиғҪеҠӣејұ гҖӮ

TransformerйҒҝе…ҚдәҶCNNдёӯеӯҳеңЁзҡ„еҪ’зәіеҒҸеҘҪй—®йўҳ гҖӮ

зјәзӮ№пјҡ

TransformerеӨҚжқӮеәҰжҜ”CNNй«ҳ пјҢ дҪҶжҳҜViTе’ҢDeformable DETRз»ҷеҮәдәҶдёҖдәӣи§ЈеҶіж–№жі•жқҘйҷҚдҪҺTransformerзҡ„еӨҚжқӮеәҰ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- дёәд»Җд№Ҳжңү"iphoneжҳҜз©·дәәжүӢжңә"зҡ„иЁҖи®әпјҹз”ЁдёҮе…ғжңәзҡ„дәәзңҹз©·еҗ—

- еӨ§дёҖйқһи®Ўз®—жңәдё“дёҡзҡ„еӯҰз”ҹпјҢеҰӮдҪ•еҲ©з”ЁеҜ’еҒҮиҮӘеӯҰCиҜӯиЁҖ

- еҸҲзҲҶзӮёпјҒиҒ”з”ө科жҠҖдј жқҘдёҖеЈ°е·Ёе“ҚпјҢжҲ–жҠҠ8 иӢұеҜёжҷ¶еңҶеёӮеңә"зӮё"дәҶ

- и®Ўз®—жңәдё“дёҡеӨ§дёҖдёӢеӯҰжңҹпјҢиҜҘйҖүжӢ©еӯҰд№ JavaиҝҳжҳҜPython

- йӣ·еҶӣеҶҚж¬Ўж”ҫеӨ§жӢӣпјҢе°Ҹзұі"иҪ»иЈ…дёҠйҳө"еҗҺпјҢеҚҺдёәиҝҳиғҪжүӣеҫ—дҪҸеҗ—пјҹ

- зҫҺеӣҪе…¬еҸёз ҙи§Ј"еҲ·и„ёж”Ҝд»ҳ"пјҹ用马дә‘з…§зүҮеҒҡе®һйӘҢпјҢз»“жһңеј№еҮә4дёӘеӨ§еӯ—

- иӢ№жһңж”№еҸҳз«Ӣеңә з§°macOSе®һз”ЁзЁӢеәҸAmphetamineеҸҜ继з»ӯз•ҷеңЁMacеә”з”Ёе•Ҷеә—дёӯ

- "дәҢе…«е®ҡеҫӢ"йҡҫз ҙ CPUеёӮеҚ зҺҮиӢұзү№е°”жҢҒз»ӯеҚ дјҳ

- иҫ№зјҳи®Ўз®—зӮ№зҮғж–°йЈҺжҡҙпјҢITдёҺOTд№ӢжҲҳдёҖи§ҰеҚіеҸ‘

- з”ЁдәҶдёӨеҲ°дёүе№ҙзҡ„еҚҺдёәжүӢжңәпјҢдёҖй”®жү“ејҖ"ејҖеҸ‘иҖ…йҖүйЎ№"пјҢеё®еҠ©жҖ§иғҪеҠ йҖҹ