Transformerз«һдәүеҜ№жүӢQRNNи®әж–Үи§ЈиҜ»жӣҙеҝ«зҡ„RNN( дёү )

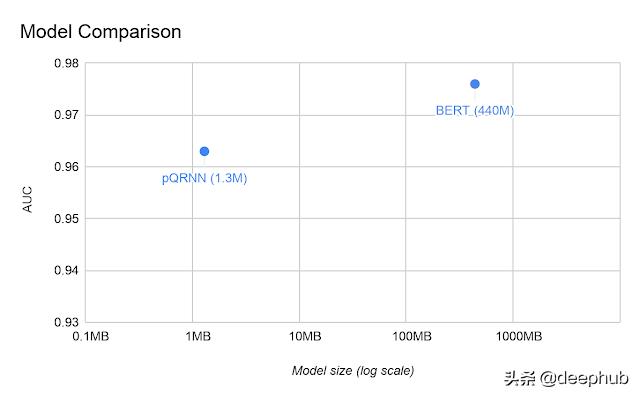

жңҖиҝ‘ пјҢ еҹәдәҺQRNNзҡ„жЁЎеһӢpQRNNеңЁеәҸеҲ—еҲҶзұ»дёҠд»…з”Ё1.3MеҸӮж•°е°ұеҸ–еҫ—дәҶдёҺBERTзӣёеҪ“зҡ„з»“жһңпјҲдёҺ440MеҸӮж•°зҡ„BERTзӣёеҜ№пјүпјҡ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

з»“и®әжҲ‘们ж·ұе…Ҙи®Ёи®әдәҶж–°йў–зҡ„QRNNжһ¶жһ„ гҖӮжҲ‘们зңӢеҲ°дәҶе®ғеҰӮдҪ•еңЁеҹәдәҺеҚ·з§Ҝзҡ„жЁЎеһӢдёӯеўһеҠ йҖ’еҪ’ пјҢ д»ҺиҖҢеҠ еҝ«дәҶеәҸеҲ—е»әжЁЎзҡ„йҖҹеәҰ гҖӮQRNNзҡ„йҖҹеәҰе’ҢжҖ§иғҪд№ҹи®ёзңҹзҡ„еҸҜд»Ҙжӣҝд»ЈTransformer гҖӮ

дҪңиҖ…пјҡRohan Jagtap

deephubзҝ»иҜ‘з»„

жҺЁиҚҗйҳ…иҜ»

- е°Ҹзұі11иҝҺжқҘеҜ№жүӢпјҢеӣҪйҷ…е·ЁеӨҙеҚіе°ҶеҮәеҮ»пјҢжҲ–йҮҮз”ЁвҖңеҸҢиҠҜзүҮвҖқж–№жЎҲ

- зҫҺеӘ’пјҡзҫҺеӣҪжӢүе°ҸејҹжҗһејҖж”ҫзҪ‘з»ң规иҢғж‘Ҷи„ұеҚҺдёә дҪҶжӣҙеӨҡдёӯеӣҪе…¬еҸёеҠ е…Ҙз«һдәүжҗ…й»„зҫҺж–№и®ЎеҲ’

- ж•°жҚ®жқҖзҶҹгҖҒеұҸи”ҪеҜ№жүӢпјҒйў‘йў‘вҖңжғ№дәӢвҖқзҡ„зҫҺеӣўйҒӯеҸҚеһ„ж–ӯиҜүи®ј

- иҜ¬йҷ·еҜ№жүӢпјҢз”©й”…е‘ҳе·ҘпјҢеҺҹжқҘзӨҫдәӨиөӣйҒ“зҡ„вҖңзҗғйңёвҖқжҳҜд»–пјҹ

- 2020е№ҙеәҰзӣҳзӮ№пҪңжүӢжңәеҺӮе•Ҷз«һдәүеҠ еү§пјҢеҠ йҖҹеҮәжө·гҖҒеҸ‘еҠӣIoTжһ„е»әз”ҹжҖҒжҲҗдё»жөҒ

- еҸҲдёҖиЎҢиҝҺвҖңе…іеҒңжҪ®вҖқпјҢе•Ҷиҙ©иў«вҖңжҠўйҘӯзў—вҖқпјҢз”ҹж„ҸйҡҫеҒҡеӣ жҒ¶ж„Ҹз«һдәүпјҹ

- е°Ҹзұі11дёҚйҖҒе……з”өеҷЁпјҢжңҖеӨ§еҜ№жүӢзӣҙжҺҘе®Јеёғпјҡж Үй…ҚйғҪжҳҜ120Wеҝ«е……еӨҙ

- VMwareеҜ№и·іж§ҪеҲ°з«һдәүеҜ№жүӢе…¬еҸёзҡ„еүҚй«ҳз®ЎеҸ‘иө·иҜүи®јпјҢз§°иҝқеҸҚеҗҲеҗҢ

- iQOO7жҲҗдёәе°Ҹзұі11жңҖеӨ§еҜ№жүӢпјҢжҖ§д»·жҜ”е®Ңе…ЁдёҚиҫ“пјҢд»·ж јжүҚжҳҜе…ій”®

- е…¬е№із«һдәүжҳҜеёӮеңәз»ҸжөҺзҡ„еҹәзҹі

![[ж•°з Ғе°ҸзҺӢ]ProжңүзӮ№еғҸпјҢиҝҳжҳҜеҸҢжү“еӯ”жӣІйқўеұҸпјҒиҚЈиҖҖ30 Proзңҹжңәжӣқе…үпјҢи·ҹеҚҺдёәP40](https://imgcdn.toutiaoyule.com/20200328/20200328061128829913a_t.jpeg)