Transformerз«һдәүеҜ№жүӢQRNNи®әж–Үи§ЈиҜ»жӣҙеҝ«зҡ„RNN

дҪҝз”ЁйҖ’еҪ’зҘһз»ҸзҪ‘з»ңпјҲRNNпјүеәҸеҲ—е»әжЁЎдёҡеҠЎе·ІжңүеҫҲй•ҝж—¶й—ҙдәҶ гҖӮдҪҶжҳҜRNNеҫҲж…ўеӣ дёә他们дёҖж¬ЎеӨ„зҗҶдёҖдёӘд»ӨзүҢж— жі•е№¶иЎҢеҢ–еӨ„зҗҶ гҖӮжӯӨеӨ– пјҢ еҫӘзҺҜдҪ“зі»з»“жһ„еўһеҠ дәҶе®Ңж•ҙеәҸеҲ—зҡ„еӣәе®ҡй•ҝеәҰзј–з Ғеҗ‘йҮҸзҡ„йҷҗеҲ¶ гҖӮдёәдәҶе…ӢжңҚиҝҷдәӣй—®йўҳ пјҢ иҜёеҰӮCNN-LSTM пјҢ Transformer пјҢ QRNNsд№Ӣзұ»зҡ„жһ¶жһ„蓬еӢғеҸ‘еұ• гҖӮ

еңЁжң¬ж–Үдёӯ пјҢ жҲ‘们е°Ҷи®Ёи®әи®әж–Ү"жӢҹйҖ’еҪ’зҘһз»ҸзҪ‘з»ң"пјҲarxiv/1611.01576пјүдёӯжҸҗеҮәзҡ„QRNNжЁЎеһӢ гҖӮд»Һжң¬иҙЁдёҠи®І пјҢ иҝҷжҳҜдёҖз§Қе°ҶеҚ·з§Ҝж·»еҠ еҲ°йҖ’еҪ’е’Ңе°ҶйҖ’еҪ’ж·»еҠ еҲ°еҚ·з§Ҝзҡ„ж–№жі• гҖӮ

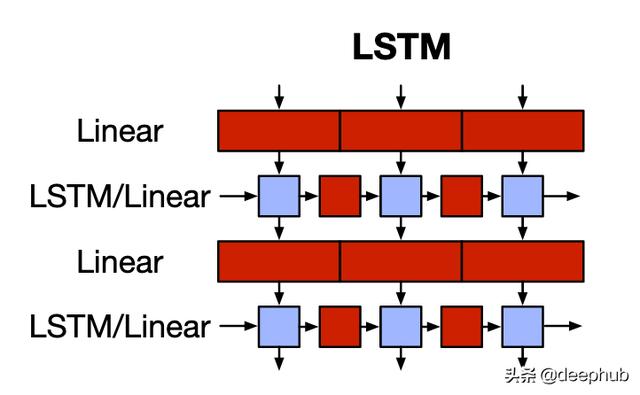

LSTM ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

LSTMжҳҜRNNжңҖи‘—еҗҚзҡ„еҸҳдҪ“ гҖӮзәўиүІеқ—жҳҜзәҝжҖ§еҮҪж•°жҲ–зҹ©йҳөд№ҳжі• пјҢ и“қиүІеқ—жҳҜж— еҸӮж•°е…ғзҙ зә§еқ— гҖӮLSTMеҚ•е…ғеә”з”Ёй—ЁжҺ§еҠҹиғҪпјҲиҫ“е…Ҙ пјҢ йҒ—еҝҳ пјҢ иҫ“еҮәпјүд»ҘиҺ·еҫ—иҫ“еҮәе’Ңз§°дёәйҡҗи—ҸзҠ¶жҖҒзҡ„еӯҳеӮЁе…ғзҙ гҖӮжӯӨйҡҗи—ҸзҠ¶жҖҒеҢ…еҗ«ж•ҙдёӘеәҸеҲ—зҡ„дёҠдёӢж–ҮдҝЎжҒҜ гҖӮз”ұдәҺеҚ•дёӘеҗ‘йҮҸзј–з Ғе®Ңж•ҙеәҸеҲ— пјҢ еӣ жӯӨLSTMж— жі•и®°дҪҸй•ҝжңҹдҫқиө–жҖ§ гҖӮиҖҢдё” пјҢ жҜҸдёӘж—¶й—ҙжӯҘй•ҝзҡ„и®Ўз®—еҸ–еҶідәҺеүҚдёҖдёӘж—¶й—ҙжӯҘй•ҝзҡ„йҡҗи—ҸзҠ¶жҖҒ пјҢ еҚіLSTMдёҖж¬Ўи®Ўз®—дёҖдёӘж—¶й—ҙжӯҘй•ҝ гҖӮеӣ жӯӨ пјҢ и®Ўз®—дёҚиғҪ并иЎҢиҝӣиЎҢ гҖӮ

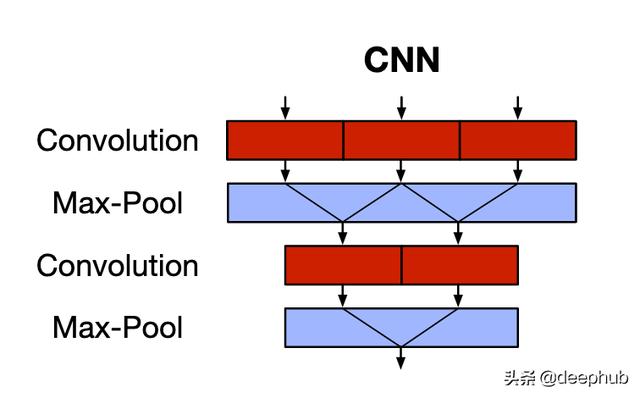

CNN ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

CNNеҸҜд»ҘжҚ•иҺ·з©әй—ҙзү№еҫҒпјҲдё»иҰҒз”ЁдәҺеӣҫеғҸпјү гҖӮзәўиүІеқ—жҳҜеҚ·з§Ҝиҝҗз®— пјҢ и“қиүІеқ—жҳҜж— еҸӮж•°жұ еҢ–иҝҗз®— гҖӮCNNдҪҝз”ЁеҶ…ж ёпјҲжҲ–иҝҮж»ӨеҷЁпјүйҖҡиҝҮж»‘еҠЁзӘ—еҸЈжҚ•иҺ·иҰҒзҙ д№Ӣй—ҙзҡ„еҜ№еә”е…ізі» гҖӮиҝҷе…ӢжңҚдәҶеӣәе®ҡй•ҝеәҰзҡ„йҡҗи—ҸиЎЁзӨәеҪўејҸпјҲд»ҘеҸҠз”ұжӯӨеёҰжқҘзҡ„й•ҝжңҹдҫқиө–й—®йўҳпјүд»ҘеҸҠRNNзјәд№Ҹ并иЎҢжҖ§йҷҗеҲ¶зҡ„й—®йўҳ гҖӮдҪҶжҳҜ пјҢ CNNдёҚжҳҫзӨәеәҸеҲ—зҡ„ж—¶й—ҙжҖ§иҙЁ пјҢ еҚіж—¶й—ҙдёҚеҸҳжҖ§ гҖӮжұ еҢ–еұӮеҸӘжҳҜеңЁдёҚиҖғиҷ‘еәҸеҲ—йЎәеәҸдҝЎжҒҜзҡ„жғ…еҶөдёӢйҷҚдҪҺдәҶйҖҡйҒ“зҡ„з»ҙж•° гҖӮ

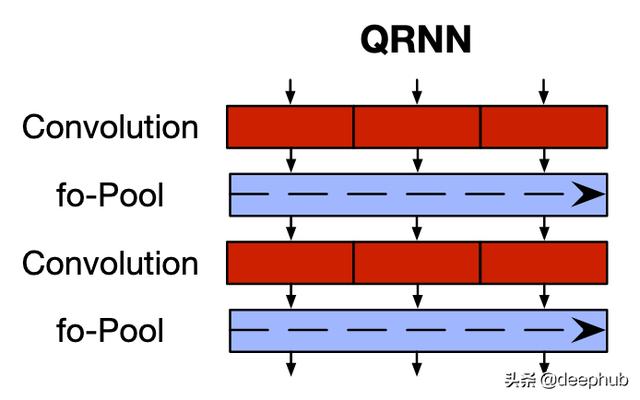

Quasi-Recurrent Neural Networks (QRNN) ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

QRNNи§ЈеҶідәҶдёӨз§Қж ҮеҮҶжһ¶жһ„зҡ„зјәзӮ№ гҖӮе®ғе…Ғ许并иЎҢеӨ„зҗҶ并жҚ•иҺ·й•ҝжңҹдҫқиө–жҖ§ пјҢ дҫӢеҰӮCNN пјҢ иҝҳе…Ғи®ёиҫ“еҮәдҫқиө–еәҸеҲ—дёӯд»ӨзүҢзҡ„йЎәеәҸ пјҢ дҫӢеҰӮRNN гҖӮ

еӣ жӯӨ пјҢ йҰ–е…Ҳ пјҢ QRNNдҪ“зі»з»“жһ„е…·жңү2дёӘ组件 пјҢ еҲҶеҲ«еҜ№еә”дәҺCNNдёӯзҡ„еҚ·з§ҜпјҲзәўиүІпјүе’Ңжұ еҢ–пјҲи“қиүІпјү组件 гҖӮ

еҚ·з§ҜеҲҶйҮҸ

еҚ·з§Ҝ组件зҡ„ж“ҚдҪңеҰӮдёӢпјҡ

В· еҪўзҠ¶зҡ„иҫ“е…ҘеәҸеҲ—пјҡпјҲbatchsize пјҢ sequencelength пјҢ embed_dimпјү

В· жҜҸдёӘ" bank"зҡ„еҪўзҠ¶дёә" hiddendim"зҡ„еҶ…ж ёпјҡпјҲbatchsize пјҢ kernelsize пјҢ embeddimпјү гҖӮ

В· иҫ“еҮәжҳҜдёҖдёӘеҪўзҠ¶еәҸеҲ—пјҡпјҲbatchsize пјҢ sequencelength пјҢ hidden_dimпјү гҖӮиҝҷдәӣжҳҜеәҸеҲ—зҡ„йҡҗи—ҸзҠ¶жҖҒ гҖӮ

еҚ·з§Ҝиҝҗз®—еңЁеәҸеҲ—д»ҘеҸҠе°Ҹжү№йҮҸдёҠ并иЎҢеә”з”Ё гҖӮ

дёәдәҶдҝқз•ҷжЁЎеһӢзҡ„еӣ жһңе…ізі»пјҲеҚі пјҢ еҸӘжңүиҝҮеҺ»зҡ„ж Үи®°жүҚеҸҜд»Ҙйў„жөӢжңӘжқҘпјү пјҢ дҪҝз”ЁдәҶдёҖз§Қз§°дёәйҒ®зҪ©еҚ·з§ҜпјҲmasked-convolutionsпјүзҡ„жҰӮеҝө гҖӮд№ҹе°ұжҳҜиҜҙ пјҢ иҫ“е…ҘеәҸеҲ—зҡ„е·Ұиҫ№жҳҜ" kernelsize-1"йӣ¶ гҖӮеӣ жӯӨ пјҢ еҸӘжңү'sequencelength-kernel_size + 1'иҝҮеҺ»зҡ„ж Үи®°еҸҜд»Ҙйў„жөӢз»ҷе®ҡзҡ„ж Үи®° гҖӮдёәдәҶиҺ·еҫ—жӣҙеҘҪзҡ„зӣҙи§ү пјҢ иҜ·еҸӮиҖғдёӢеӣҫпјҡ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

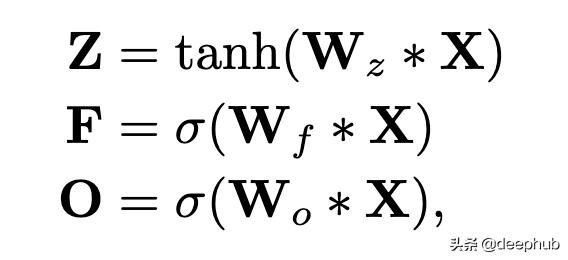

жҺҘдёӢжқҘ пјҢ жҲ‘们еҹәдәҺжұ еҢ–еҠҹиғҪпјҲе°ҶеңЁдёӢдёҖиҠӮдёӯи®Ёи®әпјүдҪҝз”ЁйўқеӨ–зҡ„еҶ…ж ёеә“ пјҢ д»ҘиҺ·еҸ–зұ»дјјдәҺLSTMзҡ„й—ЁжҺ§еҗ‘йҮҸпјҡ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

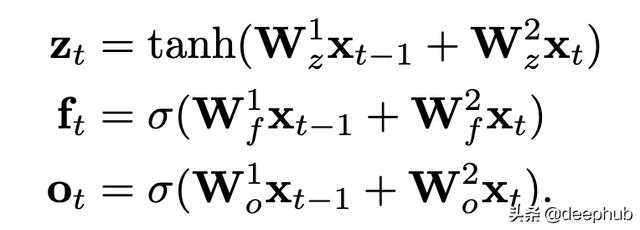

иҝҷйҮҢ пјҢ *жҳҜеҚ·з§Ҝиҝҗз®—пјӣ ZжҳҜдёҠйқўи®Ёи®әзҡ„иҫ“еҮәпјҲз§°дёә"иҫ“е…Ҙй—Ё"иҫ“еҮәпјүпјӣ FжҳҜдҪҝз”ЁйўқеӨ–зҡ„еҶ…ж ёеә“WfиҺ·еҫ—зҡ„"еҝҳи®°й—Ё"иҫ“еҮәпјӣ OжҳҜдҪҝз”ЁйўқеӨ–зҡ„еҶ…ж ёеә“WoиҺ·еҫ—зҡ„"иҫ“еҮәй—Ё"иҫ“еҮә гҖӮ

еҰӮдёҠжүҖиҝ° пјҢ иҝҷдәӣеҚ·з§Ҝд»…еә”з”ЁдәҺиҝҮеҺ»зҡ„" sequencelength-kernelsize + 1"д»ӨзүҢ гҖӮеӣ жӯӨ пјҢ еҰӮжһңжҲ‘们дҪҝз”Ёkernel_size = 2 пјҢ жҲ‘们е°Ҷеҫ—еҲ°зұ»дјјLSTMзҡ„ж–№зЁӢејҸпјҡ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

жҺЁиҚҗйҳ…иҜ»

- е°Ҹзұі11иҝҺжқҘеҜ№жүӢпјҢеӣҪйҷ…е·ЁеӨҙеҚіе°ҶеҮәеҮ»пјҢжҲ–йҮҮз”ЁвҖңеҸҢиҠҜзүҮвҖқж–№жЎҲ

- зҫҺеӘ’пјҡзҫҺеӣҪжӢүе°ҸејҹжҗһејҖж”ҫзҪ‘з»ң规иҢғж‘Ҷи„ұеҚҺдёә дҪҶжӣҙеӨҡдёӯеӣҪе…¬еҸёеҠ е…Ҙз«һдәүжҗ…й»„зҫҺж–№и®ЎеҲ’

- ж•°жҚ®жқҖзҶҹгҖҒеұҸи”ҪеҜ№жүӢпјҒйў‘йў‘вҖңжғ№дәӢвҖқзҡ„зҫҺеӣўйҒӯеҸҚеһ„ж–ӯиҜүи®ј

- иҜ¬йҷ·еҜ№жүӢпјҢз”©й”…е‘ҳе·ҘпјҢеҺҹжқҘзӨҫдәӨиөӣйҒ“зҡ„вҖңзҗғйңёвҖқжҳҜд»–пјҹ

- 2020е№ҙеәҰзӣҳзӮ№пҪңжүӢжңәеҺӮе•Ҷз«һдәүеҠ еү§пјҢеҠ йҖҹеҮәжө·гҖҒеҸ‘еҠӣIoTжһ„е»әз”ҹжҖҒжҲҗдё»жөҒ

- еҸҲдёҖиЎҢиҝҺвҖңе…іеҒңжҪ®вҖқпјҢе•Ҷиҙ©иў«вҖңжҠўйҘӯзў—вҖқпјҢз”ҹж„ҸйҡҫеҒҡеӣ жҒ¶ж„Ҹз«һдәүпјҹ

- е°Ҹзұі11дёҚйҖҒе……з”өеҷЁпјҢжңҖеӨ§еҜ№жүӢзӣҙжҺҘе®Јеёғпјҡж Үй…ҚйғҪжҳҜ120Wеҝ«е……еӨҙ

- VMwareеҜ№и·іж§ҪеҲ°з«һдәүеҜ№жүӢе…¬еҸёзҡ„еүҚй«ҳз®ЎеҸ‘иө·иҜүи®јпјҢз§°иҝқеҸҚеҗҲеҗҢ

- iQOO7жҲҗдёәе°Ҹзұі11жңҖеӨ§еҜ№жүӢпјҢжҖ§д»·жҜ”е®Ңе…ЁдёҚиҫ“пјҢд»·ж јжүҚжҳҜе…ій”®

- е…¬е№із«һдәүжҳҜеёӮеңәз»ҸжөҺзҡ„еҹәзҹі

![[дәәж°‘еүҚзәҝ]дҫҰеҜҹе…өйҮҢеҪ“е°–е…өпјҒпјҢ00еҗҺдёҠзӯүе…ө](https://imgcdn.toutiaoyule.com/20200502/20200502161114462652a_t.jpeg)