四个大型数据和数据湖的大型Apache系统 , Apache Shardingsphere , Apache冰山 , Apache Hudi和Apache IotdB

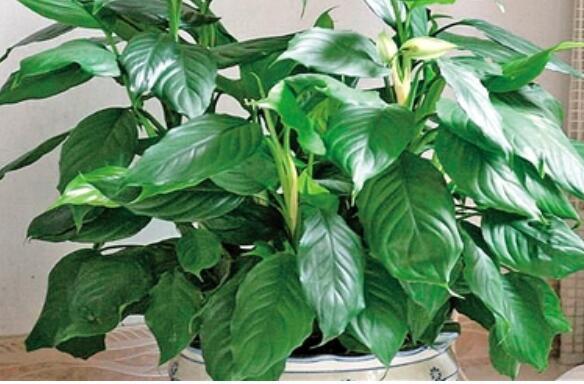

文章插图

管理大数据所需的许多功能是其中一些是事务 , 数据突变 , 数据校正 , 流媒体支持 , 架构演进 , 因为酸性事务能力Apache提供了四种 , 用于满足和管理大数据 。

Apache Sharding Sphere它是一个众所周知的数据库中间件系统 。它包含三个独立的模块 , JDBC , Proxy和Sidecar(计划) , 但在部署时它们都混合在一起 。Apache Shardingsphere提供标准化的数据分片 , 分布式事务和数据库治理功能 , 可以针对各种多样化应用方案 , 例如JAVA同义 , 异构语言和云本机 。

文章插图

今天的电子商务主要依赖于关系数据库和分布式环境 , 高效查询的激增和数据快速转移成为公司关系数据库的主要目标Apache Shardingsphere是伟大的关系数据库中间件生态系统 , 它为其开发人员提供了合理的计算和存储功能关系数据库 。

文章插图

Apache IcebergApache Iceberg 最初由Netflix设计和开发 。关键的想法是组织目录树中的所有文件 , 如果您需要在2018年5月创建的文件在Apache iceBerg中 , 您只需找出该文件并只读该文件 , 也没有必要阅读您可以阅读的其他文件忽略您对当前情况不太重要的其他数据 。核心思想是跟踪时间表上表中的所有更改 。

它是一种用于跟踪非常大的表的数据湖解决方案 , 它是一个轻量级数据湖解决方案 , 旨在解决列出大量分区和耗时和不一致的元数据和HDFS数据的问题 。它包含三种类型的表格格式木质 , Avro和Orc.in Apache iceberg表格格式与文件集合和文件格式的集合执行相同的东西 , 允许您在单个文件中跳过数据

它是一种用于在非常大型和比例表上跟踪和控制的新技术格式 。它专为对象存储而设计(例如S3) 。Iceberg 中更重要的概念是一个快照 。快照表示一组完整的表数据文件 。为每个更新操作生成新快照 。

Apache Iceberg 有以下特征:

- ACID 事务能力 , 可以在不影响当前运行数据处理任务的情况下进行上游数据写入 , 这大大简化了ETL; Iceberg 提供更好的合并能力 , 可以大大减少数据存储延迟;

- 支持更多的分析引擎优异的内核抽象使其不绑定到特定的计算引擎 。目前 , 冰山支持的计算发动机是Spark , Flink , Presto和Hive 。

- Apache Iceberg为文件存储 , 组织 , 基于流的增量计算模型和基于批处理的全尺度计算模型提供统一和灵活的数据 。批处理和流式传输任务可以使用类似的存储模型 , 并且不再隔离数据 。iceberg支持隐藏的分区和分区演进 , 这促进了业务更新数据分区策略 。支持三个存储格式木质 , Avro和Orc 。

- 增量读取处理能力iceBerg支持以流式方式读取增量数据 , 支持流和传输表源 。

Hudi的设计目标是快速且逐步更新HDFS上的数据集 。有两种更新数据的方法:读写编写并合并读取 。写入模式上的副本是当我们更新数据时 , 我们需要通过索引获取更新数据中涉及的文件 , 然后读取数据并合并更新的数据 。这种模式更易于更新数据 , 但是当涉及的数据更新时更新时 , 效率非常低;并合并读取是要将更新写入单独的新文件 , 然后我们可以选择与原始数据同步或异步地将更新的数据与原始数据合并(可以调用组合) , 因为更新的仅编写新文件 , 所以此模式将更新更快 。

推荐阅读

- 大型ESB服务总线平台服务运行分析和监控预警实践

- 中国最好的小米产地是哪?

- 使用Apache Calcite解析数据库查询

- 为什么不让养大型犬?养一只大型犬是什么体验

- 南宋四大中兴诗人是哪四个 属于南宋中兴四大诗人的有

- Apache Druid 高性能的实时分析型数据库

- 白茶的四个分类是哪些,茶砖的分类

- 一个优秀班主任具备的素养?班主任的四个素养

- 地下城与勇士|DNF:魔枪四个职业哪个搬砖舒服又快?暗枪和光枪都很不错!

- 四个坏习惯导致衰老加速,熬夜最常见