美国持续封锁,华为的技术自研,已经深入到了AI底层算法层面上,并开始将研究成果面向业界开源 。

刚刚,华为诺亚实验室开源Disout算法(地址在文末),直接对标谷歌申请专利的Dropout算法 。

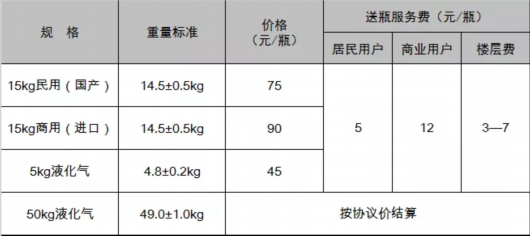

文章插图

而且,在多项任务上,华为的新算法都超过了Dropout 。比如,在ImageNet上训练的ResNet-50可以达到78.76%的准确率,而谷歌Dropout系列方法仅为76.8% 。

这一算法背后的论文,已被AAAI 2020收录,并对外公开 。华为到底提出的Disout到底如何,也得以呈现 。

华为自研Disout:多项AI任务超越Dropout在申请专利时,谷歌将Dropout定义为“解决神经网络过拟合的系统和方法” 。

其核心的思路是,训练神经网络前向传播过程中,Dropout能让某个神经元的激活值以一定的概率p停止工作,也就是“Drop”(丢弃),提升模型稳定性,来缓解过拟合现象 。

【厉害了华为!开源自研算法Disout】而Disout是提出的新型替代方案,是一种通过研究特征图扰动来增强深度神经网络的泛化能力的方法 。

简单来说,就是根据网络中间层的Rademacher 复杂度(ERC),确定给定深度神经网络的泛化误差上界 。

并将扰动引入特征图,来降低网络的Rademacher复杂度,从而提高其泛化能力 。

它们之间的区别可以用下面这张图来展示——也就是对输出特征进行扰动,而不是丢弃 。

文章插图

相比之下,华为的方法效果更好 。

Disout不但在传统视觉任务上表现优异,超越谷歌Dropout性能,在NLP任务以及语音处理任务上,同样具备有效性 。

接下来,就让我们一起看下Disout在各个数据集上与Dropout系列方法的对比 。

首先,CIFAR-10的和CIFAR-100数据上的测试准确率对比 。

全连接层实验中,华为所提出的特征图扰动方法,训练CNN达到85.24%的准确度,相比于最新的RDdrop方法,测试准确率分别在CIFAR-10和CIFAR-100数据集上提高了2.13%和1.58% 。

华为研究人员表示,他们提出的Disout方法可以有效地降低经验Rademacher的复杂度,同时保留模型的表示能力,从而具有较好的测试性能 。

文章插图

在卷积层实验上,华为的方法可以适用于卷积层,提高深度神经网络的性能,而且优于DropBlock方法,性能分别提高了0.32%和0.63% 。

文章插图

ImageNet 数据集实验中结果也显示,华为提出的特征扰动方法不仅可以替换常规的dropout方法提高深度神经网络的性能,而且可以提升最近提出的Dropblock方法的性能 。

与传统的dropout方法相比,Disout将准确性从76.80%提高到77.71%,Block Disout方法达到了78.76%的top-1准确率,超过其他现有技术 。

华为研究人员说,他们的方法可以在提高泛化能力并保留原始特征的有用信息 。

此外,他们还在文本数据集IMDB和语音数据集UrbanSound8k上进行了实验,结果如下(上为文本、下为语音):

文章插图

核心突破:对输出特征进行扰动,而不是丢弃那么,具体又是如何做到的呢?我们一起来了解一下泛化理论 。

泛化理研究的是期望风险与经验风险之间的关系 。

以图像分类任务为例,总体期望风险R(fL)和训练集上的经验风险

文章插图

是:

文章插图

Rademacher经验复杂度(ERC)被广泛用于量化期望风险和经验风险之间的差距,它的定义如定义1所示 。

定义1:给定由分布Q成的个实例D= {(x,y)}的给定训练数据集,网络的经验Rademacher复杂度定义为:

文章插图

其中Rademacher变量是{-1,+ 1}中的独立统一随机变量 。

使用经验Rademacher复杂度和MaDiarmid不等式,可以通过定理1得出预期风险的上限 。

定理1:给定 >0,对任意>0,至少以概率1−,对于所有的∈,满足

文章插图

推荐阅读

- dvc-an20是什么型号是5g手机吗?华为DVC-AN20是什么型号?

- 太厉害了!总算有人把“串行通信”的基础知识讲的明明白白了

- 华为|5399元!华为MateBook 14非触屏版今日开售:11代酷睿i5+2K屏

- 华为|5599元起!华为Mate 40 Pro 4G版官方降价:搭载5nm麒麟9000

- 什么车贬值最厉害?

- 华为传输软件叫什么?

- 刘涛|41岁的刘涛直播倒立,灵活度不输年轻人,娱乐圈明星健身有多厉害

- 运动|27岁女子坚持跳绳减肥,确诊甲状腺癌,医生惋惜:运动前1习惯害了她

- 到底什么样的行业赚钱厉害?

- 华为实验演示:利用路由器的接口配置VRRP