еҰӮдҪ•дјҳеҢ– TensorFlow Lite иҝҗиЎҢж—¶еҶ…еӯҳпјҹ( дәҢ )

еӣҫ 2

еӣҫ 2пјҡMobileNet V2 зҡ„дёӯй—ҙеј йҮҸпјҲдёҠпјүеҸҠе…¶еңЁ 2D еӯҳеӮЁз©әй—ҙпјҲдёӢпјүдёҠзҡ„жҳ е°„ гҖӮ еҰӮжһңдёӯй—ҙеј йҮҸе…ұдә«еҶ…еӯҳзј“еҶІеҢәпјҲз”Ё 4 з§ҚдёҚеҗҢзҡ„йўңиүІиЎЁзӨәпјү пјҢ е®ғ们еҸӘеҚ з”ЁзәҰ 7MB зҡ„иҝҗиЎҢж—¶еҶ…еӯҳ

еҶ…еӯҳеҒҸ移йҮҸи®Ўз®—еҜ№дәҺеңЁ CPU дёҠиҝҗиЎҢзҡ„ TFLite пјҢ йҖӮз”ЁдәҺ GL зә№зҗҶзҡ„еҶ…еӯҳзј“еҶІеҢәеұһжҖ§е№¶дёҚйҖӮз”Ё гҖӮ еӣ жӯӨ пјҢ жӣҙеёёи§Ғзҡ„еҒҡжі•жҳҜйў„е…ҲеҲҶй…ҚдёҖдёӘе·ЁеӨ§зҡ„еҶ…еӯҳз©әй—ҙ пјҢ 并让жүҖжңүи®ҝй—®е®ғзҡ„иҜ»еҸ–еҷЁе’ҢеҶҷе…ҘеҷЁе…ұдә«е®ғ пјҢ иҝҷдәӣиҜ»еҸ–еҷЁе’ҢеҶҷе…ҘеҷЁйҖҡиҝҮз»ҷе®ҡзҡ„еҒҸ移йҮҸи®ҝй—®е®ғ пјҢ иҖҢдёҚдјҡе№Іжү°е…¶д»–иҜ»еҸ–е’ҢеҶҷе…Ҙ гҖӮ иҝҷз§ҚеҶ…еӯҳеҒҸ移йҮҸи®Ўз®—ж–№жі•зҡ„зӣ®ж ҮжҳҜжңҖеӨ§зЁӢеәҰең°еҮҸе°‘еҶ…еӯҳз©әй—ҙ гҖӮ

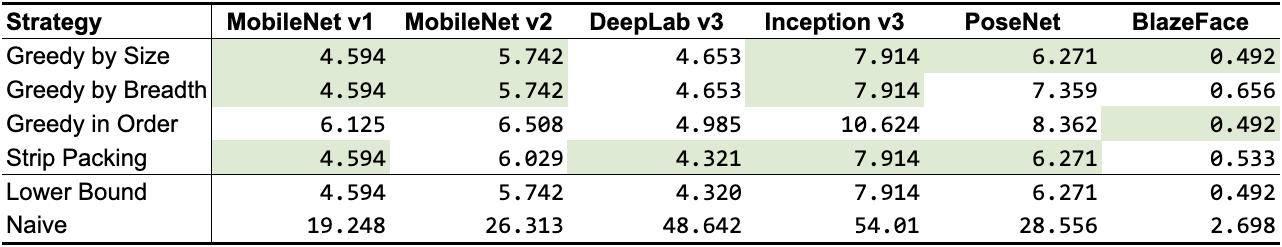

жҲ‘们已з»ҸдёәиҝҷдёӘдјҳеҢ–й—®йўҳи®ҫи®ЎдәҶ 3 з§ҚдёҚеҗҢзҡ„з®—жі• пјҢ 并жҺўзҙўдәҶе…ҲеүҚзҡ„з ”з©¶е·ҘдҪңпјҲ Sekiyama зӯүдәәеңЁ 2018 е№ҙжҸҗеҮәзҡ„ Strip Packing пјү гҖӮ дёҺе…ұдә«еҜ№иұЎж–№жі•зұ»дјј пјҢ жңүдәӣз®—жі•зҡ„жҖ§иғҪдјҳдәҺе…¶д»–з®—жі• пјҢ е…·дҪ“еҸ–еҶідәҺзҪ‘з»ң пјҢ еҰӮиЎЁ 2 жүҖзӨә гҖӮ д»ҺиҝҷдёӘи°ғжҹҘдёӯжҲ‘们еҸҜд»ҘзңӢеҮә пјҢ еҒҸ移йҮҸи®Ўз®—ж–№жі•жҜ”дёҖиҲ¬зҡ„е…ұдә«еҜ№иұЎж–№жі•еҚ з”Ёзҡ„з©әй—ҙжӣҙе°Ҹ пјҢ еӣ жӯӨ пјҢ еҰӮжһңеҸҜиЎҢзҡ„иҜқ пјҢ жҲ‘们еә”иҜҘйҖүжӢ©еүҚиҖ…иҖҢйқһеҗҺиҖ… гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

иЎЁ 2

иЎЁ 2пјҡеҒҸ移йҮҸи®Ўз®—зӯ–з•Ҙзҡ„еҶ…еӯҳеҚ з”ЁпјҲд»Ҙ MB дёәеҚ•дҪҚпјӣжңҖдҪіз»“жһңд»Ҙз»ҝиүІй«ҳдә®жҳҫзӨәпјү гҖӮ еүҚ 3 иЎҢжҳҜжҲ‘们зҡ„зӯ–з•Ҙ пјҢ жҺҘдёӢжқҘзҡ„ 1 иЎҢжҳҜе…ҲеүҚзҡ„з ”з©¶е·ҘдҪң пјҢ жңҖеҗҺ 2 иЎҢдҪңдёәеҹәзәҝпјҲдёӢйҷҗиЎЁзӨәеҸҜиғҪж— жі•е®һзҺ°зҡ„жңҖдҪіж•°еӯ—зҡ„иҝ‘дјјеҖј пјҢ иҖҢ Naive иЎЁзӨәжҜҸдёӘдёӯй—ҙеј йҮҸеҲҶй…ҚиҮӘе·ұзҡ„еҶ…еӯҳзј“еҶІеҢәеҸҜиғҪеҮәзҺ°зҡ„жңҖе·®ж•°еҖјпјү

иҝҷдәӣй’ҲеҜ№ CPU е’Ң GPU зҡ„еҶ…еӯҳдјҳеҢ– пјҢ й»ҳи®Өжғ…еҶөдёӢе·Із»ҸдёҺжңҖиҝ‘еҮ дёӘзЁіе®ҡзҡ„ TFLite зүҲжң¬дёҖиө·жҸҗдҫӣ пјҢ 并且еңЁж”ҜжҢҒиҜёеҰӮ MobileBERT зӯүжӣҙй«ҳиҰҒжұӮгҖҒжңҖе…Ҳиҝӣзҡ„жЁЎеһӢж–№йқўиҜҒжҳҺдәҶе®ғ们зҡ„д»·еҖј гҖӮ дҪ еҸҜд»ҘйҖҡиҝҮзӣҙжҺҘжҹҘзңӢ GPU е®һзҺ°е’Ң CPU е®һзҺ°жқҘжүҫеҲ°жңүе…іе®һзҺ°зҡ„жӣҙеӨҡиҜҰз»ҶдҝЎжҒҜ гҖӮ

еҺҹж–Үй“ҫжҺҘпјҡ

延伸йҳ…иҜ»пјҡ

и·Ёи¶ҠйҮҚйҮҚвҖңйҡңзўҚвҖқ пјҢ жҲ‘д»Һ PyTorch иҪ¬жҚўдёәдәҶ TensorFlow Lite-InfoQ

гҖҗеҰӮдҪ•дјҳеҢ– TensorFlow Lite иҝҗиЎҢж—¶еҶ…еӯҳпјҹгҖ‘е…іжіЁжҲ‘并иҪ¬еҸ‘жӯӨзҜҮж–Үз« пјҢ з§ҒдҝЎжҲ‘вҖңйўҶеҸ–иө„ж–ҷвҖқ пјҢ еҚіеҸҜе…Қиҙ№иҺ·еҫ—InfoQд»·еҖј4999е…ғиҝ·дҪ д№Ұ пјҢ зӮ№еҮ»ж–Үжң«гҖҢдәҶи§ЈжӣҙеӨҡгҖҚ пјҢ еҚіеҸҜ移жӯҘInfoQе®ҳзҪ‘ пјҢ иҺ·еҸ–жңҖж–°иө„и®ҜпҪһ

жҺЁиҚҗйҳ…иҜ»

- еӨ§дёҖйқһи®Ўз®—жңәдё“дёҡзҡ„еӯҰз”ҹпјҢеҰӮдҪ•еҲ©з”ЁеҜ’еҒҮиҮӘеӯҰCиҜӯиЁҖ

- еҗ‘ж—Ҙи‘өиҝңзЁӢжҺ§еҲ¶дјҒдёҡзүҲе®ўжҲ·з«Ҝжӣҙж–°еҚҮзә§пјҢдјҳеҢ–иҝңжҺ§UIйҖӮй…ҚSADDCеҶ…ж ёз®—жі•

- зәўзұіK40жёІжҹ“еӣҫжӣқе…үпјҡеұ…дёӯжҢ–еӯ”+еҗҺзҪ®еӣӣж‘„пјҢиҝҷеӨ–и§ӮдҪ и§үеҫ—еҰӮдҪ•пјҹ

- и§ҶзҪ‘иҶңдјҳеҢ–пјҹзҙўе°је…·и®ӨзҹҘиғҪеҠӣз”өи§ҶиҠҜзүҮXRжқҘдәҶ

- еҘӢж–—|иҜҘеҰӮдҪ•зңӢеҫ…жӢјеӨҡеӨҡе‘ҳе·ҘзҢқжӯ»пјҡйј“еҠұеҘӢж–—пјҢд№ҹиҰҒдҝқжҠӨеҘҪеҘӢж–—иҖ…

- иЈ…жңәзӮ№дёҚдә® еҰӮдҪ•з®Җжҳ“жҺ’жҹҘ硬件问йўҳпјҹ

- иҷҫзұійҹід№җе®Јеёғе…іеҒңпјҒжҲ‘зҡ„жӯҢеҚ•еҰӮдҪ•еҜје…ҘQQйҹід№җгҖҒзҪ‘жҳ“дә‘йҹід№җпјҹ

- дәәи„ёиҜҶеҲ«и®ҫеӨҮдё»жқҝеҰӮдҪ•йҖүеһӢ иҪҜзЎ¬ж•ҙеҗҲеӨ§е№…зј©зҹӯејҖеҸ‘ж—¶й—ҙ

- еҫ®иҪҜе®ҳж–№ж•°жҚ®жҒўеӨҚе·Ҙе…·еҚіе°Ҷжӣҙж–°пјҡжӣҙжҳ“дәҺдёҠжүӢ дјҳеҢ–жҒўеӨҚжҖ§иғҪ

- Mini-LEDдә§е“Ғж•Ҳжһң究з«ҹеҰӮдҪ•пјҹ

![[йЎ№зӣ®]е№ҝдёңеӨҡдёӘз”°йҮҺиҖғеҸӨйЎ№зӣ®еӨҚе·ҘпјҢж°ҙдёӢиҖғеҸӨжҡӮзј“](https://pic.nfapp.southcn.com/nfplus/ossfs/pic/xy/202003/10/b708c5d2-63cb-4171-bec6-77d2f41b222d.jpe)

![ж–°еҚҺзҪ‘|еҸ°йЈҺвҖңжө·зҘһвҖқиҝҮеўғйҹ©еӣҪиҮҙ2дәәеӨұиёӘ[з»„еӣҫ]](https://mz.eastday.com/20133129.jpeg)