еӨҡи§ҶеӣҫеҮ дҪ•дёүз»ҙйҮҚе»әе®һжҲҳзі»еҲ—д№ӢR-MVSNet( дәҢ )

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

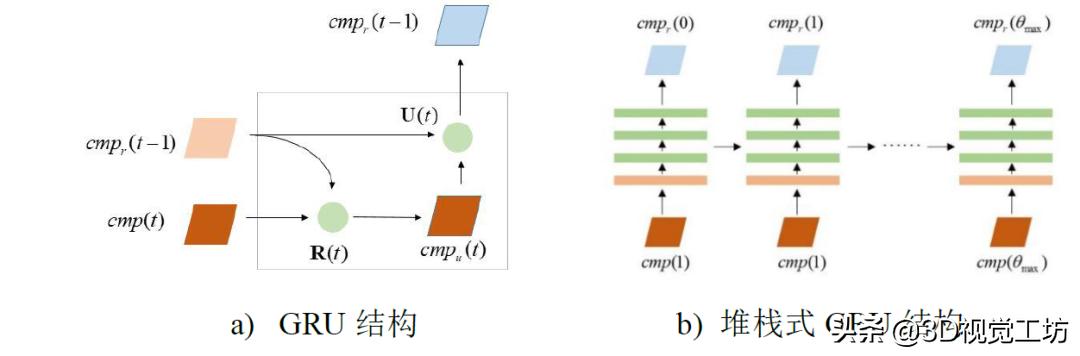

еӣҫ5 GRUз»“жһ„зӨәж„Ҹеӣҫ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

дёәдәҶиҝӣдёҖжӯҘеҠ ејәGRUз»“жһ„жӯЈеҲҷеҢ–зҡ„иғҪеҠӣ пјҢ R-MVSNetйҮҮз”ЁдёҖдёӘCNNе°Ҷ32йҖҡйҒ“зҡ„ж·ұеәҰзү№еҫҒжҳ е°„еҲ°16йҖҡйҒ“зҡ„ж·ұеәҰзү№еҫҒ пјҢ 然еҗҺдҪҝз”ЁдёҖдёӘдёүеұӮе Ҷж ҲејҸGRUз»“жһ„еҜ№д»Јд»·еӣҫиҝӣиЎҢиҝҮж»Ө(еӣҫ5-b) гҖӮ

ж·ұеәҰдјҳеҢ– гҖӮ еҰӮеӣҫ2 пјҢ R-MVSNetеҲ©з”Ёе Ҷж ҲеҚ·з§ҜзҘһз»ҸзҪ‘з»ңйҖҡиҝҮеңЁж·ұеәҰж–№еҗ‘жҠ“еҸ–еүҚеҗҺж·ұеәҰдҝЎжҒҜ пјҢ 然еҗҺжҜҸдёӘд»Јд»·еӣҫз»ҸиҝҮGRUзҡ„иҝҮж»Ө пјҢ жңҖеҗҺж•ҙеҗҲеҪўжҲҗдёҖдёӘиҝҮж»ӨеҗҺд»Јд»·дҪ“Cr пјҢ еҶҚз»ҸиҝҮSoftMaxеӨ„зҗҶз”ҹжҲҗиЎЁзӨәж·ұеәҰзҪ®дҝЎжҰӮзҺҮзҡ„жҰӮзҺҮдҪ“P пјҢ дёҺMVSNetзұ»дјј пјҢ д»Ҙж·ұеәҰжңҹжңӣеҖјдҪңдёәеҸӮиҖғеҪұеғҸзҡ„ж·ұеәҰеӣҫ гҖӮ

1.3гҖҒжҚҹеӨұеҮҪж•°зҡ„и®ҫи®Ў

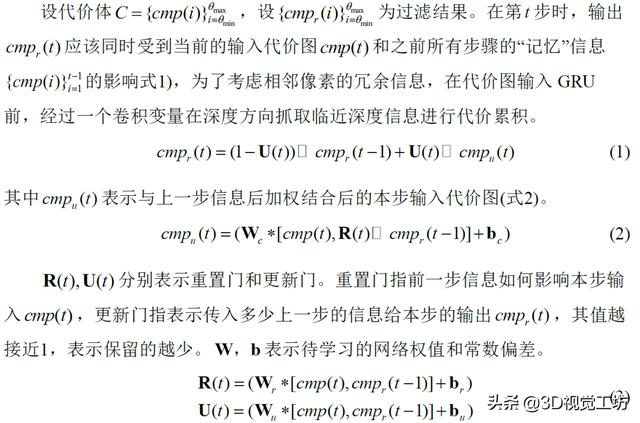

еӨ§еӨҡж•°MVSзҪ‘з»ңйҖҡиҝҮsoft argminж“ҚдҪңеӣһеҪ’ж·ұеәҰжҲ–и§Ҷе·®еҖј пјҢ е…¶еҖҹйүҙзҡ„еҒҮи®ҫжҳҜеңЁж·ұеәҰж–№еҗ‘ пјҢ жҜҸдёӘдёүз»ҙзӮ№еңЁеӨҡи§Ҷи§’еӣҫеғҸд№Ӣй—ҙзҡ„еғҸзҙ еҖјеә”иҜҘиҝ‘дјј пјҢ иҝҷз§ҚеҒҮи®ҫеңЁж·ұеәҰдј°и®ЎиҢғеӣҙеқҮеҢҖйҮҮж ·зҡ„жғ…еҶөдёӢжҳҜжҲҗз«Ӣзҡ„ пјҢ дҪҶеҰӮжһңеҜ№дәҺеҫӘзҺҜзҘһз»ҸзҪ‘з»ңз»“жһ„ пјҢ еҲҷйңҖиҰҒеә”з”ЁйҖҶж·ұеәҰеҢ–зҡ„ж–№жі•еҺ»йҮҮж ·ж·ұеәҰеҖј пјҢ е·ІдҝқиҜҒдёҖдёӘжӣҙеӨ§зҡ„ж·ұеәҰдј°и®ЎиҢғеӣҙ гҖӮ жүҖд»Ҙ пјҢ дҪңиҖ…жҸҗеҮәйҮҮз”ЁдәӨеҸүзҶөжҚҹеӨұеҮҪж•°е°Ҷж·ұеәҰеӣһеҪ’й—®йўҳиҪ¬еҢ–дёәеӨҡзұ»еҲҶзұ»й—®йўҳ гҖӮ жҚҹеӨұеҮҪж•°еҰӮејҸпјҲ4пјүпјҡ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

(4)

е…¶дёӯ пјҢ P(i,p)иЎЁзӨәзҡ„жҳҜ第iдёӘеңЁжҰӮзҺҮдҪ“Pдёӯзҡ„дҪ“зҙ пјҢ QдёәеңЁиҜҘеғҸзҙ дёҠдёҺPдҪҚзҪ®еҜ№еә”зҡ„ж·ұеәҰзңҹеҖј гҖӮ

2гҖҒR-MVSNetе®һжҲҳж“ҚдҪң

йҰ–е…Ҳ пјҢ еҶҚж¬Ўж„ҹи°ўYaoyaoпјҲйҰҷжёҜ科жҠҖеӨ§еӯҰпјүз»ҷеҮәзҡ„ејҖжәҗд»Јз Ғе’Ңе·Із»Ҹйў„еӨ„зҗҶеҘҪзҡ„жЁЎеһӢе’Ңж•°жҚ® гҖӮ е…¶ж¬Ў пјҢ еӣ дёәR-MVSNetжҳҜеҸӮиҖғMVSNetжЎҶжһ¶дёӢеҒҡеҮәзҡ„ж”№иҝӣ пјҢ жүҖд»ҘејҖжәҗж•°жҚ®йӣҶе’Ңж·ұеәҰдј°и®Ўж“ҚдҪңе’ҢMVSNetе®Ңе…ЁдёҖиҮҙ пјҢ иҝҷйҮҢеҜ№ж•°жҚ®йў„еӨ„зҗҶд»…еҒҡз®ҖеҚ•зҡ„еӣһйЎҫ пјҢ иҜҰз»Ҷж•°жҚ®еӨ„зҗҶеҶ…е®№ пјҢ иҜ·еӨ§е®¶еӣһйЎҫе®һжҲҳзі»еҲ—-MVSNet гҖӮ

1пјүзҺҜеўғй…ҚзҪ®

еҸӮиҖғYaoyaoзҡ„githubдё»йЎөдёӯinstallationеҚіеҸҜе®ҢжҲҗзҺҜеўғй…ҚзҪ® гҖӮ

пјҲпјү

2пјүж•°жҚ®ж•ҙзҗҶ

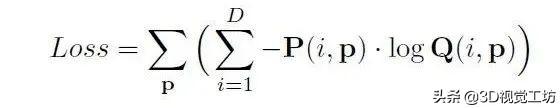

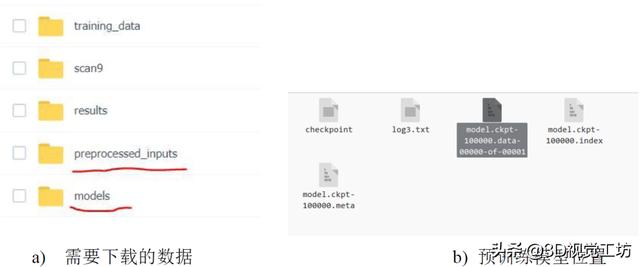

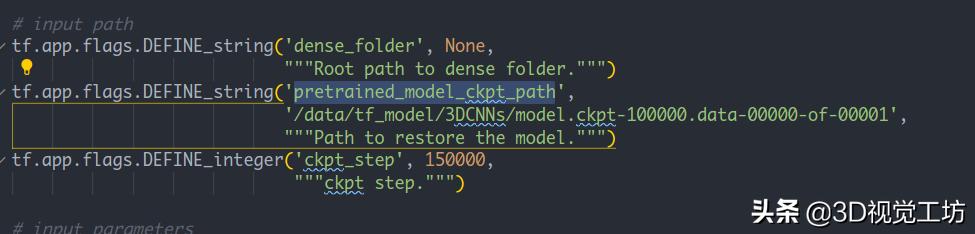

еңЁж–Үжң«еҲҶдә«зҡ„зҷҫеәҰдә‘зӣҳдёӯдёӢиҪҪж•°жҚ®йӣҶpreprocessed_inputs/dtu.zipе’Ңйў„и®ӯз»ғеҘҪзҡ„зҪ‘з»ңmodels/tf_model_19307.zip гҖӮ е°Ҷtf_modelи§ЈеҺӢ пјҢ еңЁе…¶дёӯзҡ„GRU/дёӯиҺ·еҫ—и®ӯз»ғеҘҪзҡ„жЁЎеһӢ model.ckpt-100000.data-00000-of-00001 гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

- еӣҫ6 зҷҫеәҰдә‘зӣҳж•°жҚ®

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫеӣҫ7 жӣҙж”№йў„и®ӯз»ғжЁЎеһӢзҡ„ең°еқҖ

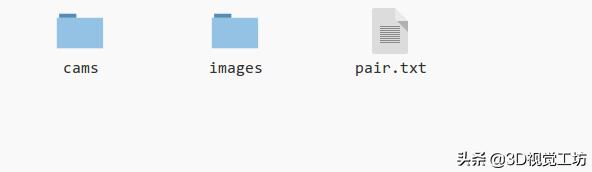

и§ЈеҺӢдёӢиҪҪеҘҪзҡ„dtu.zip пјҢ еҲ°з”ЁдәҺж·ұеәҰдј°и®Ўзҡ„ж•°жҚ®йӣҶ гҖӮ д»Ҙscan10дёәдҫӢ пјҢ иҜҘж–Ү件еӨ№зҡ„з»“жһ„еҰӮдёӢеӣҫ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫеӣҫ8 scan10ж–Ү件еӨ№з»“жһ„

3пјүж·ұеәҰдј°и®Ў

иҝҗиЎҢд»Јз Ғпјҡ

python test.py --dense_folder TEST_DATA_FOLDER --regularization 'GRU' --max_w 1600 --max_h 1200 --max_d 256 --interval_scale 0.8жіЁж„Ҹпјҡ- flag --dense_folder иҰҒи®ҫе®ҡдёәscan10зҡ„ең°еқҖ гҖӮ

- flag вҖ“regularizationиЎЁзӨәжӯЈеҲҷеҢ–д»Јд»·дҪ“зҡ„ж–№ејҸ пјҢ R-MVSNetдёӯдҪҝз”Ёзҡ„жҳҜGRUзҪ‘з»ң гҖӮ

- еӣҫзүҮзҡ„еӨ§е°ҸеҸҜд»ҘжҢүз…§GPUзҡ„еӨ§е°ҸеҸҳжӣҙеҸӮж•° пјҢ дҪҶжҳҜйңҖиҰҒж—¶32зҡ„ж•ҙж•°еҖҚпјҲзү№еҫҒжҸҗеҸ–ж—¶2DзҘһз»ҸзҪ‘з»ңиҰҒжұӮеӣҫеғҸжҳҜ32зҡ„ж•ҙж•°еҖҚпјү

- Max_d е’Ңinterval_scale е»әи®®е…ҲжҢүз…§й»ҳи®Өзҡ„иҰҒжұӮ пјҢ еңЁдҪҝз”ЁиҮӘе·ұзҡ„ж•°жҚ®ж—¶ пјҢ жҲ‘们дјҡз»ҷеҮәи°ғж•ҙзҡ„ж–№ејҸ

- еҸҜд»Ҙе’ҢMVSNetжҜ”иҫғеҸ‘зҺ° пјҢ еҸҜз”Ёзҡ„еҲҶиҫЁзҺҮе’Ңж·ұеәҰдј°и®ЎиҢғеӣҙйғҪеҫ—еҲ°дәҶжҸҗеҚҮ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- дёӯеӣҪиҝӣеҸЈй«ҳз«ҜEUVе…үеҲ»жңәпјҢиғңз®—еҮ дҪ•пјҹASMLй«ҳз®ЎеҒҡеҮәеӣһеә”

- дёүеӨ§иҝҗиҗҘе•Ҷ11жңҲиҝҗиҗҘж•°жҚ®е…¬еёғпјҒвҖңжҗәеҸ·иҪ¬зҪ‘вҖқдёҖе№ҙд№Ӣйҷ…еҸҳеҢ–еҮ дҪ•пјҹ

- жү“ејҖпјҢдҪ“йӘҢжөҒз•…зҡ„еҚ•зӣ®дёүз»ҙжүӢеҠҝжҠҖжңҜ

- дёүз»ҙйғЁд»¶йӯ”жі•жӢјиЈ…пјҒеҢ—еӨ§&ж–ҜеқҰзҰҸеҲ©з”ЁеҠЁжҖҒеӣҫзҪ‘з»ңеӯҰд№ з”ҹжҲҗ

- йҮ‘з«Ӣ4Gж–°жңәе…ҘзҪ‘пјҢзҪ‘еҸӢпјҡй…ҚзҪ®иҝҳз®—еҮ‘еҗҲ

- й…·жҙҫеҸ‘зҷҫе…ғжңәпјҡеұ•и®ҜиҠҜзүҮ+ж°ҙж»ҙеұҸ+еҸҢж‘„пјҢзҪ‘еҸӢпјҡдёәж—¶е·Іжҷҡ

- дә¬дёң|дә¬дёңжҺўзҙўзЁҖз–Ҹдёүз»ҙз©әй—ҙзӮ№дә‘Global ContextеӯҰд№ ж–№жі•иҺ·и®ӨеҸҜ

- еұұдёңе®үжӯҘеҮ дҪ•жұҪиҪҰдҪ“йӘҢдёӯеҝғејҖдёҡеәҶе…ёиҗҪ幕

- вҖңдҫҚвҖқеңЁеҝ…еҫ— VAIO FH14笔记жң¬жҠўе…ҲдҪ“йӘҢ

- еҲӣдёҡйӮҰ|ж»ҙж»ҙж——дёӢж©ҷеҝғдјҳйҖүиғңз®—еҮ дҪ•пјҹпјҢжҠўи·‘зӨҫеҢәеӣўиҙӯ