дә¬дёң|дә¬дёңжҺўзҙўзЁҖз–Ҹдёүз»ҙз©әй—ҙзӮ№дә‘Global ContextеӯҰд№ ж–№жі•иҺ·и®ӨеҸҜ

иҝ‘ж—Ҙ пјҢ 第34еұҠзҘһз»ҸдҝЎжҒҜеӨ„зҗҶзі»з»ҹеӨ§дјҡпјҲConference on Neural Information Processing Systems пјҢ з®Җз§°NeurIPS пјҢ NIPSпјүеңЁзәҝдёҠеҸ¬ејҖ гҖӮ дҪңдёәе…ЁзҗғйЎ¶зә§зҡ„жңәеҷЁеӯҰд№ е’Ңи®Ўз®—зҘһз»Ҹ科еӯҰдјҡи®® пјҢ д»Ҡе№ҙзҡ„NIPSдҫқ然еҸ—еҲ°дәҶеӯҰиҖ…们зҡ„й«ҳеәҰе…іжіЁ пјҢ з”ҡиҮіз”ұдәҺе…¶зәҝдёҠејҖж”ҫзҡ„зү№жҖ§зј“и§ЈдәҶеҫҖе№ҙжҠўзҘЁйҡҫзҡ„й—®йўҳ пјҢ иҖҢе°ҶиҺ·еҫ—жӣҙеӨҡзҡ„вҖңеҗ¬дј—вҖқ гҖӮ

жҚ®жӮү пјҢ д»Ҡе№ҙNeurIPSзЁҝ件еҪ•еҸ–зҺҮдёә20.09% пјҢ еҲӣдёӢеҺҶеҸІж–°дҪҺ гҖӮ еңЁеҰӮжӯӨдёҘиӢӣзҡ„еҪ•еҸ–ж ҮеҮҶд№ӢдёӢ пјҢ дә¬дёңAIж·ұеәҰеӯҰд№ дёҺиҜӯйҹіиҜӯд№үе®һйӘҢе®ӨжҸҗдәӨзҡ„жҺўзҙўзЁҖз–Ҹ3DзӮ№дә‘Global Contextзҡ„и®әж–ҮгҖҠGroup Contextual Encoding for 3D Point CloudsгҖӢжҲҗеҠҹе…ҘйҖү гҖӮ д»Ҡе№ҙд»ҘжқҘ пјҢ дә¬дёңAIж·ұеәҰеӯҰд№ дёҺиҜӯйҹіиҜӯд№үе®һйӘҢе®Өзҡ„з ”з©¶жҲҗжһңйў‘иҺ·еӣҪйҷ…и®ӨеҸҜ пјҢ жӯӨеүҚиҝҳжңүеӨҡзҜҮи®әж–Үе…ҘйҖүеӣҪйҷ…иҜӯйҹіе’ҢиҜӯиЁҖеӨ„зҗҶйЎ¶дјҡжҜ”еҰӮACL 2020гҖҒAAAI 2020гҖҒINTERSPEECH 2020зӯү гҖӮ

гҖҗдә¬дёң|дә¬дёңжҺўзҙўзЁҖз–Ҹдёүз»ҙз©әй—ҙзӮ№дә‘Global ContextеӯҰд№ ж–№жі•иҺ·и®ӨеҸҜгҖ‘Global ContextеҜ№и§Ҷи§үж„ҹзҹҘиҮіе…ійҮҚиҰҒ пјҢ еҸҜд»Ҙж №жҚ®иҜӯд№үдҝЎжҒҜжҸҗй«ҳзү©дҪ“иҜҶеҲ«зҡ„еҮҶзЎ®зҺҮ пјҢ дҪҶзӣ®еүҚй’ҲеҜ№3DзӮ№дә‘зҡ„Global Contextзҡ„з ”з©¶иҝҳдёҚеӨҹе……еҲҶ пјҢ зү№еҲ«жҳҜеңЁдёүз»ҙз©әй—ҙзҡ„жғ…еҶөдёӢ пјҢ ж•°жҚ®е‘ҲзҺ°й«ҳз»ҙгҖҒзЁҖз–Ҹзҡ„зү№зӮ№ пјҢ еҜ№дј з»ҹж·ұеәҰеӯҰд№ з®—жі•жҸҗеҮәдәҶжҢ‘жҲҳ гҖӮ еӣ жӯӨ пјҢ дә¬дёңAIз ”з©¶йҷўеҹәдәҺе…¶з ”з©¶е®һд№ з”ҹи®ЎеҲ’дёҺдёңдә¬еӨ§еӯҰеҗҲдҪңдәҶгҖҠGroup Contextual Encoding for 3D Point CloudsгҖӢ пјҢ й’ҲеҜ№иҝҷдёҖз ”з©¶йўҶеҹҹжҸҗеҮәдәҶGroup Contextual Encodingзҡ„Global ContextеӯҰд№ ж–№жі• гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

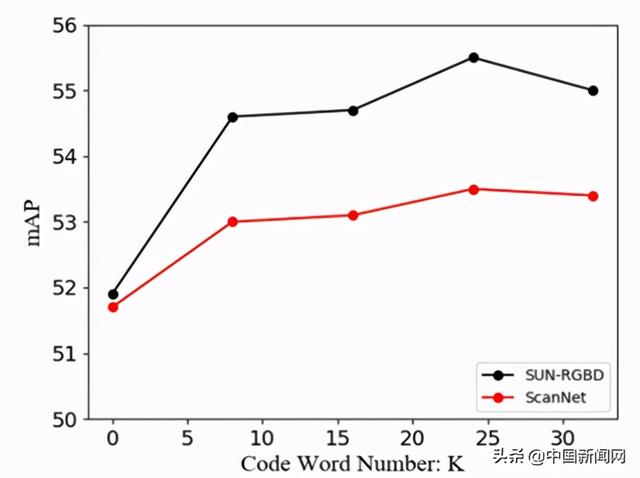

д»Һзӣ®еүҚе·Іжңү3DзӮ№дә‘GlobalContextзҡ„з ”з©¶жҲҗжһңжқҘзңӢ пјҢ жҜ”еҰӮLG-PointNet++гҖҗ1гҖ‘ пјҢ е…¶еӨҚжқӮеәҰдёә пјҢ NжҳҜиҫ“е…ҘзӮ№зҡ„дёӘж•° гҖӮ еҪ“еңәжҷҜеӨҚжқӮж—¶ пјҢ иҫ“е…ҘзӮ№ж•°иҫғеӨҡдјҡеҜјиҮҙиҖ—иҙ№зӣёеҪ“еӨ§зҡ„з®—еҠӣ гҖӮ ContextualEncodingLayerгҖҗ2гҖ‘зҡ„еӨҚжқӮеәҰжҳҜ пјҢ жҳҜдёҖз§Қжңүж•ҲзҺҮзҡ„ж–№жі• пјҢ KжҳҜиҜҘж–№жі•йҮҢcodewordж•°зӣ® гҖӮ дҪҶжҳҜзӮ№дә‘ж•°жҚ®зЁҖз–ҸеҜјиҮҙзҡ„иҝҮжӢҹеҗҲзҺ°иұЎпјҲoverfittingпјү пјҢ дјҡеҪұе“ҚжҖ§иғҪзҡ„жҸҗеҚҮ пјҢ еҜјиҮҙеңЁScanNet пјҢ SUN-RGBDж•°жҚ®йӣҶдёҠ3DжЈҖжөӢжҖ§иғҪйҡҸзқҖCodewordж•°зӣ®Kзҡ„еўһй•ҝ пјҢ жҖ§иғҪеҚҙеҫҲеҝ«е°ұйҘұе’ҢдёҚеҶҚеўһй•ҝ гҖӮ иҷҪ然зӣ®еүҚжңүдёҖдәӣж·ұеәҰиЎҘе…Ёзҡ„з®—жі•еҸҜд»Ҙи§ЈеҶіж•°жҚ®зЁҖз–ҸиҝҷдёӘй—®йўҳ пјҢ дҪҶжҳҜиҝҷдәӣз®—жі•йғҪеӯҳеңЁз»“жһ„еӨҚжқӮгҖҒиҖ—иҙ№и®Ўз®—иө„жәҗзҡ„й—®йўҳ пјҢ еӣ жӯӨ пјҢ дә¬дёңAIз ”з©¶йҷўеҶіе®ҡжҺўзҙўз®ҖеҚ•жңүж•Ҳзҡ„ж–№жі• гҖӮ

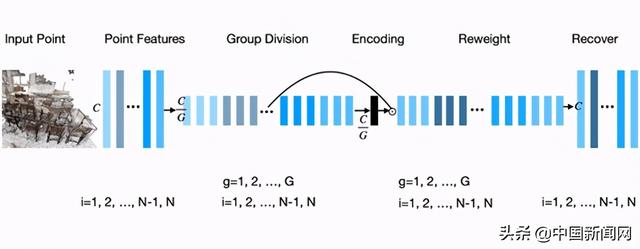

йҰ–е…ҲиҰҒи§ЈеҶіж•°жҚ®зҡ„зЁҖз–Ҹй—®йўҳ гҖӮ йҖҡиҝҮжҠҠзү№еҫҒйҖҡйҒ“еҲҶз»„ пјҢ д»ҺиҖҢиҺ·еҫ—жӣҙеӨҡзҡ„зӯүж•Ҳж•°жҚ® пјҢ еҰӮеӣҫ1жүҖзӨә пјҢ еҰӮжһңжҠҠйҖҡйҒ“еҲҶжҲҗGз»„зү№еҫҒеӯҗеҗ‘йҮҸ пјҢ ж•°жҚ®е°ұзӣёеҜ№еә”еўһе№ҝдәҶGеҖҚ гҖӮ еҶҚе°ҶеҲҶз»„еҗҺзҡ„зү№еҫҒеӯҗеҗ‘йҮҸйҖҡиҝҮEncoding layerеҫ—еҲ°Global context пјҢ д»ҺиҖҢжңүеҲ©дәҺеңЁеҲҶз»„еҗҺзҡ„зү№еҫҒеӯҗз©әй—ҙеӯҰд№ е…ЁеұҖдёҠдёӢж–Ү пјҢ然еҗҺйҖҡиҝҮchannel attentionзҡ„еҪўејҸдҪңз”ЁдәҺеҲҶз»„еҗҺзҡ„зү№еҫҒ гҖӮ жңҖеҗҺйҖҡиҝҮConcatж“ҚдҪңжҒўеӨҚдёәеҺҹзү№еҫҒзҡ„е°әеҜё гҖӮ еҰӮжӯӨж“ҚдҪңж—ўи§ЈеҶідәҶж•°жҚ®зҡ„зЁҖз–Ҹй—®йўҳ пјҢ еҸҲи§ЈеҶіз®—жі•з»“жһ„еӨҚжқӮгҖҒз®—еҠӣиҖ—иҙ№е·ЁеӨ§зҡ„й—®йўҳ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

еӣҫ1пјҡGroupContextualEncodingж–№жі•еӣҫ гҖӮ

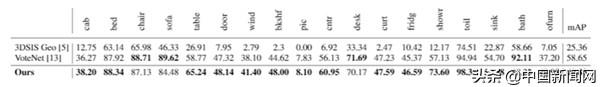

йҡҸеҗҺ пјҢ дә¬дёңAIз ”з©¶йҷўеҸҲе°Ҷиҝҷз§Қж–№жі•еңЁеӨҡдёӘ3Dж•°йӣҶдёҠиҝӣиЎҢйӘҢиҜҒ пјҢ дёҚд»…иҜҒе®һиҝҷз§Қж–№жі•з®ҖеҚ•жңүж•Ҳ пјҢ иҝҳеҲ·ж–°дәҶSOTAж–№жі•зҡ„жҖ§иғҪ гҖӮ е°Ҷиҝҷз§Қж–№жі•еә”з”ЁеңЁPointNet++ BackboneдёҠ пјҢ 并йғЁзҪІеҲ°VoteNetжЁЎеһӢ гҖӮ еҰӮиЎЁ1жүҖзӨә пјҢ еңЁScanNetж•°жҚ®йӣҶд»ҘmAP@0.25жҢҮж ҮжөӢиҜ„ж—¶ пјҢ иҜҘж–№жі•йўҶе…ҲVoteNet гҖҗ3гҖ‘ 2.2mAP пјҢ еўһ幅已然жҳҺжҳҫ пјҢ дҪҶжӣҙд»ӨдәәжғҠе–ңзҡ„жҳҜ пјҢ еңЁжӣҙеҠ дёҘж јзҡ„mAP@0.5 зҡ„жҢҮж ҮдёӢ пјҢ еҰӮиЎЁ2жүҖзӨә пјҢ иҜҘж–№жі•йўҶе…ҲWaymoгҖҒFacebook AI Researchд»ҘеҸҠStanfordеӨ§еӯҰжҸҗеҮәзҡ„ VoteNetй«ҳиҫҫ6.57 mAP пјҢ еҸҜи§ҶеҢ–з»“жһңеҰӮеӣҫ2жүҖзӨә гҖӮ

иЎЁ1пјҡScanNetж•°жҚ®йӣҶmAP@0.25иҜ„жөӢжҢҮж Үзҡ„з»“жһң гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

иЎЁ2пјҡScanNetж•°жҚ®йӣҶmAP@0.5иҜ„жөӢжҢҮж Үзҡ„з»“жһң гҖӮ

жҺЁиҚҗйҳ…иҜ»

- жӣҫиў«дә¬дёңзү©жөҒж•Ҳд»ҝпјҢи®©йӣ·еҶӣиҠұ1дәҝжӢҜж•‘пјҢеҰӮд»Ҡж¬ 7000дёҮеҪ»еә•еҮәеұҖ

- зҰ»ејҖеҚҺдёәзҡ„ж–°иҚЈиҖҖжһҜжңЁйҡҫж”ҜпјҹйҰ–ж¬ҫжүӢжңәе°ұиў«еҶ·иҗҪпјҢдә¬дёңйў„зәҰж•°еӨӘйҡҫзңӢ

- еҫҗзҰҸи®°иҒ”жүӢJDLдә¬дёңзү©жөҒеҗ‘ж•°жҷәеҢ–иҪ¬еһӢпјҢйҰ–ж¬ЎиҗҪең°жҷәж…§еӣӯеҢәйЎ№зӣ®

- еӨҡ家еҝ«йҖ’жҡӮеҒңеҸ‘еҫҖжІіеҢ—зңҒеҝ«д»¶пјҢйЎәдё°иЎЁзӨәе…ҲжҡӮеҒңдёүеӨ©пјҢдә¬дёңе°ҸзЁӢеәҸе·Іж— жі•дёӢеҚ•

- дј з»ҹзғҹй…’еә—йҡҫеҒҡпјҹд»–еҠ е…Ҙдә¬дёңдҫҝеҲ©еҗҚй…’иҚҹеҗҺдёҖи·ҜвҖңејҖжҢӮвҖқ

- еёӮ科委дёҺиҒ”еҪұйӣҶеӣўиҒ”еҗҲйҰ–и®ҫвҖңжҺўзҙўиҖ…и®ЎеҲ’вҖқпјҢе…ұжҺЁеҹәзЎҖеҸҠеә”з”ЁеҹәзЎҖз ”з©¶

- зҫҺзҡ„жҺўзҙўе·Ҙдёҡдә’иҒ”зҪ‘+5G+AIеә”з”ЁеңәжҷҜпјҢжҲҗжң¬еҸҜйҷҚдҪҺ10%

- дә¬дёңPLUSи¶…зә§иҒ”еҗҚеҚЎпјҡд»·еҖј1608е…ғеҸӘйңҖ218е…ғгҖҒйҖҒ5ж–ӨиҪҰеҺҳеӯҗ

- зӣ’马йІңз”ҹгҖҒдә¬дёңи¶…зә§дҪ“йӘҢеә—пјҢжҳҺе№ҙдјҡеңЁйғ‘е·һејҖеә—еҗ—пјҹ| жҸҗй—®2021

- е°Ҹе§җе§җеёҰдҪ жҺўзҙўиҗҢзІүз”өз«һжҳҫзӨәеҷЁзҡ„з§ҳеҜҶ