黑科技篮子|参数量仅为1/300,谷歌最新的NLP模型,性能媲美BERT( 二 )

研究者将其与一个密集bottleneck层结合在一起 , 以使网络可以学习到一个与手头任务相关的逐词表示 。 bottleneck层产生的表示仍然没有考虑到词的上下文 。 因此 , 研究者利用若干双向QRNN编码器学习了一个上下文表示 。 这样可以得到一个仅从文本输入就能学到上下文表示的网络 , 并且无需任何预处理 。

文章图片

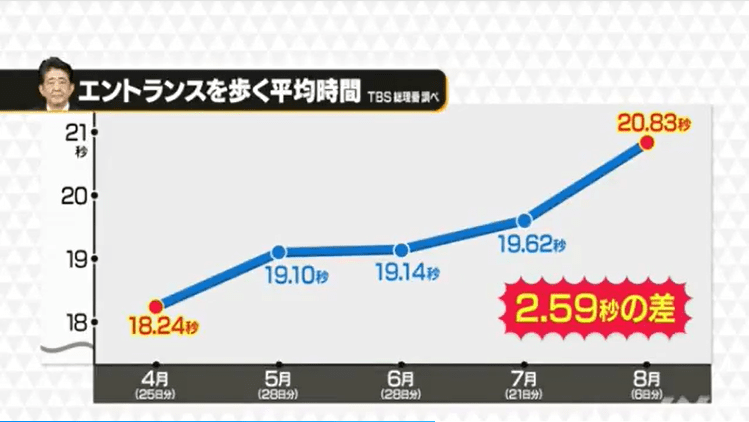

pQRNN的性能

研究者在civil_comments数据集上评估了pQRNN , 并将其与BERT模型在相同的任务中进行了比较 。 模型的大小与其参数量成正比 , 因此pQRNN比BERT小得多 。

此外 , pQRNN还进行了量化处理(quantized) , 因此模型体积进一步缩小到原来的1/4 。 公开训练的BERT在本文的任务中表现不好 , 因此拿来对比的BERT其实是在几个不同的相关多语言数据源上进行预训练得到的 , 以使其达到最好的表现 。

文章图片

在实验中 , 研究者得到了两个模型的AUC信息 。 在没有任何预训练、只在监督数据训练的情况下 , pQRNN的AUC是0.963 , 用到了130万个量化(8-bit)参数 。 在几个不同数据源进行预训练并在监督数据上进行微调之后 , BERT模型得到的AUC是0.976 , 用到了1.1亿个浮点参数 。

为了鼓励社区在谷歌研究成果的基础上做出进一步改进 , 谷歌还开源了PRADO模型 。

项目地址:https://github.com/tensorflow/models/tree/master/research/sequence_projection

【黑科技篮子|参数量仅为1/300,谷歌最新的NLP模型,性能媲美BERT】博客链接:https://ai.googleblog.com/2020/09/advancing-nlp-with-efficient-projection.html

推荐阅读

- 七号人称说科技|华为始料未及?台积电又成了“炮灰”?新风暴说来就来

- 大众新闻|众安科技荣获“今日·保险中介榜”年度Insurtech独角兽

- 雷科技|朋友圈都在秀的“互联网勋章”到底是什么?

- 快科技|小米10至尊纪念版妙享功能升级:手机与Windows电脑合体

- 七号人称说科技|再给华为一颗糖?美国到底在打什么“算盘”?,先给华为一巴掌

- 小米科技|小米旗舰再“搅局”!144Hz+2K+百倍变焦,5纳米性能赶超A14

- 科技小乐乐|12:你想太多了,跌至4784元?全网刷屏的琼版iPhone

- 雷科技|12直降1500,海南版真有这么香?,iPhone

- 科技小乐乐|为什么国内有人已拿到iPhone12却不敢开机?

- 浪浪科技|亚马逊42%的评论为虚假评论,报告:疫情期间