дёҚиҝҮпјҢдёҖе‘іең°йҳ»жӯў AI дҪҝз”Ёзҡ„жү©еұ•пјҢ并дёҚжҳҜи§ЈеҶій—®йўҳзҡ„ж №жң¬ гҖӮStack Overflow й’ҲеҜ№ AI зҡ„дҪҝз”ЁпјҢи®ЎеҲ’еҗ‘йӮЈдәӣеңЁжһ„е»әиҮӘе·ұзҡ„дәәе·ҘжҷәиғҪе·Ҙе…·ж—¶жҠ“еҸ–е…¶ж•°жҚ®зҡ„е…¬еҸёж”¶иҙ№ гҖӮйҷӨжӯӨд№ӢеӨ–пјҢStack Overflow иҮӘиә«д№ҹжңүи®ЎеҲ’жҸҗдҫӣ AI зӣёе…іжңҚеҠЎ гҖӮ

еҸҰдёҖдёӘеҸ—еҲ° AI еҪұе“ҚиҫғеӨ§зҡ„е№іеҸ°дҫҝжҳҜй—®зӯ”зӨҫеҢә Reddit гҖӮ“Reddit зҡ„ж•°жҚ®еҫҲжңүд»·еҖјпјҢдҪҶжҳҜжҲ‘们дёҚйңҖиҰҒе°ҶжүҖжңүиҝҷдәӣд»·еҖје…Қиҙ№жҸҗдҫӣз»ҷдё–з•ҢдёҠдёҖдәӣжңҖеӨ§зҡ„е…¬еҸё”пјҢеҪ“ Reddit CEO Steve Huffman иҜҙеҮәиҝҷеҸҘиҜқж—¶пјҢдҫҝж„Ҹе‘ізқҖиҜҘе…¬еҸёдјҡжңүжүҖеҠЁдҪңдәҶ гҖӮ

д»ӨдәәдёҮдёҮжІЎжғіеҲ°зҡ„жҳҜпјҢе…¶жӣҙж–°дәҶ Reddit API 收иҙ№ж”ҝзӯ– пјҢжғіиҰҒд»ҺдёӯиҺ·еҫ—жӣҙеӨҡ收е…ҘпјҢд№ҹдёәдәҶи®©е…¶ж•°жҚ®жңүдёҖе®ҡзҡ„д»·еҖјдҪ“зҺ°ж—¶пјҢеҚҙйҒӯеҲ°дәҶеҫҲеӨҡзүҲдё»е®һж–Ҫе°Ғй”ҒзӨҫеҢәзүҲеқ—д»ҘзӨәжҠ—и®® гҖӮ

жңҖеҗҺпјҢдҪңдёәеҫҲеӨҡзҪ‘з«ҷи®ҝй—®зҡ„е…ҘеҸЈпјҢе…Ёзҗғ第дёҖеӨ§жҗңзҙўеј•ж“Һ Google жҺҢжҸЎзқҖзҺ°д»Ј Web зҪ‘з«ҷзҡ„е‘Ҫи„ү гҖӮдёҚиҝҮпјҢеҸ— Bing AI е’Ң ChatGPT дҪңдёәжӣҝд»Јжҗңзҙўеј•ж“Һзҡ„и¶ӢеҠҝжҺЁеҠЁпјҢGoogle д№ҹжӯЈеңЁйҮҮеҸ–иЎҢеҠЁпјҢжңүеӘ’дҪ“жҠҘйҒ“з§°пјҢGoogle жӯЈеҜ»жұӮжү“йҖ дёҖж¬ҫз”ұ AI жҠҖжңҜй©ұеҠЁзҡ„е…Ёж–°жҗңзҙўеј•ж“ҺпјҢж–°еј•ж“Һзҡ„дёҖеӨ§зү№зӮ№жҳҜ“иғҪеӨҹзҢңеҲ°з”ЁжҲ·зҡ„йңҖжұӮ”пјҢиҜҘеј•ж“Һе°Ҷж №жҚ®з”ЁжҲ·зҡ„жҗңзҙўеҶ…е®№пјҢеӯҰд№ е№¶йў„жөӢз”ЁжҲ·жғіиҰҒзҹҘйҒ“зҡ„дәӢжғ…пјҢ并且е°ҶжҸҗдҫӣйў„е…ҲжҢ‘йҖүзҡ„иҙӯд№°зү©е“ҒгҖҒз ”з©¶дҝЎжҒҜе’Ңе…¶д»–дҝЎжҒҜзҡ„жё…еҚ• гҖӮеҰӮжһң Google зңҹзҡ„е®һж–ҪиҝҷдёҖи®ЎеҲ’пјҢйӮЈд№Ҳ AI еҜ№дј з»ҹзҪ‘з«ҷеёҰжқҘзҡ„еҪұе“Қе°ҶжҳҜе·ЁеӨ§зҡ„ гҖӮ

и®© AI жҺҢиҲө Web зҪ‘з«ҷпјҢдјҡеҸ‘з”ҹд»Җд№Ҳпјҹ

жҜӢеәёзҪ®з–‘пјҢAI зҺ°еңЁеҸҳеҫ—ж— еӨ„дёҚеңЁпјҢеҖҳиӢҘжүҖжңүзҡ„е№іеҸ°пјҢйғҪиў« AI иҡ•йЈҹпјҢеҸҲдјҡжңүд»Җд№Ҳж ·еҸҳеҢ–пјҹ

еҜ№жӯӨпјҢ科жҠҖзҪ‘з«ҷ Tom's Hardware зҡ„дё»зј– Avram Piltch жҢҮеҮәпјҢе°Ҫз®Ўдәәе·ҘжҷәиғҪжӢҘжңүйҮҚз»„ж–Үжң¬зҡ„иғҪеҠӣпјҢдҪҶжңҖз»ҲеҲӣе»әеә•еұӮж•°жҚ®зҡ„жҳҜдәә——ж— и®әжҳҜйҮҮи®ҝдәәе‘ҳжӢҝиө·з”өиҜқж ёжҹҘдәӢе®һпјҢиҝҳжҳҜеңЁйҒҮеҲ°з”өжұ й—®йўҳж—¶ Reddit з”ЁжҲ·иғҪеҫҲй«ҳе…ҙе‘ҠиҜүдҪ жҳҜжҖҺд№Ҳдҝ®еӨҚе®ғзҡ„ гҖӮ

зӣёжҜ”д№ӢдёӢпјҢAI иҜӯиЁҖжЁЎеһӢе’ҢиҒҠеӨ©жңәеҷЁдәәдә§з”ҹзҡ„дҝЎжҒҜйҖҡеёёдёҚдёҖе®ҡеҜ№пјҢжӣҙдёәжЈҳжүӢзҡ„жҳҜпјҢеҪ“е®ғеҮәй”ҷж—¶пјҢе…¶й”ҷиҜҜж–№ејҸеҫҖеҫҖеҫҲйҡҫиў«еҸ‘зҺ° гҖӮеӣ жӯӨпјҢиҝҷйңҖиҰҒж—¶й—ҙе’Ңдё“дёҡзҹҘиҜҶжқҘиҝӣдёҖжӯҘж ёе®һ гҖӮ

еҰӮжһңжңәеҷЁз”ҹжҲҗзҡ„еҶ…е®№еҸ–д»ЈдәҶдәәзұ»зҡ„дҪңиҖ…иә«д»ҪпјҢйӮЈд№ҲеңЁеҺҹжң¬еҸӘжңүдәәзҠҜй”ҷзҡ„еҹәзЎҖдёҠпјҢжңүеӨҡдәҶ AI жң¬иә«е°ұдјҡзҠҜй”ҷпјҢз”ҡиҮідёҖе®ҡзЁӢеәҰдёҠйҳ»зўҚдәҶдәәзұ»дё“дёҡзҹҘиҜҶзҡ„жұІеҸ–иғҪеҠӣпјҢйӮЈд№Ҳзә жӯЈжҲ‘们йӣҶдҪ“й”ҷиҜҜзҡ„жңәдјҡе°ұдјҡеҮҸе°‘ гҖӮ

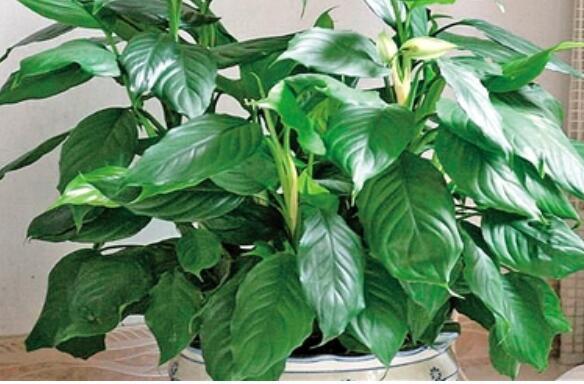

ж–Үз« жҸ’еӣҫ

дёҺжӯӨеҗҢж—¶пјҢThe Verge йҮҮи®ҝдәәе‘ҳ James Vincent жҢҮеҮәпјҢдәәе·ҘжҷәиғҪеҜ№ Web зҡ„еҪұе“Қ并дёҚжҳҜйӮЈд№Ҳз®ҖеҚ•е°ұеҸҜд»ҘжҰӮжӢ¬зҡ„ гҖӮеҚідҪҝеңЁдёҠйқўеј•з”Ёзҡ„е°‘ж•°дҫӢеӯҗдёӯпјҢд№ҹжңүи®ёеӨҡдёҚеҗҢзҡ„жңәеҲ¶еңЁиө·дҪңз”Ё гҖӮ

еңЁд»–зңӢжқҘпјҢжңҖжҲҗеҠҹзҡ„зҪ‘з«ҷеҫҖеҫҖжҳҜеҲ©з”Ёи§„жЁЎеҸ‘жҢҘе…¶дјҳеҠҝзҡ„зҪ‘з«ҷпјҢиҰҒд№ҲйҖҡиҝҮеўһеҠ зӨҫдјҡиҒ”зі»жҲ–дә§е“ҒйҖүжӢ©пјҢиҰҒд№ҲйҖҡиҝҮеҜ№жһ„жҲҗдә’иҒ”зҪ‘жң¬иә«зҡ„е·ЁеӨ§дҝЎжҒҜзҫӨиҝӣиЎҢеҲҶзұ»пјҢдҪҶиҝҷз§Қ规模дҫқиө–дәҺеӨ§йҮҸдәәзұ»жқҘеҲӣйҖ жҪңеңЁд»·еҖјпјҢеңЁеӨ§и§„жЁЎз”ҹдә§ж–№йқўпјҢдәәзұ»жҳҫз„¶ж— жі•еҮ»иҙҘдәәе·ҘжҷәиғҪ гҖӮ

дҪҶиҝҷдёҖе®ҡжҳҜдёҖ件еқҸдәӢеҗ—пјҹ

е…¶е®һдёҚ然пјҢJames Vincent и®ӨдёәпјҢ“жңүдәӣдәәдјҡиҜҙиҝҷеҸӘжҳҜдё–з•ҢиҝҗиЎҢзҡ„дёҖз§Қж–№ејҸпјҢ并жҢҮеҮә Web жң¬иә«жқҖжӯ»дәҶд№ӢеүҚзҡ„дәӢзү©пјҢиҖҢдё”еҫҖеҫҖжҳҜдёәдәҶеҸҳеҫ—жӣҙеҘҪ гҖӮдҫӢеҰӮпјҢеҚ°еҲ·зүҲзҷҫ科全д№ҰеҮ д№Һе·Із»Ҹз»қиҝ№пјҢдҪҶжҲ‘жӣҙе–ңж¬ўз»ҙеҹәзҷҫ科зҡ„е№ҝеәҰе’ҢеҸҜи®ҝй—®жҖ§пјҢиҖҢдёҚжҳҜгҖҠеӨ§иӢұзҷҫ科全д№ҰгҖӢзҡ„еҺҡеәҰе’ҢдҝқиҜҒ гҖӮеҜ№дәҺдёҺдәәе·ҘжҷәиғҪз”ҹжҲҗзҡ„еҶҷдҪңзӣёе…ізҡ„жүҖжңүй—®йўҳпјҢд№ҹжңүеҫҲеӨҡж–№жі•еҸҜд»Ҙж”№иҝӣе®ғ——д»Һж”№иҝӣзҡ„еј•ж–ҮеҠҹиғҪеҲ°жӣҙеӨҡзҡ„дәәе·Ҙзӣ‘зқЈ гҖӮ еҸҰеӨ–пјҢеҚідҪҝ Web е°Ҫз®Ўе……ж–ҘзқҖдәәе·ҘжҷәиғҪеһғеңҫпјҢдҪҶе®ғеҸҜиғҪдјҡиў«иҜҒжҳҺжҳҜжңүзӣҠзҡ„пјҢиғҪеӨҹеҲәжҝҖиө„йҮ‘жӣҙе……и¶ізҡ„е№іеҸ°зҡ„еҸ‘еұ• гҖӮдҫӢеҰӮпјҢеҰӮжһң Google жҖ»жҳҜеңЁжҗңзҙўдёӯз»ҷдҪ жҸҗдҫӣеһғеңҫз»“жһңпјҢдҪ еҸҜиғҪдјҡжӣҙеҖҫеҗ‘дәҺдёәдҪ дҝЎд»»зҡ„жқҘжәҗд»ҳиҙ№е№¶зӣҙжҺҘи®ҝй—®е®ғ们 гҖӮ”

дәӢе®һдёҠпјҢдәәе·ҘжҷәиғҪзӣ®еүҚйҖ жҲҗзҡ„еҸҳеҢ–еҸӘжҳҜ Web еҺҶеҸІдёҠй•ҝжңҹж–—дәүдёӯзҡ„жңҖж–°дёҖдёӘ гҖӮд»Һжң¬иҙЁдёҠи®ІпјҢиҝҷжҳҜдёҖеңәдҝЎжҒҜд№ӢжҲҳ——и°ҒеҲ¶йҖ дҝЎжҒҜгҖҒеҰӮдҪ•и®ҝй—®дҝЎжҒҜд»ҘеҸҠи°ҒиҺ·еҫ—жҠҘй…¬ гҖӮдҪҶд»…д»…еӣ дёәжҲҳж–—жҳҜзҶҹжӮүзҡ„并дёҚж„Ҹе‘ізқҖе®ғдёҚйҮҚиҰҒпјҢд№ҹдёҚиғҪдҝқиҜҒеҗҺз»ӯзҡ„зі»з»ҹдјҡжҜ”жҲ‘们зҺ°еңЁзҡ„зі»з»ҹжӣҙеҘҪ гҖӮж–° Web жӯЈеңЁеҠӘеҠӣиҜһз”ҹпјҢжҲ‘们зҺ°еңЁеҒҡеҮәзҡ„еҶіе®ҡе°ҶеҶіе®ҡе®ғзҡ„еҸ‘еұ•ж–№ејҸ гҖӮ

гҖҗAI жӯЈеңЁжқҖжӯ»ж—§ WebпјҹгҖ‘

жҺЁиҚҗйҳ…иҜ»

- дёҖиҫҶж—§з”өеҠЁиҪҰд»Ҙж—§жҚўж–°иғҪеҖјеӨҡе°‘пјҹиЎҢеҶ…дәәиҜҙеҮәе®һжғ…пјҢжҚўиҪҰж—¶еҝғйҮҢжңүдёӘеә•

- йңҚе»әеҚҺиў«еҒ¶йҒҮпјҢ43еІҒдҫқж—§её…ж°”дёҚеҮҸпјҢзЁҖз–ҸзҷҪеҸ‘жҠўй•ңпјҒзІүдёқеҒ¶йҒҮж„ҹиЁҖжӣқе…ү

- 34е№ҙиҝҮеҺ»дәҶпјҢеә„жңҲжҳҺзҡ„жӯ»пјҢдҫқж—§жҳҜжқҺжіҪжҘ·зҡ„еҝғеӨҙеҲәпјҢе’ҪдёҚдёӢд№ҹжӢ”дёҚеҮә

- й»„жӣІйңүиҸҢз”Ёд»Җд№ҲиғҪжқҖжӯ»

- и°ўдёңй—өдёәжңұжҷәиҙӨеәҶз”ҹдёәеҜ№ж–№жӢҚзҫҺз…§ еҘіеҸӢжӣҫеҒ·йЈҹеңҲдёӯдәәдҫқж—§дҝқжҢҒжҒ©зҲұ

- 家й•ҝзәій—·пјҢвҖңй«ҳ马е°ҫвҖқеңЁдёӯеӯҰз”ҹйҮҢйҖҗжёҗж¶ҲеӨұпјҢвҖңйІ¶йұјеӨҙвҖқеҚҙдҫқж—§зӣӣиЎҢ

- йҷҲжі•и“үжҫ„жё…и°ЈиЁҖпјҢе‘Ёжҳҹй©°и„ёдёҠеҸЈзәўеҚ°е’ҢиҮӘе·ұж— е…іпјҢ56еІҒжңӘе©ҡдҫқж—§жҙ’и„ұ

- жӯЈеңЁзғӯж’ӯзҡ„дә”йғЁз”өи§Ҷеү§пјҢгҖҠйӣӘй№°йўҶдё»гҖӢжҺ’еңЁжңҖеҗҺпјҢгҖҠй•ҝйЈҺжёЎгҖӢ第дәҢ

- йӯ”е…Ҫдё–з•ҢжҖҖж—§жңҚпјҡж–°еўһеҚ•жүӢж©ҷж–§еҷ¬зҘһиҖ…пјҢеұһжҖ§е…ЁйқўеҠ ејәиҪ»жқҫеҚ•жҢ‘е°ҫзҺӢ

- е°ҸSдёҺйҳҝйӣ…ж—§з…§иў«жү’иҫЈзңјзқӣпјҢиҖҢеӨ§SеҚҙеҫҲиҮӘеҫӢпјҢд»Һе°Ҹе°ұжҳҜд№–д№–еҘі