еҜ№жҜ”GPT-1пјҢGPT-2并жңӘеңЁжЁЎеһӢз»“жһ„дёҠеӨ§дҪңж–Үз« пјҢеҸӘжҳҜдҪҝз”ЁдәҶжӣҙеӨҡеҸӮж•°зҡ„жЁЎеһӢе’ҢжӣҙеӨҡзҡ„и®ӯз»ғж•°жҚ®пјҲиЎЁ1пјү гҖӮGPT-2жңҖйҮҚиҰҒзҡ„жҖқжғіжҳҜжҸҗеҮәдәҶ“жүҖжңүзҡ„жңүзӣ‘зқЈеӯҰд№ йғҪжҳҜж— зӣ‘зқЈиҜӯиЁҖжЁЎеһӢзҡ„дёҖдёӘеӯҗйӣҶ”зҡ„жҖқжғіпјҢиҝҷдёӘжҖқжғід№ҹжҳҜжҸҗзӨәеӯҰд№ пјҲPrompt Learningпјүзҡ„еүҚиә« гҖӮеүҚиЁҖGPTзі»еҲ—жҳҜOpenAIзҡ„дёҖзі»еҲ—йў„и®ӯз»ғж–Үз« пјҢGPTзҡ„е…Ёз§°жҳҜGenerative Pre-Trained TransformerпјҢйЎҫеҗҚжҖқд№үпјҢGPTзҡ„зӣ®зҡ„е°ұжҳҜйҖҡиҝҮTransformerдёәеҹәзЎҖжЁЎеһӢпјҢдҪҝз”Ёйў„и®ӯз»ғжҠҖжңҜеҫ—еҲ°йҖҡз”Ёзҡ„ж–Үжң¬жЁЎеһӢ гҖӮзӣ®еүҚе·Із»Ҹе…¬еёғи®әж–Үзҡ„жңүж–Үжң¬йў„и®ӯз»ғGPT-1пјҢGPT-2пјҢGPT-3пјҢд»ҘеҸҠеӣҫеғҸйў„и®ӯз»ғiGPT гҖӮжҚ®дј иҝҳжңӘеҸ‘еёғзҡ„GPT-4жҳҜдёҖдёӘеӨҡжЁЎжҖҒжЁЎеһӢ гҖӮжңҖиҝ‘йқһеёёзҒ«зҡ„ChatGPTе’Ңд»Ҡе№ҙе№ҙеҲқе…¬еёғзҡ„[1]жҳҜдёҖеҜ№е§җеҰ№жЁЎеһӢпјҢжҳҜеңЁGPT-4д№ӢеүҚеҸ‘еёғзҡ„йў„зғӯжЁЎеһӢпјҢжңүж—¶еҖҷд№ҹиў«еҸ«еҒҡGPT3.5 гҖӮChatGPTе’ҢInstructGPTеңЁжЁЎеһӢз»“жһ„пјҢи®ӯз»ғж–№ејҸдёҠйғҪе®Ңе…ЁдёҖиҮҙпјҢеҚійғҪдҪҝз”ЁдәҶжҢҮзӨәеӯҰд№ пјҲInstruction Learningпјүе’Ңдәәе·ҘеҸҚйҰҲзҡ„ејәеҢ–еӯҰд№ пјҲReinforcement Learning from Human FeedbackпјҢRLHFпјүжқҘжҢҮеҜјжЁЎеһӢзҡ„и®ӯз»ғпјҢе®ғ们дёҚеҗҢзҡ„д»…д»…жҳҜйҮҮйӣҶж•°жҚ®зҡ„ж–№ејҸдёҠжңүжүҖе·®ејӮ гҖӮжүҖд»ҘиҰҒжҗһжҮӮChatGPTпјҢжҲ‘们еҝ…йЎ»иҰҒе…ҲиҜ»жҮӮInstructGPT гҖӮ

1. иғҢжҷҜзҹҘиҜҶеңЁд»Ӣз»ҚChatGPT/InstructGPTд№ӢеүҚпјҢжҲ‘们е…Ҳд»Ӣз»Қе®ғ们дҫқиө–зҡ„еҹәзЎҖз®—жі• гҖӮ

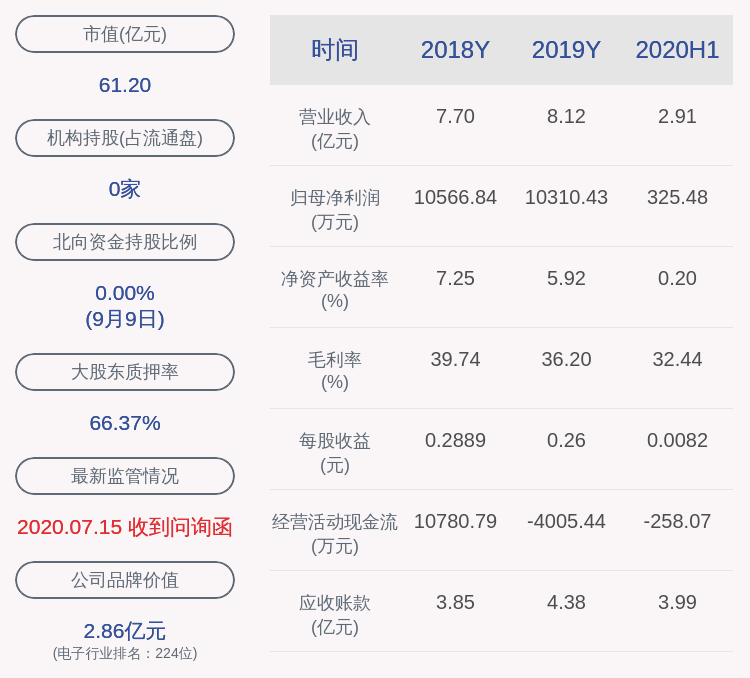

1.1 GPTзі»еҲ—еҹәдәҺж–Үжң¬йў„и®ӯз»ғзҡ„GPT-1[2]пјҢGPT-2[3]пјҢGPT-3[4]дёүд»ЈжЁЎеһӢйғҪжҳҜйҮҮз”Ёзҡ„д»ҘTransformerдёәж ёеҝғз»“жһ„зҡ„жЁЎеһӢпјҲеӣҫ1пјүпјҢдёҚеҗҢзҡ„жҳҜжЁЎеһӢзҡ„еұӮж•°е’ҢиҜҚеҗ‘йҮҸй•ҝеәҰзӯүи¶…еҸӮпјҢе®ғ们具дҪ“зҡ„еҶ…е®№еҰӮиЎЁ1 гҖӮ

ж–Үз« жҸ’еӣҫ

еӣҫ1пјҡGPTзі»еҲ—зҡ„жЁЎеһӢз»“жһ„пјҲе…¶дёӯTrmжҳҜдёҖдёӘTransformerз»“жһ„пјү

иЎЁ1пјҡеҺҶд»ЈGPTзҡ„еҸ‘еёғж—¶й—ҙпјҢеҸӮж•°йҮҸд»ҘеҸҠи®ӯз»ғйҮҸ

еҸ‘еёғж—¶й—ҙ

гҖҗChatGPT/InstructGPTиҜҰи§ЈгҖ‘еұӮж•°

еӨҙж•°

иҜҚеҗ‘йҮҸй•ҝеәҰ

еҸӮж•°йҮҸ

йў„и®ӯз»ғж•°жҚ®йҮҸ

GPT-1

2018 е№ҙ 6 жңҲ

12

12

768

1.17 дәҝ

зәҰ 5GB

GPT-2

2019 е№ҙ 2 жңҲ

48

-

1600

15 дәҝ

40GB

GPT-3

2020 е№ҙ 5 жңҲ

96

96

12888

1,750 дәҝ

45TB

GPT-1жҜ”BERTиҜһз”ҹз•Ҙж—©еҮ дёӘжңҲ гҖӮе®ғ们йғҪжҳҜйҮҮз”ЁдәҶTransformerдёәж ёеҝғз»“жһ„пјҢдёҚеҗҢзҡ„жҳҜGPT-1йҖҡиҝҮиҮӘе·Ұеҗ‘еҸіз”ҹжҲҗејҸзҡ„жһ„е»әйў„и®ӯз»ғд»»еҠЎпјҢ然еҗҺеҫ—еҲ°дёҖдёӘйҖҡз”Ёзҡ„йў„и®ӯз»ғжЁЎеһӢпјҢиҝҷдёӘжЁЎеһӢе’ҢBERTдёҖж ·йғҪеҸҜз”ЁжқҘеҒҡдёӢжёёд»»еҠЎзҡ„еҫ®и°ғ гҖӮGPT-1еҪ“ж—¶еңЁ9дёӘNLPд»»еҠЎдёҠеҸ–еҫ—дәҶSOTAзҡ„ж•ҲжһңпјҢдҪҶGPT-1дҪҝз”Ёзҡ„жЁЎеһӢ规模е’Ңж•°жҚ®йҮҸйғҪжҜ”иҫғе°ҸпјҢиҝҷд№ҹе°ұдҝғдҪҝдәҶGPT-2зҡ„иҜһз”ҹ гҖӮ

еҜ№жҜ”GPT-1пјҢGPT-2并жңӘеңЁжЁЎеһӢз»“жһ„дёҠеӨ§дҪңж–Үз« пјҢеҸӘжҳҜдҪҝз”ЁдәҶжӣҙеӨҡеҸӮж•°зҡ„жЁЎеһӢе’ҢжӣҙеӨҡзҡ„и®ӯз»ғж•°жҚ®пјҲиЎЁ1пјү гҖӮGPT-2жңҖйҮҚиҰҒзҡ„жҖқжғіжҳҜжҸҗеҮәдәҶ“жүҖжңүзҡ„жңүзӣ‘зқЈеӯҰд№ йғҪжҳҜж— зӣ‘зқЈиҜӯиЁҖжЁЎеһӢзҡ„дёҖдёӘеӯҗйӣҶ”зҡ„жҖқжғіпјҢиҝҷдёӘжҖқжғід№ҹжҳҜжҸҗзӨәеӯҰд№ пјҲPrompt Learningпјүзҡ„еүҚиә« гҖӮGPT-2еңЁиҜһз”ҹд№ӢеҲқд№ҹеј•еҸ‘дәҶдёҚе°‘зҡ„иҪ°еҠЁпјҢе®ғз”ҹжҲҗзҡ„ж–°й—»и¶ід»Ҙж¬әйӘ—еӨ§еӨҡж•°дәәзұ»пјҢиҫҫеҲ°д»ҘеҒҮд№ұзңҹзҡ„ж•Ҳжһң гҖӮз”ҡиҮіеҪ“ж—¶иў«з§°дёә“AIз•ҢжңҖеҚұйҷ©зҡ„жӯҰеҷЁ”пјҢеҫҲеӨҡй—ЁжҲ·зҪ‘з«ҷд№ҹе‘Ҫд»ӨзҰҒжӯўдҪҝз”ЁGPT-2з”ҹжҲҗзҡ„ж–°й—» гҖӮ

GPT-3иў«жҸҗеҮәж—¶пјҢйҷӨдәҶе®ғиҝңи¶…GPT-2зҡ„ж•ҲжһңеӨ–пјҢеј•иө·жӣҙеӨҡи®Ёи®әзҡ„жҳҜе®ғ1750дәҝзҡ„еҸӮж•°йҮҸ гҖӮGPT-3йҷӨдәҶиғҪе®ҢжҲҗеёёи§Ғзҡ„NLPд»»еҠЎеӨ–пјҢз ”з©¶иҖ…ж„ҸеӨ–зҡ„еҸ‘зҺ°GPT-3еңЁеҶҷSQLпјҢJAVAScriptзӯүиҜӯиЁҖзҡ„д»Јз ҒпјҢиҝӣиЎҢз®ҖеҚ•зҡ„ж•°еӯҰиҝҗз®—дёҠд№ҹжңүдёҚй”ҷзҡ„иЎЁзҺ°ж•Ҳжһң гҖӮGPT-3зҡ„и®ӯз»ғдҪҝз”ЁдәҶжғ…еўғеӯҰд№ пјҲIn-context LearningпјүпјҢе®ғжҳҜе…ғеӯҰд№ пјҲMeta-learningпјүзҡ„дёҖз§ҚпјҢе…ғеӯҰд№ зҡ„ж ёеҝғжҖқжғіеңЁдәҺйҖҡиҝҮе°‘йҮҸзҡ„ж•°жҚ®еҜ»жүҫдёҖдёӘеҗҲйҖӮзҡ„еҲқе§ӢеҢ–иҢғеӣҙпјҢдҪҝеҫ—жЁЎеһӢиғҪеӨҹеңЁжңүйҷҗзҡ„ж•°жҚ®йӣҶдёҠеҝ«йҖҹжӢҹеҗҲпјҢ并иҺ·еҫ—дёҚй”ҷзҡ„ж•Ҳжһң гҖӮ

йҖҡиҝҮдёҠйқўзҡ„еҲҶжһҗжҲ‘们еҸҜд»ҘзңӢеҮәд»ҺжҖ§иғҪи§’еәҰдёҠи®ІпјҢGPTжңүдёӨдёӘзӣ®ж Үпјҡ

- жҸҗеҚҮжЁЎеһӢеңЁеёёи§ҒNLPд»»еҠЎдёҠзҡ„иЎЁзҺ°ж•Ҳжһңпјӣ

- жҸҗеҚҮжЁЎеһӢеңЁе…¶д»–йқһе…ёеһӢNLPд»»еҠЎпјҲдҫӢеҰӮд»Јз Ғзј–еҶҷпјҢж•°еӯҰиҝҗз®—пјүдёҠзҡ„жіӣеҢ–иғҪеҠӣ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- ChatGPTз”ЁдәҺз”ҹдә§зә§еҜ№иҜқејҸAIзі»з»ҹзҡ„йӮЈдәӣзјәзӮ№

- ChatGPTжҗһй’ұиЎҢдёҚиЎҢ

- дёҖж–ҮиҜҰи§ЈPythonиҜӯиЁҖйҖүжӢ©з»“жһ„е’ҢеҫӘзҺҜз»“жһ„

- icloudжҖҺд№Ҳз”ЁпјҢicloudзҡ„жӯЈзЎ®з”Ёжі•иҜҰи§Ј

- з”өе•ҶиҝҗиҗҘжҖҺд№ҲеҒҡж•°жҚ®еҲҶжһҗпјҢиҜҰи§Јз”өе•ҶиҝҗиҗҘзӯ–з•Ҙ

- еӨ©зҢ«иҪ¬и®©йңҖиҰҒеӨҡе°‘й’ұпјҢеӨ©зҢ«еә—й“әиҪ¬и®©жөҒзЁӢеҸҠиҙ№з”ЁиҜҰи§Ј

- е»әзҪ‘з«ҷйңҖиҰҒеӨҡе°‘й’ұпјҢе»әз«ҷиҙ№з”ЁиҜҰи§Ј

- ејҖеҸ‘иҪҜ件йңҖиҰҒд»Җд№Ҳй…ҚзҪ®еҸҠжҠҖжңҜпјҢиҪҜ件ејҖеҸ‘жөҒзЁӢиҜҰи§Ј

- еүҚз«Ҝjsдёӯhttpи·іиҪ¬httpsжҠҘ403й”ҷиҜҜпјҢиҜ·жұӮеӨҙrefererиҜҰи§Ј

- ChatGPTзҲҶзҒ«иғҢеҗҺпјҢз”ҹжҲҗејҸAIжҳҜеҗҰеҸӘжҳҜвҖңжҳҷиҠұдёҖзҺ°вҖқпјҹ