"routing_key": "default"

},

# еҮЎжҳҜ topic ејҖеӨҙзҡ„ routing key

# йғҪдјҡиў«ж”ҫеҲ°иҝҷдёӘйҳҹеҲ—

"topicqueue": {

"routing_key": "topic.#",

"exchange": "topic_exchange",

"exchange_type": "topic",

},

"task_eeg": { # и®ҫзҪ®жүҮеҪўдәӨжҚўжңә

"exchange": "tasks",

"exchange_type": "fanout",

"binding_key": "tasks",

},

celery зҡ„й…ҚзҪ®йқһеёёеӨҡ пјҢ дёҚжӯўжҲ‘们дёҠйқўиҜҙзҡ„йӮЈдәӣ пјҢ жӣҙеӨҡй…ҚзҪ®еҸҜд»ҘжҹҘзңӢе®ҳзҪ‘ пјҢ еҶҷзҡ„жҜ”иҫғиҜҰз»Ҷ гҖӮ

https://docs.celeryq.dev/en/latest/userguide/configuration.html#general-settings

еҖјеҫ—дёҖжҸҗзҡ„жҳҜ пјҢ еңЁ 5.0 д№ӢеүҚй…ҚзҪ®йЎ№йғҪжҳҜеӨ§еҶҷзҡ„ пјҢ иҖҢд»Һ 5.0 ејҖе§Ӣй…ҚзҪ®йЎ№ж”№жҲҗе°ҸеҶҷдәҶ гҖӮдёҚиҝҮиҖҒзҡ„еҶҷжі•зӣ®еүҚд»Қ然ж”ҜжҢҒ пјҢ еҸӘжҳҜеҗҜеҠЁзҡ„ж—¶еҖҷдјҡжҠӣиӯҰе‘Ҡ пјҢ 并且еңЁ 6.0 зҡ„ж—¶еҖҷдёҚеҶҚе…је®№иҖҒзҡ„еҶҷжі• гҖӮ

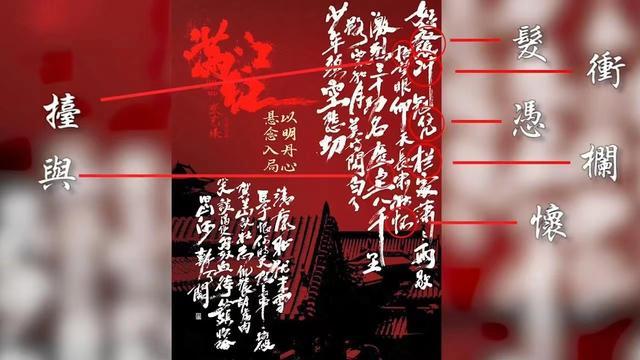

ж–Үз« жҸ’еӣҫ

е®ҳзҪ‘д№ҹеҫҲиҙҙеҝғең°е°ҶиҖҒзүҲжң¬зҡ„й…ҚзҪ®е’Ңж–°зүҲжң¬зҡ„й…ҚзҪ®зҪ—еҲ—дәҶеҮәжқҘ пјҢ е°Ҫз®Ўй…ҚзҪ®жңүеҫҲеӨҡ пјҢ дҪҶ并дёҚжҳҜжҜҸдёҖдёӘйғҪиҰҒз”Ё пјҢ еҸҜд»Ҙж №жҚ®иҮӘиә«зҡ„дёҡеҠЎеҗҲзҗҶйҖүжӢ© гҖӮ

然еҗҺдёӢйқўжҲ‘们е°ұж №жҚ®й…ҚзҪ®ж–Ү件зҡ„ж–№ејҸеҗҜеҠЁ celery пјҢ еҪ“еүҚзӣ®еҪ•з»“жһ„еҰӮдёӢпјҡ

ж–Үз« жҸ’еӣҫ

celery_demo/config.py

broker_url = "redis://:maverick@82.157.146.194:6379/1"

result_backend = "redis://:maverick@82.157.146.194:6379"

# еҶҷдҝ©е°ұе®ҢдәӢдәҶcelery_demo/tasks/task1.py

celery еҸҜд»Ҙж”ҜжҢҒйқһеёёеӨҡзҡ„е®ҡж—¶д»»еҠЎ пјҢ иҖҢдёҚеҗҢз§Қзұ»зҡ„е®ҡж—¶д»»еҠЎжҲ‘们дёҖиҲ¬йғҪдјҡеҶҷеңЁдёҚеҗҢзҡ„жЁЎеқ—дёӯпјҲеҪ“然иҝҷйҮҢзӣ®еүҚеҸӘжңүдёҖдёӘпјү пјҢ 然еҗҺеҶҚе°ҶиҝҷдәӣжЁЎеқ—з»„з»ҮеңЁдёҖдёӘеҚ•зӢ¬зҡ„зӣ®еҪ•дёӯ гҖӮ

еҪ“еүҚеҸӘжңүдёҖдёӘ task1.py пјҢ жҲ‘们йҡҸдҫҝеҫҖйҮҢйқўеҶҷзӮ№дёңиҘҝ пјҢ еҪ“然дҪ д№ҹеҸҜд»ҘеҲӣе»әжӣҙеӨҡзҡ„ж–Ү件 гҖӮ

def add(x, y):

return x + ydef sub(x, y):

return x - ydef mul(x, y):

return x * ydef div(x, y):

return x / ycelery_demo/app.py

from celery import Celery

import config

from tasks.task1 import (

add, sub, mul, div# жҢҮе®ҡдёҖдёӘ name еҚіеҸҜ

app = Celery("satori")

# е…¶е®ғеҸӮж•°йҖҡиҝҮеҠ иҪҪй…ҚзҪ®ж–Ү件зҡ„ж–№ејҸжҢҮе®ҡ

# е’Ң flask йқһеёёзұ»дјј

app.config_from_object(config)# еҲӣе»әд»»еҠЎе·ҘеҺӮ пјҢ жңүдәҶд»»еҠЎе·ҘеҺӮжүҚиғҪеҲӣе»әд»»еҠЎ

# иҝҷз§Қж–№ејҸе’ҢиЈ…йҘ°еҷЁзҡ„ж–№ејҸжҳҜзӯүд»·зҡ„

add = app.task(add)

sub = app.task(sub)

mul = app.task(mul)

div = app.task(div)然еҗҺйҮҚж–°еҗҜеҠЁ workerпјҡ

ж–Үз« жҸ’еӣҫ

иҫ“еҮәз»“жһңжҳҫзӨә пјҢ д»»еҠЎе·ҘеҺӮйғҪе·Із»Ҹиў«еҠ иҪҪиҝӣжқҘдәҶ пјҢ 然еҗҺжҲ‘们еҲӣе»әд»»еҠЎе№¶еҸ‘йҖҒиҮійҳҹеҲ— гҖӮ

# еңЁ celery_demo зӣ®еҪ•дёӢ

# е°Ҷ app.py йҮҢйқўзҡ„д»»еҠЎе·ҘеҺӮеҜје…ҘиҝӣжқҘ

>>> from app import add, sub, mul, div

# 然еҗҺеҲӣе»әд»»еҠЎеҸ‘йҖҒиҮійҳҹеҲ— пјҢ 并зӯүеҫ…з»“жһң

>>> add.delay(3, 4).get()

7

>>> sub.delay(3, 4).get()

-1

>>> mul.delay(3, 4).get()

12

>>> div.delay(3, 4).get()

0.75з»“жһңжӯЈеёёиҝ”еӣһдәҶ пјҢ еҶҚжқҘзңӢзңӢ worker зҡ„иҫ“еҮә пјҢ

ж–Үз« жҸ’еӣҫ

еӨҡдёӘд»»еҠЎйғҪиў«жү§иЎҢдәҶ гҖӮ

еҸ‘йҖҒд»»еҠЎж—¶жҢҮе®ҡеҸӮж•°

жҲ‘们еңЁеҸ‘йҖҒд»»еҠЎеҲ°йҳҹеҲ—зҡ„ж—¶еҖҷ пјҢ дҪҝз”Ёзҡ„жҳҜ delay ж–№жі• пјҢ йҮҢйқўзӣҙжҺҘдј йҖ’еҮҪж•°жүҖйңҖзҡ„еҸӮж•°еҚіеҸҜ пјҢ йӮЈд№ҲйҷӨдәҶеҮҪж•°йңҖиҰҒзҡ„еҸӮж•°д№ӢеӨ– пјҢ иҝҳжңүжІЎжңүе…¶е®ғеҸӮж•°е‘ўпјҹ

йҰ–е…Ҳ delay ж–№жі•е®һйҷ…дёҠжҳҜи°ғз”Ёзҡ„ apply_async ж–№жі• пјҢ 并且 delay ж–№жі•йҮҢйқўеҸӘжҺҘ收еҮҪж•°зҡ„еҸӮж•° пјҢ дҪҶжҳҜ apply_async жҺҘ收зҡ„еҸӮж•°е°ұеҫҲеӨҡдәҶ пјҢ жҲ‘们е…ҲжқҘзңӢзңӢе®ғ们зҡ„еҮҪж•°еҺҹеһӢпјҡ

жҺЁиҚҗйҳ…иҜ»

- йҫҷд№Ӣ家ж—Ҹ|гҖҠйҫҷд№Ӣ家ж—ҸгҖӢиҝҷ1з»ҶиҠӮпјҢжҡ—зӨәдәҶдё№еҰ®иҺүдёқпјҢжүҚжҳҜжңҖдјҹеӨ§зҡ„еқҰж јеҲ©е®үпјҹ

- е°Ҹзұі|37еІҒиҙўеҜҢиҮӘз”ұпјҒйӣ·еҶӣжҺҘеҸ—еӨ®и§ҶйҮҮи®ҝпјҡжҲ‘иҰҒжҲҗдјҹеӨ§зҡ„дәә е°ҸзұіиҰҒеҪұе“Қдё–з•ҢгҖҒйҖ иҪҰжҳҜиў«йҖјзҡ„

- дёӯеӣҪжңҖеӨ§зҡ„еІӣеұҝжҳҜж—Ҙжң¬еІӣ дёӯеӣҪжңҖеӨ§зҡ„еІӣеұҝжҳҜд»Җд№ҲеІӣ-еј йӣӘеі°

- зӣӣжҳҺе…°|йҮҚжё©гҖҠзҹҘеҗҰгҖӢпјҢзҺӢиҖҒеӨӘеёҲдёҖз”ҹжңҖеӨ§зҡ„иҙҘ笔пјҢе°ұжҳҜеЁ¶дәҶеҒҸеҝғзҡ„зҺӢиҖҒеӨӘеӨӘ

- йҹ©еү§|гҖҠеҪ“дҪ жІүзқЎж—¶гҖӢпјҡеҪ“еҷ©жўҰз…§иҝӣзҺ°е®һпјҢж•‘иөҺе’ҢдҝЎд»»жүҚжҳҜжңҖејәзҡ„йҷӘдјҙ

- иөөй№Ҹзҝ”|вҖңжқҺжҳ“еі°вҖқдәӢ件жңҖеӨ§зҡ„еҸ—зӣҠиҖ…жҳҜи°Ғпјҹ

- зҪҡзҪӘ|гҖҠзҪҡзҪӘгҖӢпјҡеӨ§зҺӢзҺ°иә«пјҢжҳҜе…Ёеү§жңҖеӨ§зҡ„еҸҚиҪ¬еҗ—пјҢзҪ‘еҸӢпјҡдёҚжҳҜзҡ„

- |иғҪеҠӣпјҢи®©дёҖдёӘдәәиҝ…йҖҹи„ұйў–иҖҢеҮәпјҢеҰӮдҪ•еҸ‘жҢҘеҮәдҪ зҡ„жңҖејәжҠҖиғҪпјҹ

- еҚҺдёә|е–·й—®з•ҢM7дёҚеҘҪзңӢзҡ„дәәе“ҒдҪҚжҜ”иҫғLowпјҒдҪҷжүҝдёңпјҡеҚҺдёәеҒҡдјҹеӨ§зҡ„и®ҫи®Ў

- жңҖеӨ§зҡ„жҒҗйҫҷжңүеӨҡеӨ§ жңҖеӨ§зҡ„жҒҗйҫҷжҺ’иЎҢжҰңеүҚеҚҒеҗҚ