дёҖгҖҒMapReduceжҰӮиҝ°1гҖҒеҹәжң¬жҰӮеҝөHadoopж ёеҝғ组件д№ӢдёҖпјҡеҲҶеёғејҸи®Ўз®—зҡ„ж–№жЎҲMapReduce пјҢ жҳҜдёҖз§Қзј–зЁӢжЁЎеһӢ пјҢ з”ЁдәҺеӨ§и§„жЁЎж•°жҚ®йӣҶзҡ„并иЎҢиҝҗз®— пјҢ е…¶дёӯMapпјҲжҳ е°„пјүе’ҢReduceпјҲеҪ’зәҰпјү гҖӮ

MapReduceж—ўжҳҜдёҖдёӘзј–зЁӢжЁЎеһӢ пјҢ д№ҹжҳҜдёҖдёӘ计算组件 пјҢ еӨ„зҗҶзҡ„иҝҮзЁӢеҲҶдёәдёӨдёӘйҳ¶ж®ө пјҢ Mapйҳ¶ж®өпјҡиҙҹиҙЈжҠҠд»»еҠЎеҲҶи§ЈдёәеӨҡдёӘе°Ҹд»»еҠЎ пјҢ ReduceиҙҹиҙЈжҠҠеӨҡдёӘе°Ҹд»»еҠЎзҡ„еӨ„зҗҶз»“жһңиҝӣиЎҢжұҮжҖ» гҖӮе…¶дёӯMapйҳ¶ж®өдё»иҰҒиҫ“е…ҘжҳҜдёҖеҜ№Key-Value пјҢ з»ҸиҝҮmapи®Ўз®—еҗҺиҫ“еҮәдёҖеҜ№Key-ValueеҖјпјӣ然еҗҺе°ҶзӣёеҗҢKeyеҗҲ并 пјҢ еҪўжҲҗKey-ValueйӣҶеҗҲпјӣеҶҚе°ҶиҝҷдёӘKey-ValueйӣҶеҗҲиҪ¬е…ҘReduceйҳ¶ж®ө пјҢ з»ҸиҝҮи®Ўз®—иҫ“еҮәжңҖз»ҲKey-Valueз»“жһңйӣҶ гҖӮ

2гҖҒзү№зӮ№жҸҸиҝ°MapReduceеҸҜд»Ҙе®һзҺ°еҹәдәҺдёҠеҚғеҸ°жңҚеҠЎеҷЁе№¶еҸ‘е·ҘдҪң пјҢ жҸҗдҫӣеҫҲејәеӨ§зҡ„ж•°жҚ®еӨ„зҗҶиғҪеҠӣ пјҢ еҰӮжһңе…¶дёӯеҚ•еҸ°жңҚеҠЎжҢӮжҺү пјҢ и®Ўз®—д»»еҠЎдјҡиҮӘеҠЁиҪ¬д№үеҲ°еҸҰеӨ–иҠӮзӮ№жү§иЎҢ пјҢ дҝқиҜҒй«ҳе®№й”ҷжҖ§пјӣдҪҶжҳҜMapReduceдёҚйҖӮеә”дәҺе®һж—¶и®Ўз®—дёҺжөҒејҸи®Ўз®— пјҢ и®Ўз®—зҡ„ж•°жҚ®жҳҜйқҷжҖҒзҡ„ гҖӮ

дәҢгҖҒж“ҚдҪңжЎҲдҫӢ1гҖҒжөҒзЁӢжҸҸиҝ°

ж–Үз« жҸ’еӣҫ

ж•°жҚ®ж–Ү件дёҖиҲ¬д»ҘCSVж јејҸеұ…еӨҡ пјҢ ж•°жҚ®иЎҢйҖҡеёёд»Ҙз©әж јеҲҶйҡ” пјҢ иҝҷйҮҢйңҖиҰҒиҖғиҷ‘ж•°жҚ®еҶ…е®№зү№зӮ№пјӣ

ж–Ү件з»ҸиҝҮеҲҮзүҮеҲҶй…ҚеңЁдёҚеҗҢзҡ„MapTaskд»»еҠЎдёӯ并еҸ‘жү§иЎҢпјӣ

MapTaskд»»еҠЎжү§иЎҢе®ҢжҜ•д№ӢеҗҺ пјҢ жү§иЎҢReduceTaskд»»еҠЎ пјҢ дҫқиө–Mapйҳ¶ж®өзҡ„ж•°жҚ®пјӣ

ReduceTaskд»»еҠЎжү§иЎҢе®ҢжҜ•еҗҺ пјҢ иҫ“еҮәж–Ү件结жһң гҖӮ

2гҖҒеҹәзЎҖй…ҚзҪ®

hadoop:# иҜ»еҸ–зҡ„ж–Ү件жәҗinputPath: hdfs://hop01:9000/hopdir/JAVANew.txt# иҜҘи·Ҝеҫ„еҝ…йЎ»жҳҜзЁӢеәҸиҝҗиЎҢеүҚдёҚеӯҳеңЁзҡ„outputPath: /wordOut3гҖҒMApperзЁӢеәҸpublic class WordMapper extends Mapper<LongWritable, Text, Text, IntWritable> {Text mapKey = new Text();IntWritable mapValue = https://www.isolves.com/it/cxkf/kj/2020-11-23/new IntWritable(1);@Overrideprotected void map (LongWritable key, Text value, Context context)throws IOException, InterruptedException {// 1гҖҒиҜ»еҸ–иЎҢString line = value.toString();// 2гҖҒиЎҢеҶ…е®№еҲҮеүІ пјҢ ж №жҚ®ж–Ү件дёӯеҲҶйҡ”з¬ҰString[] words = line.split(" ");// 3гҖҒеӯҳеӮЁfor (String word : words) {mapKey.set(word);context.write(mapKey, mapValue);}}}4гҖҒReducerзЁӢеәҸpublic class WordReducer extends Reducer<Text, IntWritable, Text, IntWritable> {int sum ;IntWritable value = https://www.isolves.com/it/cxkf/kj/2020-11-23/new IntWritable();@Overrideprotected void reduce(Text key, Iterable values,Context context)throws IOException, InterruptedException {// 1гҖҒзҙҜеҠ жұӮе’Ңз»ҹи®Ўsum = 0;for (IntWritable count : values) {sum += count.get();}// 2гҖҒиҫ“еҮәз»“жһңvalue.set(sum);context.write(key,value);}} 5гҖҒжү§иЎҢзЁӢеәҸ@RestControllerpublic class WordWeb {@Resourceprivate MapReduceConfig mapReduceConfig ;@GetMapping("/getWord")public String getWord () throws IOException, ClassNotFoundException, InterruptedException {// еЈ°жҳҺй…ҚзҪ®Configuration hadoopConfig = new Configuration();hadoopConfig.set("fs.hdfs.impl",org.Apache.hadoop.hdfs.DistributedFileSystem.class.getName());hadoopConfig.set("fs.file.impl",org.apache.hadoop.fs.LocalFileSystem.class.getName());Job job = Job.getInstance(hadoopConfig);// Jobжү§иЎҢдҪңдёҡ иҫ“е…Ҙи·Ҝеҫ„FileInputFormat.addInputPath(job, new Path(mapReduceConfig.getInputPath()));// Jobжү§иЎҢдҪңдёҡ иҫ“еҮәи·Ҝеҫ„FileOutputFormat.setOutputPath(job, new Path(mapReduceConfig.getOutputPath()));// иҮӘе®ҡд№ү Mapperе’ҢReducer дёӨдёӘйҳ¶ж®өзҡ„д»»еҠЎеӨ„зҗҶзұ»job.setMapperClass(WordMapper.class);job.setReducerClass(WordReducer.class);// и®ҫзҪ®иҫ“еҮәз»“жһңзҡ„Keyе’ҢValueзҡ„зұ»еһӢjob.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);//жү§иЎҢJobзӣҙеҲ°е®ҢжҲҗjob.waitForCompletion(true);return "success" ;}}6гҖҒжү§иЎҢз»“жһңжҹҘзңӢе°Ҷеә”з”ЁзЁӢеәҸжү“еҢ…ж”ҫеҲ°hop01жңҚеҠЎдёҠжү§иЎҢпјӣjava -jar map-reduce-case01.jar

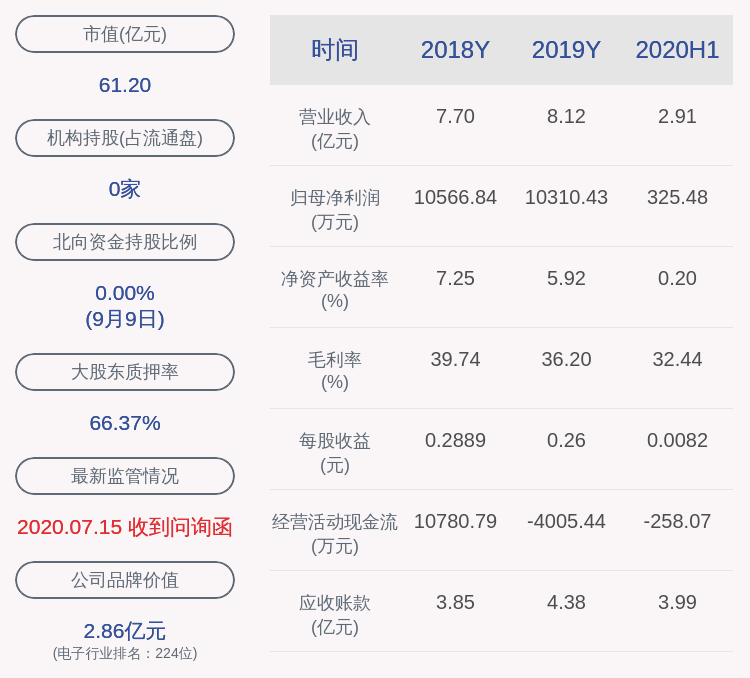

ж–Үз« жҸ’еӣҫ

дёүгҖҒжЎҲдҫӢеҲҶжһҗ1гҖҒж•°жҚ®зұ»еһӢJavaж•°жҚ®зұ»еһӢдёҺеҜ№еә”зҡ„Hadoopж•°жҚ®еәҸеҲ—еҢ–зұ»еһӢпјӣ

ж–Үз« жҸ’еӣҫ

2гҖҒж ёеҝғжЁЎеқ—MapperжЁЎеқ—пјҡеӨ„зҗҶиҫ“е…Ҙзҡ„ж•°жҚ® пјҢ дёҡеҠЎйҖ»иҫ‘еңЁmap()ж–№жі•дёӯе®ҢжҲҗ пјҢ иҫ“еҮәзҡ„ж•°жҚ®д№ҹжҳҜKVж јејҸпјӣ

ReducerжЁЎеқ—пјҡеӨ„зҗҶMapзЁӢеәҸиҫ“еҮәзҡ„KVж•°жҚ® пјҢ дёҡеҠЎйҖ»иҫ‘еңЁreduce()ж–№жі•дёӯпјӣ

DriverжЁЎеқ—пјҡе°ҶзЁӢеәҸжҸҗдәӨеҲ°yarnиҝӣиЎҢи°ғеәҰ пјҢ жҸҗдәӨе°ҒиЈ…дәҶиҝҗиЎҢеҸӮж•°зҡ„jobеҜ№иұЎпјӣ

еӣӣгҖҒеәҸеҲ—еҢ–ж“ҚдҪң1гҖҒеәҸеҲ—еҢ–з®Җд»ӢеәҸеҲ—еҢ–пјҡе°ҶеҶ…еӯҳдёӯеҜ№иұЎиҪ¬жҚўдёәдәҢиҝӣеҲ¶зҡ„еӯ—иҠӮеәҸеҲ— пјҢ еҸҜд»ҘйҖҡиҝҮиҫ“еҮәжөҒжҢҒд№…еҢ–еӯҳеӮЁжҲ–иҖ…зҪ‘з»ңдј иҫ“пјӣ

еҸҚеәҸеҲ—еҢ–пјҡжҺҘ收иҫ“е…Ҙеӯ—иҠӮжөҒжҲ–иҖ…иҜ»еҸ–зЈҒзӣҳжҢҒд№…еҢ–зҡ„ж•°жҚ® пјҢ еҠ иҪҪеҲ°еҶ…еӯҳзҡ„еҜ№иұЎиҝҮзЁӢпјӣ

жҺЁиҚҗйҳ…иҜ»

- ејҖеҸ‘жЎҶжһ¶жҗӯе»әиҖғйҮҸ

- AppејҖеҸ‘д№Ӣе®ўжҲ·з«ҜжЎҶжһ¶жҗӯе»ә

- дёҖд»Јж·ұеәҰеӯҰд№ жЎҶжһ¶з ”究

- д»Һйӣ¶ејҖе§ӢеӯҰASP.NET Core IdentityжЎҶжһ¶

- APIж•ҸжҚ·ејҖеҸ‘жЎҶжһ¶

- EggжңҚеҠЎеҷЁеҹәзЎҖеҠҹиғҪ

- еҰӮдҪ•дјҳйӣ…ең°дҪҝз”ЁhttprunnerжөӢиҜ•жЎҶжһ¶иҝӣиЎҢжҺҘеҸЈжөӢиҜ•пјҹ收и—Ҹ

- е“ӘдёӘжЎҶжһ¶жӣҙеҘҪпјҡAngular,React,Vue

- еӨ§дҪ¬жҠҠSpringжЎҶжһ¶жҖ»з»“зҡ„гҖҢж— жҜ”иҜҰз»ҶгҖҚпјҢзңӢе®ҢиҝҳиҜҙдёҚжҮӮеҲ«еӯҰдәҶ

- ThinkPHPжЎҶжһ¶вҖ”вҖ”е®һзҺ°е®ҡж—¶д»»еҠЎпјҢе®ҡж—¶жӣҙж–°гҖҒжё…зҗҶж•°жҚ®