жңәеҷЁеӯҰд№ еҹәзЎҖ,дәҶи§Јж··ж·Ҷзҹ©йҳөзҡ„жүҖжңүж–№йқў

еңЁжң¬ж–Үдёӯ пјҢ жҲ‘们е°ҶйҮҚзӮ№дәҶи§Јж··ж·Ҷзҹ©йҳөе’ҢдҪҝз”Ёж··ж·Ҷзҹ©йҳөпјҲIзұ»й”ҷиҜҜ пјҢ IIзұ»й”ҷиҜҜе’ҢеҮҶзЎ®еәҰпјүи®Ўз®—зҡ„жҢҮж Ү гҖӮеңЁеҲҶзұ»з®—жі•зҡ„жғ…еҶөдёӢдҪҝз”ЁжӯӨж–№жі•жқҘзЎ®е®ҡ/иҜ„дј°жЁЎеһӢзҡ„жҖ§иғҪ гҖӮ

ж–Үз« жҸ’еӣҫ

жҲ‘们д»Һе»әз«Ӣж•°жҚ®йӣҶејҖе§Ӣ пјҢ еҗҢж—¶е»әз«Ӣд»»дҪ•з»ҹи®ЎжҲ–MLжЁЎеһӢ гҖӮе°ҶиҜҘж•°жҚ®йӣҶеҲҶдёәдёӨйғЁеҲҶпјҡеҹ№и®ӯе’ҢжөӢиҜ• гҖӮдҝқз•ҷжөӢиҜ•ж•°жҚ®йӣҶ пјҢ 并дҪҝз”Ёи®ӯз»ғж•°жҚ®йӣҶи®ӯз»ғжЁЎеһӢ гҖӮдёҖж—ҰжЁЎеһӢеҮҶеӨҮеҘҪиҝӣиЎҢйў„жөӢ пјҢ жҲ‘们е°ұе°қиҜ•еҜ№жөӢиҜ•ж•°жҚ®йӣҶиҝӣиЎҢйў„жөӢ гҖӮдёҖж—Ұе°Ҷз»“жһңеҲҶеүІжҲҗзұ»дјјдәҺдёҠеӣҫжүҖзӨәзҡ„зҹ©йҳө пјҢ е°ұеҸҜд»ҘзңӢеҲ°жҲ‘们зҡ„жЁЎеһӢиғҪеӨҹйў„жөӢжӯЈзЎ®зҡ„ж•°йҮҸд»ҘеҸҠе…¶йў„жөӢй”ҷиҜҜзҡ„ж•°йҮҸ гҖӮ

ж–Үз« жҸ’еӣҫ

жҲ‘们дҪҝз”ЁжөӢиҜ•ж•°жҚ®йӣҶдёӯзҡ„ж•°еӯ—еЎ«е……дёҠеӣҫдёӯжүҖзӨәзҡ„4дёӘеҚ•е…ғж јпјҲдҫӢеҰӮ пјҢ е…·жңү1000дёӘи§ӮеҜҹеҖјпјү гҖӮ

· TPпјҲзңҹйҳіжҖ§пјүпјҡеңЁжөӢиҜ•ж•°жҚ®йӣҶдёӯиҜҘеҲ—зҡ„е®һйҷ…ж Үзӯҫдёә"жҳҜ" пјҢ иҖҢжҲ‘们зҡ„йҖ»иҫ‘еӣһеҪ’жЁЎеһӢд№ҹйў„жөӢдёә"жҳҜ" гҖӮпјҲ500и§ӮеҜҹпјү

· TNпјҲзңҹйҳҙжҖ§пјүпјҡеңЁжөӢиҜ•ж•°жҚ®йӣҶдёӯиҜҘеҲ—зҡ„е®һйҷ…ж Үзӯҫдёә"еҗҰ" пјҢ иҖҢжҲ‘们зҡ„йҖ»иҫ‘еӣһеҪ’жЁЎеһӢд№ҹйў„жөӢдёә"еҗҰ" гҖӮпјҲ200и§ӮеҜҹпјү

· FPпјҲеҒҮйҳіжҖ§пјүпјҡеңЁжөӢиҜ•ж•°жҚ®йӣҶдёӯиҜҘеҲ—зҡ„е®һйҷ…ж Үзӯҫдёә"еҗҰ" пјҢ дҪҶжҲ‘们зҡ„йҖ»иҫ‘еӣһеҪ’жЁЎеһӢйў„жөӢдёә"жҳҜ" гҖӮпјҲ100и§ӮеҜҹпјү

· FNпјҲеҒҮйҳҙжҖ§пјүпјҡеңЁжөӢиҜ•ж•°жҚ®йӣҶдёӯиҜҘеҲ—зҡ„е®һйҷ…ж Үзӯҫдёә"жҳҜ" пјҢ дҪҶжҲ‘们зҡ„йҖ»иҫ‘еӣһеҪ’жЁЎеһӢйў„жөӢдёә"еҗҰ" гҖӮпјҲ200и§ӮеҜҹпјү

иҝҷ4дёӘеҚ•е…ғж јжһ„жҲҗдәҶ"ж··ж·Ҷзҹ©йҳө" пјҢ е°ұеғҸзҹ©йҳөдёҖж · пјҢ е®ғеҸҜд»ҘйҖҡиҝҮжё…жҷ°ең°жҸҸз»ҳжЁЎеһӢзҡ„йў„жөӢиғҪеҠӣжқҘеҮҸиҪ»еҜ№жЁЎеһӢдјҳеҠЈзҡ„жүҖжңүж··ж·Ҷ гҖӮ

ж··ж·Ҷзҹ©йҳөжҳҜдёҖдёӘиЎЁ пјҢ йҖҡеёёз”ЁдәҺжҸҸиҝ°еҲҶзұ»жЁЎеһӢпјҲжҲ–"еҲҶзұ»еҷЁ"пјүеҜ№дёҖз»„е·ІзҹҘзңҹе®һеҖјзҡ„жөӢиҜ•ж•°жҚ®зҡ„жҖ§иғҪ гҖӮ

е…ідәҺж··ж·Ҷзҹ©йҳөеҸҜд»ҘзҗҶи§Јзҡ„е…¶д»–жҢҮж Үзұ»еһӢIй”ҷиҜҜ

ж–Үз« жҸ’еӣҫ

зұ»еһӢ1й”ҷиҜҜд№ҹз§°дёәиҜҜжҠҘ пјҢ еҪ“еҲҶзұ»жЁЎеһӢй”ҷиҜҜең°дёәжңҖеҲқзҡ„й”ҷиҜҜи§ӮеҜҹз»“жһңйў„жөӢзңҹе®һз»“жһңж—¶еҸ‘з”ҹ гҖӮ

дҫӢеҰӮпјҡеҒҮи®ҫжҲ‘们зҡ„зү©жөҒжЁЎеһӢжӯЈеңЁеӨ„зҗҶеһғеңҫйӮ®д»¶иҖҢйқһеһғеңҫйӮ®д»¶з”өеӯҗйӮ®д»¶з”ЁдҫӢ гҖӮеҰӮжһңжҲ‘们зҡ„жЁЎеһӢе°ҶеҺҹжң¬еҫҲйҮҚиҰҒзҡ„з”өеӯҗйӮ®д»¶ж Үи®°дёәеһғеңҫйӮ®д»¶ пјҢ йӮЈд№Ҳиҝҷе°ұжҳҜжҲ‘们зҡ„жЁЎеһӢIеһӢй”ҷиҜҜзҡ„зӨәдҫӢ гҖӮеңЁиҝҷдёӘзү№ж®Ҡзҡ„й—®йўҳйҷҲиҝ°дёӯ пјҢ жҲ‘们еҫҲж•Ҹж„ҹең°е°ҪеҸҜиғҪең°еҮҸе°‘Type Iй”ҷиҜҜ пјҢ еӣ дёәиҝӣе…ҘеһғеңҫйӮ®д»¶зҡ„йҮҚиҰҒз”өеӯҗйӮ®д»¶еҸҜиғҪдјҡйҖ жҲҗдёҘйҮҚеҗҺжһң гҖӮ

3. IIеһӢй”ҷиҜҜ

ж–Үз« жҸ’еӣҫ

IIеһӢй”ҷиҜҜд№ҹз§°дёәеҒҮйҳҙжҖ§ пјҢ еҪ“еҲҶзұ»жЁЎеһӢй”ҷиҜҜең°дёәеҺҹе§Ӣзңҹе®һи§ӮеҜҹз»“жһңйў„жөӢй”ҷиҜҜз»“жһңж—¶ пјҢ е°ұдјҡеҸ‘з”ҹIIеһӢй”ҷиҜҜ гҖӮ

дҫӢеҰӮпјҡеҒҮи®ҫжҲ‘们зҡ„йҖ»иҫ‘жЁЎеһӢжӯЈеңЁеӨ„зҗҶдёҖдёӘз”ЁдҫӢ пјҢ е®ғеҝ…йЎ»йў„жөӢдёҖдёӘдәәжҳҜеҗҰжӮЈжңүзҷҢз—Ү гҖӮеҰӮжһңжҲ‘们зҡ„жЁЎеһӢе°ҶжӮЈжңүзҷҢз—Үзҡ„дәәж Үи®°дёәеҒҘеә·дәә并е°Ҷе…¶еҲҶзұ»й”ҷиҜҜ пјҢ еҲҷиҝҷе°ұжҳҜжҲ‘们зҡ„жЁЎеһӢеҸ‘з”ҹзҡ„IIеһӢй”ҷиҜҜзҡ„дҫӢеӯҗ гҖӮеңЁиҝҷдёӘзү№ж®Ҡзҡ„й—®йўҳйҷҲиҝ°дёӯ пјҢ жҲ‘们еҜ№е°ҪеҸҜиғҪеҮҸе°‘IIеһӢй”ҷиҜҜйқһеёёж•Ҹж„ҹ пјҢ еӣ дёәеңЁиҝҷз§Қжғ…еҶөдёӢ пјҢ еҰӮжһңеҒҮйҳҙжҖ§з»§з»ӯеҪұе“ҚжӮЈиҖ… пјҢ еҲҷеҒҮйҳҙжҖ§еҸҜиғҪеҜјиҮҙжӯ»дәЎ гҖӮ

4.еҮҶзЎ®жҖ§зҺ°еңЁ пјҢ д»ҘдёҠи®Ёи®әзҡ„дёүдёӘжҢҮж ҮйғҪжҳҜйҖҡз”ЁжҢҮж Ү пјҢ дёҺжӮЁжӢҘжңүзҡ„еҹ№и®ӯе’ҢжөӢиҜ•ж•°жҚ®зҡ„з§Қзұ»д»ҘеҸҠдёәй—®йўҳйҷҲиҝ°жүҖйғЁзҪІзҡ„еҲҶзұ»з®—жі•зҡ„з§Қзұ»ж— е…і гҖӮ

жҲ‘们зҺ°еңЁжӯЈзқҖжүӢи®Ёи®әйқһеёёйҖӮеҗҲзү№е®ҡзұ»еһӢж•°жҚ®зҡ„жҢҮж Ү гҖӮ

и®©жҲ‘们д»ҺиҝҷйҮҢејҖе§Ӣи°Ҳи®әеҮҶзЎ®жҖ§ пјҢ иҝҷжҳҜжңҖйҖӮеҗҲе№іиЎЎж•°жҚ®йӣҶзҡ„жҢҮж Ү гҖӮиҜ·еҸӮиҖғдёӢеӣҫ пјҢ иҜҘеӣҫжәҗдәҺжң¬ж–Ү гҖӮ

ж–Үз« жҸ’еӣҫ

> Source: Link

еҰӮжӮЁжүҖи§Ғ пјҢ е№іиЎЎж•°жҚ®йӣҶжҳҜдёҖдёӘз”ұи®ӯз»ғж•°жҚ®е№іеқҮд»ЈиЎЁ1е’Ң0 пјҢ жҳҜе’ҢеҗҰ пјҢ жӯЈиҙҹзҡ„ж•°жҚ®йӣҶ гҖӮеҸҰдёҖж–№йқў пјҢ еҰӮжһңдёӨдёӘзұ»еҲ«ж Үзӯҫзҡ„жҜ”зҺҮеҮәзҺ°еҒҸе·® пјҢ еҲҷжҲ‘们зҡ„жЁЎеһӢе°ҶеҒҸеҗ‘дёҖдёӘзұ»еҲ« гҖӮ

еҒҮи®ҫжҲ‘们жңүдёҖдёӘе№іиЎЎзҡ„ж•°жҚ®йӣҶ пјҢ и®©жҲ‘们еӯҰд№ д»Җд№ҲжҳҜеҮҶзЎ®жҖ§ гҖӮ

ж–Үз« жҸ’еӣҫ

зІҫеәҰжҳҜжөӢйҮҸз»“жһңдёҺзңҹе®һеҖјзҡ„жҺҘиҝ‘зЁӢеәҰ гҖӮе®ғе‘ҠиҜүжҲ‘们еҲҶзұ»жЁЎеһӢиғҪеӨҹеӨҡд№ҲеҮҶзЎ®ең°йў„жөӢй—®йўҳйҷҲиҝ°дёӯз»ҷеҮәзҡ„зұ»еҲ«ж Үзӯҫ гҖӮ

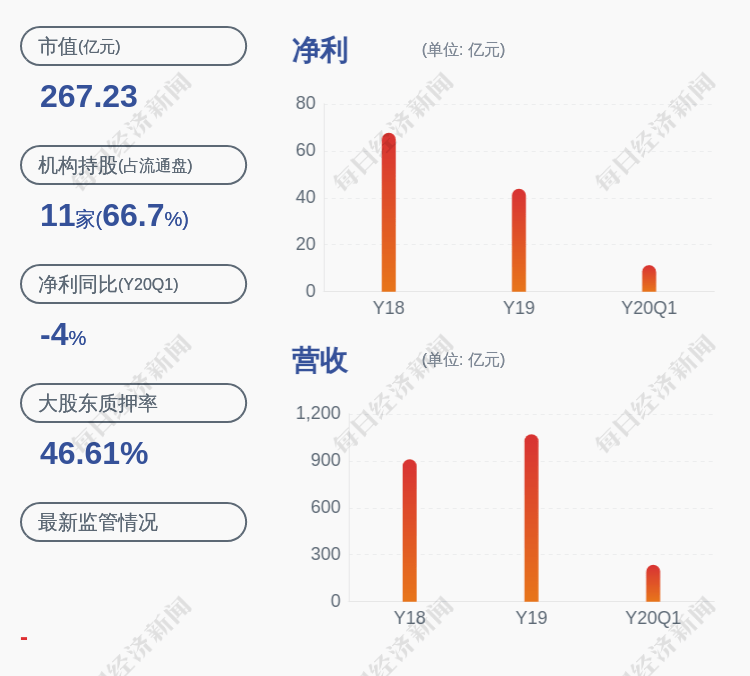

дҫӢеҰӮпјҡеҒҮи®ҫжҲ‘们зҡ„еҲҶзұ»жЁЎеһӢжӯЈеңЁе°қиҜ•йў„жөӢе®ўжҲ·жөҒеӨұжғ…еҶө гҖӮеңЁдёҠеӣҫдёӯ пјҢ еңЁжҖ»е…ұ700дёӘе®һйҷ…жҚҹиҖ—зҡ„е®ўжҲ·пјҲTP + FNпјүдёӯ пјҢ иҜҘжЁЎеһӢжӯЈзЎ®ең°иғҪеӨҹжӯЈзЎ®еҲҶзұ»500дёӘжҚҹиҖ—зҡ„е®ўжҲ·пјҲTPпјү гҖӮеҗҢж · пјҢ еңЁ300дёӘдҝқз•ҷе®ўжҲ·пјҲFP + TNпјүдёӯ пјҢ иҜҘжЁЎеһӢжӯЈзЎ®ең°иғҪеӨҹжӯЈзЎ®еҲҶзұ»200дёӘдҝқз•ҷе®ўжҲ·пјҲTNпјү гҖӮ

жҺЁиҚҗйҳ…иҜ»

- зҙ йЈҹиҖ…еҚҒеӯ—еҸЈиҜҖ и®©дҪ дёҚеҶҚжӢ…еҝғиҗҘе…»дёҚеӨҹ

- иҮӘеҲ¶зҘӣж№ҝиҢ¶пјҢжҜҸеӨ©е–қжҜҸеӨ©е…»пјҢж№ҝж°”дёҚеҶҚжқҘпјҒ

- зүҷз–јжҖҺд№ҲеҠһ 9ж¬ҫйЈҹз–—и®©зүҷз–јдёҚеҶҚжқҘ

- и…°з–јеҗғд»Җд№ҲеҘҪ е…«ж¬ҫиҚҜиҶійЈҹз–—ж–№и®©дҪ дёҚеҶҚи…°з–ј

- дҪ зҹҘйҒ“еҗ—пјҹJSд»Јз Ғж··ж·ҶеҠ еҜҶпјҢеҫҲжңүз”Ё

- жҺЁзү№|з§ҒжңүеҢ–жіЎжұӨпјҹ 马ж–Ҝе…Ӣе·ІдёҚеҶҚжҳҜжҺЁзү№жңҖеӨ§иӮЎдёң

- еҰӮдҪ•дёҚеӨұзӨјиҠӮең°жӢ’з»қд»–дәәзҡ„дёҚеҪ“иҜ·жұӮпјҹзүўи®°3зӮ№пјҢж—ҘеҗҺдёҚеҶҚеҸ—еҲ¶дәҺдәә

- ж•°жҚ®еҰӮдҪ•еңЁзҪ‘з»ңдёҠдј иҫ“пјҹжҺҢжҸЎиҝҷдәӣе°ҸзҹҘиҜҶпјҢзј–зЁӢе°ҶдёҚеҶҚе‘Ҷжқҝж— и¶Ј

- дёӨж¬ҫе®үзҘһиҢ¶йҘ® е…ҘзқЎдёҚеҶҚжҳҜйҡҫйўҳ

- 家йҮҢжҖ»иў«жҪ®ж№ҝеӣ°жү°пјҹеӯҰдјҡ4дёӘеӨ„зҗҶж–№жі•пјҢи®©дҪ дёҚеҶҚиў«жҪ®ж№ҝйҳҙеҶ·жҠҳзЈЁ

![[зҺӢ瑶]иЈҒеҶідәҶпјҒзү№жң—жҷ®ж”ҝеәңиҝқжі•](http://dayu-img.uc.cn/columbus/img/oc/1002/2f44f7485846122ee8150e78bee9aefa.jpg)