еҰӮгҖҠеҗҢж ·жҳҜй«ҳ并еҸ‘пјҢQQ/еҫ®еҚҡ/12306зҡ„жһ¶жһ„йҡҫеәҰдёҖж ·еҗ—пјҹгҖӢдёҖж–ҮжүҖиҝ°пјҢеҗҢж ·жҳҜй«ҳ并еҸ‘еңәжҷҜпјҢдёүзұ»дёҡеҠЎзҡ„жһ¶жһ„жҢ‘жҲҳдёҚдёҖж ·пјҡ

- QQзұ»дёҡеҠЎпјҢз”ЁжҲ·дё»иҰҒиҜ»еҶҷиҮӘе·ұзҡ„ж•°жҚ®пјҢи®ҝй—®еҹәжң¬еёҰжңүuidеұһжҖ§пјҢж•°жҚ®и®ҝй—®й”ҒеҶІзӘҒиҫғе°Ҹ

- еҫ®еҚҡзұ»дёҡеҠЎпјҢз”ЁжҲ·зҡ„feedдё»йЎөз”ұеҲ«дәәеҸ‘еёғзҡ„ж¶ҲжҒҜжһ„жҲҗпјҢж•°жҚ®иҜ»еҶҷжңүдёҖе®ҡй”ҒеҶІзӘҒ

- 12306зұ»дёҡеҠЎпјҢ并еҸ‘йҮҸеҫҲй«ҳпјҢеҮ д№ҺжүҖжңүзҡ„иҜ»еҶҷй”ҒеҶІзӘҒйғҪйӣҶдёӯеңЁе°‘йҮҸж•°жҚ®дёҠпјҢйҡҫеәҰжңҖеӨ§

зі»з»ҹеұӮйқўпјҢз§’жқҖдёҡеҠЎзҡ„дјҳеҢ–ж–№еҗ‘еҰӮдҪ•пјҹ

дё»иҰҒжңүдёӨйЎ№пјҡ

пјҲ1пјүе°ҶиҜ·жұӮе°ҪйҮҸжӢҰжҲӘеңЁзі»з»ҹдёҠжёёпјҢиҖҢдёҚиҰҒи®©й”ҒеҶІзӘҒиҗҪеҲ°ж•°жҚ®еә“ гҖӮ

дј з»ҹз§’жқҖзі»з»ҹд№ӢжүҖд»ҘжҢӮпјҢжҳҜеӣ дёәиҜ·жұӮйғҪеҺӢеҲ°дәҶеҗҺз«Ҝж•°жҚ®еұӮпјҢж•°жҚ®иҜ»еҶҷй”ҒеҶІзӘҒдёҘйҮҚпјҢ并еҸ‘й«ҳе“Қеә”ж…ўпјҢеҮ д№ҺжүҖжңүиҜ·жұӮйғҪи¶…ж—¶пјҢи®ҝй—®жөҒйҮҸеӨ§пјҢдёӢеҚ•жҲҗеҠҹзҡ„жңүж•ҲжөҒйҮҸе°Ҹ гҖӮ

дёҖи¶ҹзҒ«иҪҰ2000еј зҘЁпјҢ200wдёӘдәәеҗҢж—¶жқҘд№°пјҢжІЎжңүдәәиғҪд№°жҲҗеҠҹпјҢиҜ·жұӮжңүж•ҲзҺҮдёә0 гҖӮ

з”»еӨ–йҹіпјҡжӯӨж—¶зі»з»ҹзҡ„ж•ҲзҺҮпјҢиҝҳдёҚеҰӮзәҝдёӢе”®зҘЁзӘ—еҸЈ гҖӮ

пјҲ2пјүе……еҲҶеҲ©з”Ёзј“еӯҳ гҖӮ

з§’жқҖд№°зҘЁпјҢиҝҷжҳҜдёҖдёӘе…ёеһӢзҡ„иҜ»еӨҡеҶҷе°‘зҡ„дёҡеҠЎеңәжҷҜпјҡ

- иҪҰж¬ЎжҹҘиҜўпјҢиҜ»пјҢйҮҸеӨ§

- дҪҷзҘЁжҹҘиҜўпјҢиҜ»пјҢйҮҸеӨ§

- дёӢеҚ•е’Ңж”Ҝд»ҳпјҢеҶҷпјҢйҮҸе°Ҹ

з§’жқҖдёҡеҠЎпјҢеёёи§Ғзҡ„зі»з»ҹеҲҶеұӮжһ¶жһ„еҰӮдҪ•пјҹ

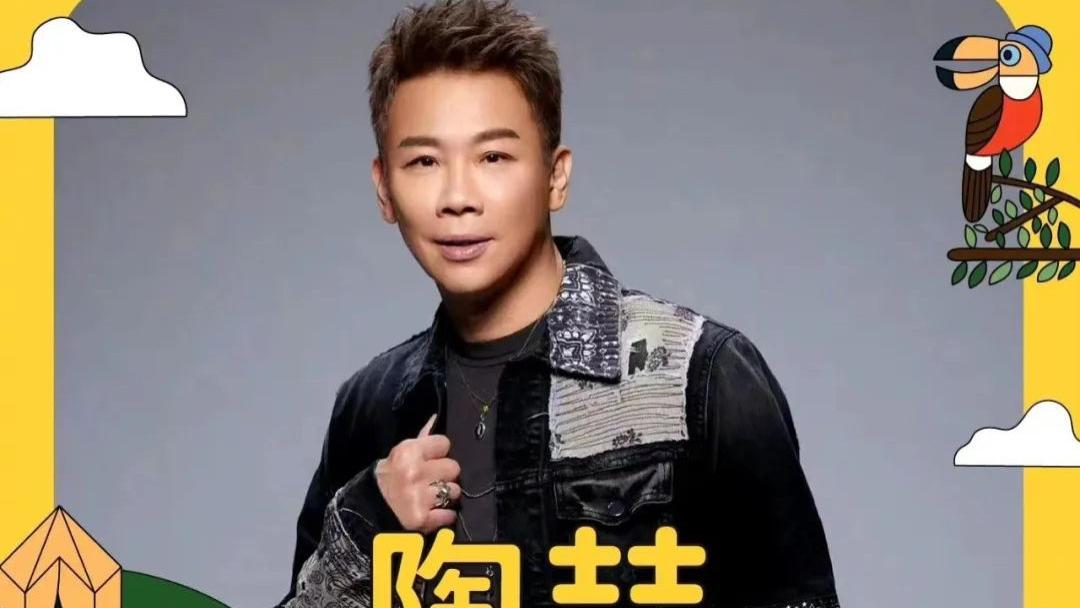

ж–Үз« жҸ’еӣҫ

з§’жқҖдёҡеҠЎпјҢеҸҜд»ҘдҪҝз”Ёе…ёеһӢзҡ„жңҚеҠЎеҢ–еҲҶеұӮжһ¶жһ„пјҡ

- з«ҜпјҲжөҸи§ҲеҷЁ/AppпјүпјҢжңҖдёҠеұӮпјҢйқўеҗ‘з”ЁжҲ·

- з«ҷзӮ№еұӮпјҢи®ҝй—®еҗҺз«Ҝж•°жҚ®пјҢжӢјиЈ…html/jsonиҝ”еӣһ

- жңҚеҠЎеұӮпјҢеұҸи”Ҫеә•еұӮж•°жҚ®з»ҶиҠӮпјҢжҸҗдҫӣж•°жҚ®и®ҝй—®

- ж•°жҚ®еұӮпјҢDBеӯҳеӮЁеә“еӯҳпјҢеҪ“然д№ҹжңүзј“еӯҳ

дёҖгҖҒз«ҜдёҠзҡ„иҜ·жұӮжӢҰжҲӘпјҲжөҸи§ҲеҷЁ/APPпјү

жғіеҝ…жҳҘиҠӮеӨ§е®¶йғҪзҺ©иҝҮеҫ®дҝЎзҡ„ж‘ҮдёҖж‘ҮжҠўзәўеҢ…пјҢз”ЁжҲ·жҜҸж‘ҮдёҖж¬ЎпјҢзңҹзҡ„е°ұдјҡеҫҖеҗҺз«ҜеҸ‘йҖҒдёҖж¬ЎиҜ·жұӮд№Ҳпјҹ

еӣһйЎҫжҠўзҘЁзҡ„еңәжҷҜпјҢз”ЁжҲ·зӮ№еҮ»“жҹҘиҜў”жҢүй’®д№ӢеҗҺпјҢзі»з»ҹеҚЎйЎҝпјҢз”ЁжҲ·зқҖжҖҘпјҢдјҡдёҚиҮӘи§үзҡ„еҶҚеҺ»йў‘з№ҒзӮ№еҮ»“жҹҘиҜў”пјҢдёҚдҪҶжІЎз”ЁпјҢеҸҚиҖҢе№ізҷҪж— ж•…еўһеҠ зі»з»ҹиҙҹиҪҪпјҢе№іеқҮдёҖдёӘз”ЁжҲ·зӮ№5ж¬ЎпјҢ80%зҡ„иҜ·жұӮжҳҜиҝҷд№ҲеӨҡеҮәжқҘзҡ„ гҖӮ

JSеұӮйқўпјҢеҸҜд»ҘйҷҗеҲ¶з”ЁжҲ·еңЁxз§’д№ӢеҶ…еҸӘиғҪжҸҗдәӨдёҖж¬ЎиҜ·жұӮпјҢд»ҺиҖҢйҷҚдҪҺзі»з»ҹиҙҹиҪҪ гҖӮ

з”»еӨ–йҹіпјҡйў‘з№ҒжҸҗдәӨпјҢеҸҜд»ҘеҸӢеҘҪжҸҗзӨә“йў‘зҺҮиҝҮеҝ«” гҖӮ

APPеұӮйқўпјҢеҸҜд»ҘеҒҡзұ»дјјзҡ„дәӢжғ…пјҢиҷҪ然用жҲ·з–ҜзӢӮзҡ„еңЁж‘Үеҫ®дҝЎжҠўзәўеҢ…пјҢдҪҶе…¶е®һxз§’жүҚеҗ‘еҗҺз«ҜеҸ‘иө·дёҖж¬ЎиҜ·жұӮ гҖӮ

з”»еӨ–йҹіпјҡиҝҷе°ұжҳҜжүҖи°“зҡ„“е°ҶиҜ·жұӮе°ҪйҮҸжӢҰжҲӘеңЁзі»з»ҹдёҠжёё”пјҢжөҸи§ҲеҷЁ/APPеұӮе°ұиғҪжӢҰжҲӘ80%+зҡ„иҜ·жұӮ гҖӮ

дёҚиҝҮпјҢз«ҜдёҠзҡ„жӢҰжҲӘеҸӘиғҪжҢЎдҪҸжҷ®йҖҡз”ЁжҲ·пјҲ99%зҡ„з”ЁжҲ·жҳҜжҷ®йҖҡз”ЁжҲ·пјүпјҢзЁӢеәҸе‘ҳfirebugдёҖжҠ“еҢ…пјҢеҶҷдёӘforеҫӘзҺҜзӣҙжҺҘи°ғз”ЁеҗҺз«ҜhttpжҺҘеҸЈпјҢjsжӢҰжҲӘж №жң¬дёҚиө·дҪңз”ЁпјҢиҝҷдёӢжҖҺд№ҲеҠһпјҹ

дәҢгҖҒз«ҷзӮ№еұӮзҡ„иҜ·жұӮжӢҰжҲӘ

еҰӮдҪ•жҠ—дҪҸзЁӢеәҸе‘ҳеҶҷforеҫӘзҺҜи°ғз”ЁhttpжҺҘеҸЈпјҢйҰ–е…ҲиҰҒзЎ®е®ҡз”ЁжҲ·зҡ„е”ҜдёҖж ҮиҜҶпјҢеҜ№дәҺйў‘з№Ғи®ҝй—®зҡ„з”ЁжҲ·дәҲд»ҘжӢҰжҲӘ гҖӮ

з”Ёд»Җд№ҲжқҘеҒҡз”ЁжҲ·зҡ„е”ҜдёҖж ҮиҜҶпјҹ

ipпјҹcookie-idпјҹеҲ«жғіеҫ—еӨӘеӨҚжқӮпјҢиҙӯзҘЁзұ»дёҡеҠЎйғҪйңҖиҰҒзҷ»еҪ•пјҢз”Ёuidе°ұиғҪж ҮиҜҶз”ЁжҲ· гҖӮ

еңЁз«ҷзӮ№еұӮпјҢеҜ№еҗҢдёҖдёӘuidзҡ„иҜ·жұӮиҝӣиЎҢи®Ўж•°е’ҢйҷҗйҖҹпјҢдҫӢеҰӮпјҡдёҖдёӘuidпјҢ5з§’еҸӘеҮҶйҖҸиҝҮ1дёӘиҜ·жұӮпјҢиҝҷж ·еҸҲиғҪжӢҰдҪҸ99%зҡ„forеҫӘзҺҜиҜ·жұӮ гҖӮ

дёҖдёӘuidпјҢ5sеҸӘйҖҸиҝҮдёҖдёӘиҜ·жұӮпјҢе…¶дҪҷзҡ„иҜ·жұӮжҖҺд№ҲеҠһпјҹ

зј“еӯҳпјҢйЎөйқўзј“еӯҳпјҢ5з§’еҶ…еҲ°иҫҫз«ҷзӮ№еұӮзҡ„е…¶д»–иҜ·жұӮпјҢеқҮиҝ”еӣһдёҠж¬Ўиҝ”еӣһзҡ„йЎөйқў гҖӮ

з”»еӨ–йҹіпјҡиҪҰж¬ЎжҹҘиҜўе’ҢдҪҷзҘЁжҹҘиҜўйғҪиғҪеӨҹиҝҷд№ҲеҒҡпјҢж—ўиғҪдҝқиҜҒз”ЁжҲ·дҪ“йӘҢпјҲиҮіе°‘жІЎжңүиҝ”еӣһ404йЎөйқўпјүпјҢеҸҲиғҪдҝқиҜҒзі»з»ҹзҡ„еҒҘеЈ®жҖ§пјҲеҲ©з”ЁйЎөйқўзј“еӯҳпјҢжҠҠиҜ·жұӮжӢҰжҲӘеңЁз«ҷзӮ№еұӮдәҶпјү гҖӮ

OKпјҢйҖҡиҝҮи®Ўж•°гҖҒйҷҗйҖҹгҖҒйЎөйқўзј“еӯҳжӢҰдҪҸдәҶ99%зҡ„жҷ®йҖҡзЁӢеәҸе‘ҳпјҢдҪҶд»Қжңүдәӣй«ҳз«ҜзЁӢеәҸе‘ҳпјҢдҫӢеҰӮй»‘е®ўпјҢжҺ§еҲ¶дәҶ10wдёӘиӮүйёЎпјҢжүӢйҮҢжңү10wдёӘuidпјҢеҗҢж—¶еҸ‘иҜ·жұӮпјҢиҝҷдёӢжҖҺд№ҲеҠһпјҹ

дёүгҖҒжңҚеҠЎеұӮзҡ„иҜ·жұӮжӢҰжҲӘ

并еҸ‘зҡ„иҜ·жұӮе·Із»ҸеҲ°дәҶжңҚеҠЎеұӮпјҢеҰӮдҪ•иҝӣжӢҰжҲӘпјҹ

жңҚеҠЎеұӮйқһеёёжё…жҘҡдёҡеҠЎзҡ„еә“еӯҳпјҢйқһеёёжё…жҘҡж•°жҚ®еә“зҡ„жҠ—еҺӢиғҪеҠӣпјҢеҸҜд»Ҙж №жҚ®иҝҷдёӨиҖ…иҝӣиЎҢеүҠеі°йҷҗйҖҹ гҖӮ

дҫӢеҰӮпјҢдёҡеҠЎжңҚеҠЎеҫҲжё…жҘҡзҡ„зҹҘйҒ“пјҢдёҖеҲ—зҒ«иҪҰеҸӘжңү2000еј иҪҰзҘЁпјҢжӯӨж—¶йҖҸдј 10wдёӘиҜ·жұӮеҺ»ж•°жҚ®еә“пјҢжҳҜжІЎжңүж„Ҹд№үзҡ„ гҖӮ

з”»еӨ–йҹіпјҡеҒҮеҰӮж•°жҚ®еә“жҜҸз§’еҸӘиғҪжҠ—500дёӘеҶҷиҜ·жұӮпјҢе°ұеҸӘйҖҸдј 500дёӘ гҖӮ

гҖҗжҜҸз§’100WиҜ·жұӮпјҢжһ¶жһ„еҰӮдҪ•дјҳеҢ–гҖ‘з”Ёд»Җд№ҲеүҠеі°пјҹ

иҜ·жұӮйҳҹеҲ— гҖӮ

еҜ№дәҺеҶҷиҜ·жұӮпјҢеҒҡиҜ·жұӮйҳҹеҲ—пјҢжҜҸж¬ЎеҸӘйҖҸдј жңүйҷҗзҡ„еҶҷиҜ·жұӮеҺ»ж•°жҚ®еұӮпјҲдёӢи®ўеҚ•пјҢж”Ҝд»ҳиҝҷж ·зҡ„еҶҷдёҡеҠЎпјү гҖӮ

жҺЁиҚҗйҳ…иҜ»

- ж·ҳе®қйқһжі•иҜ·жұӮзӯҫеҗҚжҳҜд»Җд№Ҳж„ҸжҖқ ж·ҳе®қйқһжі•иҜ·жұӮзӯҫеҗҚжҖҺд№ҲеҠһ

- ajaxвҖ”вҖ”иҜ·жұӮжң¬ең°ж•°жҚ®еә“

- иҘҝеҢ—йЈҺжҜҸз§’10зұіжҳҜеҮ зә§йЈҺ дёңеҢ—йЈҺ10зұіжҜҸз§’жҳҜеҮ зә§йЈҺ

- PythonжңҚеҠЎеҷЁеҠЁжҖҒиө„жәҗиҜ·жұӮ

- C#жЁЎжӢҹHTTPиҜ·жұӮеҸ‘йҖҒдәҢиҝӣеҲ¶ж–Ү件

- иҫҫеҲ°зү©зҗҶзҪ‘еҚЎдёҠйҷҗпјҢзӘҒ然еҮ еҚҒдёҮзҡ„иҜ·жұӮи®ҝй—®Redisзҡ„жҹҗдёӘkeyеҰӮдҪ•и§ЈеҶі

- жҜҸз§’20W次并еҸ‘еҲҶиҜҚжЈҖзҙўпјҢжһ¶жһ„еҰӮдҪ•и®ҫи®Ўпјҹ

- C++еҶ…еӯҳжұ е®һзҺ°

- дёҖж–ҮеҪ»еә•жҗһжҮӮJavaScriptејӮжӯҘиҜ·жұӮ

- PHPжЁЎжӢҹPOST/GETиҜ·жұӮпјҢд»ҘеҸҠhttp_build_queryз”Ёжі•пјҢеҘҪйҷҢз”ҹпјҹ