и¶іеӨҹеҘҪзҡ„з»„еҗҲж•°жҚ®жү©еўһ( дәҢ )

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

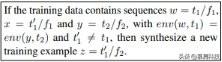

еҰӮжһңзүҮж®өеңЁз»ҷе®ҡж ·жң¬дёӯеӨҡж¬ЎеҮәзҺ° пјҢ еҲҷжӣҝжҚўжүҖжңүе®һдҫӢ гҖӮ (и§Ғеӣҫ 3)

иҜӯиЁҖ笔记 е°Ҫз®ЎдёҠиҝ°ж“ҚдҪңжҳҜз”ұз”ҹжҲҗиҜӯжі•е’ҢеҲҶеёғиҜӯд№үзҡ„и§Ғи§ЈжүҖй©ұеҠЁзҡ„ пјҢ дҪҶеә”иҜҘејәи°ғзҡ„жҳҜ пјҢ дҪңдёәдёҖиҲ¬иҜӯиЁҖеҺҹеҲҷзҡ„иЎЁиҝ° пјҢ иҝҷжҳҫ然жҳҜй”ҷиҜҜзҡ„ гҖӮеҸҚдҫӢжҜ”жҜ”зҡҶжҳҜпјҡеңЁиӢұиҜӯдёӯ пјҢ йҮҚйҹіиЎҚз”ҹеҗҚиҜҚпјҲдҫӢеҰӮд»Һ recГіrd еҫ—жқҘзҡ„ rГ©cordпјүе°Ҷиў«и§Ҷдёәи®ёеӨҡеҗҚиҜҚе’ҢеҠЁиҜҚеҸҜдә’жҚўзҡ„иҜҒжҚ® гҖӮ еңЁжҷ®йҖҡиҜқдёӯ пјҢ kДӣshГ¬ е’Ң dГ nshГ¬ йғҪиЎЁзӨәвҖңbutвҖқ пјҢ дҪҶжҳҜеңЁзү№е®ҡзҡ„з»“жһ„дёӯд»… kДӣshГ¬ еҸҜд»ҘиЎЁзӨәвҖңйқһеёёвҖқ гҖӮ

йҮҚиҰҒзҡ„жҳҜжӯӨзұ»й”ҷиҜҜзҡ„зӣёеҜ№йў‘зҺҮпјҡеҰӮжһңй”ҷиҜҜеҜ№дёҚеҮҶзЎ®жЁЎеһӢзҡ„иҙЎзҢ®е°ҸдәҺеҺҹе§Ӣи®ӯз»ғж•°жҚ®дёҚи¶іеҜјиҮҙзҡ„дёҚеҮҶзЎ® пјҢ GECA д»Қ然жңүеё®еҠ© гҖӮ еңЁжқЎд»¶й—®йўҳдёӯ пјҢ дҫӢеҰӮдёҠйқўзҡ„жңәеҷЁзҝ»иҜ‘зӨәдҫӢ пјҢ жӯӨзұ»й”ҷиҜҜеҸҜиғҪжҳҜе®Ңе…Ёж— е®ізҡ„пјҡеҰӮжһңжҲ‘们еңЁзңҹе®һи®ӯз»ғж•°жҚ®зҡ„ж”ҜжҢҒиҢғеӣҙд№ӢеӨ–еҗҲжҲҗж–°зҡ„пјҲx пјҢ yпјүеҜ№ пјҢ йҷӨдәҶжҸҗдҫӣжңүз”Ёзҡ„дёҖиҲ¬еҪ’зәіеҒҸе·®еӨ– пјҢ е®ғ们еҸҜиғҪдёҚдјҡеҪұе“ҚжЁЎеһӢеҜ№зңҹе®һж”ҜжҢҒзҡ„йў„жөӢ гҖӮ

е®һзҺ° иЈ…з®ұж“ҚдҪңзҡ„з®ҖеҚ•е®һзҺ°иҠұиҙ№ O(t3f3)зҡ„ж—¶й—ҙпјҲе…¶дёӯ t жҳҜж•°жҚ®йӣҶдёӯдёҚеҗҢжЁЎжқҝзҡ„ж•°йҮҸ пјҢ f жҳҜдёҚеҗҢзүҮж®өзҡ„ж•°йҮҸпјү гҖӮйҖҡиҝҮжһ„е»әеҗҲйҖӮзҡ„ж•°жҚ®з»“жһ„пјҲз®—жі• 1пјү пјҢ еҸҜд»ҘдјҳеҢ–дёә O(ft2e)пјҲе…¶дёӯ e жҳҜжҳ е°„еҲ°еҗҢдёҖзҺҜеўғзҡ„жЁЎжқҝж•°йҮҸпјү гҖӮ

з©әй—ҙйңҖжұӮеҸҜиғҪд»Қ然еҫҲеӨ§пјҲдёҺ n-gram иҜӯиЁҖжЁЎеһӢжүҖдҪҝз”Ёзҡ„з©әй—ҙйңҖжұӮзӣёжҜ”иҫғпјү пјҢ иҜӯиЁҖе»әжЁЎж–ҮзҢ®дёӯзҡ„зӯ–з•ҘеҸҜиў«з”ЁжқҘеҮҸе°‘еҶ…еӯҳдҪҝз”ЁпјҲHeafield пјҢ 2011пјү гҖӮеҜ№дәҺзўҺзүҮе’ҢзҺҜеўғеҮҪж•°зҡ„йҖүжӢ© пјҢ иҜҘз®—жі•жҳҜдёҚеҸҜзҹҘзҡ„ гҖӮ дёӢж–Үе°ҶеҜ№жҜҸдёӘе®һйӘҢзҡ„зү№е®ҡд»»еҠЎйҖүжӢ©дҪңиҜҰз»Ҷд»Ӣз»Қ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

3гҖҒиҜҠж–ӯе®һйӘҢ ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

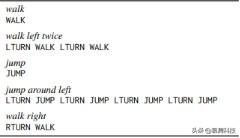

жҲ‘们йҰ–е…ҲеҜ№еҗҲжҲҗж•°жҚ®иҝӣиЎҢдәҶдёҖз»„е®һйӘҢ пјҢ ж—ЁеңЁзІҫзЎ®жөӢиҜ• GECA жҳҜеҗҰжҸҗдҫӣдәҶи®ҫи®Ўж—¶жүҖиҰҒжұӮзҡ„жіӣеҢ–иғҪеҠӣ гҖӮ иҝҷйҮҢжҲ‘们дҪҝз”Ё SCAN ж•°жҚ®йӣҶ пјҢ иҜҘж•°жҚ®йӣҶз”ұз®ҖеҚ•зҡ„иӢұиҜӯе‘Ҫд»Өе’ҢзҰ»ж•ЈеҠЁдҪңеәҸеҲ—й…ҚеҜ№з»„жҲҗпјҲеӣҫ 2пјү гҖӮжҲ‘们зү№еҲ«е…іжіЁadd primitiveпјҲjumpпјүе’Ңadd templateпјҲaround rightпјүжқЎд»¶ пјҢ иҝҷдәӣжқЎд»¶жөӢиҜ•д»ЈзҗҶжҳҜеҗҰеҸҜд»ҘеңЁи®ӯз»ғж—¶зӢ¬з«Ӣең°жҡҙйңІдәҺеҚ•дёҖе‘Ҫд»ӨжҲ–дҝ®йҘ°з¬ҰпјҲдҫӢеҰӮjumpвҠҝJUMPпјү пјҢ 并еңЁжөӢиҜ•ж—¶е°Ҷе®ғ们еҗҲ并еҲ°жӣҙеӨҚжқӮзҡ„е‘Ҫд»Өдёӯ пјҢ еҰӮеүҚйқўзҡ„зӨәдҫӢжүҖзӨә гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

еӣҫ 2пјҡSCAN ж•°жҚ®зӨәдҫӢ

жҲ‘们жҸҗеҸ–еёҰжңүдёҖдёӘй—ҙйҡҷдё”жңҖеӨ§й•ҝеәҰдёә 4 дёӘд»ӨзүҢзҡ„зүҮж®ө гҖӮ иҜҘзҺҜеўғиў«и§Ҷдёәе®Ңж•ҙзҡ„жЁЎжқҝ гҖӮ з”ҹжҲҗзҡ„ж ·жң¬е°Ҷиў«йҷ„еҠ еҲ°еҺҹе§Ӣж•°жҚ®йӣҶдёӯ гҖӮ дҪңдёәиҝҷз§Қжү©еўһиҝҮзЁӢж•Ҳжһңзҡ„дёҖдёӘдҫӢеӯҗ пјҢ еҺҹе§Ӣзҡ„jumpеҲҶеүІеҢ…еҗ« 12620 дёӘи®ӯз»ғж ·жң¬ пјҢ GECA дҪҝз”Ё 395 дёӘдёҚеҗҢзҡ„жЁЎжқҝе’Ң 6 дёӘдёҚеҗҢзҡ„зүҮж®өз”ҹжҲҗйўқеӨ– 395 дёӘи®ӯз»ғж ·жң¬ гҖӮ

еҲ©з”ЁеҺҹе§Ӣж•°жҚ®йӣҶе’Ңжү©еўһж•°жҚ®йӣҶ пјҢ жҲ‘们и®ӯз»ғдәҶдёҖдёӘ embedding size дёә 64 пјҢ hidden size дёә 512 пјҢ еҢ…еҗ«еҸҢеҗ‘зј–з ҒеҷЁе’ҢжіЁж„ҸеҠӣи§Јз ҒеҷЁзҡ„еҚ•еұӮ LSTM зј–з ҒеҷЁ-и§Јз ҒеҷЁжЁЎеһӢ гҖӮ жҲ‘们дҪҝз”Ё ADAM и®ӯз»ғжЁЎеһӢ пјҢ step size дёә 0.001 пјҢ dropout rate дёә 0.5 гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

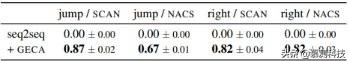

иЎЁ 1пјҡSCAN ж•°жҚ®йӣҶзҡ„еәҸеҲ—еҢ№й…ҚзІҫеәҰ

з»“жһңеҰӮиЎЁ 1 жүҖзӨә пјҢ дёҺ Lake е’Ң Baroni зҡ„еҺҹе§Ӣе®һйӘҢдёҖиҮҙ пјҢ еҹәзәҝеәҸеҲ—еҲ°еәҸеҲ—жЁЎеһӢе®Ңе…Ёж— жі•жҺЁе№ҝеҲ°жөӢиҜ•йӣҶ гҖӮеә”з”Ё GECA еҸҜдҪҝеӯҰд№ зҡ„жЁЎеһӢжҲҗеҠҹең°еңЁжҢҮд»ӨеҲ°еҠЁдҪңе’ҢеҠЁдҪңеҲ°жҢҮд»ӨдёӨдёӘж–№еҗ‘дёҠеҜ№еҚ•дёӘеҚ•иҜҚжқЎзӣ®е’ҢеӨҡеҚ•иҜҚжқЎзӣ®жҲҗеҠҹиҝӣиЎҢеӨ§еӨҡж•°жөӢиҜ• гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

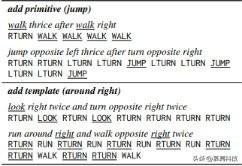

еӣҫ 3пјҡдёә SCAN д»»еҠЎеҗҲжҲҗзҡ„ж ·жң¬

еҲҶжһҗпјҡж ·жң¬ еӣҫ 3 жҳҫзӨәдәҶдёҖдәӣеҗҲжҲҗж ·жң¬ гҖӮ add primitiveжқЎд»¶дёӢзҡ„жҲҗеҠҹжәҗдәҺд»ҘдёӢзәҰжқҹпјҡеҺҹиҜӯзҡ„еҚ•дёӘж ·жң¬з”Ёжі•д»Қеҝ…йЎ»жҳҜжңүж•Ҳзҡ„пјҲcommand пјҢ actionпјүеҜ№ пјҢ 并且жүҖжңүеҠЁиҜҚйғҪжҳҜзӢ¬з«Ӣзҡ„жңүж•Ҳе‘Ҫд»Ө гҖӮ еҸӘжңү runвҠҝRUN пјҢ walkвҠҝWALK пјҢ lookвҠҝLOOK дёүдёӘж ·жң¬иҜҒе®һдәҶ GECA з”ЁдәҺеҗҲжҲҗдҪҝз”Ё jump зҡ„ж–°з”Ёжі•пјӣеҰӮжһңе°Ҷе…¶еҲ йҷӨ пјҢ еҲҷ sequence-to-sequence жЁЎеһӢзҡ„и®ӯз»ғзІҫеәҰе°ҶдҝқжҢҒдёҚеҸҳ пјҢ дҪҶ GECA е°Ҷж— жі•еҗҲжҲҗд»»дҪ•ж¶үеҸҠ jump зҡ„ж–°ж ·жң¬ пјҢ 并且жөӢиҜ•зІҫеәҰе°ҶйҷҚиҮійӣ¶ гҖӮ еҜ№дәҺadd templateжқЎд»¶ пјҢ GECA жӯЈзЎ®ең°е°ҶжүҖжңүеҮәзҺ°зҡ„ LTURN жӣҝжҚўдёә RTURN жқҘз”ҹжҲҗaround rightжЁЎжқҝзҡ„ж–°ж ·жң¬пјӣиҜҘж ·жң¬зӘҒеҮәдәҶ GECA еҸ‘зҺ°дёҚиҝһз»ӯдё”йқһдёҠдёӢж–Үж— е…ізҡ„жӣҝжҚўеҠҹиғҪзҡ„жңүз”ЁжҖ§ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- иҝӣж”»жүҚжҳҜжңҖеҘҪзҡ„йҳІе®ҲпјҒеҚҺдёәжҢүдёӢвҖңеҝ«иҝӣй”®вҖқпјҢдј жқҘ3дёӘеҘҪж¶ҲжҒҜ

- еҚЎеҶ…еҹәжў…йҡҶеӨ§еӯҰжҸҗеҮәдәҶжӣҙеҘҪзҡ„ејәеҜҶз Ғи®ҫзҪ®е»әи®®

- жғ жҷ®жҲҳ66вҖ”вҖ”еҸҜиғҪжҳҜдё»жөҒд»·дҪҚдёӯжңҖеҘҪзҡ„й”®зӣҳдҪ“йӘҢ

- е°Ҹзұі11ж•Ҳд»ҝиӢ№жһңдёҚйҖҒе……з”өеҷЁ жҲ–жңүжӣҙеҘҪзҡ„ж–№ејҸжӣҝд»Ј

- и¶Ҡзә§зҡ„иЎЁзҺ°пјҢдёүж¬ҫйҹіиҙЁи¶…еҘҪзҡ„зңҹж— зәҝиҖіжңәжҺЁиҚҗ

- йҡҸж—¶йҡҸең°зңӢзҢ«зӢ—пјҢйҷҢз”ҹдәәж•Ій—Ёд№ҹдёҚе®іжҖ•пјҢе°ұжҳҜиҝҷд№ҲзҘһеҘҮзҡ„з»„еҗҲ

- иӢ№жһңз ҚеҚ•дәҶ еӨ§иҢғеӣҙеҸ–ж¶Ҳз”ЁжҲ·и®ўеҚ• иҜҙеҘҪзҡ„з”ЁжҲ·жҳҜдёҠеёқе‘ўпјҹ

- йҖӮз”ЁдәҺжңәеҷЁеӯҰд№ гҖҒж•°жҚ®з§‘еӯҰе’Ңж·ұеәҰеӯҰд№ пјҢдёҚеҗҢд»·дҪҚжңҖеҘҪзҡ„笔记жң¬з”өи„‘

- еҚҺдёә Watch Fit еӣҫиөҸпјҡи¶іеӨҹзәӨи–„пјҢд№ҹи¶іеӨҹжҷәж…§

- Lava Be UеңЁеҚ°еәҰеҸ‘еёғ дҪҺз«ҜжүӢжңәиҫ…д»Ҙ2+32GBеҶ…еӯҳз»„еҗҲ

![[и…ҫи®Ҝ科жҠҖ]дәҡ马йҖҠд»“еә“еҸӘиҝӣеҝ…йңҖе“ҒпјҢиҙ·ж¬ҫзј иә«зҡ„еҚ–家дёҡеҠЎеҸ—жҚҹгҖҒеІҢеІҢеҸҜеҚұ](http://ttbs.guangsuss.com/image/5f41d7bbff536ef727029b8fdf70c7a9)