еҪ»еә•зҗҶи§Ј IO еӨҡи·ҜеӨҚз”Ёе®һзҺ°жңәеҲ¶( дә” )

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

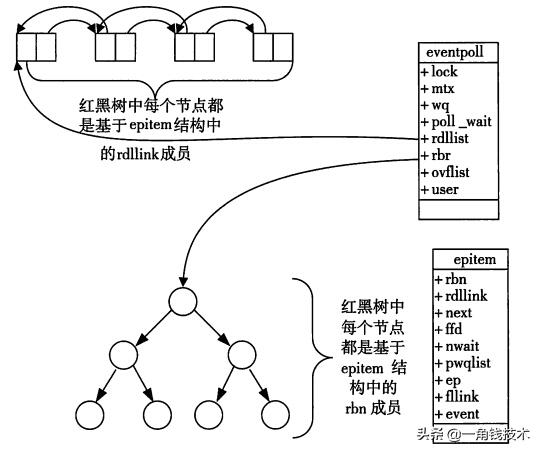

д»ҺдёҠйқўзҡ„и®Іи§ЈеҸҜзҹҘпјҡйҖҡиҝҮзәўй»‘ж ‘е’ҢеҸҢй“ҫиЎЁж•°жҚ®з»“жһ„ пјҢ 并结еҗҲеӣһи°ғжңәеҲ¶ пјҢ йҖ е°ұдәҶepollзҡ„й«ҳж•Ҳ гҖӮи®Іи§Је®ҢдәҶEpollзҡ„жңәзҗҶ пјҢ жҲ‘们дҫҝиғҪеҫҲе®№жҳ“жҺҢжҸЎepollзҡ„з”Ёжі•дәҶ гҖӮ дёҖеҸҘиҜқжҸҸиҝ°е°ұжҳҜпјҡдёүжӯҘжӣІ гҖӮ

- 第дёҖжӯҘпјҡepoll_create()зі»з»ҹи°ғз”Ё гҖӮ жӯӨи°ғз”Ёиҝ”еӣһдёҖдёӘеҸҘжҹ„ пјҢ д№ӢеҗҺжүҖжңүзҡ„дҪҝз”ЁйғҪдҫқйқ иҝҷдёӘеҸҘжҹ„жқҘж ҮиҜҶ гҖӮ

- 第дәҢжӯҘпјҡepoll_ctl()зі»з»ҹи°ғз”Ё гҖӮ йҖҡиҝҮжӯӨи°ғз”Ёеҗ‘epollеҜ№иұЎдёӯж·»еҠ гҖҒеҲ йҷӨгҖҒдҝ®ж”№ж„ҹе…ҙи¶Јзҡ„дәӢ件 пјҢ иҝ”еӣһ0ж ҮиҜҶжҲҗеҠҹ пјҢ иҝ”еӣһ-1иЎЁзӨәеӨұиҙҘ гҖӮ

- 第дёүйғЁпјҡepoll_wait()зі»з»ҹи°ғз”Ё гҖӮ йҖҡиҝҮжӯӨи°ғ用收йӣҶ收йӣҶеңЁepollзӣ‘жҺ§дёӯе·Із»ҸеҸ‘з”ҹзҡ„дәӢ件 гҖӮ

int main(int argc, char* argv[]){/** еңЁиҝҷйҮҢиҝӣиЎҢдёҖдәӣеҲқе§ӢеҢ–зҡ„ж“ҚдҪң пјҢ* жҜ”еҰӮеҲқе§ӢеҢ–ж•°жҚ®е’Ңsocketзӯү гҖӮ*/// еҶ…ж ёдёӯеҲӣе»әepеҜ№иұЎepfd=epoll_create(256);// йңҖиҰҒзӣ‘еҗ¬зҡ„socketж”ҫеҲ°epдёӯepoll_ctl(epfd,EPOLL_CTL_ADD,listenfd,while(1) {// йҳ»еЎһиҺ·еҸ–nfds = epoll_wait(epfd,events,20,0);for(i=0;iepollзҡ„дјҳзӮ№- жІЎжңүжңҖеӨ§е№¶еҸ‘иҝһжҺҘзҡ„йҷҗеҲ¶ пјҢ иғҪжү“ејҖзҡ„FDзҡ„дёҠйҷҗиҝңеӨ§дәҺ1024пјҲ1Gзҡ„еҶ…еӯҳдёҠиғҪзӣ‘еҗ¬зәҰ10дёҮдёӘз«ҜеҸЈпјүпјӣ

- ж•ҲзҺҮжҸҗеҚҮ пјҢ дёҚжҳҜиҪ®иҜўзҡ„ж–№ејҸ пјҢ дёҚдјҡйҡҸзқҖFDж•°зӣ®зҡ„еўһеҠ ж•ҲзҺҮдёӢйҷҚ гҖӮ еҸӘжңүжҙ»и·ғеҸҜз”Ёзҡ„FDжүҚдјҡи°ғз”ЁcallbackеҮҪж•°пјӣеҚіEpollжңҖеӨ§зҡ„дјҳзӮ№е°ұеңЁдәҺе®ғеҸӘз®ЎдҪ вҖңжҙ»и·ғвҖқзҡ„иҝһжҺҘ пјҢ иҖҢи·ҹиҝһжҺҘжҖ»ж•°ж— е…і пјҢ еӣ жӯӨеңЁе®һйҷ…зҡ„зҪ‘з»ңзҺҜеўғдёӯ пјҢ Epollзҡ„ж•ҲзҺҮе°ұдјҡиҝңиҝңй«ҳдәҺselectе’Ңpollпјӣ

- еҶ…еӯҳжӢ·иҙқ пјҢ еҲ©з”Ёmmap()ж–Ү件жҳ е°„еҶ…еӯҳеҠ йҖҹдёҺеҶ…ж ёз©әй—ҙзҡ„ж¶ҲжҒҜдј йҖ’пјӣеҚіepollдҪҝз”ЁmmapеҮҸе°‘еӨҚеҲ¶ејҖй”Җ гҖӮ

epollзјәзӮ№- epollеҸӘиғҪе·ҘдҪңеңЁ linux дёӢ

epoll LT дёҺ ET жЁЎејҸзҡ„еҢәеҲ«epoll жңү EPOLLLT е’Ң EPOLLET дёӨз§Қи§ҰеҸ‘жЁЎејҸ пјҢ LT жҳҜй»ҳи®Өзҡ„жЁЎејҸ пјҢ ET жҳҜ вҖңй«ҳйҖҹвҖқ жЁЎејҸ гҖӮ

- LT жЁЎејҸдёӢ пјҢ еҸӘиҰҒиҝҷдёӘ fd иҝҳжңүж•°жҚ®еҸҜиҜ» пјҢ жҜҸж¬Ў epoll_wait йғҪдјҡиҝ”еӣһе®ғзҡ„дәӢ件 пјҢ жҸҗйҶ’з”ЁжҲ·зЁӢеәҸеҺ»ж“ҚдҪңпјӣ

- ET жЁЎејҸдёӢ пјҢ е®ғеҸӘдјҡжҸҗзӨәдёҖж¬Ў пјҢ зӣҙеҲ°дёӢж¬ЎеҶҚжңүж•°жҚ®жөҒе…Ҙд№ӢеүҚйғҪдёҚдјҡеҶҚжҸҗзӨәдәҶ пјҢ ж— и®ә fd дёӯжҳҜеҗҰиҝҳжңүж•°жҚ®еҸҜиҜ» гҖӮ жүҖд»ҘеңЁ ET жЁЎејҸдёӢ пјҢ read дёҖдёӘ fd зҡ„ж—¶еҖҷдёҖе®ҡиҰҒжҠҠе®ғзҡ„ buffer иҜ»е®Ң пјҢ жҲ–иҖ…йҒҮеҲ° EAGIN й”ҷиҜҜ гҖӮ

epollдҪҝз”ЁвҖңдәӢ件вҖқзҡ„е°ұз»ӘйҖҡзҹҘж–№ејҸ пјҢ йҖҡиҝҮepoll_ctlжіЁеҶҢfd пјҢ дёҖж—ҰиҜҘfdе°ұз»Ә пјҢ еҶ…ж ёе°ұдјҡйҮҮз”Ёзұ»дјјcallbackзҡ„еӣһи°ғжңәеҲ¶жқҘжҝҖжҙ»иҜҘfd пјҢ epoll_waitдҫҝеҸҜд»Ҙ收еҲ°йҖҡзҹҘ гҖӮ

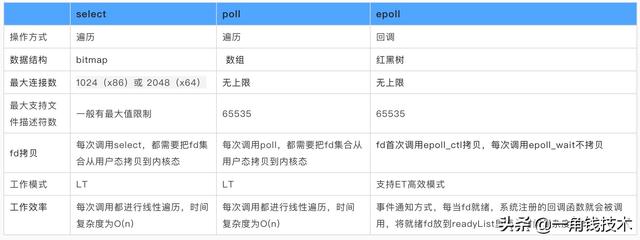

select/poll/epollд№Ӣй—ҙзҡ„еҢәеҲ«select пјҢ poll пјҢ epollйғҪжҳҜIOеӨҡи·ҜеӨҚз”Ёзҡ„жңәеҲ¶ гҖӮ I/OеӨҡи·ҜеӨҚз”Ёе°ұйҖҡиҝҮдёҖз§ҚжңәеҲ¶ пјҢ еҸҜд»Ҙзӣ‘и§ҶеӨҡдёӘжҸҸиҝ°з¬Ұ пјҢ дёҖж—ҰжҹҗдёӘжҸҸиҝ°з¬Ұе°ұз»ӘпјҲдёҖиҲ¬жҳҜиҜ»е°ұз»ӘжҲ–иҖ…еҶҷе°ұз»Әпјү пјҢ иғҪеӨҹйҖҡзҹҘзЁӢеәҸиҝӣиЎҢзӣёеә”зҡ„иҜ»еҶҷж“ҚдҪң гҖӮ дҪҶselect пјҢ poll пјҢ epollжң¬иҙЁдёҠйғҪжҳҜеҗҢжӯҘI/O пјҢ еӣ дёә他们йғҪйңҖиҰҒеңЁиҜ»еҶҷдәӢ件е°ұз»ӘеҗҺиҮӘе·ұиҙҹиҙЈиҝӣиЎҢиҜ»еҶҷ пјҢ д№ҹе°ұжҳҜиҜҙиҝҷдёӘиҜ»еҶҷиҝҮзЁӢжҳҜйҳ»еЎһзҡ„ пјҢ иҖҢејӮжӯҘI/OеҲҷж— йңҖиҮӘе·ұиҙҹиҙЈиҝӣиЎҢиҜ»еҶҷ пјҢ ејӮжӯҘI/Oзҡ„е®һзҺ°дјҡиҙҹиҙЈжҠҠж•°жҚ®д»ҺеҶ…ж ёжӢ·иҙқеҲ°з”ЁжҲ·з©әй—ҙ гҖӮ

epollи·ҹselectйғҪиғҪжҸҗдҫӣеӨҡи·ҜI/OеӨҚз”Ёзҡ„и§ЈеҶіж–№жЎҲ гҖӮ еңЁзҺ°еңЁзҡ„LinuxеҶ…ж ёйҮҢжңүйғҪиғҪеӨҹж”ҜжҢҒ пјҢ е…¶дёӯepollжҳҜLinuxжүҖзү№жңү пјҢ иҖҢselectеҲҷеә”иҜҘжҳҜPOSIXжүҖ规е®ҡ пјҢ дёҖиҲ¬ж“ҚдҪңзі»з»ҹеқҮжңүе®һзҺ°

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

epollжҳҜLinuxзӣ®еүҚеӨ§и§„жЁЎзҪ‘з»ң并еҸ‘зЁӢеәҸејҖеҸ‘зҡ„йҰ–йҖүжЁЎеһӢ гҖӮ еңЁз»қеӨ§еӨҡж•°жғ…еҶөдёӢжҖ§иғҪиҝңи¶…selectе’Ңpoll гҖӮ зӣ®еүҚжөҒиЎҢзҡ„й«ҳжҖ§иғҪwebжңҚеҠЎеҷЁNginxжӯЈејҸдҫқиө–дәҺepollжҸҗдҫӣзҡ„й«ҳж•ҲзҪ‘з»ңеҘ—жҺҘеӯ—иҪ®иҜўжңҚеҠЎ гҖӮ дҪҶжҳҜ пјҢ еңЁе№¶еҸ‘иҝһжҺҘдёҚй«ҳзҡ„жғ…еҶөдёӢ пјҢ еӨҡзәҝзЁӢ+йҳ»еЎһI/Oж–№ејҸеҸҜиғҪжҖ§иғҪжӣҙеҘҪ гҖӮ

жҺЁиҚҗйҳ…иҜ»

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- жӣҫиў«дә¬дёңзү©жөҒж•Ҳд»ҝпјҢи®©йӣ·еҶӣиҠұ1дәҝжӢҜж•‘пјҢеҰӮд»Ҡж¬ 7000дёҮеҪ»еә•еҮәеұҖ

- зәҝдёӢеёӮеңәеҪ»еә•вҖңд№ұдәҶвҖқпјҒе°Ҹзұіе®Јеёғ新规пјҒеҚҺдёәжҚҶз»‘еҠ д»·иЎҢдёәиҝҺдәүи®®

- дёҖжіўжңӘе№ідёҖжіўеҸҲиө·пјҢжҲ‘д№°дёӘиҸңе°ұж¬ дәҶдёҖ笔иҙ·ж¬ҫпјҹзҫҺеӣўиҝҷж¬ЎеҪ»еә•жІЎиҜқиҜҙ

- еҫ®иҪҜ|еӨ–еӘ’пјҡеҫ®иҪҜе°ҶеҜ№Windows 10з•ҢйқўиҝӣиЎҢеҪ»еә•ж”№иҝӣ е·ІжӢӣе…ө买马

- еҚҺдёәP50зңҹжңәеӣҫжӣқе…үпјҡеӨ–еҪўеҸҳеҢ–еҫҲеҪ»еә•

- дә¬дёң7FRESHиҝҺжқҘеҪ»еә•еҸҳйқ©

- Windows 10зӯүиҪҜ件全йғЁе°ҒжқҖ FlashеҪ»еә•иҜҙеҶҚи§Ғ

- ж•°жҚ®|ж–°еҹәе»әж—¶д»ЈпјҢй«ҳеӨ§е…Ёзҡ„ж•°жҚ®з®ЎзҗҶи§ЈеҶіж–№жЎҲжҳҜжҖҺж ·вҖңзӮјвҖқжҲҗзҡ„пјҹ

- е°јеә·зӣёжңәе°ҶдәҺ2021е№ҙеә•еүҚеҪ»еә•е‘ҠеҲ«вҖңж—Ҙжң¬дә§вҖқ

- еҫ®дҝЎзҡ„дёҖйЎ№жӣҙж–°пјҢеҪ»еә•и®©з”ЁжҲ·вҖңеҸҚж„ҹвҖқпјҢиҝҷжҳҜиҰҒејҖеҗҜзӣҙж’ӯж—¶д»Јпјҹ

![[vivo]дёӨеҚғе·ҰеҸіеҸҜд»Ҙжҗһе®ҡзҡ„5Gдёӯз«ҜжңәпјҡдёҖж¬ҫ120Hzй«ҳеҲ·еұҸпјҢеҸҰдёҖж¬ҫз»ӯиҲӘжҖӘе…Ҫ](http://img88.010lm.com/img.php?https://image.uc.cn/s/wemedia/s/2020/4c382528b7b9d7f7ebee19b4bbca1156.jpg)