з‘һе…Ӣ|з”ЁGPT-2еҒҡдёӘвҖңе§ҘзҲ·вҖқпјҒ57иЎҢд»Јз Ғз»ҷгҖҠз‘һе…Ӣе’ҢиҺ«и’ӮгҖӢеҶҷж–°еү§йӣҶ

_еҺҹйўҳдёә з”ЁGPT-2еҒҡдёӘвҖңе§ҘзҲ·вҖқпјҒ57иЎҢд»Јз Ғз»ҷгҖҠз‘һе…Ӣе’ҢиҺ«и’ӮгҖӢеҶҷж–°еү§йӣҶ

ж–Үз« еӣҫзүҮ

еӨ§ж•°жҚ®ж–Үж‘ҳеҮәе“Ғ

жқҘжәҗпјҡMedium

зј–иҜ‘пјҡxtгҖҒcoolboy

жңҖиҝ‘ пјҢ дёҖжҸҗеҲ°иҜӯиЁҖжЁЎеһӢ пјҢ жҲ‘们жғіеҲ°зҡ„еҸҜиғҪе°ұжҳҜGPT-3 пјҢ жҜ•з«ҹжҳҜжңүеҸІд»ҘжқҘ规模жңҖеӨ§зҡ„иҜӯиЁҖжЁЎеһӢ пјҢ еҸӮж•°й«ҳиҫҫ1750дәҝдёӘ гҖӮ дәӢе®һдёҠ пјҢ е®ғзҡ„еүҚиә«GPT-2д№ҹеҫҲејәеӨ§ гҖӮ

жң¬ж–Үе°Ҷеҗ‘еҗ„дҪҚеұ•зӨәеҰӮдҪ•еҲ©з”ЁHugging Faceзҡ„Transformersеә“вҖңзІҫз»Ҷи°ғж•ҷвҖқдҪҝз”ЁгҖҠз‘һе…Ӣе’ҢиҺ«и’ӮгҖӢеү§жң¬йў„е…Ҳи®ӯз»ғиҝҮзҡ„GPT-2жЁЎеһӢ гҖӮ д»ҘдёӢжҲ‘们дјҡеҲ¶дҪңдёҖдёӘеұ•зӨәжЎҲдҫӢ пјҢ 并дҪҝз”ЁStreamlit SharingжқҘйғЁзҪІе®ғ гҖӮ

д»Ӣз»Қ йҡҸзқҖжңәеҷЁеӯҰд№ пјҲMachine Learning, MLпјүе’ҢиҮӘ然иҜӯиЁҖеӨ„зҗҶпјҲNatural Language Processing, NLPпјүжҠҖжңҜзҡ„еҝ«йҖҹиҝӣеұ• пјҢ ж–°з®—жі•е…·еӨҮз”ҹжҲҗж–Үжң¬зҡ„иғҪеҠӣ пјҢ иҝҷдәӣж–Үжң¬д№ҹеҸҳеҫ—и¶ҠжқҘи¶ҠжҺҘиҝ‘дәәзұ»еҶҷеҮәзҡ„еҶ…е®№ гҖӮ GPT21е°ұжҳҜе…¶дёӯдёҖдёӘз®—жі• пјҢ е®ғиў«еә”з”ЁеңЁеҫҲеӨҡејҖжәҗйЎ№зӣ®2дёӯ гҖӮ GPT2д»ҘWebTextдёәи®ӯз»ғйӣҶ пјҢ WebTextеҢ…еҗ«4500дёҮжқЎжқҘиҮӘRedditпјҲдёҖдёӘеҜ№ж–°й—»иҝӣиЎҢиҜ„и®әзҡ„зҪ‘з»ңзӨҫеҢәпјүзҡ„еӨ–й“ҫ гҖӮ е…¶дёӯеҚ жҚ®еӨ–й“ҫеҶ…е®№еүҚ10зҡ„дё»иҰҒж•°жҚ®3жқҘиҮӘGoogle пјҢ Archive пјҢ Blogspot пјҢ Github пјҢ NYTimes пјҢ WordPress пјҢ Washington Post пјҢ Wikia пјҢ BBCд»ҘеҸҠThe Guardian гҖӮ еҸ—иҝҮи®ӯз»ғзҡ„GPT2жЁЎеһӢиғҪж №жҚ®е…·дҪ“ж•°жҚ®йӣҶеҶҚиў«иҝӣдёҖжӯҘи°ғж Ў пјҢ жҜ”еҰӮиҜҙжңҖз»ҲиғҪеӨҹжҠ“еҸ–жҹҗдёӘж•°жҚ®йӣҶзҡ„йЈҺж јжҲ–иҖ…иғҪеӨҹеҒҡж–ҮжЎЈеҲҶзұ» гҖӮ

иҝҷдёҖеҠҹиғҪеҹәдәҺиҝҒ移еӯҰд№ зҡ„е®һзҺ° пјҢ еҚідёҖз§Қд»Һжәҗи®ҫе®ҡдёӯжҸҗеҸ–зҹҘиҜҶ并еә”з”ЁеҲ°еҸҰдёҖдёӘдёҚеҗҢзӣ®ж Үи®ҫзҪ®дёҠзҡ„жҠҖжңҜ4 гҖӮ еҰӮжһңжғіиҰҒдәҶи§ЈGTP2з®—жі•жӣҙиҜҰз»Ҷзҡ„и§ЈйҮҠд»ҘеҸҠз®—жі•жһ„жһ¶ пјҢ иҜ·еҸӮиҖғеҺҹе§Ӣж–ҮзҢ®5 пјҢ OpenAIзҡ„еҚҡе®ў6е’ҢJay Alammarзҡ„жҢҮеҜјиҜҙжҳҺ7 гҖӮ

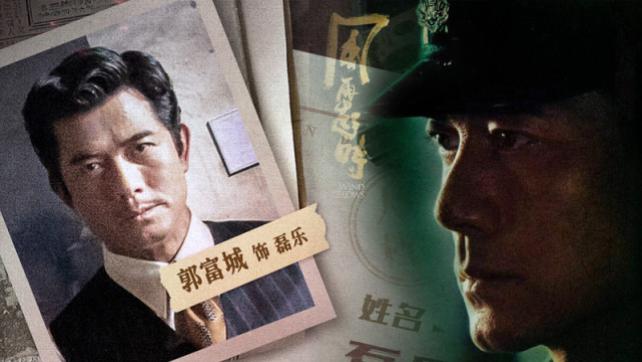

ж•°жҚ®йӣҶ з”ЁжқҘи®ӯз»ғGPT2зҡ„ж•°жҚ®йӣҶжқҘиҮӘгҖҠз‘һе…Ӣе’ҢиҺ«и’ӮгҖӢеүҚдёүеӯЈзҡ„еҸ°иҜҚ гҖӮ жҲ‘жҸҗеүҚиҝҮж»ӨдәҶе…¶дёӯдёҚеұһдәҺRick пјҢ Morty пјҢ Summer пјҢ Bethе’ҢJerryзҡ„еҜ№иҜқ гҖӮ иҝҷдәӣж•°жҚ®дёӢиҪҪеҗҺд»Ҙз”ҹж–Үжң¬ж јејҸиҝӣиЎҢеӯҳеӮЁ гҖӮ жҜҸдёҖиЎҢж•°жҚ®д»ЈиЎЁдёҖдҪҚдё»и§’зҡ„еҸ‘иЁҖ пјҢ еҗҢж—¶еҢ…еҗ«дәҶеҜ№д»–们иҜӯж°”/еҠЁдҪңеҸҠеҜ№иҜқеңәжҷҜзҡ„жҸҸиҝ° гҖӮ ж•°жҚ®йӣҶиў«еҲҶдёәи®ӯз»ғйӣҶе’ҢжөӢиҜ•йӣҶ пјҢ еҲҶеҲ«жңү6905иЎҢе’Ң1454иЎҢ гҖӮ еҺҹж–Ү件еңЁжӯӨеҸҜдҫӣжҹҘзңӢпјҲhttps://github.com/e-tony/Story_Generator/tree/main/dataпјү гҖӮ и®ӯз»ғйӣҶжҳҜз”ЁжқҘи®ӯз»ғжЁЎеһӢзҡ„ пјҢ жөӢиҜ•йӣҶеҲҷз”ЁжқҘиҜ„дј°жЁЎеһӢж•Ҳжһң гҖӮ

и®ӯз»ғжЁЎеһӢ Hugging FaceвҖҷs Transformersеә“жҸҗдҫӣдәҶдёҖдёӘз®ҖеҚ•зҡ„GPT2жЁЎеһӢи®ӯз»ғи„ҡжң¬пјҲhttps://github.com/huggingface/transformers/tree/master/examples/language-modeling#gpt-2gpt-and-causal-language-modelingпјү гҖӮ

жҺҘдёӢжқҘ пјҢ дҪ еҸҜд»ҘеңЁGoogle Colab notebookпјҲhttps://colab.research.google.com/drive/1opXtwhZ02DjdyoVlafiF3Niec4GqPJvC?usp=sharingпјүзҺҜеўғдёӢејҖе§Ӣи®ӯз»ғиҮӘе·ұзҡ„жЁЎеһӢ гҖӮ дёҖж—Ұе®ҢжҲҗдәҶжЁЎеһӢи®ӯз»ғ пјҢ дҪ йңҖиҰҒе°Ҷи®ӯз»ғиҫ“еҮәж–Ү件еӨ№дёӢиҪҪдёӢжқҘ пјҢ ж–Ү件еӨ№йҮҢеҢ…еҗ«дәҶжүҖжңүзӣёе…іжЁЎеһӢзҡ„ж–Ү件 пјҢ иҝҷдёҖжӯҘеҜ№д№ӢеҗҺеҠ иҪҪжЁЎеһӢиҮіе…ійҮҚиҰҒ гҖӮ дҪ иҝҳеҸҜд»Ҙе°ҶиҮӘе·ұзҡ„жЁЎеһӢдёҠдј еҲ°Hugging Faceзҡ„жЁЎеһӢдёӯеҝғ8 пјҢ и®©е…¶д»–дәәд№ҹиғҪзңӢеҲ°е®ғ гҖӮ иҝҷдёӘи®ӯз»ғеҘҪзҡ„жЁЎеһӢеңЁдҪҝз”ЁжөӢиҜ•ж•°жҚ®иҜ„дј°ж—¶ пјҢ дјҡиҺ·еҫ—17еҲҶе·ҰеҸізҡ„еӨҚжқӮеәҰеҫ—еҲҶ гҖӮ

ж–Үз« еӣҫзүҮ

жҗӯе»әеә”з”Ё йҰ–е…Ҳ пјҢ жҲ‘们新е»әдёҖдёӘеҸ«еҒҡStory_Generatorзҡ„йЎ№зӣ®ж–Ү件еӨ№пјҢ 并еңЁPython 3.7зҡ„зҺҜеўғдёӢејҖе§ӢиҜ•йӘҢпјҡ

mkdir Story_Generator

cd Story_Generator

python3.7 -m venv venv

source venv/bin/activate

дёӢдёҖжӯҘ пјҢ е®үиЈ…жүҖжңүйңҖиҰҒзҡ„дҫқиө–пјҡ

pip install streamlit-nightly==0.69.3.dev20201025

pip install torch==1.6.0+cpu torchvision==0.7.0+cpu -f https://download.pytorch.org/whl/torch_stable.html

pip install git+git://github.com/huggingface/transformers@59b5953d89544a66d73

ж•ҙдёӘеә”з”ЁйҖҡиҝҮapp.pyе®һзҺ° гҖӮ жҲ‘们йңҖиҰҒеҲӣе»әpythonж–Ү件并еҜје…ҘжҲ‘们新е®үиЈ…зҡ„дҫқиө–пјҡ

import urllib

import streamlit as st

import torch

from transformers import pipeline

еңЁжӣҙиҝӣдёҖжӯҘд№ӢеүҚ пјҢ йңҖиҰҒеҠ иҪҪи®ӯз»ғеҘҪзҡ„жЁЎеһӢ гҖӮ еҲ©з”Ё@st_cacheзҡ„иЈ…йҘ°еҷЁ пјҢ жү§иЎҢдёҖж¬Ўload_model()еҮҪ数并е°Ҷз»“жһңеӯҳеҲ°жң¬ең°зј“еӯҳ гҖӮ иҝҷдёӘж“ҚдҪңиғҪеӨҹеўһе№…зЁӢеәҸжҖ§иғҪ гҖӮ жҺҘзқҖз”Ёpipeline()еҮҪж•°еҠ иҪҪж–Үжң¬з”ҹжҲҗеҷЁжЁЎеһӢеҚіеҸҜпјҲе°Ҷд»Јз Ғдёӯзҡ„жЁЎеһӢи·Ҝеҫ„жҚўжҲҗдҪ иҮӘе·ұзҡ„жЁЎеһӢжҲ–иҖ…д№ҹеҸҜд»ҘзӣҙжҺҘз”ЁжЁЎеһӢдёӯеҝғйҮҢжҲ‘йў„е…Ҳи®ӯз»ғиҝҮзҡ„mypre-trainedmodel пјҢ https://huggingface.co/e-tony/gpt2-rnmпјүпјҡ

@st.cache(allow_output_mutation=True, suppress_st_warning=True)

def load_model():

return pipeline("text-generation", model="e-tony/gpt2-rnm")model = load_model()

дҪҝз”ЁStreamlitдёӯзҡ„text_area()еҮҪж•°еҸҜд»Ҙз”ҹжҲҗдёҖдёӘз®ҖеҚ•ж–Үжң¬жЎҶ гҖӮ жҲ‘们еҸҜд»ҘйўқеӨ–е®ҡд№үж–Үжң¬жЎҶзҡ„й«ҳеәҰеҸҠе…¶е®№зәізҡ„жңҖеӨ§еӯ—з¬Ұж•°пјҲйңҖиҰҒжіЁж„Ҹзҡ„жҳҜи¶ҠеӨ§зҡ„ж–Үжң¬з”ҹжҲҗж—¶й—ҙи¶Ҡй•ҝпјүпјҡ

textbox = st.text_area('Start your story:', '', max_chars=1000)

жҗһе®ҡдәҶд»Јз Ғзҡ„ејҖеӨҙйғЁеҲҶ пјҢ жҲ‘们зҺ°еңЁеҸҜд»ҘиҝҗиЎҢзЁӢеәҸ пјҢ зңӢзңӢзӣ®еүҚзҡ„иҝӣеәҰпјҲд№ҹеҸҜд»ҘйҖҡиҝҮеҲ·ж–°йЎөйқўиҺ·еҸ–еҸҠж—¶иҝӣеәҰпјү

жҺЁиҚҗйҳ…иҜ»

- жҳҺжҳҹе…«еҚҰ|еә”йҮҮе„ҝдәҢиғҺжҒўеӨҚиә«жқҗпјҢжӣҫз»ҸзӣҙиЁҖжғіз”ҹеҘіе„ҝпјҢеҒҡдёӘвҖңе® еҘізӢӮйӯ”вҖқ

- е‘ЁйңҮеҚ—|е‘ЁйңҮеҚ—пјҢеҒҡдёӘеӯқеӯҗпјҢзңҹзҡ„еҫҲйҡҫеҗ—пјҹ

- жқҘй•ҝжІҷ|жҲҗжҜ…10жңҲ26еҸ·еҪ•еҲ¶гҖҠеҝ«жң¬гҖӢпјҒеҘідё»иўҒеҶ°еҰҚзјәеёӯпјҢзҹӣзӣҫеҠ еү§пјҢе§ңзЈҠеҒҡдёӘдәәпјҹ

- еҺЁжҲҝ|еҸӮи§Ӯжј”е‘ҳе‘Ёжқ°еҰӮд»Ҡзҡ„家пјҢеҺЁжҲҝеҒҡдёӘзҺ»з’ғеҗҠйЎ¶пјҢе®ӨеҶ…д№ҹиғҪдә«еҸ—жҲ·еӨ–йҳіе…ү