еӨ§ж•°жҚ®ж•°жҚ®жөҒжҠҖжңҜеңЁGPUе’ҢеӨ§ж•°жҚ®еӨ„зҗҶдёӯзҡ„еә”з”Ё( дёү )

жөҒеӨ„зҗҶеҷЁеҜ№еә”зҡ„зЁӢеәҸжү§иЎҢжЁЎеһӢйҮҮз”Ёзҡ„жҳҜдёӨзә§зј–зЁӢж–№ејҸ пјҢ еҲҶдёәжөҒзЁӢеәҸе’ҢеҶ…ж ёпјҲkernelпјүзЁӢеәҸ гҖӮ жөҒзЁӢеәҸжҺ§еҲ¶ж•ҙдёӘзЁӢеәҸзҡ„жү§иЎҢиҝҮзЁӢ пјҢ е°Ҷж•°жҚ®з»„з»ҮжҲҗжөҒзҡ„еҪўејҸпјӣkernelзЁӢеәҸиҙҹиҙЈеҜ№жөҒдёӯзҡ„ж•°жҚ®иҝӣиЎҢ并иЎҢеӨ„зҗҶ пјҢ е°Ҷж•°жҚ®жҳ е°„еҲ°еӨ§и§„жЁЎи®Ўз®—йҳөеҲ—дёӯ пјҢ еңЁжөҒи®Ўз®—дёӯ пјҢ ж ёеҝғзЁӢеәҸзҡ„жҰӮеҝөеҸҜд»Ҙи®ӨдёәжҳҜе®Ҹи§ӮдёҠзҡ„ж•°жҚ®жөҒиҠӮзӮ№ гҖӮ еҸӘиҰҒжөҒе’Ңи®Ўз®—йҳөеҲ—е°ұз»Әе°ұеҸҜд»Ҙжү§иЎҢжҢҮд»Ө пјҢ иҖҢдё”kernelзҡ„иҫ“еҮәжөҒйҖҡеёёдјҡдҪңдёәдёӢдёҖдёӘkernelзҡ„иҫ“е…ҘжөҒ гҖӮ еңЁжөҒи®Ўз®—жЁЎеһӢдёӯ пјҢ жүҖи°“зҡ„жөҒе°ұжҳҜдёҖз»„жңүеәҸзҡ„ж•°жҚ®и®°еҪ•пјҲrecordпјү гҖӮ и®°еҪ•з”ұзӣёе…іж•°жҚ®зҡ„йӣҶеҗҲз»„жҲҗ гҖӮ жөҒи®°еҪ•еҸҜд»ҘжҳҜд»»ж„Ҹж•°жҚ®зұ»еһӢ пјҢ дҪҶеҗҢдёҖдёӘжөҒдёӯзҡ„и®°еҪ•еҝ…йЎ»жҳҜеҗҢзұ»еһӢзҡ„ гҖӮ

2.3 GPUGPUжҳҜзӣ®еүҚеӨ§ж•°жҚ®е’ҢжҷәиғҪи®Ўз®—ж—¶д»Јзҡ„е® е„ҝ пјҢ еҸҜд»ҘиҜҙеңЁжҷәиғҪи®Ўз®—йўҶеҹҹ пјҢ GPUеҚ жҚ®дәҶдё»еҜјең°дҪҚ гҖӮ GPUзҡ„еҸ‘еұ•е’ҢжҲҗеҠҹйғҪзҰ»дёҚејҖж•°жҚ®жөҒжҠҖжңҜ пјҢ д»Һ硬件зҡ„и§’еәҰжқҘзңӢ пјҢ GPUзҡ„жү§иЎҢеҚ•е…ғжҳҜз”ұжөҒеӨ„зҗҶеҷЁз»„жҲҗзҡ„ пјҢ йҖҡиҝҮе ҶеҸ еӨ§йҮҸеҗҢжһ„зҡ„жөҒеӨ„зҗҶеҷЁжқҘжҸҗдҫӣи¶…ејәзҡ„и®Ўз®—иғҪеҠӣпјӣд»ҺиҪҜ件зҡ„и§’еәҰзңӢ пјҢ GPUзҡ„kernelжү§иЎҢжЁЎејҸжҳҜе…ёеһӢзҡ„ж•°жҚ®жөҒжү§иЎҢжңәеҲ¶ пјҢ дёҚеҗҢзҡ„kernelзҡ„жү§иЎҢйЎәеәҸжҳҜз”ұиө„жәҗе’Ңиҫ“е…Ҙиҫ“еҮәж•°жҚ®жҳҜеҗҰе°ұз»ӘеҶіе®ҡзҡ„ гҖӮ еңЁkernelзҡ„жү§иЎҢиҝҮзЁӢдёӯ пјҢ дёҚеҗҢзәҝзЁӢзҡ„жү§иЎҢйЎәеәҸеҸҲжҳҜдёҚзЎ®е®ҡзҡ„ гҖӮ

иө·еҲқ пјҢ GPUйҖҡеёёеҸӘжҳҜдҪңдёәдёҖз§ҚеӣҫеҪўеӣҫеғҸеӨ„зҗҶдё“з”Ёи®ҫеӨҮиҖҢеӯҳеңЁзҡ„ пјҢ йҮҮз”ЁйЎ¶зӮ№зј–зЁӢзҡ„ж–№ејҸ гҖӮ з”ұдәҺе…¶й«ҳеәҰдё“з”Ёзј–зЁӢжҺҘеҸЈзҡ„зү№зӮ№ пјҢ еҪ“ж—¶зҡ„GPUеңЁе…¶д»–и®Ўз®—йўҶеҹҹзҡ„еә”з”ЁжҳҜеҚҒеҲҶеҸ—йҷҗзҡ„ гҖӮ д№ӢеҗҺNVIDIAе…¬еҸёеј•е…Ҙ2дёӘе…ій”®зҡ„жҠҖжңҜи§ЈеҶідәҶиҝҷдёҖй—®йўҳ гҖӮ еңЁзЎ¬д»¶з»“жһ„дёҠ пјҢ NVIDIAзҡ„GPUйҮҮз”Ёз»ҹдёҖзҡ„и®Ўз®—дҪ“зі»з»“жһ„ пјҢ з”ұиӢҘе№ІдёӘеҗҢжһ„зҡ„жөҒеӨ„зҗҶеҷЁз»„жҲҗи®Ўз®—йҳөеҲ— пјҢ зЁӢеәҸе‘ҳзңӢеҲ°зҡ„д№ҹдёҚеҶҚжҳҜзү№е®ҡзҡ„еӣҫеҪўеӨ„зҗҶеҚ•е…ғ пјҢ иҖҢжҳҜйҖҡз”Ёзҡ„еӨ§и§„模并иЎҢеӨ„зҗҶеҷЁ гҖӮ еңЁиҪҜ件еұӮйқў пјҢ йҮҮз”ЁCUDA[9] пјҢ еӨ§еӨ§з®ҖеҢ–дәҶGPUзҡ„зј–зЁӢ пјҢ зЁӢеәҸе‘ҳдёҚйңҖиҰҒе…іжіЁдј з»ҹеә”з”ЁзЁӢеәҸжҺҘеҸЈпјҲapplication programming interface пјҢ APIпјү гҖӮ йҷӨдәҶNVIDIAд№ӢеӨ– пјҢ AMDе’ҢиӢұзү№е°”пјҲIntelпјүд№ҹйғҪжңүиҮӘе·ұзҡ„еӣҫеҪўеӣҫеғҸеӨ„зҗҶеҷЁ пјҢ дҪҶжҳҜзӣ®еүҚйғҪж— жі•ж’јеҠЁNVIDIAеңЁGPUйўҶеҹҹзҡ„дё»еҜјең°дҪҚ гҖӮ жң¬ж–Үд»ҘNVIDIAзҡ„GPUдёәжЎҲдҫӢиҝӣиЎҢеҲҶжһҗ гҖӮ

NVIDIAе…¬еҸёGPUзҡ„жҲҗеҠҹеҫҲеӨ§зЁӢеәҰдёҠжҳҜеӣ дёәеҖҹйүҙдәҶжөҒеӨ„зҗҶеҷЁзҡ„жҖқжғі пјҢ Imagineзҡ„иҙҹиҙЈдәәDally W Jж•ҷжҺҲеҠ е…ҘNVIDIAе…¬еҸёжҲҗдёәйҰ–еёӯ科еӯҰ家жһҒеӨ§ең°жҺЁеҠЁдәҶжөҒи®Ўз®—еңЁGPUйўҶеҹҹзҡ„дҪҝз”Ё гҖӮ еӣҫ2жҳҜдёҖдёӘе…ёеһӢзҡ„NVIDIAе…¬еҸёзҡ„GPUжһ¶жһ„ пјҢ е®ғдҪҝз”ЁSMжқҘжһ„е»әж•ҙдёӘи®ҫеӨҮ пјҢ дёҚеҗҢзі»еҲ—зҡ„GPUдёӯжҜҸдёӘSMеҢ…еҗ«зҡ„жөҒеӨ„зҗҶеҷЁж•°йҮҸдёҚзӯү пјҢ з”ұеҺҹжқҘзҡ„8дёӘеҲ°32дёӘ пјҢ еҶҚеҲ°еҰӮд»Ҡзҡ„192дёӘ гҖӮ жҜҸдёӘSMжҳҜе®Ңе…ЁзӢ¬з«ӢеҸҜжү§иЎҢзҡ„ пјҢ еңЁGPUзҡ„еҶ…йғЁ пјҢ зӣёеҪ“дәҺйӣҶжҲҗдәҶеҫҲеӨҡеҗҢжһ„зҡ„ж•°жҚ®жөҒи®Ўз®—иҠӮзӮ№ гҖӮ еңЁеӯҳеӮЁеұӮж¬Ўж–№йқў пјҢGPUж¶үеҸҠзүҮдёҠеӯҳеӮЁз©әй—ҙе’ҢзүҮеӨ–еӯҳеӮЁз©әй—ҙ гҖӮ зүҮдёҠеӯҳеӮЁз©әй—ҙеҢ…жӢ¬жҢҮд»ӨcacheгҖҒеҜ„еӯҳеҷЁгҖҒеҸҜй…ҚзҪ®зҡ„е…ұдә«еӯҳеӮЁеҷЁе’ҢL1 cacheд»ҘеҸҠL2 cache гҖӮ дёҚеҗҢдәҺе…ёеһӢзҡ„жөҒеӨ„зҗҶеҷЁ пјҢ GPUйҮҮз”ЁиҪҜ件еҸҜз®ЎзҗҶзҡ„cacheжЁЎејҸ пјҢ ж—ўеҸҜд»ҘжҳҫзӨәз®ЎзҗҶж•°жҚ® пјҢ д№ҹеҸҜд»ҘеңЁдёҖе®ҡзЁӢеәҰдёҠеҲ©з”Ёcacheзҡ„еұҖеҹҹжҖ§ пјҢ дҪҝеҫ—GPUеҸҜд»ҘйҖӮеә”дёҚеҗҢзҡ„еә”з”ЁеңәжҷҜ гҖӮ GPUзҡ„зүҮеӨ–еӯҳеӮЁз§°дёәе…ЁеұҖеӯҳеӮЁеҷЁпјҲglobal memoryпјү пјҢ з”ЁжқҘеӯҳеӮЁеӨ§йҮҸзҡ„ж•°жҚ® гҖӮ

гҖҗеӨ§ж•°жҚ®ж•°жҚ®жөҒжҠҖжңҜеңЁGPUе’ҢеӨ§ж•°жҚ®еӨ„зҗҶдёӯзҡ„еә”з”ЁгҖ‘

жң¬ж–ҮжҸ’еӣҫ

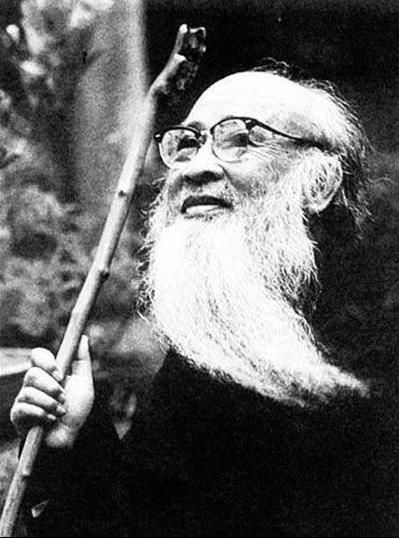

еӣҫ1 Imagine жөҒеӨ„зҗҶеҷЁдҪ“зі»з»“жһ„

жң¬ж–ҮжҸ’еӣҫ

еӣҫ2 GPUзҡ„е…ёеһӢжһ¶жһ„

CUDAжҳҜз”ұNVIDIAејҖеҸ‘зҡ„дёҖз§Қйқўеҗ‘GPUйҖҡз”Ёи®Ўз®—зҡ„并иЎҢзј–зЁӢжЁЎеһӢ пјҢ ж”ҜжҢҒC/C++гҖҒFortranзӯүй«ҳзә§иҜӯиЁҖ гҖӮ CUDAзј–зЁӢжЁЎеһӢйҮҮз”Ёhost+deviceзҡ„дё»д»ҺжЁЎејҸ пјҢ еңЁCPUдёҠжү§иЎҢжҺ§еҲ¶жөҒ пјҢ еңЁGPUз«Ҝжү§иЎҢи®Ўз®—жөҒ пјҢ е…¶жү§иЎҢжЁЎејҸе’ҢзәҝзЁӢз»„з»ҮеұӮж¬ЎеҰӮеӣҫ3жүҖзӨә гҖӮ дё»жңәпјҲhostпјүCPUзЁӢеәҸдё»иҰҒиҙҹиҙЈжү§иЎҢжҺ§еҲ¶жөҒеӨҚжқӮзҡ„дёІиЎҢзЁӢеәҸж®ө пјҢ 并иҙҹиҙЈи®ҫеӨҮз«Ҝи®Ўз®—kernelзҡ„и°ғз”Ёд»ҘеҸҠдё»жңәдёҺи®ҫеӨҮд№Ӣй—ҙзҡ„ж•°жҚ®дј иҫ“зӯүж“ҚдҪң гҖӮ kernelзЁӢеәҸиҙҹиҙЈжү§иЎҢ并иЎҢеәҰеҫҲй«ҳзҡ„и®Ўз®—д»»еҠЎ гҖӮ еҪ“и®Ўз®—kernelиў«и°ғз”Ёж—¶ пјҢ е°Ҷж №жҚ®жү§иЎҢй…ҚзҪ®еҸҳйҮҸ<<>>еҲӣе»ә并组з»ҮзәҝзЁӢеңЁи®ҫеӨҮдёҠзҡ„жү§иЎҢеұӮж¬Ў гҖӮ kernelзЁӢеәҸйҖҡиҝҮзәҝзЁӢзә§е’ҢзәҝзЁӢеқ—зә§дёӨзә§е№¶иЎҢеҜ№еә”з”ЁиҝӣиЎҢеҠ йҖҹ гҖӮ зәҝзЁӢжҳҜз»ҶзІ’еәҰзҡ„并иЎҢеұӮж¬Ў пјҢ е®ғжү§иЎҢеңЁжөҒеӨ„зҗҶеҷЁдёҠ пјҢ еӨ§йҮҸзҡ„зәҝзЁӢеҸҜд»ҘеҗҢж—¶жү§иЎҢ пјҢ дҪҶжҳҜзәҝзЁӢзҡ„жү§иЎҢйЎәеәҸ并дёҚжҳҜзЎ®е®ҡзҡ„ пјҢ жҜҸдёҖдёӘзәҝзЁӢйҖҡиҝҮиҮӘе·ұзҡ„IDиҜ»еҸ–еҜ№еә”зҡ„ж•°жҚ®иҝӣиЎҢеӨ„зҗҶ гҖӮ зәҝзЁӢзҡ„IDеҲ»з”»дәҶж•°жҚ®жөҒи®Ўз®—жЁЎеһӢдёӯдёҚеҗҢж•°жҚ®зҡ„д»ӨзүҢзҡ„и§’иүІ пјҢ дҪҝеҫ—еҚідҪҝзәҝзЁӢзҡ„жү§иЎҢжҳҜд№ұеәҸзҡ„ пјҢ д№ҹд»Қ然иғҪеӨҹдҝқиҜҒзЁӢеәҸзҡ„жӯЈзЎ®жҖ§ гҖӮ CUDAиҝҳжҸҗдҫӣдәҶеӨҡдёӘkernelеҗҢж—¶жү§иЎҢзҡ„жңәеҲ¶ пјҢ е°ұжҳҜдёәдәҶдҝқиҜҒжөҒеӨ„зҗҶеҷЁзҡ„и®Ўз®—иҙҹиҪҪиҫҫеҲ°йҘұе’ҢзҠ¶жҖҒ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- йҫҹйі–иЎҢжғ…дёҺжҠҖжңҜ|еҗ„ең°йҫҹиӢ—дәӨжҳ“еҠЁжҖҒ

- дёӯеӣҪж–°й—»зҪ‘|дҫҜз«Ӣе®үйҷўеЈ«пјҡз ”еҸ‘йӣҶжҲҗз©әж°”еҮҖеҢ–е’Ңж¶ҲжқҖжҠҖжңҜеә”з”ЁжҲҳвҖңз–«вҖқ

- з–«жғ…|зҫҺеӣҪз–«жғ…йҖҹжҠҘпјҡзЎ®иҜҠж•°е·ІйҖјиҝ‘284дёҮпјӣзү№жң—жҷ®еҸ‘иҜқпјҡ99%ж–°еҶ з—…дҫӢе®Ңе…Ёж— е®іпјӣзҫҺ专家пјҡе®һйҷ…ж„ҹжҹ“ж•°жҲ–жҳҜзҺ°жңүж•°жҚ®10~24еҖҚ

- й»‘еҸ”科жҠҖ 4Kе…ЁйқўеұҸ+зӢ¬еҲӣжҖ§еұҸдёӢйҖҸй•ңжҠҖжңҜпјҢдҪ зІүдәҶеҗ—пјҢзҙўе°јйЎ¶зә§5GжҰӮеҝөжңәжӣқе…ү

- гҖҢеҫҗиүәжҙӢгҖҚдёӨзҷҫдёҮзҡ„ж•°жҚ®е·®пјҢеј иүәеҮЎеҚҙвҖңйЎ¶жӣҝвҖқеҫҗиүәжҙӢеҮәйҒ“пјҢжӯЈйқўж’•ејҖеҲӣ3еҶ…幕

- дё»д»Һ|Redisзі»еҲ—пјҲдә”пјүпјҡдё»д»ҺеӨҚеҲ¶

- жёёжҲҸжңәе®һз”ЁжҠҖжңҜ|гҖҠе‘Ҫд»ӨдёҺеҫҒжңҚ йҮҚеҲ¶зүҲгҖӢејҖеҗҜжҠҳжүЈпјҢжҠҳеҗҺ119е…ғ

- йҮ‘иүІе…ү|дә§й”ҖдҪҺиҝ·иҝҳжү©дә§4.25еҖҚпјҢеҘҘжқҘеҫ·пјҡжңӘжҠ«йңІж ёеҝғжҠҖжңҜдәәе‘ҳйҮҚеӨ§еҸҳеҢ–пјҢ

- зәўеҲҠиҙўз»Ҹ|и’ҷжі°иӮЎд»ҪжӢҹеҲӣдёҡжқҝжіЁеҶҢдёҠеёӮ иҗҘдёҡ收е…Ҙж•°жҚ®ејӮеёёй—®йўҳйҡҫи§Ј

- гҖҺйҳІеј№иЎЈгҖҸ6еҗҚз©ҝзқҖйҳІеј№иЎЈзҡ„еҶӣдәәзӣҙжҺҘиў«еҮ»жҜҷпјҢеҚ°еәҰ专家пјҡеӯҗеј№жҠҖжңҜжқҘиҮӘдёӯеӣҪпјҢеҸҜж”»з ҙйҳІеј№иЎЈ