и®ӯз»ғж·ұеәҰеӯҰд№ зҪ‘з»ңж—¶еҖҷпјҢеҮәзҺ°NanжҳҜе•ҘеҺҹеӣ пјҢе’ӢжүҚиғҪйҒҝе…Қ( дәҢ )

в– зҪ‘еҸӢ

иҜҙжҳҺи®ӯз»ғдёҚ收ж•ӣдәҶ, еӯҰд№ зҺҮеӨӘеӨ§пјҢжӯҘеӯҗиҝҲзҡ„еӨӘеӨ§еҜјиҮҙжўҜеәҰзҲҶзӮёзӯүйғҪжҳҜжңүеҸҜиғҪзҡ„пјҢеҸҰеӨ–д№ҹжңүеҸҜиғҪжҳҜзҪ‘з»ңзҡ„й—®йўҳпјҢзҪ‘з»ңз»“жһ„и®ҫи®Ўзҡ„жңүй—®йўҳгҖӮжҲ‘зҺ°еңЁзҡ„йҮҮз”Ёж–№ејҸжҳҜпјҡ 1. ејұеҢ–еңәжҷҜпјҢе°ҶдҪ зҡ„ж ·жң¬з®ҖеҢ–пјҢеҗ„дёӘеӯҰд№ зҺҮзӯүеҸӮж•°йҮҮз”Ёе…ёеһӢй…ҚзҪ®пјҢжҜ”еҰӮ10дёҮж ·жң¬йғҪжҳҜеҗҢдёҖеј еӨҚеҲ¶зҡ„пјҢи®©иҝҷдёӘзҪ‘з»ңеҺ»жӢҹеҗҲпјҢеҰӮжһңжңүй—®йўҳпјҢеҲҷжҳҜзҪ‘з»ңзҡ„й—®йўҳгҖӮеҗҰеҲҷеҲҷжҳҜеҗ„дёӘеҸӮж•°зҡ„й—®йўҳгҖӮ 2. еҰӮжһңжҳҜзҪ‘з»ңзҡ„й—®йўҳпјҢеҲҷйҖҡиҝҮдёҚж–ӯеҠ еӨ§ж ·жң¬зҡ„еӨҚжқӮеәҰе’Ңи°ғж•ҙзҪ‘з»ңпјҲи°ғж•ҙжӢҹеҗҲиғҪеҠӣпјүжқҘж”№еҸҳгҖӮ 3. еҸӮж•°зҡ„еҫ®и°ғпјҢжҲ‘дёӘдәәж„ҹи§үжҳҜеңЁзҪ‘з»ңзҡ„жӢҹеҗҲиғҪеҠӣе’Ңж ·жң¬зҡ„еӨҚжқӮеәҰеҢ№й…Қзҡ„жғ…еҶөдёӢпјҢе°ұжҳҜеҸҜд»ҘtrainеҲ°дёҖе®ҡж°ҙе№іпјҢ然еҗҺжғіиҝӣиЎҢиҝӣдёҖжӯҘдјҳеҢ–зҡ„ж—¶еҖҷйҮҮз”ЁгҖӮ 4. еҸӮж•°зҡ„еҫ®и°ғпјҢжҘјдёҠиҜҙеҫ—еҮ дёӘд№ҹз®—жҳҜдёҖз§ҚжҖқи·Ҝеҗ§пјҢе…¶д»–зҡ„йқ иҮӘе·ұеҺ»з§ҜзҙҜпјҢеҸҰеӨ–е°ҶweightsеҸҜи§ҶеҢ–д№ҹжҳҜдёҖдёӘз»Ҷи°ғиө·жқҘеҸҜд»Ҙз”Ёзҡ„ж–№жі•пјҢзҺ°еңЁdigits tfйҮҢйқўйғҪжңүзӣёе…ізҡ„е·Ҙе…·.

в– зҪ‘еҸӢ

з”Ёзҡ„жҳҜдәӨеҸүзҶөcross_entropy = -tf.reduce_sum(y_*tf.log(y_conv))зҡ„иҜқпјҢжңҖеҗҺsoftmaxеұӮиҫ“еҮәy_convзҡ„еҸ–еҖјиҢғеӣҙеңЁйЎөе°ұжҳҜиҜҙе…Ғи®ёеҸ–0еҖјпјҢжңүlog(0)еҮәзҺ°еҫҲжңүеҸҜиғҪеҮәзҺ°nanе•ҠпјҢcross_entropy = -tf.reduce_mean(y_*tf.log(tf.clip_by_value(y_conv,1e-15,1.0)))еңЁtensorflowйҮҢеҸҜд»Ҙйҷҗе®ҡдёҖдёӢy_convзҡ„еҸ–еҖјиҢғеӣҙпјҢеҲ«зҡ„жЎҶжһ¶дёҚжё…жҘҡгҖӮ

в– зҪ‘еҸӢ

еҜ№дәҺжҲ‘зҡ„caseпјҢ иҜ•дәҶжүҖжңүеҲ«зҡ„ж–№жі•еҗҺйғҪдёҚз®Ўз”Ё д№ҹжҳҜжһң然еңЁжЈҖжөӢиҫ“е…Ҙж•°жҚ®зҡ„ж—¶еҖҷеҸ‘зҺ°жҹҗеҮ еҚҒдёҮиЎҢйӮЈйҮҢеҸ‘зҺ°дәҶдёҖиЎҢNANпјҢжүҖд»ҘиҜҙ第дёҖжӯҘе…ҲжЈҖжөӢиҫ“е…Ҙж•°жҚ®йҮҢжңүжІЎжңүNANпјҢ然еҗҺеҶҚиҜ•еҲ«зҡ„ж–№жі•гҖӮ

в– зҪ‘еҸӢ

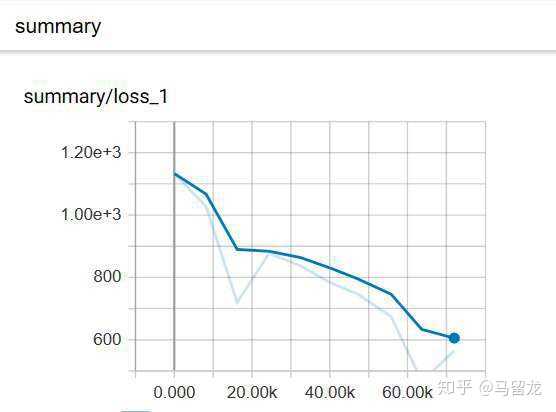

и·‘йЈһдәҶеҗ§пјҢж•°жҚ®еӨӘеӨ§дәҶпјҢе·Із»Ҹи¶…иҝҮдәҶ规е®ҡзҡ„жһҒйҷҗ--------------------------------------------------жҲ‘жҳҜеҲҶеүІзәҝ--------------------------------lossеҮәзҺ°NanпјҢиҜҙжҳҺдҪ зҡ„lossе·Із»ҸеҸ‘ж•ЈдәҶгҖӮдёӢйқўжҳҜдёҖзӮ№дёӘдәәз»ҸйӘҢпјҢж— зҗҶи®әжҢҮеҜјпјҢж¬ўиҝҺжқҝз –гҖӮи§ЈеҶіеҠһжі•пјҡ1гҖҒеҮҸе°Ҹж•ҙдҪ“еӯҰд№ зҺҮгҖӮеӯҰд№ зҺҮжҜ”иҫғеӨ§зҡ„ж—¶еҖҷпјҢеҸӮж•°еҸҜиғҪover shootдәҶпјҢз»“жһңе°ұжҳҜжүҫдёҚеҲ°жһҒе°ҸеҖјзӮ№гҖӮеҮҸе°ҸеӯҰд№ зҺҮеҸҜд»Ҙи®©еҸӮж•°жңқзқҖжһҒеҖјзӮ№еүҚиҝӣгҖӮ2гҖҒж”№еҸҳзҪ‘з»ңе®ҪеәҰгҖӮжңүеҸҜиғҪжҳҜзҪ‘з»ңеҗҺйқўзҡ„еұӮеҸӮж•°жӣҙж–°ејӮеёёпјҢеўһеҠ еҗҺйқўеұӮзҡ„е®ҪеәҰиҜ•иҜ•гҖӮ3гҖҒеўһеҠ зҪ‘з»ңеұӮж•°гҖӮ4гҖҒж”№еҸҳеұӮзҡ„еӯҰд№ зҺҮгҖӮжҜҸдёӘеұӮйғҪеҸҜд»Ҙи®ҫзҪ®еӯҰд№ зҺҮпјҢеҸҜд»Ҙе°қиҜ•еҮҸе°ҸеҗҺйқўеұӮзҡ„еӯҰд№ зҺҮиҜ•иҜ•гҖӮ

в– зҪ‘еҸӢ

жңҖиҝ‘еңЁи®ӯз»ғејәеҢ–еӯҰд№ зҪ‘з»ңж—¶зў°еҲ°иҝҮlossдёәnanзҡ„жғ…еҶөпјҢжіЁж„Ҹз”ЁtensorflowеҒҡsoftmaxеҫ—еҲ°nanеҗҺдёҚдјҡжҠҘй”ҷпјҢеҸҜд»ҘжҠҠз»“жһңиҫ“еҮәжқҘи§ӮеҜҹгҖӮ

и®ӯз»ғзҡ„жҳҜa3cзҪ‘з»ңпјҢеӣ дёәзЁӢеәҸдёҺзҺҜеўғдәӨдә’жҜ”иҫғж…ўпјҢе°ұе…Ҳз”Ёдј з»ҹз®—жі•еҫ—еҲ°ж ҮзӯҫпјҢ然еҗҺз”Ёзӣ‘зқЈеӯҰд№ и®ӯз»ғзӯ–з•ҘзҪ‘з»ңпјҢеҫ—еҲ°жҜ”иҫғеҘҪзҡ„еҲқеҖјд»ҘеҠ йҖҹи®ӯз»ғгҖӮеҠ иҪҪи®ӯз»ғеҘҪзҡ„зӯ–з•ҘзҪ‘з»ңи·‘ејәеҢ–еӯҰд№ дёҚд№…е°ұеҮәзҺ°дәҶnanпјҢжҠҳи…ҫдәҶеҘҪд№…жңҖеҗҺи§ЈеҶідәҶпјҢжҖ»з»“жңүиҝҷд№ҲеҮ зӮ№пјҡ

policy lossдёәдәӨеҸүзҶөпјҢеӣ жӯӨйңҖиҰҒеҜ№policyеҒҡclipпјҢеҗҢж—¶еҜ№жўҜеәҰи®ҫзҪ®дәҶдёҠйҷҗ40пјҢйҒҝе…ҚжўҜеәҰзҲҶзӮёпјӣе…ідәҺж•°жҚ®зҡ„еӨ„зҗҶпјҢжҘјдёҠиҜҙиҰҒйҒҝе…Қи„Ҹж•°жҚ®пјҢиҝҳжңүеҒҡBatch NormalizationгҖӮиҝҷдёӘе…¶е®һеңЁеҲҡејҖе§Ӣе°ұз”ЁдәҶпјҢеӣ дёәдёҖејҖе§Ӣзӯ–з•ҘзҪ‘з»ңжҖ»жҳҜиҫ“еҮәдёҖдёӘзү№е®ҡзҡ„actionпјҢжғідәҶдёӢеә”иҜҘжҳҜstateйҮҢжңүж—¶й—ҙеәҸеҲ—пјҢиҝҷдёӘеҖјдёҖзӣҙеўһеӨ§дҪҝеҫ—зҪ‘з»ңи¶Ҡи¶Ӣеҗ‘дәҺиҫ“еҮәйӮЈдёӘзү№е®ҡзҡ„actionгҖӮеҒҡдәҶBNеҗҺпјҢиҝҷз§Қжғ…еҶөз«ӢеҲ»е°ұж¶ҲеӨұдәҶпјҢеҪ“зҪ‘з»ңи®ӯз»ғдёҚдёӢеҺ»ж—¶BNзЎ®е®һжҳҜеҲ©еҷЁпјӣеҮҸе°ҸеӯҰд№ зҺҮгҖӮзҪ‘з»ңеҮәзҺ°nanеҗҺдёҖзӣҙеҮҸе°ҸеӯҰд№ зҺҮеҲ°1e-7еҗҺе°ұж¶ҲеӨұдәҶпјӣж”№иҝӣзҪ‘з»ңгҖӮзӣ‘зқЈеӯҰд№ дёӯеӯҰд№ зҺҮдёә1e-4е°ұеҫҲе°ҸдәҶпјҢиҖҢиҝҷйҮҢзӣҙеҲ°1e-7жүҚдёҚдјҡеҮәзҺ°nanпјҢ并且зӣ‘зқЈеӯҰд№ е·Із»Ҹеҫ—еҲ°дәҶжҜ”иҫғеҗҲзҗҶзҡ„жқғйҮҚеҖјпјҢиҖҢејәеҢ–еӯҰд№ и®ӯз»ғдёҚд№…е°ұеҮәзҺ°дәҶnanпјҢиҜҙжҳҺзҪ‘з»ңз»“жһ„дёҚеҗҲзҗҶпјҢиҝҮдәҺз®ҖеҚ•гҖӮеӣ дёәstateз”Ёзҡ„жҳҜеәҸеҲ—ж•°жҚ®пјҢжҲ‘еҠ дәҶеҮ еұӮ1D-CNNпјҢйҮҚж–°зӣ‘зқЈеӯҰд№ и®ӯз»ғзӯ–з•ҘзҪ‘з»ңпјҢеҠ иҪҪжқғйҮҚеҗҺи·‘ејәеҢ–еӯҰд№ пјҢlossејҖе§ӢдёӢйҷҚпјҢеҶҚд№ҹжІЎжңүеҮәзҺ°иҝҮnanгҖӮ

жңҖеҗҺеҶҚиҜҙдёҖзӮ№пјҢеҫҲеӨҡж—¶еҖҷеҮәзҺ°жҜ”иҫғеҘҮжҖӘзҡ„з»“жһңиҰҒеҶҚжЈҖжҹҘжЈҖжҹҘзЁӢеәҸйҖ»иҫ‘пјҢжҜ”еҰӮstateе’ҢlabelжҳҜеҗҰеҜ№еә”гҖӮжҲ‘жңүж®өж—¶й—ҙи®ӯз»ғa3cзҪ‘з»ңlossдёҖзӣҙдёҚйҷҚпјҢжңҖеҗҺеҸ‘зҺ°зҠҜдәҶдёҖдёӘеҫҲдҪҺзә§зҡ„й”ҷиҜҜпјҢa3cдёӯдёәдәҶдҪҝеҫ—и®ӯз»ғзЁіе®ҡпјҢйҖҡеёёи®ҫзҪ®дёҖдёӘglobal networkжқҘеҒҡжўҜеәҰзҡ„жӣҙж–°пјҢиҖҢе…¶д»–local networkиҙҹиҙЈдёҺзҺҜеўғдәӨдә’收йӣҶж•°жҚ®пјҢеҫ—еҲ°жўҜеәҰгҖӮиҖҢеңЁдёҖдёӘepisodeејҖе§Ӣд№ӢеүҚlocal networkд»Һglobal networkдёӯеҫ—еҲ°жңҖж–°жқғйҮҚпјҢи·‘иҝҷдёӘepisodeж—¶дёҺglobal networkжІЎжңүдәӨдә’пјҢе“ӘжҖ•е…¶д»–зәҝзЁӢзҡ„local networkеҫ—еҲ°дәҶжўҜеәҰ并жӣҙж–°дәҶglobal networkгҖӮиҝҷж ·еҸҜд»ҘдҝқиҜҒи®ӯз»ғзҡ„зЁіе®ҡжҖ§пјҢжңүзӮ№еғҸDQNдёӯзҡ„target networkгҖӮиҖҢжҲ‘жҠҠиҝҷдёӨдёӘзҡ„йЎәеәҸеҶҷеҸҚдәҶпјҢд№ҹе°ұжҳҜе…¶е®һжқғйҮҚж №жң¬е°ұжІЎжңүжӣҙж–°иҝҮпјҢд№ҹе°ұдёҚеҘҮжҖӘlossдёҖзӣҙйңҮиҚЎпјҢз»ҙжҢҒеңЁдёҖдёӘеҹәжң¬еҖјйҷ„иҝ‘гҖӮ

жҺЁиҚҗйҳ…иҜ»

- еӣӣе·қд№җеұұеёӮзҠҚдёәеҺҝеҸ‘з”ҹ4.2зә§ең°йңҮйңҮжәҗж·ұеәҰ13еҚғзұі

- еӣӣе·қиҮӘиҙЎеёӮиҚЈеҺҝеҸ‘з”ҹ3.2зә§ең°йңҮйңҮжәҗж·ұеәҰ10еҚғзұі

- гҖҺеҸ—дјӨгҖҸи·Ёи¶Ҡ1700е…¬йҮҢеҚ—дә¬жұӮеҢ» жҸҗйҶ’пјҡеҲ«е°ҸзңӢжүӯдјӨгҖҒжӢүдјӨ жҳҶжҳҺж¶ҲйҳІе‘ҳи®ӯз»ғдёӯеҸ—дјӨ

- еӣӣе·қеҫ·йҳіеёӮз»өз«№еёӮеҸ‘з”ҹ3.4зә§ең°йңҮйңҮжәҗж·ұеәҰ8еҚғзұі

- зҺ°еңЁеңЁзәҝеӯҰд№ и§Ҷйў‘жңүеҫҲеӨҡдәҶпјҢдёәе•ҘеӨ§йғЁеҲҶдәәиҝҳжҳҜе–ңж¬ўдёӢиҪҪдёӢжқҘи§ӮзңӢ

- жҚўдёӘи§’еәҰзңӢиҪҰеёӮ|ж·ұеәҰпјҡй•ҝеҹҺзӮ®и¶ҠйҮҺзҡ®еҚЎ1.5дёҮе…¬йҮҢй•ҝжөӢд№ӢжҠҖжңҜзҠ¶жҖҒжұҮжҖ»

- е©ҙе„ҝ|зҫҺеӣҪе„ҝ科еӯҰдјҡпјҡ 1еІҒд»ҘдёӢе©ҙе„ҝдёҚжҺЁиҚҗеӯҰд№ жёёжіі

- ж–°з–Ҷе…ӢеӯңеӢ’иӢҸе·һйҳҝе…Ӣйҷ¶еҺҝеҸ‘з”ҹ3.3зә§ең°йңҮ йңҮжәҗж·ұеәҰ140еҚғзұі

- еңЁзҫҺеӣҪеӨ§еӯҰеӯҰд№ computer science жҳҜе•Ҙж ·зҡ„дҪ“йӘҢ

- дҪңдёәиҪҜ件е·ҘзЁӢеӨ§дәҢзҡ„еӯҰз”ҹпјҢеӯҰд№ дёҖиҲ¬пјҢзј–зЁӢдёҖиҲ¬пјҢжҜ•дёҡеҗҺиғҪе№Ідәӣе•Ҙ