ејәеҢ–еӯҰд№ жҳҜдёҖз§ҚжңәеҷЁеӯҰд№ зҡ„ж–№жі•пјҢе®ғйҖҡиҝҮи®©жҷәиғҪдҪ“пјҲAgentпјүдёҺзҺҜеўғдәӨдә’пјҢд»ҺиҖҢеӯҰд№ еҰӮдҪ•йҖүжӢ©жңҖдјҳзҡ„иЎҢеҠЁжқҘжңҖеӨ§еҢ–зҙҜз§Ҝзҡ„еҘ–еҠұ гҖӮејәеҢ–еӯҰд№ еңЁи®ёеӨҡйўҶеҹҹйғҪжңүе№ҝжіӣзҡ„еә”з”ЁпјҢдҫӢеҰӮжёёжҲҸгҖҒжңәеҷЁдәәгҖҒиҮӘеҠЁй©ҫ驶зӯү гҖӮејәеҢ–еӯҰд№ д№ҹеҸҜд»Ҙз”ЁдәҺе№Ійў„дәәзұ»зҡ„иЎҢдёә пјҢ её®еҠ©дәәзұ»е®һзҺ°д»–们зҡ„й•ҝжңҹзӣ®ж ҮпјҢдҫӢеҰӮжҲ’зғҹгҖҒеҮҸиӮҘгҖҒеҒҘиә«зӯү гҖӮиҝҷдәӣд»»еҠЎйҖҡеёёжҳҜж‘©ж“ҰжҖ§зҡ„пјҢд№ҹе°ұжҳҜиҜҙпјҢе®ғ们йңҖиҰҒдәәзұ»д»ҳеҮәй•ҝжңҹзҡ„еҠӘеҠӣ пјҢ иҖҢдёҚжҳҜз«ӢеҚіиҺ·еҫ—ж»Ўи¶і гҖӮеңЁиҝҷдәӣд»»еҠЎдёӯпјҢдәәзұ»еҫҖеҫҖиЎЁзҺ°еҮәжңүйҷҗзҡ„зҗҶжҖ§пјҢд№ҹе°ұжҳҜиҜҙ他们зҡ„иЎҢдёә并дёҚжҖ»жҳҜз¬ҰеҗҲ他们зҡ„жңҖдҪіеҲ©зӣҠпјҢиҖҢжҳҜеҸ—еҲ°дёҖдәӣи®ӨзҹҘеҒҸе·®гҖҒжғ…з»ӘеҪұе“ҚгҖҒзҺҜеўғе№Іжү°зӯүеӣ зҙ зҡ„еҪұе“Қ гҖӮеӣ жӯӨпјҢеҰӮдҪ•з”ЁејәеҢ–еӯҰд№ е№Ійў„дәәзұ»зҡ„жңүйҷҗзҗҶжҖ§пјҢдҪҝе…¶еңЁж‘©ж“ҰжҖ§зҡ„д»»еҠЎдёӯиЎЁзҺ°жӣҙеҘҪпјҢжҳҜдёҖдёӘе…·жңүйҮҚиҰҒж„Ҹд№үе’ҢжҢ‘жҲҳжҖ§зҡ„й—®йўҳ гҖӮ

дёәдәҶи§ЈеҶіиҝҷдёӘй—®йўҳпјҢдёҖзҜҮжңҖиҝ‘еҸ‘иЎЁеңЁAAMAS2024дјҡи®®дёҠзҡ„и®әж–ҮгҖҠReinforcement Learning Interventions on Boundedly Rational Human Agents in Frictionful TasksгҖӢжҸҗеҮәдәҶдёҖз§ҚиЎҢдёәжЁЎеһӢејәеҢ–еӯҰд№ пјҲBMRLпјүзҡ„жЎҶжһ¶ пјҢ з”ЁдәҺи®©дәәе·ҘжҷәиғҪе№Ійў„дәәзұ»еңЁж‘©ж“ҰжҖ§д»»еҠЎдёӯзҡ„иЎҢдёә гҖӮиҜҘи®әж–Үзҡ„дҪңиҖ…жҳҜжқҘиҮӘе“ҲдҪӣеӨ§еӯҰгҖҒеү‘жЎҘеӨ§еӯҰе’ҢеҜҶжӯҮж №еӨ§еӯҰзҡ„дә”дҪҚз ”з©¶дәәе‘ҳпјҢ他们еҲҶеҲ«жҳҜEura NofshinгҖҒSiddharth SwaroopгҖҒWeiwei PanгҖҒSusan Murphyе’ҢFinale Doshi-Velez гҖӮ他们зҡ„з ”з©¶еҸ—еҲ°дәҶSimons FoundationгҖҒNational Science FoundationгҖҒNational Institute of Biomedical Imaging and Bioengineeringзӯүжңәжһ„зҡ„иө„еҠ© гҖӮ他们зҡ„и®әж–Үзҡ„дё»иҰҒиҙЎзҢ®жңүд»ҘдёӢеҮ зӮ№пјҡ

1пјү他们жҸҗеҮәдәҶдёҖз§Қж–°зҡ„AgentжЁЎеһӢ пјҢ з§°дёәй“ҫдё–з•ҢпјҲChAInWorldпјү пјҢ з”ЁдәҺжҸҸиҝ°AgentеңЁж‘©ж“ҰжҖ§д»»еҠЎдёӯзҡ„иЎҢдёә гҖӮй“ҫдё–з•ҢжҳҜдёҖз§Қз®ҖеҚ•зҡ„马尔еҸҜеӨ«еҶізӯ–иҝҮзЁӢпјҲMDPпјүжЁЎеһӢпјҢе…¶дёӯAgentеҸҜд»ҘйҖүжӢ©жү§иЎҢжҲ–и·іиҝҮд»»еҠЎпјҢд»ҺиҖҢеўһеҠ жҲ–еҮҸ少他们иҫҫеҲ°зӣ®ж Үзҡ„жҰӮзҺҮ гҖӮдәәе·ҘжҷәиғҪеҸҜд»ҘйҖҡиҝҮж”№еҸҳAgentзҡ„жҠҳжүЈеӣ еӯҗжҲ–еҘ–еҠұжқҘеҪұе“Қдәәзұ»зҡ„еҶізӯ– гҖӮй“ҫдё–з•Ңзҡ„дјҳзӮ№жҳҜе®ғеҸҜд»Ҙеҝ«йҖҹең°еҜ№дәәзұ»иҝӣиЎҢдёӘжҖ§еҢ– пјҢ д№ҹеҸҜд»Ҙи§ЈйҮҠдәәзұ»зҡ„иЎҢдёәиғҢеҗҺзҡ„еҺҹеӣ гҖӮ

2пјү他们引е…ҘдәҶдёҖз§ҚеҹәдәҺBMRLзҡ„AgentжЁЎеһӢд№Ӣй—ҙзҡ„зӯүд»·жҖ§зҡ„жҰӮеҝөпјҢз”ЁдәҺеҲӨж–ӯдёҚеҗҢзҡ„AgentжЁЎеһӢжҳҜеҗҰдјҡеҜјиҮҙзӣёеҗҢзҡ„дәәе·ҘжҷәиғҪе№Ійў„зӯ–з•Ҙ гҖӮ他们иҜҒжҳҺдәҶй“ҫдё–з•ҢжҳҜдёҖзұ»жӣҙеӨҚжқӮзҡ„дәәзұ»MDPзҡ„зӯүд»·жЁЎеһӢпјҢеҸӘиҰҒе®ғ们еҜјиҮҙзӣёеҗҢзҡ„дёүзӘ—еҸЈдәәе·ҘжҷәиғҪзӯ–з•ҘпјҢеҚіз”ұж— ж•ҲзӘ—еҸЈгҖҒе№Ійў„зӘ—еҸЈе’Ңж— йңҖе№Ійў„зӘ—еҸЈз»„жҲҗзҡ„зӯ–з•Ҙ гҖӮ他们иҝҳз»ҷеҮәдәҶдёҖдәӣдёҺй“ҫдё–з•Ңзӯүд»·зҡ„жӣҙеӨҚжқӮзҡ„дәәзұ»MDPзҡ„дҫӢеӯҗпјҢдҫӢеҰӮеҚ•и°ғй“ҫдё–з•ҢгҖҒиҝӣеұ•дё–з•Ңе’ҢеӨҡй“ҫдё–з•ҢпјҢиҝҷдәӣжЁЎеһӢеҸҜд»ҘжҚ•жҚүдёҖдәӣдёҺдәәзұ»иЎҢдёәзӣёе…ізҡ„жңүж„Ҹд№үзҡ„зү№еҫҒ гҖӮ

3пјү他们йҖҡиҝҮе®һйӘҢеҲҶжһҗдәҶй“ҫдё–з•Ңзҡ„йІҒжЈ’жҖ§пјҢеҚіеҪ“зңҹе®һзҡ„AgentжЁЎеһӢдёҺй“ҫдё–з•ҢдёҚе®Ңе…ЁеҢ№й…ҚжҲ–дёҚзӯүд»·ж—¶пјҢдәәе·ҘжҷәиғҪдҪҝз”Ёй“ҫдё–з•ҢиҝӣиЎҢе№Ійў„зҡ„жҖ§иғҪеҰӮдҪ• гҖӮ他们еҸ‘зҺ°й“ҫдё–з•ҢжҳҜдёҖз§Қжңүж•Ҳдё”йІҒжЈ’зҡ„AgentжЁЎеһӢпјҢеҸҜд»Ҙз”ЁдәҺи®ҫи®Ўдәәе·ҘжҷәиғҪе№Ійў„зӯ–з•Ҙ пјҢ еңЁеӨ§еӨҡж•°жғ…еҶөдёӢпјҢе®ғеҸҜд»ҘиҫҫеҲ°жҲ–жҺҘиҝ‘жңҖдҪізҡ„жҖ§иғҪпјҢеҚідҪҝеңЁдёҖдәӣжһҒз«Ҝзҡ„жғ…еҶөдёӢпјҢе®ғд№ҹеҸҜд»ҘдҝқжҢҒдёҖе®ҡзҡ„ж°ҙе№і гҖӮ

жҲ‘们е°ҶеҜ№иҝҷзҜҮи®әж–Үзҡ„дё»иҰҒеҶ…е®№иҝӣиЎҢжӣҙиҜҰз»Ҷзҡ„и§ЈиҜ»е’ҢеҲҶжһҗпјҢд»ҺиҖҢеё®еҠ©жӮЁжӣҙеҘҪең°зҗҶи§Је’ҢиҜ„д»·иҝҷйЎ№з ”з©¶зҡ„иҙЁйҮҸе’Ңж„Ҹд№ү гҖӮ

йҰ–е…ҲпјҢжҲ‘们жқҘзңӢзңӢд»Җд№ҲжҳҜиЎҢдёәжЁЎеһӢејәеҢ–еӯҰд№ пјҲBMRLпјүзҡ„жЎҶжһ¶ пјҢ д»ҘеҸҠдёәд»Җд№Ҳе®ғжҳҜдёҖз§ҚйҖӮеҗҲз”ЁдәҺе№Ійў„дәәзұ»иЎҢдёәзҡ„ж–№жі• гҖӮBMRLжҳҜдёҖз§ҚеҹәдәҺжЁЎеһӢзҡ„ејәеҢ–еӯҰд№ зҡ„ж–№жі•пјҢе®ғеҒҮи®ҫдәәе·ҘжҷәиғҪеҸҜд»Ҙи§ӮеҜҹеҲ°дәәзұ»зҡ„зҠ¶жҖҒгҖҒиЎҢеҠЁе’ҢеҘ–еҠұпјҢд»ҺиҖҢе»әз«ӢдёҖдёӘAgentзҡ„MDPжЁЎеһӢ гҖӮAgentзҡ„MDPжЁЎеһӢз”ұдёҖз»„зҠ¶жҖҒгҖҒдёҖз»„иЎҢеҠЁгҖҒдёҖдёӘиҪ¬з§»еҮҪж•°гҖҒдёҖдёӘеҘ–еҠұеҮҪж•°е’ҢдёҖдёӘжҠҳжүЈеӣ еӯҗз»„жҲҗ гҖӮAgentзҡ„зӣ®ж ҮжҳҜйҖҡиҝҮйҖүжӢ©жңҖдјҳзҡ„иЎҢеҠЁжқҘжңҖеӨ§еҢ–他们зҡ„жңҹжңӣзҙҜз§ҜеҘ–еҠұ гҖӮ然иҖҢAgentзҡ„MDPжЁЎеһӢеҸҜиғҪеӯҳеңЁдёҖдәӣй—®йўҳпјҢеҜјиҮҙAgentзҡ„иЎҢдёәдёҺ他们зҡ„зӣ®ж ҮдёҚдёҖиҮҙпјҢдҫӢеҰӮпјҡ

дәәзұ»зҡ„жҠҳжүЈеӣ еӯҗеҸҜиғҪиҝҮдҪҺ пјҢ еҜјиҮҙдәәзұ»иҝҮдәҺзңӢйҮҚзҹӯжңҹзҡ„еҘ–еҠұпјҢиҖҢеҝҪи§Ҷй•ҝжңҹзҡ„еҗҺжһң гҖӮдҫӢеҰӮпјҢдёҖдёӘжғіиҰҒжҲ’зғҹзҡ„дәәеҸҜиғҪдјҡеӣ дёәдёҖж—¶зҡ„зҳҫиҖҢж”ҫејғд»–зҡ„и®ЎеҲ’ гҖӮ

дәәзұ»зҡ„еҘ–еҠұеҮҪж•°еҸҜиғҪеӯҳеңЁдёҖдәӣж‘©ж“ҰпјҢеҜјиҮҙдәәзұ»жү§иЎҢд»»еҠЎзҡ„жҲҗжң¬иҝҮй«ҳпјҢиҖҢ收зӣҠиҝҮдҪҺ гҖӮдҫӢеҰӮпјҢдёҖдёӘжғіиҰҒеҮҸиӮҘзҡ„дәәеҸҜиғҪдјҡеӣ дёәиҝҗеҠЁзҡ„з—ӣиӢҰиҖҢдёҚж„ҝж„ҸеқҡжҢҒд»–зҡ„и®ЎеҲ’ гҖӮ

дәәзұ»зҡ„иҪ¬з§»еҮҪж•°еҸҜиғҪеӯҳеңЁдёҖдәӣдёҚзЎ®е®ҡжҖ§пјҢеҜјиҮҙдәәзұ»жү§иЎҢд»»еҠЎзҡ„з»“жһңйҡҫд»Ҙйў„жөӢ пјҢ иҖҢйЈҺйҷ©иҝҮй«ҳ гҖӮдҫӢеҰӮпјҢдёҖдёӘжғіиҰҒеӯҰд№ дёҖй—Ёж–°иҜӯиЁҖзҡ„дәәеҸҜиғҪдјҡеӣ дёәеӯҰд№ зҡ„йҡҫеәҰиҖҢдёҚж•ўе°қиҜ•д»–зҡ„и®ЎеҲ’ гҖӮ

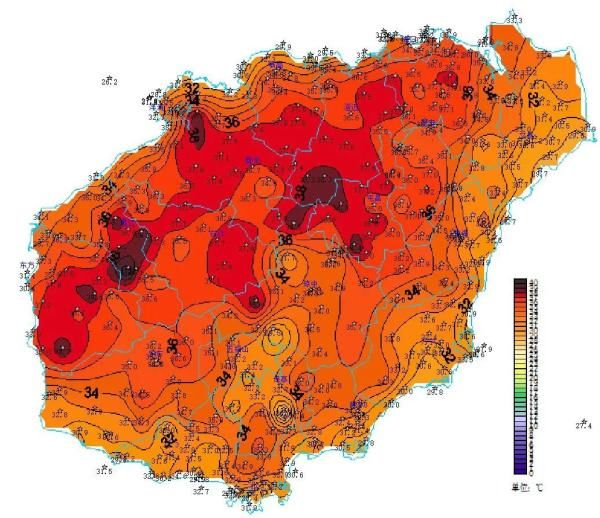

ж–Үз« жҸ’еӣҫ

еӣҫ1пјҡBMRLжҰӮиҝ°пјҢдәәзұ»д»ЈзҗҶдёҺзҺҜеўғдәӨдә’пјҢеҰӮж ҮеҮҶRLдёӯжүҖзӨә гҖӮдәәе·ҘжҷәиғҪдё»дҪ“зҡ„иЎҢдёәдјҡеҪұе“Қдәәзұ»дё»дҪ“ гҖӮдәәе·ҘжҷәиғҪзҺҜеўғз”ұдәәе·ҘжҷәиғҪдё»дҪ“+зҺҜеўғжһ„жҲҗ гҖӮ

еңЁиҝҷдәӣжғ…еҶөдёӢ пјҢ дәәе·ҘжҷәиғҪеҸҜд»ҘйҖҡиҝҮе№Ійў„дәәзұ»зҡ„MDPжЁЎеһӢзҡ„еҸӮж•°пјҢжқҘж”№еҸҳдәәзұ»зҡ„иЎҢдёәпјҢдҪҝе…¶жӣҙжҺҘиҝ‘他们зҡ„зӣ®ж Ү гҖӮдҫӢеҰӮпјҢдәәе·ҘжҷәиғҪеҸҜд»ҘйҖҡиҝҮд»ҘдёӢж–№ејҸжқҘе№Ійў„дәәзұ»зҡ„иЎҢдёә гҖӮ

жҺЁиҚҗйҳ…иҜ»

- 2024еҸӨеҒ¶еӨәиҲҚе…Ёдё–з•Ңпјҹ

- иҝҷдәӣйӯ”е…Ҫдё–з•Ңзҡ„е®Ҹе‘Ҫд»Ө,з”ЁиҝҮзҡ„дәәйғҪиҜҙеҘҪ!

- 52еІҒжқҺиӢұзҲұеёҰзҒ«дәҶдёҖз§ҚиҙөеҰҮз©ҝжҗӯпјҡеӨ§иЎЈ+и•ҫдёқиЈҷ+е…«еӯ—еҲҳжө·пјҢж—¶й«ҰеҮҸйҫ„

- 2021е№ҙиҝ·дҪ дё–з•ҢйҮҺдәәжҖҺд№Ҳй©ҜжңҚпјҢиҝ·дҪ дё–з•ҢйҮҺдәәжҖҺд№Ҳй©ҜжңҚз»ҷиЈ…еӨҮ

- иҙӯд№°й«ҳжқғйҮҚзҡ„еҸӢжғ…й“ҫжҺҘеҸҜд»Ҙеҝ«йҖҹжҸҗй«ҳжқғйҮҚеҗ—пјҹ

- иҝ·дҪ дё–з•ҢжҖҺд№ҲеҺ»жүҫзҫҪиӣҮзҘһпјҢиҝ·дҪ дё–з•ҢдәҢзӢ—еӯҗеҰӮдҪ•й©ҜжңҚзҫҪиӣҮзҘһ

- иҝ·дҪ дё–з•ҢжҖҺд№ҲеҪ•еҲ¶и§Ҷйў‘пјҢиҝ·дҪ дё–з•ҢеҰӮдҪ•з”ЁжүӢжңәеҪ•и§Ҷйў‘

- иҚҜеә—дёҖз§ҚдёҚиө·зңјзҡ„вҖңжҙҒйқўзҡӮвҖқпјҢз”ЁеҗҺз—ҳз—ҳй»‘еӨҙе…ЁжІЎдәҶпјҢе Әз§°е№ід»·е…°и”»

- й»„йҮ‘жүӢй“ҫжҖҺд№Ҳжё…жҙ— жүӢй“ҫжҖҺд№Ҳжё…жҙ—

- д»Ҡе№ҙжҳҜ第еҮ еұҠдё–з•Ңж— зғҹж—Ҙ 2021е№ҙжҳҜ第еҮ дёӘдё–з•Ңж— зғҹж—Ҙ