5.2 LLM中 token 的长度限制与应对像 GPT-3/4 , LLaMA等这样的大模型有一个最大token 数量限制,超过这个限制 , 它们就不能接受输入或生成输出 。

文章插图

图片

一般地,我们可以尝试以下方法来解决token长度限制的问题:截断截断涉及删除输入文本的一部分以适应令牌限制 。这可以通过删除文本的开头或结尾,或两者的组合来完成 。然而,截断可能导致重要信息的丢失,并可能影响所产生的产出的质量和一致性 。

抽样抽样是一种从输入文本中随机选择标记子集的技术 。这允许您在输入中保留一些多样性,并且可以帮助生成不同的输出 。然而,这种方法(类似于截断)可能会导致上下文信息的丢失,并降低生成输出的质量 。

重组另一种方法是将输入文本分割成符号限制内的较小块或段,并按顺序处理它们 。通过这种方式,可以独立处理每个块,并且可以连接输出以获得最终结果 。

编解码编码和解码是常见的自然语言处理技术,它们将文本数据转换为数字表示,反之亦然 。这些技术可用于压缩、解压缩、截断或展开文本以适应语言模型的标记限制 。这种方法需要额外的预处理步骤,可能会影响生成输出的可读性 。

微调微调允许使用较少的特定任务数据来调整预先训练好的语言模型以适应特定任务或领域 。可以利用微调来解决语言模型中的标记限制,方法是训练模型预测一系列文本中的下一个标记,这些文本被分块或分成更小的部分 , 每个部分都在模型的标记限制范围内 。

6. token 相关技术的展望虽然token传统上代表文本单位,但是token的概念正在超越语言要素的范畴 。最近的进展探索了其他模式(如图像、音频或视频)的标记,允许 LLM 与这些模式一起处理和生成文本 。这种多模式方法为在丰富多样的数据源背景下理解和生成文本提供了新的机会 。它使 LLM 能够分析图像标题,生成文本描述,甚至提供详细的音频转录 。

文章插图

图片

tokenization领域是一个动态和不断发展的研究领域 。未来的进步可能集中于解决tokenization的局限性 , 改进 OOV 处理,并适应新兴语言和文本格式的需要 。而且 , 将继续完善tokenization技术,纳入特定领域的知识,并利用上下文信息来增强语义理解 。tokenization的不断发展将进一步赋予 LLM 以更高的准确性、效率和适应性来处理和生成文本 。

7.小结Token是支持 LLM 语言处理能力的基本构件 。理解token在 LLM 中的作用,以及tokenization方面的挑战和进步,使我们能够充分发挥这些模型的潜力 。随着继续探索token的世界,我们将彻底改变机器理解和生成文本的方式,推动自然语言处理的边界,促进各个领域的创新应用 。

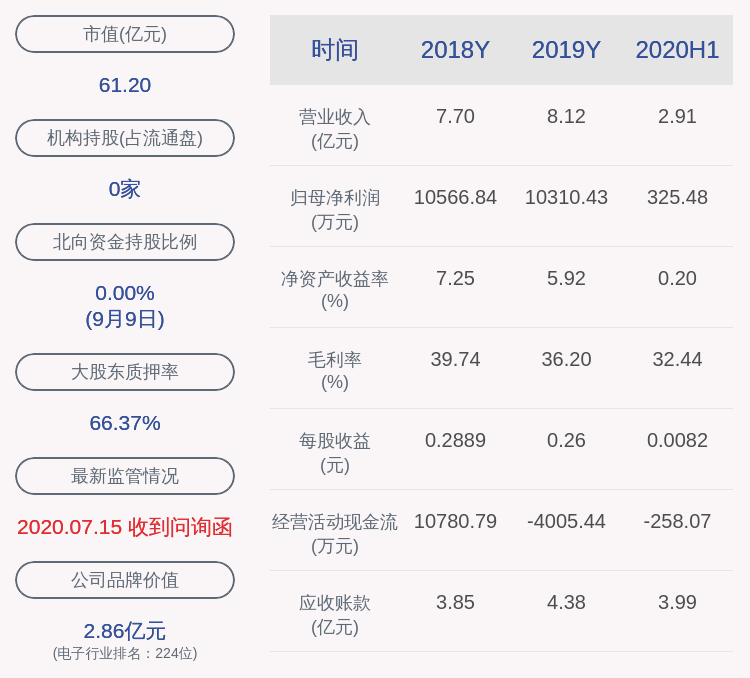

PS. One more thing, 我们在开发大模型应用时应该了解的一些数字如下:

文章插图

图片

【参考资料】

- https://Python/ target=_blank class=infotextkey>Python.langchain.com/docs

- https://blog.langchain.dev/

- OpenAI: What are tokens and how to count them? , https://help.openai.com/en/articles/4936856-what-are-tokens-and-how-to-count-them

- Predicting Million-byte Sequences with Multiscale Transformers,https://arxiv.org/pdf/2305.07185.pdf

- https://learn.microsoft.com/en-us/semantic-kernel/prompt-engineering/tokens

- https://www.anyscale.com/blog/num-every-llm-developer-should-know

【LLM 解读大模型的token】

推荐阅读

- 生成式AI与大模型有什么区别和联系?

- 为何有的男性会被称为“油腻大叔”?看女性怎么解读

- 揭秘大模型背后的知识储存与提取技术

- 大模型助力高效创建知识图谱

- LLM的工程实践思考

- 如何构建基于大模型的App

- 人工智能大模型布局千行百业

- 数据标注员,困在大模型里

- 大模型可解释性你能理得清吗?综述已来,一文解你疑惑

- 多模态大模型最全综述来了!7位微软研究员大力合作,5大主题,成文119页