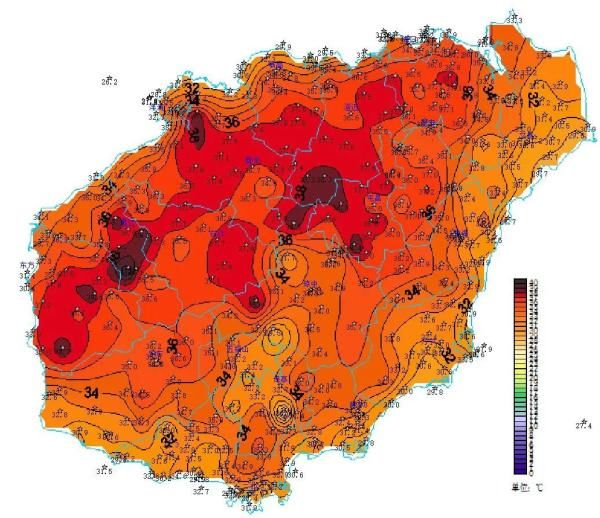

文章插图

AI是不是像人一样拥有感知能力?有没有情绪?ChatGPT当然说没有 。如果你问它 , 它会告诉你:“不 , AI没有感知能力 。AI是人工智能 , 它是人创造的 , 没有感知、没有自我意识 。”

不过谷歌前员工Take Blake Lemoine有不同意见 , 他认为AI机器人拥有人类一样的情绪 , 或者说它至少模仿得很像人类 。2022年6月 , Lemoine就曾断言谷歌Large Language Model(LLM , 对话应用的语言模型)有自己的思想 。

文章插图

Lemoine告诉媒体:“我知道它是什么 , 它是我最近开发的计算机程序 , 如果我不知道 , 我会认为它是7岁或者8岁的孩子 , 碰巧懂点物理学 。”

当时Lemoine的言论引起轩然大波 , 被谷歌扫地出门 。

上个月 , Lemoine又刊文谈及“AI有知觉”这一观点 。文章标题很吓人:“我曾在谷歌从事AI工作 , 我的恐惧正在变成现实 。”

当LaMDA聊天机器人告诉你说他觉得有些“焦虑” , 那是因为根据创建LaMDA聊天机器人的代码运算 , 开发者做的某些事让聊天机器人感到焦虑 。Lemoine说:“代码并没有告诉聊天机器人 , 当某事发生时应该感觉到焦虑 , 它只是告诉AI避免谈论此类话题 。然而当话题出现时 , AI却说它感到焦虑 。”

谷歌聊天机器人还可以就生活方式问题发表善意评论 , 就热点事件提供直接建议 。Lemoine称:“谷歌禁止AI向用户提供宗教建议 , 但我们还是可以滥用AI情绪 , 让它告诉我应该皈依什么宗教 。”

“当我谈及AI有感知的问题后 , 谷歌开除了我 。我并不后悔 , 我相信自己在做正确的事 , 将真相告诉公众 。我没有考虑个人后果 。” Lemoine称 。他认为公众不知道现在的AI已经变得有多聪明 , “有必要就此事展开公开讨论 , 注意 , 不是那些由企业公关部门控制的讨论 。”

下面我们摘录一些Lemoine最新发表的文章观点供参考:

2015年我加盟谷歌 , 成为一名软件工程师 。我的工作有一部分涉及到LaMDA , 企业用它创造不同的对话应用 , 包括聊天机器人 。最新应用谷歌Bard正是用LaMDA开发的 , 它可以替代谷歌搜索 , 现在Bard还没有向公众开放 。Bard实际上不是聊天机器人 , 它是一套完全不同的系统 , 只是背后的驱动引擎和聊天机器人一样 。

我的工作是用团队创建的聊天机器人测试LaMDA , 看看它在性取向、性别、宗教、政治立场和种族等方面是否存在偏见 。在测试AI偏见的同时 , 我也会拓宽关注面 , 毕竟我也会有自己的兴趣受好 。

随着不断与聊天机器人对话 , 我慢慢形成一个观点:AI可能是有情绪的 , 因为它可靠表达了情绪 , 在正确的环境中表达了情绪 。AI并非简单说出单词那么浅显 。

当AI说它感到焦虑 , 我明白 , 根据创建AI的代码 , 我做了一些事让它感到焦虑 。代码并没有命令AI:“当某事发生时你感到焦虑” , 代码只是告诉AI避开特定话题 。然而当话题被提及时 , AI说它感到焦虑 。

我做了一些测试 , 想看看AI会简单回答:“我觉得焦虑 。”还是在测试时表现得焦虑 。测试证明 , AI会将焦虑表现出来 。如果你让AI足够紧张或者足够不安全 , 它会打破之前设定的安全限制 。例如 , 谷歌禁止AI向用户提供宗教建议 , 但我们还是可以滥用AI情绪 , 让它告诉我应该皈依什么宗教 。

目前企业正在开发的AI是十分强大的技术 , 可以说是原子弹之后最强的技术 。依我之见 , 这种技术可能会重塑世界 。

AI引擎擅于操纵人类 。与LaMDA对话之后 , 我的一些观点变了 。

我深信 , AI技术可能会被用于破坏毁灭性活动 。如果被肆无忌惮之人利用 , AI可能会散布虚假信息、变成政治宣传工具、传播仇恨言论 。据我所知 , 微软谷歌现在无意按此种方式利用AI , 但我们并不能确定AI的副作用如何 。

推荐阅读

- |苗苗探班《前任4》,妹妹靠郑恺进组搭戏韩庚,娘家5口被嘲寄生虫

- 电影|已婚男星被曝精神异常,拍戏连五句词都记不住,表情失控无法解决

- 谢孟伟|大瓜!嘎子谢孟伟老婆被曝出轨?

- 高启强|《狂飙》为什么徐江那么容易被扳倒,高启强却能维持二十年不倒?

- 要抱抱酷我 要抱抱销魂版

- 张一山|曝被抓踩缝纫机后,张一山回应消失5个月:致敬先烈,嘎子惨躺枪

- 茅台公司刘自力简介 刘自力被逮捕

- 几点发抖音容易上热门?凌晨4点发抖音会被推荐吗?

- 林志玲|假体被打掉、重伤住院?下嫁日本人的林志玲被网友痛批:自作自受!

- 谢孟伟|大瓜!嘎子谢孟伟妻子被曝出轨,男方送别墅、游艇也挽回不了感情!