еҮҪж•°ејҖеӨҙзҡ„time_limitе’ҢbudgetжҳҜз”ЁжқҘжҺ§еҲ¶net_rx_actionеҮҪж•°дё»еҠЁйҖҖеҮәзҡ„пјҢзӣ®зҡ„жҳҜдҝқиҜҒзҪ‘з»ңеҢ…зҡ„жҺҘ收дёҚйңёеҚ CPUдёҚж”ҫ гҖӮзӯүдёӢж¬ЎзҪ‘еҚЎеҶҚжңүзЎ¬дёӯж–ӯиҝҮжқҘзҡ„ж—¶еҖҷеҶҚеӨ„зҗҶеү©дёӢзҡ„жҺҘ收数жҚ®еҢ… гҖӮе…¶дёӯbudgetеҸҜд»ҘйҖҡиҝҮеҶ…ж ёеҸӮж•°и°ғж•ҙ гҖӮиҝҷдёӘеҮҪж•°дёӯеү©дёӢзҡ„ж ёеҝғйҖ»иҫ‘жҳҜиҺ·еҸ–еҲ°еҪ“еүҚCPUеҸҳйҮҸsoftnet_dataпјҢеҜ№е…¶poll_listиҝӣиЎҢйҒҚеҺҶ, 然еҗҺжү§иЎҢеҲ°зҪ‘еҚЎй©ұеҠЁжіЁеҶҢеҲ°зҡ„pollеҮҪж•° гҖӮеҜ№дәҺigbзҪ‘еҚЎжқҘиҜҙпјҢе°ұжҳҜigbй©ұеҠЁеҠӣзҡ„igb_pollеҮҪж•°дәҶ гҖӮ

static int igb_poll(struct napi_struct *napi, int budget){ ... if (q_vector->tx.ring) clean_complete = igb_clean_tx_irq(q_vector); if (q_vector->rx.ring) clean_complete &= igb_clean_rx_irq(q_vector, budget); ...}еңЁиҜ»еҸ–ж“ҚдҪңдёӯпјҢigb_pollзҡ„йҮҚзӮ№е·ҘдҪңжҳҜеҜ№igb_clean_rx_irqзҡ„и°ғз”Ё гҖӮ

static bool igb_clean_rx_irq(struct igb_q_vector *q_vector, const int budget){ ... do { /* retrieve a buffer from the ring */ skb = igb_fetch_rx_buffer(rx_ring, rx_desc, skb); /* fetch next buffer in frame if non-eop */ if (igb_is_non_eop(rx_ring, rx_desc)) continue; } /* verify the packet layout is correct */ if (igb_cleanup_headers(rx_ring, rx_desc, skb)) { skb = NULL; continue; } /* populate checksum, timestamp, VLAN, and protocol */ igb_process_skb_fields(rx_ring, rx_desc, skb); napi_gro_receive(&q_vector->napi, skb);}igb_fetch_rx_bufferе’Ңigb_is_non_eopзҡ„дҪңз”Ёе°ұжҳҜжҠҠж•°жҚ®её§д»ҺRingBufferдёҠеҸ–дёӢжқҘ гҖӮдёәд»Җд№ҲйңҖиҰҒдёӨдёӘеҮҪж•°е‘ўпјҹеӣ дёәжңүеҸҜиғҪеё§иҰҒеҚ еӨҡеӨҡдёӘRingBufferпјҢжүҖд»ҘжҳҜеңЁдёҖдёӘеҫӘзҺҜдёӯиҺ·еҸ–зҡ„пјҢзӣҙеҲ°её§е°ҫйғЁ гҖӮиҺ·еҸ–дёӢжқҘзҡ„дёҖдёӘж•°жҚ®её§з”ЁдёҖдёӘsk_buffжқҘиЎЁзӨә гҖӮ收еҸ–е®Ңж•°жҚ®д»ҘеҗҺпјҢеҜ№е…¶иҝӣиЎҢдёҖдәӣж ЎйӘҢпјҢ然еҗҺејҖе§Ӣи®ҫзҪ®sbkеҸҳйҮҸзҡ„timestamp, VLAN id, protocolзӯүеӯ—ж®ө гҖӮжҺҘдёӢжқҘиҝӣе…ҘеҲ°napi_gro_receiveдёӯ:

//file: net/core/dev.cgro_result_t napi_gro_receive(struct napi_struct *napi, struct sk_buff *skb){ skb_gro_reset_offset(skb); return napi_skb_finish(dev_gro_receive(napi, skb), skb);}dev_gro_receiveиҝҷдёӘеҮҪж•°д»ЈиЎЁзҡ„жҳҜзҪ‘еҚЎGROзү№жҖ§пјҢеҸҜд»Ҙз®ҖеҚ•зҗҶи§ЈжҲҗжҠҠзӣёе…ізҡ„е°ҸеҢ…еҗҲ并жҲҗдёҖдёӘеӨ§еҢ…е°ұиЎҢпјҢзӣ®зҡ„жҳҜеҮҸе°‘дј йҖҒз»ҷзҪ‘з»ңж Ҳзҡ„еҢ…ж•°пјҢиҝҷжңүеҠ©дәҺеҮҸе°‘ CPU зҡ„дҪҝз”ЁйҮҸ гҖӮжҲ‘们жҡӮдё”еҝҪз•ҘпјҢзӣҙжҺҘзңӢnapi_skb_finish, иҝҷдёӘеҮҪж•°дё»иҰҒе°ұжҳҜи°ғз”ЁдәҶnetif_receive_skb гҖӮ

//file: net/core/dev.cstatic gro_result_t napi_skb_finish(gro_result_t ret, struct sk_buff *skb){ switch (ret) { case GRO_NORMAL: if (netif_receive_skb(skb)) ret = GRO_DROP; break; ......}еңЁnetif_receive_skbдёӯпјҢж•°жҚ®еҢ…е°Ҷиў«йҖҒеҲ°еҚҸи®®ж Ҳдёӯ гҖӮеЈ°жҳҺпјҢд»ҘдёӢзҡ„3.3, 3.4, 3.5д№ҹйғҪеұһдәҺиҪҜдёӯж–ӯзҡ„еӨ„зҗҶиҝҮзЁӢпјҢеҸӘдёҚиҝҮз”ұдәҺзҜҮе№…еӨӘй•ҝпјҢеҚ•зӢ¬жӢҝеҮәжқҘжҲҗе°ҸиҠӮ гҖӮ

3.3 зҪ‘з»ңеҚҸи®®ж ҲеӨ„зҗҶnetif_receive_skbеҮҪж•°дјҡж №жҚ®еҢ…зҡ„еҚҸи®®пјҢеҒҮеҰӮжҳҜudpеҢ…пјҢдјҡе°ҶеҢ…дҫқж¬ЎйҖҒеҲ°ip_rcv(),udp_rcv()еҚҸи®®еӨ„зҗҶеҮҪж•°дёӯиҝӣиЎҢеӨ„зҗҶ гҖӮ

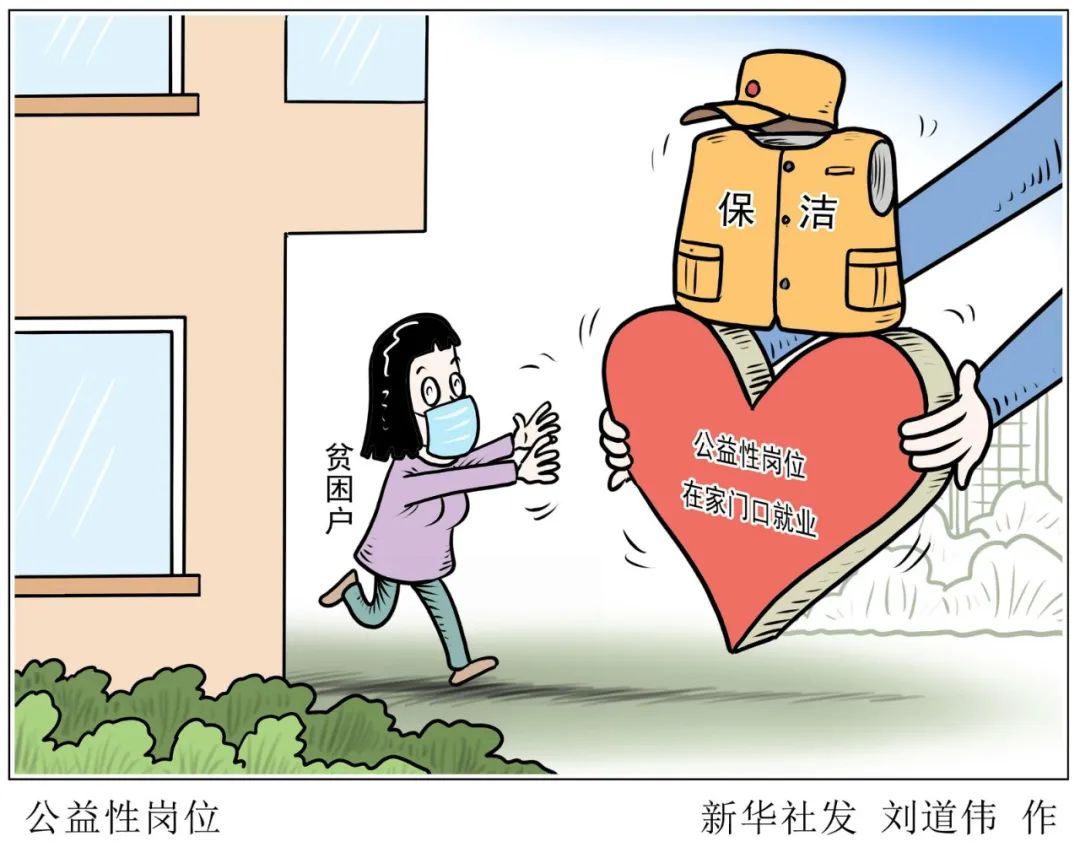

ж–Үз« жҸ’еӣҫ

еӣҫ10 зҪ‘з»ңеҚҸи®®ж ҲеӨ„зҗҶ

//file: net/core/dev.cint netif_receive_skb(struct sk_buff *skb){ //RPSеӨ„зҗҶйҖ»иҫ‘пјҢе…ҲеҝҪз•Ҙ ...... return __netif_receive_skb(skb);}static int __netif_receive_skb(struct sk_buff *skb){ ...... ret = __netif_receive_skb_core(skb, false);}static int __netif_receive_skb_core(struct sk_buff *skb, bool pfmemalloc){ ...... //pcapйҖ»иҫ‘пјҢиҝҷйҮҢдјҡе°Ҷж•°жҚ®йҖҒе…ҘжҠ“еҢ…зӮ№ гҖӮtcpdumpе°ұжҳҜд»ҺиҝҷдёӘе…ҘеҸЈиҺ·еҸ–еҢ…зҡ„ list_for_each_entry_rcu(ptype, &ptype_all, list) { if (!ptype->dev || ptype->dev == skb->dev) { if (pt_prev) ret = deliver_skb(skb, pt_prev, orig_dev); pt_prev = ptype; } } ...... list_for_each_entry_rcu(ptype, &ptype_base[ntohs(type) & PTYPE_HASH_MASK], list) { if (ptype->type == type && (ptype->dev == null_or_dev || ptype->dev == skb->dev || ptype->dev == orig_dev)) { if (pt_prev) ret = deliver_skb(skb, pt_prev, orig_dev); pt_prev = ptype; } }}

жҺЁиҚҗйҳ…иҜ»

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- дёүз§ҚдҪҝз”ЁAIж”»еҮ»зҪ‘з»ңе®үе…Ёзҡ„ж–№жі•

- зҗҶи§ЈдәҶLinux I/OжңәеҲ¶пјҢжүҚиғҪзңҹзҡ„жҳҺзҷҪвҖңд»Җд№ҲжҳҜеӨҡзәҝзЁӢвҖқ

- LinuxзҪ‘з»ңй…ҚзҪ®

- еёҰдҪ йҮҚж–°и®ӨиҜҶLinuxзі»з»ҹзҡ„inode

- еҸӨеү‘еҘҮи°ӯзҪ‘з»ңзүҲйҮҺеӨ–pvp еҸӨеү‘еҘҮи°ӯolеү§жғ…

- д»ҺLinuxжәҗз ҒзңӢSocketзҡ„listenеҸҠиҝһжҺҘйҳҹеҲ—

- linuxзҪ‘з»ңзј–зЁӢеёёи§ҒAPIиҜҰи§Ј

- дәҶи§ЈзҘһз»ҸзҪ‘з»ңе’ҢжЁЎеһӢжіӣеҢ–

- TCP/IP еҹәзЎҖзҹҘиҜҶжҖ»з»“

- еҰӮдҪ•еңЁз”өи„‘дёҠе®үиЈ…зҪ‘з»ңжү“еҚ°жңәпјҹиҜҰз»Ҷж•ҷзЁӢе…ЁйғЁж•ҷз»ҷдҪ