第7жӯҘдёӯпјҢеңЁigb_probeеҲқе§ӢеҢ–иҝҮзЁӢдёӯпјҢиҝҳи°ғз”ЁеҲ°дәҶigb_alloc_q_vector гҖӮд»–жіЁеҶҢдәҶдёҖдёӘNAPIжңәеҲ¶жүҖеҝ…йЎ»зҡ„pollеҮҪж•°пјҢеҜ№дәҺigbзҪ‘еҚЎй©ұеҠЁжқҘиҜҙпјҢиҝҷдёӘеҮҪж•°е°ұжҳҜigb_poll,еҰӮдёӢд»Јз ҒжүҖзӨә гҖӮ

static int igb_alloc_q_vector(struct igb_adapter *adapter, int v_count, int v_idx, int txr_count, int txr_idx, int rxr_count, int rxr_idx){ ...... /* initialize NAPI */ netif_napi_add(adapter->netdev, &q_vector->napi, igb_poll, 64);}2.5 еҗҜеҠЁзҪ‘еҚЎеҪ“дёҠйқўзҡ„еҲқе§ӢеҢ–йғҪе®ҢжҲҗд»ҘеҗҺпјҢе°ұеҸҜд»ҘеҗҜеҠЁзҪ‘еҚЎдәҶ гҖӮеӣһеҝҶеүҚйқўзҪ‘еҚЎй©ұеҠЁеҲқе§ӢеҢ–ж—¶пјҢжҲ‘们жҸҗеҲ°дәҶй©ұеҠЁеҗ‘еҶ…ж ёжіЁеҶҢдәҶ structure net_device_ops еҸҳйҮҸпјҢе®ғеҢ…еҗ«зқҖзҪ‘еҚЎеҗҜз”ЁгҖҒеҸ‘еҢ…гҖҒи®ҫзҪ®mac ең°еқҖзӯүеӣһи°ғеҮҪж•°пјҲеҮҪж•°жҢҮй’Ҳпјү гҖӮеҪ“еҗҜз”ЁдёҖдёӘзҪ‘еҚЎж—¶пјҲдҫӢеҰӮпјҢйҖҡиҝҮ ifconfig eth0 upпјүпјҢnet_device_ops дёӯзҡ„ igb_openж–№жі•дјҡиў«и°ғз”Ё гҖӮе®ғйҖҡеёёдјҡеҒҡд»ҘдёӢдәӢжғ…пјҡ

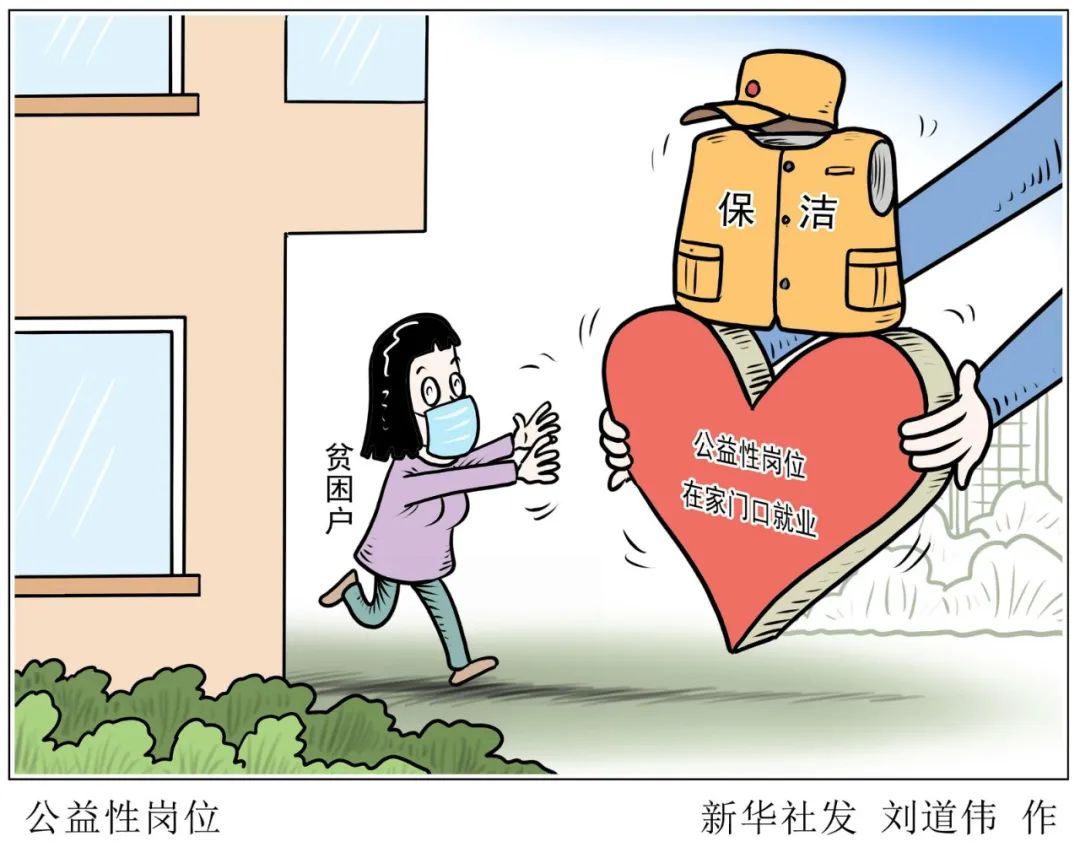

ж–Үз« жҸ’еӣҫ

еӣҫ7 еҗҜеҠЁзҪ‘еҚЎ

//file: drivers/net/ethernet/intel/igb/igb_main.cstatic int __igb_open(struct net_device *netdev, bool resuming){ /* allocate transmit descriptors */ err = igb_setup_all_tx_resources(adapter); /* allocate receive descriptors */ err = igb_setup_all_rx_resources(adapter); /* жіЁеҶҢдёӯж–ӯеӨ„зҗҶеҮҪж•° */ err = igb_request_irq(adapter); if (err) goto err_req_irq; /* еҗҜз”ЁNAPI */ for (i = 0; i < adapter->num_q_vectors; i++) napi_enable(&(adapter->q_vector[i]->napi)); ......}еңЁдёҠйқў__igb_openеҮҪж•°и°ғз”ЁдәҶigb_setup_all_tx_resources,е’Ңigb_setup_all_rx_resources гҖӮеңЁigb_setup_all_rx_resourcesиҝҷдёҖжӯҘж“ҚдҪңдёӯпјҢеҲҶй…ҚдәҶRingBufferпјҢ并е»әз«ӢеҶ…еӯҳе’ҢRxйҳҹеҲ—зҡ„жҳ е°„е…ізі» гҖӮпјҲRx Tx йҳҹеҲ—зҡ„ж•°йҮҸе’ҢеӨ§е°ҸеҸҜд»ҘйҖҡиҝҮ ethtool иҝӣиЎҢй…ҚзҪ®пјү гҖӮжҲ‘们еҶҚжҺҘзқҖзңӢдёӯж–ӯеҮҪж•°жіЁеҶҢigb_request_irq:static int igb_request_irq(struct igb_adapter *adapter){ if (adapter->msix_entries) { err = igb_request_msix(adapter); if (!err) goto request_done; ...... }}static int igb_request_msix(struct igb_adapter *adapter){ ...... for (i = 0; i < adapter->num_q_vectors; i++) { ... err = request_irq(adapter->msix_entries[vector].vector, igb_msix_ring, 0, q_vector->name, }еңЁдёҠйқўзҡ„д»Јз Ғдёӯи·ҹиёӘеҮҪж•°и°ғз”ЁпјҢ __igb_open => igb_request_irq => igb_request_msix, еңЁigb_request_msixдёӯжҲ‘们зңӢеҲ°дәҶпјҢеҜ№дәҺеӨҡйҳҹеҲ—зҡ„зҪ‘еҚЎпјҢдёәжҜҸдёҖдёӘйҳҹеҲ—йғҪжіЁеҶҢдәҶдёӯж–ӯпјҢе…¶еҜ№еә”зҡ„дёӯж–ӯеӨ„зҗҶеҮҪж•°жҳҜigb_msix_ringпјҲиҜҘеҮҪж•°д№ҹеңЁdrivers/net/ethernet/intel/igb/igb_main.cдёӢпјү гҖӮжҲ‘们д№ҹеҸҜд»ҘзңӢеҲ°пјҢmsixж–№ејҸдёӢпјҢжҜҸдёӘ RX йҳҹеҲ—жңүзӢ¬з«Ӣзҡ„MSI-X дёӯж–ӯпјҢд»ҺзҪ‘еҚЎзЎ¬д»¶дёӯж–ӯзҡ„еұӮйқўе°ұеҸҜд»Ҙи®ҫзҪ®и®©ж”¶еҲ°зҡ„еҢ…иў«дёҚеҗҢзҡ„ CPUеӨ„зҗҶ гҖӮпјҲеҸҜд»ҘйҖҡиҝҮ irqbalanceпјҢжҲ–иҖ…дҝ®ж”№ /proc/irq/IRQ_NUMBER/smp_affinityиғҪеӨҹдҝ®ж”№е’ҢCPUзҡ„з»‘е®ҡиЎҢдёәпјү гҖӮеҪ“еҒҡеҘҪд»ҘдёҠеҮҶеӨҮе·ҘдҪңд»ҘеҗҺпјҢе°ұеҸҜд»ҘејҖй—ЁиҝҺе®ўпјҲж•°жҚ®еҢ…пјүдәҶпјҒ

дёү

иҝҺжҺҘж•°жҚ®зҡ„еҲ°жқҘ

3.1 зЎ¬дёӯж–ӯеӨ„зҗҶйҰ–е…ҲеҪ“ж•°жҚ®её§д»ҺзҪ‘зәҝеҲ°иҫҫзҪ‘еҚЎдёҠзҡ„ж—¶еҖҷпјҢ第дёҖз«ҷжҳҜзҪ‘еҚЎзҡ„жҺҘ收йҳҹеҲ— гҖӮзҪ‘еҚЎеңЁеҲҶй…Қз»ҷиҮӘе·ұзҡ„RingBufferдёӯеҜ»жүҫеҸҜз”Ёзҡ„еҶ…еӯҳдҪҚзҪ®пјҢжүҫеҲ°еҗҺDMAеј•ж“ҺдјҡжҠҠж•°жҚ®DMAеҲ°зҪ‘еҚЎд№ӢеүҚе…іиҒ”зҡ„еҶ…еӯҳйҮҢпјҢиҝҷдёӘж—¶еҖҷCPUйғҪжҳҜж— ж„ҹзҡ„ гҖӮеҪ“DMAж“ҚдҪңе®ҢжҲҗд»ҘеҗҺпјҢзҪ‘еҚЎдјҡеҗ‘CPUеҸ‘иө·дёҖдёӘзЎ¬дёӯж–ӯпјҢйҖҡзҹҘCPUжңүж•°жҚ®еҲ°иҫҫ гҖӮ

ж–Үз« жҸ’еӣҫ

еӣҫ8 зҪ‘еҚЎж•°жҚ®зЎ¬дёӯж–ӯеӨ„зҗҶиҝҮзЁӢ

жіЁж„ҸпјҡеҪ“RingBufferж»Ўзҡ„ж—¶еҖҷпјҢж–°жқҘзҡ„ж•°жҚ®еҢ…е°Ҷз»ҷдёўејғ гҖӮifconfigжҹҘзңӢзҪ‘еҚЎзҡ„ж—¶еҖҷпјҢеҸҜд»ҘйҮҢйқўжңүдёӘoverrunsпјҢиЎЁзӨәеӣ дёәзҺҜеҪўйҳҹеҲ—ж»Ўиў«дёўејғзҡ„еҢ… гҖӮеҰӮжһңеҸ‘зҺ°жңүдёўеҢ…пјҢеҸҜиғҪйңҖиҰҒйҖҡиҝҮethtoolе‘Ҫд»ӨжқҘеҠ еӨ§зҺҜеҪўйҳҹеҲ—зҡ„й•ҝеәҰ гҖӮеңЁеҗҜеҠЁзҪ‘еҚЎдёҖиҠӮпјҢжҲ‘们иҜҙеҲ°дәҶзҪ‘еҚЎзҡ„зЎ¬дёӯж–ӯжіЁеҶҢзҡ„еӨ„зҗҶеҮҪж•°жҳҜigb_msix_ring гҖӮ

//file: drivers/net/ethernet/intel/igb/igb_main.cstatic irqreturn_t igb_msix_ring(int irq, void *data){ struct igb_q_vector *q_vector = data; /* Write the ITR value calculated from the previous interrupt. */ igb_write_itr(q_vector); napi_schedule(&q_vector->napi); return IRQ_HANDLED;}

жҺЁиҚҗйҳ…иҜ»

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- дёүз§ҚдҪҝз”ЁAIж”»еҮ»зҪ‘з»ңе®үе…Ёзҡ„ж–№жі•

- зҗҶи§ЈдәҶLinux I/OжңәеҲ¶пјҢжүҚиғҪзңҹзҡ„жҳҺзҷҪвҖңд»Җд№ҲжҳҜеӨҡзәҝзЁӢвҖқ

- LinuxзҪ‘з»ңй…ҚзҪ®

- еёҰдҪ йҮҚж–°и®ӨиҜҶLinuxзі»з»ҹзҡ„inode

- еҸӨеү‘еҘҮи°ӯзҪ‘з»ңзүҲйҮҺеӨ–pvp еҸӨеү‘еҘҮи°ӯolеү§жғ…

- д»ҺLinuxжәҗз ҒзңӢSocketзҡ„listenеҸҠиҝһжҺҘйҳҹеҲ—

- linuxзҪ‘з»ңзј–зЁӢеёёи§ҒAPIиҜҰи§Ј

- дәҶи§ЈзҘһз»ҸзҪ‘з»ңе’ҢжЁЎеһӢжіӣеҢ–

- TCP/IP еҹәзЎҖзҹҘиҜҶжҖ»з»“

- еҰӮдҪ•еңЁз”өи„‘дёҠе®үиЈ…зҪ‘з»ңжү“еҚ°жңәпјҹиҜҰз»Ҷж•ҷзЁӢе…ЁйғЁж•ҷз»ҷдҪ