иҜҰи§Је·ҘзЁӢеёҲдёҚеҸҜдёҚдјҡзҡ„LRUзј“еӯҳж·ҳжұ°з®—жі•

еӨ§е®¶еҘҪ пјҢ ж¬ўиҝҺеӨ§е®¶жқҘеҲ°з®—жі•ж•°жҚ®з»“жһ„дё“йўҳ пјҢ д»ҠеӨ©жҲ‘们е’ҢеӨ§е®¶иҒҠдёҖдёӘйқһеёёеёёз”Ёзҡ„з®—жі• пјҢ еҸ«еҒҡLRU гҖӮ

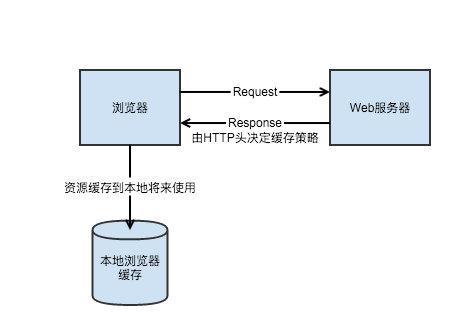

LRUзҡ„иӢұж–Үе…Ёз§°жҳҜLeast Recently Used пјҢ д№ҹеҚіжңҖдёҚз»ҸеёёдҪҝз”Ё гҖӮ жҲ‘们зңӢзқҖеҘҪеғҸжҢәиҝ·зіҠзҡ„ пјҢ е…¶е®һиҝҷдёӘеҗ«д№үиҰҒз»“еҗҲзј“еӯҳдёҖиө·дҪҝз”Ё гҖӮ еҜ№дәҺе·ҘзЁӢиҖҢиЁҖ пјҢ зј“еӯҳжҳҜйқһеёёйқһеёёйҮҚиҰҒзҡ„жңәеҲ¶ пјҢ е°Өе…¶жҳҜеңЁеҪ“дёӢзҡ„дә’иҒ”зҪ‘еә”з”ЁзҺҜеўғеҪ“дёӯ пјҢ иө·еҲ°зҡ„дҪңз”ЁйқһеёёйҮҚиҰҒ гҖӮ дёәдәҶдҫҝдәҺеӨ§е®¶жӣҙеҘҪең°зҗҶи§Ј пјҢ жҲ‘们д»Һзј“еӯҳзҡ„жңәеҲ¶ејҖе§ӢиҜҙиө· гҖӮ

зј“еӯҳзј“еӯҳзҡ„иӢұж–ҮжҳҜcache пјҢ жңҖж—©е…¶е®һжҢҮзҡ„жҳҜз”ЁдәҺCPUе’Ңдё»еӯҳж•°жҚ®дәӨдә’зҡ„ гҖӮ ж—©е№ҙиҝҷеқ—еӯҳеӮЁиў«з§°дёәй«ҳйҖҹзј“еӯҳ пјҢ жңҖиҝ‘е·Із»Ҹеҗ¬дёҚеҲ°иҝҷдёӘиҜҚдәҶ пјҢ дёҚзҹҘйҒ“жҳҜдёҚжҳҜж·ҳжұ°дәҶ гҖӮ еӣ дёәзј“еӯҳзҡ„иҜ»еҶҷйҖҹеәҰиҰҒй«ҳдәҺCPUдҪҺдәҺдё»еӯҳ пјҢ жүҖд»ҘжҳҜз”ЁжқҘиҝҮжёЎж•°жҚ®з”Ёзҡ„ гҖӮ CPUд»Һзј“еӯҳеҪ“дёӯиҜ»еҸ–ж•°жҚ® пјҢ дё»еӯҳзҡ„ж•°жҚ®д№ҹдјҡе…ҲеҠ иҪҪеҲ°зј“еӯҳеҪ“дёӯжқҘ пјҢ д№ӢеҗҺеҶҚиҝӣе…ҘCPU гҖӮ

еҗҺжқҘзј“еӯҳжңүдәҶжӣҙеӨҡзҡ„еә”з”Ёе’Ңж„Ҹдёә пјҢ еңЁеҗҺз«ҜжңҚеҠЎеҪ“дёӯдёҖиҲ¬з”ЁжқҘеҝ«йҖҹе“Қеә”иҜ·жұӮ гҖӮ е…¶е®һиҝҷйҮҢзҡ„жҖқжғіе’Ңи®°еҝҶеҢ–жҗңзҙўжңүзӮ№еғҸ пјҢ жҲ‘们жҠҠеҸҜиғҪиҰҒз”ЁеҲ°зҡ„ж•°жҚ®е…Ҳеӯҳиө·жқҘ пјҢ еҗҺжңҹеҰӮжһңиҰҒз”ЁеҲ°зҡ„иҜқ пјҢ е°ұеҸҜд»ҘзӣҙжҺҘд»ҺеҶ…еӯҳеҪ“дёӯиҜ»еҸ–иҖҢдёҚжҳҜеҶҚеҺ»и®Ўз®—дёҖйҒҚдәҶ гҖӮ еҺҹзҗҶд№ҹжҳҜдёҖж ·зҡ„ пјҢ жңүдәҶзј“еӯҳжҲ‘们еҸҜд»ҘжҠҠиҰҒиҝ”еӣһз»ҷз”ЁжҲ·зҡ„ж•°жҚ®еӮЁеӯҳеңЁеҶ…еӯҳдёӯ пјҢ еҪ“еҗҢж ·зҡ„иҜ·жұӮиҝҮжқҘзҡ„ж—¶еҖҷ пјҢ жҲ‘们е°ұеҸҜд»ҘзӣҙжҺҘд»ҺеҶ…еӯҳеҪ“дёӯиҜ»еҸ–з»“жһң пјҢ иҖҢдёҚжҳҜеҶҚиө°дёҖж¬Ўй“ҫи·ҜиҺ·еҸ–ж•°жҚ®дәҶ гҖӮ

дёҫдёҖдёӘеҫҲз®ҖеҚ•зҡ„дҫӢеӯҗ пјҢ жҜ”еҰӮиҜҙжҲ‘们жү“ејҖж·ҳе®қйҰ–йЎөдјҡзңӢеҲ°еҫҲеӨҡе•Ҷе“Ғзҡ„жҺЁиҚҗ гҖӮ е…¶е®һжҺЁиҚҗе•Ҷе“Ғзҡ„жөҒзЁӢжҳҜйқһеёёеӨҚжқӮзҡ„ пјҢ йҰ–е…ҲиҰҒж №жҚ®дёҖе®ҡзҡ„зӯ–з•ҘеҺ»е•Ҷе“Ғеә“еҪ“дёӯеҸ¬еӣһе•Ҷе“Ғ гҖӮ жҜ”еҰӮж №жҚ®з”ЁжҲ·д№ӢеүҚзҡ„иЎҢдёәеҸ¬еӣһе’ҢеҺҶеҸІиЎҢдёәзӣёе…ізҡ„е•Ҷе“Ғ пјҢ еҸ¬еӣһдәҶе•Ҷе“Ғд№ӢеҗҺиҝҳиҰҒиҝӣиЎҢжё…жҙ— пјҢ иҝҮж»ӨжҺүдёҖдәӣжҳҺзЎ®дёҚж„ҹе…ҙи¶ЈжҲ–иҖ…жҳҜйқһжі•гҖҒиҝқ规зҡ„е•Ҷе“Ғ гҖӮ иҝҮж»ӨдәҶд№ӢеҗҺйңҖиҰҒдҪҝз”ЁжңәеҷЁеӯҰд№ жҲ–иҖ…жҳҜж·ұеәҰеӯҰд№ зҡ„жЁЎеһӢжқҘиҝӣиЎҢзӮ№еҮ»зҺҮйў„жөӢ пјҢ д»ҺиҖҢе°ҶеҸ‘з”ҹзӮ№еҮ»еҸҜиғҪжҖ§жңҖй«ҳзҡ„е•Ҷе“ҒжҺ’еңЁеүҚйқў гҖӮ

еҲ°иҝҷйҮҢиҝҳжІЎз»“жқҹ пјҢ жҺЁиҚҗе•Ҷе“ҒеҲ—иЎЁе…¶е®һд№ҹжҳҜеҲҶеұ•дҪҚзҡ„ пјҢ жңүдәӣдҪҚзҪ®зҡ„е•Ҷе“ҒжҳҜиҝҗиҗҘй…ҚеҘҪзҡ„ пјҢ жңүдәӣдҪҚзҪ®еӣәе®ҡеұ•зӨәзҡ„жҳҜе№ҝе‘Ҡ гҖӮ е№ҝе‘ҠеҫҖеҫҖд№ҹжңүиҮӘе·ұзҡ„дёҖжқЎй“ҫи·Ҝ пјҢ иҝҳжңүдәӣдҪҚзҪ®жңүдёҖдәӣе…¶д»–зҡ„йҖ»иҫ‘ гҖӮ иҝҷдәӣе•Ҷе“Ғзҡ„ж•°жҚ®йғҪжӢҝеҲ°дәҶд№ӢеҗҺ пјҢ иҝҳиҰҒиҺ·еҸ–еӣҫзүҮд»ҘеҸҠе…¶д»–дёҖдәӣйӣ¶йӣ¶ж•Јж•Јзҡ„дҝЎжҒҜ пјҢ жңҖеҗҺжүҚиғҪеұ•зӨәеҮәжқҘ гҖӮ еӣ жӯӨеӨ§е®¶еҸҜд»ҘиҜ•дёҖдёӢжү“ејҖж·ҳе®қйҰ–йЎөиҰҒжҜ”жү“ејҖзҷҫеәҰйҰ–йЎөж…ўеҫ—еӨҡ пјҢ иҝҷ并дёҚжҳҜж·ҳе®қжҠҖжңҜе·® пјҢ иҖҢжҳҜеӣ дёәиҝҷдёӯй—ҙзҡ„й“ҫи·Ҝе®һеңЁжҳҜеӨӘй•ҝдәҶ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

жҲ‘们еҫҲе®№жҳ“еҸ‘зҺ° пјҢ еҜ№дәҺдёҖдәӣз»Ҹеёёжү“ејҖж·ҳе®қзҡ„з”ЁжҲ·жқҘиҜҙ пјҢ е…¶е®һжІЎжңүеҝ…иҰҒжҜҸдёҖж¬ЎйғҪжҠҠе®Ңж•ҙзҡ„й“ҫи·Ҝиө°дёҖйҒҚ гҖӮ жҲ‘们еӨ§еҸҜд»ҘжҠҠд№ӢеүҚеұ•зӨәзҡ„з»“жһңеӯҳеӮЁеңЁеҶ…еӯҳйҮҢ пјҢ дёӢдёҖж¬ЎеҶҚйҒҮеҲ°еҗҢж ·иҜ·жұӮзҡ„ж—¶еҖҷ пјҢ зӣҙжҺҘд»ҺеҶ…еӯҳеҪ“дёӯиҜ»еҸ–并且иҝ”еӣһе°ұеҸҜд»ҘдәҶ гҖӮ иҝҷж ·еҸҜд»ҘиҠӮзңҒеӨ§йҮҸзҡ„ж—¶й—ҙд»ҘеҸҠи®Ўз®—иө„жәҗ пјҢ жҜ”еҰӮеңЁеӨ§дҝғзҡ„ж—¶еҖҷ пјҢ е°ұеҸҜд»ҘжҠҠи®Ўз®—иө„жәҗиҠӮзңҒдёӢжқҘз”ЁеңЁжӣҙеҠ йңҖиҰҒзҡ„ең°ж–№ гҖӮ

гҖҗиҜҰи§Је·ҘзЁӢеёҲдёҚеҸҜдёҚдјҡзҡ„LRUзј“еӯҳж·ҳжұ°з®—жі•гҖ‘зј“еӯҳиҷҪ然еҘҪз”Ё пјҢ дҪҶжҳҜд№ҹдёҚжҳҜдёҮиғҪзҡ„ пјҢ еӣ дёәеҶ…еӯҳжҳҜеҫҲиҙөзҡ„ пјҢ жҲ‘们дёҚеҸҜиғҪжҠҠжүҖжңүж•°жҚ®йғҪеӯҳеңЁеҶ…еӯҳйҮҢ гҖӮ еҶ…еӯҳйҮҢеҸӘиғҪж”ҫдёҖдәӣжҲ‘们и®ӨдёәжҜ”иҫғй«ҳд»·еҖјзҡ„ж•°жҚ® пјҢ еңЁиҝҷз§Қжғ…еҶөдёӢ пјҢ 计算科еӯҰ家们жғіеҮәдәҶз§Қз§Қзӯ–з•ҘжқҘи°ғеәҰзј“еӯҳ пјҢ дҝқжҢҒзј“еӯҳеҪ“дёӯж•°жҚ®зҡ„й«ҳд»·еҖј гҖӮ LRUе°ұжҳҜе…¶дёӯдёҖз§ҚжҜ”иҫғеёёз”Ёзҡ„зӯ–з•Ҙ гҖӮ

LRUеҗ«д№үжҲ‘们еүҚйқўд№ҹиҜҙдәҶ пјҢ LRUзҡ„ж„ҸжҖқжҳҜжңҖй•ҝдёҚз»ҸеёёдҪҝз”Ё пјҢ д№ҹеҸҜд»ҘзҗҶи§ЈжҲҗжңҖд№…жІЎжңүдҪҝз”Ё гҖӮ еңЁиҝҷз§Қзӯ–з•ҘдёӢжҲ‘们用жңҖиҝ‘дёҖж¬ЎдҪҝз”Ёзҡ„ж—¶й—ҙжқҘиЎЎйҮҸдёҖеқ—еҶ…еӯҳзҡ„д»·еҖј пјҢ и¶Ҡд№…д№ӢеүҚдҪҝз”Ёзҡ„д»·еҖјд№ҹе°ұи¶ҠдҪҺ пјҢ жңҖиҝ‘еҲҡеҲҡдҪҝз”ЁиҝҮзҡ„ пјҢ еҗҺйқўжҺҘзқҖдјҡз”ЁеҲ°зҡ„жҰӮзҺҮд№ҹе°ұи¶ҠеӨ§ пјҢ йӮЈд№ҲиҮӘ然д№ҹе°ұд»·еҖји¶Ҡй«ҳ гҖӮ

еҪ“然еҸӘжңүиҝҷдёӘйҷҗеҲ¶жҳҜдёҚеӨҹзҡ„ пјҢ жҲ‘们еүҚйқўд№ҹиҜҙдәҶ пјҢ з”ұдәҺеҶ…еӯҳжҳҜйқһеёёйҮ‘иҙөзҡ„ пјҢ еҜјиҮҙжҲ‘们еҸҜд»ҘеӯҳеӮЁеңЁзј“еӯҳеҪ“дёӯзҡ„ж•°жҚ®жҳҜжңүйҷҗзҡ„ гҖӮ жҜ”еҰӮиҜҙжҲ‘们еӣәе®ҡеҸӘиғҪеӯҳеӮЁ1wжқЎ пјҢ еҪ“еҶ…еӯҳж»ЎдәҶд№ӢеҗҺ пјҢ зј“еӯҳжҜҸжҸ’е…ҘдёҖжқЎж–°ж•°жҚ® пјҢ йғҪиҰҒжҠӣејғдёҖжқЎжңҖй•ҝжІЎжңүдҪҝз”Ёзҡ„ж—§ж•°жҚ® гҖӮ иҝҷж ·жҲ‘们е°ұдҝқиҜҒдәҶзј“еӯҳеҪ“дёӯзҡ„ж•°жҚ®зҡ„д»·еҖјйғҪжҜ”иҫғй«ҳ пјҢ 并且еҶ…еӯҳдёҚдјҡи¶…иҝҮйҷҗеҲ¶ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- жһҒйҖҹйІЁиҜҫе Ӯ85пјҡжҳҫеҚЎжҖҺд№ҲжөӢиҜ• 3DMARKиҜҰи§Ј

- йӣ·еҶӣпјҡ2021е№ҙзҡ„第дёҖ件еӨ§дәӢпјҢз»ҷе·ҘзЁӢеёҲеҸ‘зҷҫдёҮзҫҺйҮ‘еӨ§еҘ–

- ж—Ҙжң¬е·ҘзЁӢеёҲпјҡжҪҳеӨҡжӢүйӯ”зӣ’иў«зҫҺеӣҪжү“ејҖпјҢдёӯеӣҪеҠһиҠҜзүҮеӨ§еӯҰеҸӘдёәжү“з ҙзҰҒд»Ө

- жҖ§иғҪзҝ»еҖҚпјҒйЈһи…ҫйҰ–ж¬ҫ8ж ёжЎҢйқўеӨ„зҗҶеҷЁи…ҫй”җD2000иҜҰи§Ј

- д»Һе·ҘзЁӢеёҲеҲ°вҖңж°ҙжһңзҢҺдәәвҖқд»–еңЁзҷҫеәҰеҒҡ科жҷ®

- е№ҙд»Јж„ҹеҚҒи¶іпјҒеүҚиӢ№жһңе·ҘзЁӢеёҲж”ҫеҮәеҲқд»ЈiPhoneз”ҹдә§зәҝз…§зүҮ

- иғҪиЈ…иҝӣеҸЈиўӢзҡ„е·ҘзЁӢеёҲиҝҗз»ҙ笔记жң¬пјҡеЈ№еҸ·жң¬еЈ№еҸ·е·ҘзЁӢеёҲPC A1

- еёғеұҖAIиҚҜзү©з ”еҸ‘пјҒеҚҺдёәжӢӣиҒҳиҚҜзү©з ”еҸ‘з®—жі•е·ҘзЁӢеёҲпјҢж—©жңүеҮҶеӨҮиҝӣеҶӣеҢ»з–—иЎҢдёҡпјҹ

- зҪ‘йҖҹеҶҚзҝ»еҖҚпјҢе®ҳж–№иҜҰи§Је°Ҹзұі 11 жҗӯиҪҪзҡ„ WiFi 6 еўһејәзүҲжҠҖжңҜ

- и…ҫи®Ҝж•°жҚ®е·ҘзЁӢеёҲжҺЁиҚҗзҡ„Pythonж–°жүӢе…Ҙй—Ёд№ҰзұҚпјҢиҝҳжҳҜйҰ–еҸ‘з”өеӯҗзүҲ

![[еҫ·ж–Ҝ]82284.6欧е…ғиө·е”® ж–°ж¬ҫжў…иөӣеҫ·ж–Ҝ-AMG Eзә§ејҖеҗҜйў„е®ҡ](https://k-static.6789.com/uploads/auto-pic/202007/07/1594089939_69902300.jpg)