深度学习算法完整简介( 三 )

多个RBM可以叠加形成一个深度信念网络 。 它们看起来完全像全连接层 , 但但是它们的训练方式不同 。

#8生成对抗网络(GAN)

GAN正在成为一种流行的在线零售机器学习模型 , 因为它们能够以越来越高的准确度理解和重建视觉内容 。 用例包括:

- 从轮廓填充图像 。

- 从文本生成逼真的图像 。

- 制作产品原型的真实感描述 。

- 将黑白图像转换为彩色图像 。

- 在框架内模拟人类行为和运动的模式 。

- 预测后续的视频帧 。

- 创建deepfake

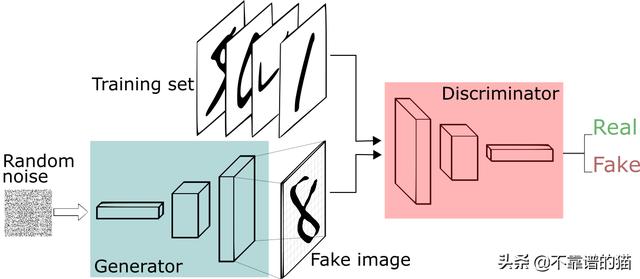

- 生成器学习生成可信的数据 。 生成的实例成为判别器的负面训练实例 。

- 判别器学会从数据中分辨出生成器的假数据 。 判别器对产生不可信结果的发生器进行惩罚 。

文章插图

文章插图然后 , 将生成的图像与原始概念的实际数据点一起馈入判别器 。 判别器对信息进行过滤 , 并返回0到1之间的概率来表示每个图像的真实性(1与真相关 , 0与假相关) 。 然后检查这些值是否成功 , 并不断重复 , 直到达到预期的结果 。

#9Transformers

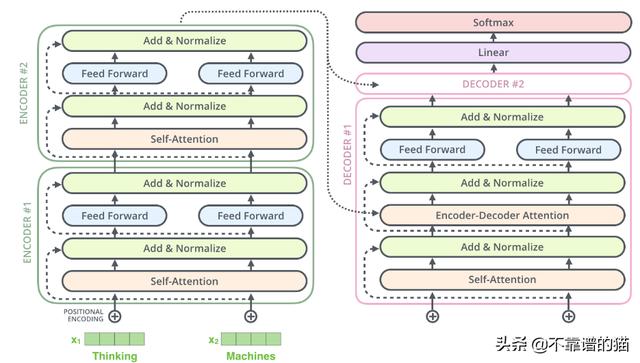

Transformers也很新 , 它们主要用于语言应用 。 它它们基于一个叫做注意力的概念 , 这个概念被用来迫使网络将注意力集中在特定的数据点上 。

由于LSTM单元过于复杂 , 因此可以使用注意力机制根据其重要性对输入的不同部分进行权衡 。 注意力机制只不过是另一个具有权重的层 , 它的唯一目的是调整权重 , 使输入的部分优先化 , 同时排除其他部分 。

实际上 , Transformers由多个堆叠的编码器(形成编码器层) , 多个堆叠的解码器(解码器层)和一堆attention层(self- attentions和encoder-decoder attentions)组成

文章插图

文章插图Transformers设计用于处理诸如机器翻译和文本摘要之类的各种任务的有序数据序列 , 例如自然语言 。 如今 , BERT和GPT-2是两个最著名的经过预先训练的自然语言系统 , 用于各种NLP任务中 , 它们都基于Transformers 。

#10图神经网络

一般来说 , 非结构化数据并不适合深度学习 。 在许多实际应用中 , 数据是非结构化的 , 例如社交网络 , 化合物 , 知识图 , 空间数据等 。

图神经网络的目的是对图数据进行建模 , 这意味着它们识别图中节点之间的关系 , 并对其进行数值表示 。 它们以后可以在任何其他机器学习模型中用于各种任务 , 例如聚类 , 分类等 。

推荐阅读

- 向日葵远程控制企业版客户端更新升级,优化远控UI适配SADDC内核算法

- 计算机专业大一下学期,该选择学习Java还是Python

- 假期弯道超车 国美学习“神器”助孩子变身“学霸”

- 想自学Python来开发爬虫,需要按照哪几个阶段制定学习计划

- 未来想进入AI领域,该学习Python还是Java大数据开发

- Google AI建立了一个能够分析烘焙食谱的机器学习模型

- 学习大数据是否需要学习JavaEE

- 学习“时代楷模”精神 信息科技创新助跑5G智慧港口

- 创维小湃盒子P3 Pro深度评测

- 把时间花在更有价值的地方,关注这几个有深度的订阅号