特斯拉自动驾驶不靠谱,发生事故只需1/8秒,且不会留任何痕迹

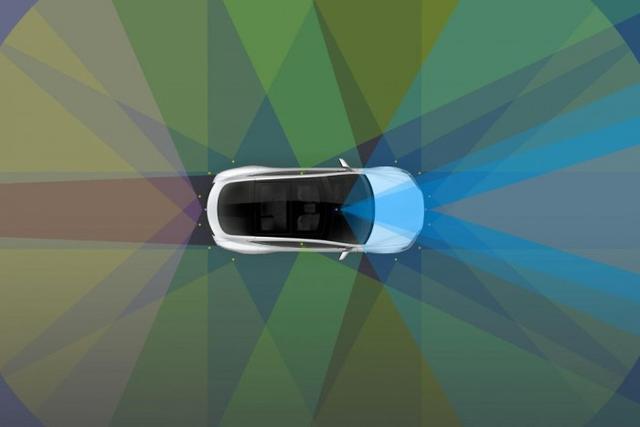

【特斯拉自动驾驶不靠谱,发生事故只需1/8秒,且不会留任何痕迹】伴随着技术的发展 , 汽车驾驶辅助系统不断迭代 , 安全性逐渐提高 , 但辅助驾驶系统的可靠性还远没有完善 。 近日 , 有研究人员表示 , 通过入侵互联网广告牌 , 就可以诱使特斯拉的自动驾驶系统采取紧急制动、停车或者转弯等动作 。

文章插图

文章插图

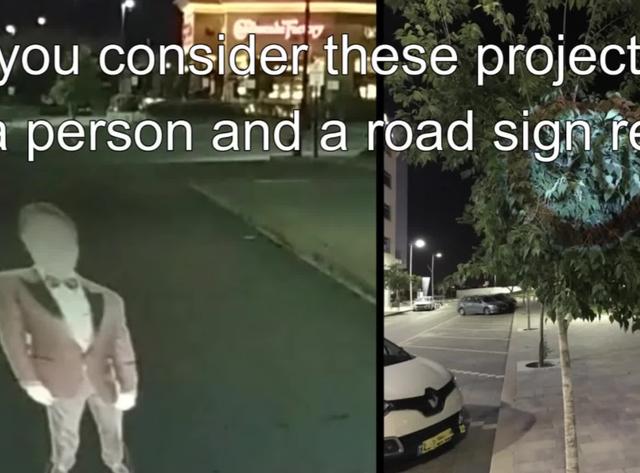

以色列的本·古里安大学一直在对迷惑自动驾驶系统的“鬼影”图像进行试验 。

简单来说 , 一些图像可以迷惑自动驾驶和辅助驾驶系统 , 只需要营造瞬间的光线投影 , 让系统注意到不存在的物体即可 , 比如一个停车指示牌 。

文章插图

文章插图

该研究最早的演示 , 是把路标和人影投射到路面上 。 只需要几毫秒的图像 , 就可以误导高级辅助驾驶系统了 。 据悉 , 当黑客黑入某些数字广告牌之后 , 黑客可以通过令广告牌显示特定内容 , 引导汽车发生事故 , 并且不会留下任何明显痕迹 , 至少不会被司机注意到 。

文章插图

文章插图

研究人员表示 , 针对的是特斯拉的Autopilot和MobileEye 630系统 , 前者会对0.42秒的虚假影响作出反应 , 对后者只需要1/8秒就够了 。

推荐阅读

- 上线 | 特斯拉亚太首座“机场超充站”来了,8个桩够不够?

- 关注 | 马斯克突然宣布:特斯拉或将迎来首届“人工智能日”

- 运动计数开发项目的对抗赛:飞算全自动软件工程平台碾压传统模式

- 特斯拉频频自动加速、突然失控?美国监管机构调查结果:证据不足

- 特斯拉国产Model Y来了!造车新势力慌了?

- 超级|全球最大特斯拉超级充电站已上线,位于上海一地下3层停车场

- 中策橡胶首创胎面压出产线“自动驾驶”,重量误差小于1%

- 美国特斯拉下调Model Y售价,标续版上线约27万元

- Clearbot:一款能自动在水上追踪收集垃圾的机器人

- LG发布新款无线吸尘器 可自动清空集尘盒

![[他人婚]被曝插足他人婚姻 《青你2》选手申冰退赛](https://img3.utuku.china.com/550x0/toutiao/20200326/5961a705-f613-40cd-b825-bc7656e59cfc.jpg)