еҗүжһ—еӨ§еӯҰTARS-GOжҲҳйҳҹи§Ҷи§үд»Јз Ғ

д»Ӣз»Қжң¬д»Јз ҒжҳҜеҗүжһ—еӨ§еӯҰTARS-GOжҲҳйҳҹRobomaster2020иөӣеӯЈжӯҘе…өи§Ҷи§үз®—жі• пјҢ дё»иҰҒжЁЎеқ—еҲҶдёәиЈ…з”ІжқҝиҜҶеҲ«гҖҒеӨ§йЈҺиҪҰиғҪйҮҸжңәе…іиҜҶеҲ«гҖҒи§’еәҰи§Јз®—гҖҒзӣёжңәй©ұеҠЁеҸҠдёІеҸЈ/CANйҖҡдҝЎ гҖӮ

1.еҠҹиғҪд»Ӣз»Қ

- иЈ…з”ІжқҝиҜҶеҲ« пјҢжЈҖжөӢж•Ңж–№жңәеҷЁдәәиЈ…з”ІжқҝдҪҚзҪ®дҝЎжҒҜ并иҜҶеҲ«е…¶ж•°еӯ—

- еӨ§йЈҺиҪҰиғҪйҮҸжңәе…іиҜҶеҲ« пјҢжЈҖжөӢеҫ…жҝҖжҙ»еӨ§йЈҺиҪҰжүҮеҸ¶зӣ®ж ҮдҪҚзҪ®дҝЎжҒҜ

- и§’еәҰи§Јз®—пјҢ ж №жҚ®дёҠиҝ°дҪҚзҪ®дҝЎжҒҜи§Јз®—зӣ®ж ҮзӣёеҜ№жһӘз®Ўзҡ„yawгҖҒpitchи§’еәҰеҸҠи·қзҰ»

- зӣёжңәй©ұеҠЁ пјҢеӨ§жҒ’зӣёжңәSDKе°ҒиЈ… пјҢ е®һзҺ°зӣёжңәеҸӮж•°жҺ§еҲ¶еҸҠеӣҫеғҸйҮҮйӣҶ

- дёІеҸЈ/CANйҖҡдҝЎ пјҢдёҺдёӢдҪҚжңәйҖҡдҝЎ пјҢ дј иҫ“жңәеҷЁдәәе§ҝжҖҒдҝЎжҒҜеҸҠж“ҚдҪңжүӢеҸҚйҰҲи§Ҷи§үзҡ„жҺ§еҲ¶дҝЎжҒҜ

**EnemyColor = BLUE; TargetNum = 1**

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ**EnemyColor = RED; TargetNum = 2**

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫеңЁ640*480еӣҫеғҸеҲҶиҫЁзҺҮдёӢ пјҢ иЈ…з”ІжқҝиҜҶеҲ«её§зҺҮеҸҜиҫҫ340fpsе·ҰеҸі пјҢ еј•е…ҘROIд№ӢеҗҺеҸҜиҫҫ420fps гҖӮ дҪҶиҖғиҷ‘еҲ°иҜҶеҲ«её§зҺҮеҜ№дәҺз”өжҺ§жңә械延иҝҹзҡ„йҘұе’Ң пјҢ еҸ–ж¶Ҳеј•е…ҘROIж“ҚдҪң пјҢ д»ҘжӯӨйҒҝе…Қеј•е…ҘROIд№ӢеҗҺж— жі•еҸҠж—¶жҺўжөӢе…ЁеұҖи§ҶйҮҺжғ…еҶөзҡ„й—®йўҳ пјҢ еҠ еҝ«жңәеҷЁдәәиҮӘзһ„е“Қеә” гҖӮ

гҖҗеҗүжһ—еӨ§еӯҰTARS-GOжҲҳйҳҹи§Ҷи§үд»Јз ҒгҖ‘**640\*480пјҲеі°еҖјеҸҜиҫҫ340FPSпјү**

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ**320\*240пјҲеі°еҖјеҸҜиҫҫ1400FPSпјү**

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫиЈ…з”Іжқҝж•°еӯ—иҜҶеҲ«йҮҮз”ЁSVM пјҢ йҖҡиҝҮиЈ…з”ІжқҝдҪҚзҪ®дҝЎжҒҜиЈҒеүӘдәҢеҖјеҢ–еҗҺзҡ„иЈ…з”ІжқҝеӣҫеғҸ并йҖҸе°„еҸҳжҚў пјҢ жҠ•е…Ҙи®ӯз»ғеҘҪзҡ„SVMжЁЎеһӢдёӯиҜҶеҲ« пјҢ ж•°еӯ—иҜҶеҲ«еҮҶзЎ®зҺҮеҸҜиҫҫ98% гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫеӨ§йЈҺиҪҰиғҪйҮҸжңәе…іиҜҶеҲ«

ж–Үз« жҸ’еӣҫ

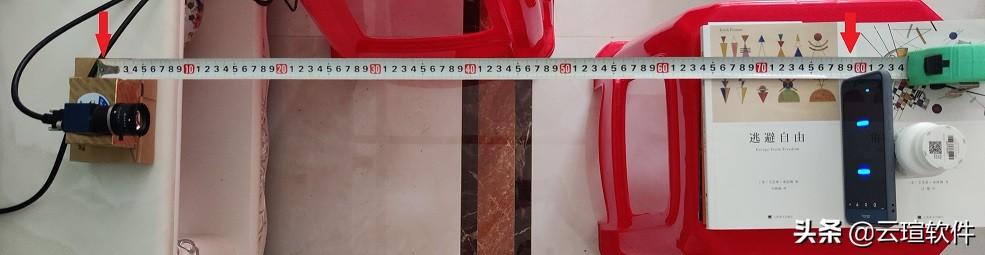

ж–Үз« жҸ’еӣҫи§’еәҰи§Јз®—и§’еәҰи§Јз®—ж–№йқўдҪҝз”ЁдәҶдёӨз§Қи§Јз®—ж–№жі•еҲҶи·қзҰ»жҢЎдҪҚиҝҗиЎҢ гҖӮ 第дёҖжЎЈдҪҝз”ЁP4Pз®—жі• пјҢ 第дәҢжЎЈдҪҝз”Ёе°Ҹеӯ”жҲҗеғҸеҺҹзҗҶзҡ„PinHoleз®—жі• гҖӮ жӯӨеӨ–иҝҳеј•е…ҘдәҶзӣёжңә-жһӘеҸЈзҡ„YиҪҙи·қзҰ»иЎҘеҒҝеҸҠйҮҚеҠӣиЎҘеҒҝ гҖӮ дҪҝз”Ёж Үе®ҡжқҝжөӢиҜ• пјҢ и§’еәҰи§Јз®—и®Ўз®—зҡ„и·қзҰ»иҜҜе·®еңЁ10%д»ҘеҶ… пјҢ и§’еәҰеҹәжң¬дёҺе®һйҷ…еҗ»еҗҲ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ/** *@brief: detect and delete error armor which is caused by the single lightBar й’ҲеҜ№жёёзҰ»зҒҜжқЎеҜјиҮҙзҡ„й”ҷиҜҜиЈ…з”ІжқҝиҝӣиЎҢжЈҖжөӢе’ҢеҲ йҷӨ */void eraseErrorRepeatArmor(vectorvector::iterator it = armors.begin(); for (size_t i = 0; i < length; i++)for (size_t j = i + 1; j < length; j++){if (armors[i].l_index == armors[j].l_index ||armors[i].l_index == armors[j].r_index ||armors[i].r_index == armors[j].l_index ||armors[i].r_index == armors[j].r_index){armors[i].getDeviationAngle() > armors[j].getDeviationAngle() ? armors.erase(it + i) : armors.erase(it + j);}}}- иЈ…з”Іжқҝж•°еӯ—иҜҶеҲ«еҢ№й…ҚеҘҪиЈ…з”ІжқҝеҗҺ пјҢ еҲ©з”ЁиЈ…з”Іжқҝзҡ„йЎ¶зӮ№еңЁеҺҹеӣҫзҡ„дәҢеҖјеӣҫпјҲеҺҹеӣҫзҡ„зҒ°еәҰдәҢеҖјеӣҫпјүдёӯеүӘеҲҮиЈ…з”Іжқҝеӣҫ пјҢ дҪҝз”ЁйҖҸе°„еҸҳжҚўе°ҶиЈ…з”ІжқҝеӣҫеҸҳжҚўдёәSVMжЁЎеһӢжүҖйңҖзҡ„Size пјҢ йҡҸеҗҺжҠ•е…ҘSVMиҜҶеҲ«иЈ…з”Іжқҝж•°еӯ— гҖӮ

жҺЁиҚҗйҳ…иҜ»

- ж—Ҙжң¬е·ҘзЁӢеёҲпјҡжҪҳеӨҡжӢүйӯ”зӣ’иў«зҫҺеӣҪжү“ејҖпјҢдёӯеӣҪеҠһиҠҜзүҮеӨ§еӯҰеҸӘдёәжү“з ҙзҰҒд»Ө

- еҚЎеҶ…еҹәжў…йҡҶеӨ§еӯҰжҸҗеҮәдәҶжӣҙеҘҪзҡ„ејәеҜҶз Ғи®ҫзҪ®е»әи®®

- е»әи®ҫ|ж Ўең°еҗҲдҪң з»өйҳіж¶ӘеҹҺеҢәжҗәжүӢжөҷжұҹеӨ§еӯҰеҸ‘еёғ5gеҲӣж–°жҲҗжһң

- еҸҲжҳҜеҲ«дәә家зҡ„еӯ©еӯҗпјҹе®ҝиҲҚдёІй—ЁиҜ·е…ҲеҲ·жҢҮзә№ иҘҝз”өеӨ§еӯҰз”ҹиҮӘеҲ¶и¶Је‘іжҷәиғҪй”ҒжҲҗвҖңзҪ‘зәўвҖқ

- жҷ®йҖҡеӨ§еӯҰи®Ўз®—жңәдё“дёҡзҡ„жң¬з§‘з”ҹпјҢиҜҘйҖүжӢ©дё»ж”»еүҚз«ҜиҝҳжҳҜJava

- жөҷжұҹжҗәжүӢиӢұеӣҪиҘҝиӢҸж је…°еӨ§еӯҰе…ұе»әеҲӣж–°еҹәең°

- еҜјиҲӘ|ж”»еқҡвҖңеҚ«жҳҹеҜјиҲӘдҝЎеҸ·ејұвҖқйҡҫйўҳпјҢй«ҳеҫ·зЁӢеәҸе‘ҳиҒ”жүӢжӯҰеӨ§еӯҰеӯҗеӨәеҫ—еӣҪйҷ…е®ӨеҶ…е®ҡдҪҚеӨ§иөӣеҶ еҶӣ

- жё…еҚҺеӨ§еӯҰз ”з©¶йҷўеҮәжүӢпјҒж“ҰдёҖж¬ЎпјҢжҢҒз»ӯ24е°Ҹж—¶йҳІйӣҫпјҢж”№еҸҳзңјй•ңе…ҡдҪ“йӘҢ

- еҢ—еӨ§жңҖеӨ§еҚ•дҪ“е»әи®ҫйЎ№зӣ®е°ҒйЎ¶

- йҰ–家"иҠҜзүҮеӨ§еӯҰ"еҚіе°ҶиҗҪжҲҗпјҢзӣ–иҢЁпјҡдёӯеӣҪиҠҜе°Ҷеҙӣиө·пјҢзҫҺеӣҪе°ҶеӨ§йҮҸеӨұдёҡ