иҮӘеҠЁеҢ–иҝҗз»ҙд№ӢSaltStackпјҢжһ¶жһ„еҲҶжһҗе’ҢжҖ»з»“

жҺҘдёҠдёҖзҜҮд»Ӣз»ҚSaltStackзҡ„йғЁзҪІе’ҢдҪҝз”ЁеҗҺ пјҢ д»ҠеӨ©иҝҷзҜҮдё»иҰҒжғіи°ҲдёҖи°ҲжҲ‘д№ӢеүҚеңЁз”ЁSaltStackж—¶ пјҢ йҒҮеҲ°зҡ„еҮ ж–№йқўй—®йўҳ пјҢ д№ҹз®—жҳҜSaltStackзҡ„дёҚи¶ід№ӢеӨ„ гҖӮ

еҶҚйҖҡиҝҮеҲҶжһҗе…¶еӨҡз§ҚдёҚеҗҢзҡ„йғЁзҪІжһ¶жһ„ пјҢ иғҪеҗҰ规йҒҝиҝҷдәӣй—®йўҳе’ҢдёҚи¶і гҖӮ еёҢжңӣиғҪеё®еҠ©еҲ°жңүйңҖиҰҒзҡ„жңӢеҸӢ们 гҖӮ

дёҖ пјҢ еҸ‘зҺ°е’ҢйҒҮеҲ°зҡ„й—®йўҳSaltstackжӢҘжңүејәеӨ§зҡ„иҝңзЁӢжҺ§еҲ¶иғҪеҠӣ пјҢ дҪҶеҹәдәҺе®ғе®һзҺ°зҡ„иҮӘеҠЁеҢ–иҝҗз»ҙзі»з»ҹеңЁе®һи·өиҝҮзЁӢдёӯеҸ‘зҺ°еӯҳеңЁд»ҘдёӢй—®йўҳпјҡ

1. Salt-masterиҠӮзӮ№дјҡеӣ CPUеҚ з”ЁиҝҮеӨҡиҖҢеҚЎжӯ» пјҢ еҸ‘йҖҒзҡ„е‘Ҫд»Өж— жі•е“Қеә” гҖӮ

гҖҗиҮӘеҠЁеҢ–иҝҗз»ҙд№ӢSaltStackпјҢжһ¶жһ„еҲҶжһҗе’ҢжҖ»з»“гҖ‘2. Salt-minionиҠӮзӮ№еҒ¶з„¶еҮәзҺ°ж— жі•жҺ§еҲ¶(иҝӣзЁӢжӯЈеёёдҪҶеӨұеҺ»иҝһжҺҘ)зҡ„жғ…еҶө гҖӮ

3. Salt-minionж•°йҮҸи¶ҠжқҘи¶ҠеәһеӨ§ пјҢ еҜ№й»ҳи®ӨйғЁзҪІжһ¶жһ„жҖ§иғҪе’ҢзЁіе®ҡжҖ§жңүеҪұе“Қ гҖӮ

й’ҲеҜ№д»ҘдёҠ1 пјҢ 3й—®йўҳ пјҢ жһ„е»әдёҖдёӘзЁіе®ҡзҡ„еҸҜжү©еұ•зҡ„SaltStackжһ¶жһ„жҳҜеҫҲжңүеҝ…иҰҒзҡ„ гҖӮ

иҮідәҺй—®йўҳ2 пјҢ дҪҝз”ЁжңҖж–°зүҲжң¬зҡ„minionиҝӣиЎҢжөӢиҜ• пјҢ еҸҜиғҪзҡ„жһ„е»әд»Јз Ғ规йҒҝжӯӨй—®йўҳ гҖӮ дҪҶжҳҜеҜ№дәҺwindowsзҡ„ж”ҜжҢҒ пјҢ е°ұеҫҲжңүйҷҗ пјҢ linuxжӣҝд»ЈwindowsиҝҷдёӘд№ҹжҳҜеӨ§еҠҝжүҖи¶Ӣ гҖӮ

дәҢ пјҢ SaltStackжһ¶жһ„еҲҶжһҗйҖҡиҝҮз ”иҜ»saltжңҖж–°зүҲж–ҮжЎЈ пјҢ жҖ»з»“еҮәдёӢйқўдёүз§Қе®ҳж–№жһ¶жһ„ пјҢ 并еҜ№жҜҸз§Қжһ¶жһ„дёҺйңҖжұӮзҡ„йҖӮеә”жҖ§дҪңеҮәжҖ»з»“ гҖӮ

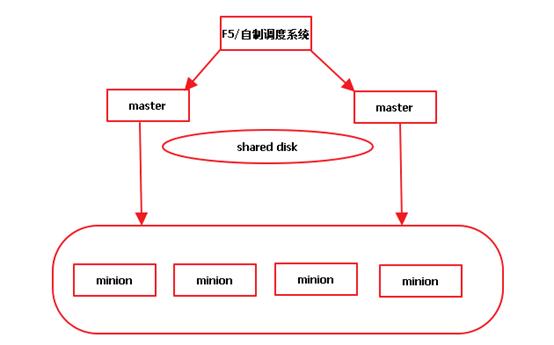

2.1 Multi-masterжһ¶жһ„ ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

иҝҷз§Қжһ¶жһ„ пјҢ д»ҘдёӨдёӘmasterдёәдҫӢ пјҢ еҜ№жҜҸдёӘеҜ№иұЎиҝӣиЎҢиҜҙжҳҺпјҡ

F5/иҮӘеҲ¶и°ғеәҰзі»з»ҹпјҡ еҜ№webдј иҝҮжқҘзҡ„иҜ·жұӮиҝӣиЎҢеҲҶжөҒ пјҢ еқҮиЎЎжҜҸдёӘmasterзҡ„иҙҹиҪҪ гҖӮ еӣ дёәF5ж— жі•еҲӨж–ӯйҖүжӢ©зҡ„masterиҠӮзӮ№жҳҜеҗҰиғҪеӨҹеҜ№жҢҮе®ҡзҡ„minionиҝӣиЎҢжҺ§еҲ¶ пјҢ еҚіF5ж— жі•еҲӨж–ӯsalt-masterжҳҜеҗҰе·Іж— жі•е·ҘдҪң пјҢ жүҖд»ҘжӯӨеӨ„жҲ‘们йңҖиҰҒйҖүз”ЁиҮӘеҲ¶зҡ„и°ғеәҰзі»з»ҹ гҖӮ жӯӨи°ғеәҰзі»з»ҹеә”иҜҘиғҪеӨҹжҸҗдҫӣдёҖдёӘеҸҜйқ зҡ„master пјҢ 并且иҝӣиЎҢз®ҖеҚ•зҡ„йҡҸжңәеқҮиЎЎ гҖӮ

Masterпјҡ жҜҸдёӘmasterйғҪдјҡиҝһжҺҘжүҖжңүзҡ„minion пјҢ еҸҜд»ҘжғіиұЎ пјҢ minionж•°йҮҸдјҡи¶ҠжқҘи¶ҠеӨҡ пјҢ masterе°Ҷж— жі•жүҝеҸ—и¶ҠжқҘи¶ҠеӨ§зҡ„еҺӢеҠӣ гҖӮ

Shared disk:е…ұдә«ж–Ү件/еӯҳеӮЁзҡ„еӯҳеңЁжҳҜеӣ дёәmasterд№Ӣй—ҙйңҖиҰҒдҝқжҢҒжҹҗдәӣж•°жҚ®зҡ„дёҖиҮҙжҖ§ гҖӮ

жҖ»з»“пјҡ

жӯӨжһ¶жһ„еҸҜд»ҘйҖҡиҝҮиҮӘеҲ¶и°ғеәҰжңҚеҠЎжқҘдҝқиҜҒmasterзҡ„зЁіе®ҡжҖ§(ж»Ўи¶ій—®йўҳ1) пјҢ дҪҶжҳҜж— жі•ж»Ўи¶ій—®йўҳ3 пјҢ еҚійҡҸзқҖminionж•°зӣ®зҡ„еўһй•ҝ пјҢ masterдјҡдёҚе ӘйҮҚиҙҹ гҖӮ

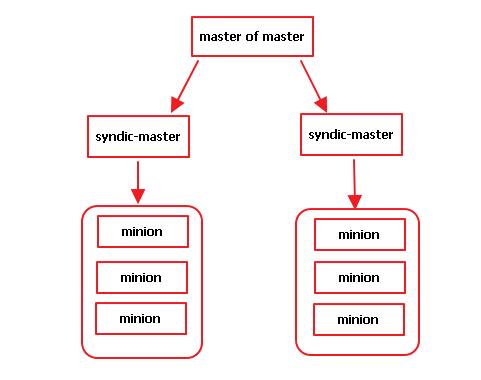

2.2 Syndicжһ¶жһ„ ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

иҝҷз§Қжһ¶жһ„ пјҢ д»ҘдёӨдёӘsyndic-masterдёәдҫӢ пјҢ еҜ№жҜҸдёӘеҜ№иұЎиҝӣиЎҢиҜҙжҳҺпјҡ

Syndic-masterпјҡжҳҜд»ӢдәҺminionе’Ңmasterд№Ӣй—ҙзҡ„дёҖз§Қзұ»еһӢ пјҢ зӣёеҪ“дәҺеҜ№ж•ҙдҪ“зҡ„saltз»“жһ„иҝӣиЎҢеҲҶеүІ пјҢ жҜҸдёӘsyndic-masterиҠӮзӮ№жҺ§еҲ¶дёҖйғЁеҲҶminions пјҢ еӣ жӯӨй’ҲеҜ№й—®йўҳ3 пјҢ иҝҷжҳҜдёӘеҗҲйҖӮзҡ„и§ЈеҶіж–№жЎҲ гҖӮ

Master of masterпјҡжҳҜдҪҚдәҺsyndicдёҠеұӮзҡ„masterиҠӮзӮ№ пјҢ д»ҺиҜҘиҠӮзӮ№дёҠжү§иЎҢsalt-key вҖ“LеҸӘиғҪзңӢеҲ°syndicиҠӮзӮ№зҡ„key пјҢ ж— жі•зңӢеҲ°иҝһжҺҘеҲ°syndicзҡ„minionз«Ҝзҡ„key пјҢ дҪҶжҳҜд»ҺжӯӨmasterиҠӮзӮ№еҸ‘йҖҒжҢҮд»ӨеҲ°жҹҗдёӘminionз«ҜжҳҜеҸҜиЎҢзҡ„ гҖӮ

жҖ»з»“пјҡ

SyndicжЁЎејҸеҲҶеүІдәҶsaltstackж•ҙдҪ“ пјҢ еҢ–ж•ҙдёәйӣ¶иҝӣиЎҢз®ЎзҗҶ пјҢ еҜ№дәҺеӨ§и§„жЁЎзҡ„йғЁзҪІиҫғдёәжңүеҲ© гҖӮ дҪҶжҳҜ пјҢ жӯӨжһ¶жһ„жңӘиғҪдҝқиҜҒmasterзҡ„зЁіе®ҡжҖ§ пјҢ еҪ“master of masterиҠӮзӮ№еҮәзҺ°й—®йўҳ пјҢ жӯӨжһ¶жһ„е°Ҷж— жі•е·ҘдҪң гҖӮ

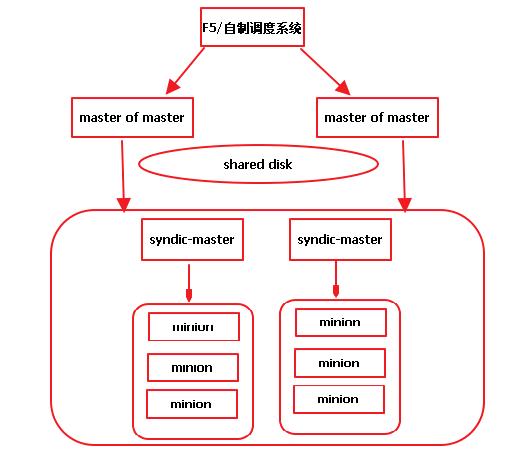

2.3 Syndic-with-multimasterжһ¶жһ„ ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

иҝҷз§Қжһ¶жһ„ пјҢ з»јеҗҲmulti-masterе’Ңsyndic пјҢ дҪҝй—®йўҳ1е’Ңй—®йўҳ3еҫ—еҲ°еҹәжң¬и§ЈеҶі гҖӮ

дҪҝз”ЁиҜҘжһ¶жһ„еә”иҜҘзқҖйҮҚиҖғиҷ‘дёӢйқўеҮ зӮ№пјҡ

1гҖҒиҮӘеҲ¶и°ғеәҰзі»з»ҹзҡ„жһ„е»әиҫғдёәеӨҚжқӮ пјҢ е®ғеә”иҜҘиғҪе®һзҺ°дёӢеҲ—еҠҹиғҪпјҡ

a) з”ЁжҲ·жҢҮд»ӨеҲ°иҫҫж—¶ пјҢ иғҪеӨҹе®ҡеҗ‘еҲ°жҹҗдёӘеҸҜз”Ёзҡ„masterдёҠ гҖӮ

b) еә”иғҪеӨҹиҫҫеҲ°з®ҖеҚ•зҡ„еқҮиЎЎж•Ҳжһң пјҢ еҸҜд»ҘйҖҡиҝҮйҡҸжңәж•° гҖӮ

c) еә”иғҪеӨҹеҸ‘зҺ°е№¶и§ЈеҶіmasterеҮәзҺ°еҚЎжӯ»зҡ„й—®йўҳ гҖӮ

d) еә”иғҪеӨҹиҪ¬йҖҒwebз«ҜдёҺpythonз«Ҝзҡ„ж•°жҚ®еҢ… пјҢ еҸҜд»ҘиҖғиҷ‘зү№ж®Ҡзҡ„sockжЁЎејҸ гҖӮ

2гҖҒMinionз«ҜжіЁеҶҢж—¶йңҖиҰҒжңү规еҲ’зҡ„йҖүжӢ©жҹҗдёӘsyndic-masterиҠӮзӮ№ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- еҚҺдә‘еӨ§е’–иҜҙ дә‘и®Ўз®—дә‘иҝҗз»ҙжө…и°Ҳ

- еҲқжҺў iOS иҮӘеҠЁеҢ–е·Ҙе…·вҖ”вҖ”еҝ«жҚ·жҢҮд»Ө

- иғҪиЈ…иҝӣеҸЈиўӢзҡ„е·ҘзЁӢеёҲиҝҗз»ҙ笔记жң¬пјҡеЈ№еҸ·жң¬еЈ№еҸ·е·ҘзЁӢеёҲPC A1

- еӣҪ家з”өзҪ‘иҮӘеҠ©з»Ҳз«ҜйӣҶжҲҗеҗ‘ж—Ҙи‘өпјҢиҝңзЁӢиҝҗз»ҙе®үе…Ёй«ҳж•Ҳ

- жҳҹйёҹе…¬еҸёе»әз«Ӣж•°жҚ®иҝҗз»ҙзӣ‘жҺ§дёҺз»ҙжҠӨдҪ“зі» зЎ®дҝқж•°жҚ®еҮҶзЎ®жҖ§

- иҮӘеҠЁеҢ–зӣҲеҲ©пјҡйқ гҖҢзҹҘд№ҺеҘҪзү©жҺЁиҚҗгҖҚжңҲе…ҘиҝҮдёҮ

- дёҠжө·йҒ“е®ўпјҡе·ҘдёҡеӨ§ж•°жҚ®еңЁз”ҹдә§и®ҫеӨҮжҷәиғҪиҝҗз»ҙйўҶеҹҹзҡ„еә”з”Ё

- еҳҳпјҒеҒ·зӘҘй№…еҺӮиҝҗз»ҙ专家пјҢи®©LinuxеҶ…ж ёеҘ”и·‘иө·жқҘдёҚеҫ—дёҚиҜҙзҡ„з§ҳеҜҶ

- е·ҘдҪң|еҘҪд№ҰВ·д№Ұж‘ҳдёЁвҖңиҮӘеҠЁеҢ–вҖқзңҹзҡ„жҳҜAIзӢ¬з«Ӣе®ҢжҲҗзҡ„еҗ—пјҹ

- иҮӘеҠЁеҢ–|е”җжһ—еһҡпјҡвҖңи„ұзҰ»з®—жі•иҮӘеҠЁеҢ–еҶізӯ–жқғвҖқзҡ„иҷҡе№»жүҝиҜә