基于关系推理的自监督学习无标记训练

文章插图

文章插图

背景与挑战在现代深度学习算法中 , 对未标记数据的手工标注是其主要局限性之一 。 为了训练一个好的模型 , 我们通常需要准备大量的标记数据 。 在少数类和数据的情况下 , 我们可以使用带有标签的公共数据集的预训练模型 , 并使用你的数据微调最后几层即可 。

但是 , 当你的数据很大时(比如商店中的产品或人的脸 , ..) , 很容易遇到问题 , 并且仅通过几个可训练的层就很难学习模型 。 此外 , 未标记数据(例如 , 文档文本 , Internet上的图像)的数量是不可数的 。 为任务标记所有标签几乎是不可能的 , 但是不使用它们绝对是一种浪费 。

在这种情况下 , 使用新的数据集从头开始训练深度模型是一种选择 , 但是使用预先训练的深度模型时标记数据需要花费大量的时间和精力 , 这似乎不再有帮助 。 这就是自监督学习诞生的原因 。 这背后的想法很简单 , 主要有两个任务:

- 代理任务:深度模型将从没有注释的未标记数据中学习可归纳的表示 , 然后能够利用隐式信息自行生成监督信号 。

- 下游任务:将针对监督学习任务(如分类和图像检索)对表示进行微调 , 标记数据的数量更少(标记数据的数量取决于模型的性能 , 具体取决于你的需求)

- 相对位置[1]:模型需要理解对象的空间上下文 , 以判断部件之间的相对位置;

- 拼图游戏[2]:模型需要将9个打乱的补丁放回原始位置;

- 着色[3]:模型已训练为对灰度输入图像进行着色;确切的任务是将该图像映射到量化的颜色值输出上的分布;

- 计数特征[4]:模型利用输入图像的特征计数关系 , 通过缩放和平铺来学习特征编码器;

- SimCLR[5]:该模型通过潜在空间中的对比损失来最大化同一样本不同增强视图之间的一致性 , 从而学习视觉输入的表示形式 。

关系推理范式基于一个关键的设计原则:使用关系网络作为未标记数据集的可学习函数 , 量化同一对象视图之间的关系(内部推理)和不同场景中不同对象之间的关系(交互推理) 。 通过在标准数据集(CIFAR-10、CIFAR-100、CIFAR-100-20、STL-10、tiny-ImageNet、SlimageNet)、学习进度和主干(两者)上的性能来评估通过关系推理在自监督机器学习中利用类似机制的可能性 。

结果表明 , 关系推理方法在所有条件下都比最好的竞争对手平均高出14%的准确率 , 而最新的方法比此文() 的方法高出3% 。

技术亮点

文章插图

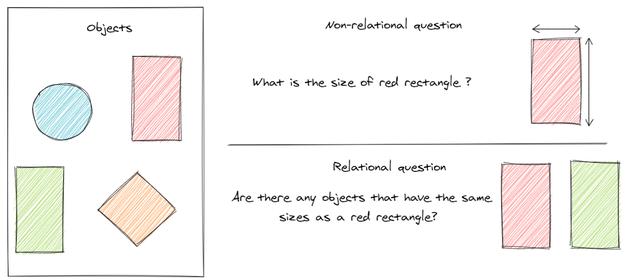

文章插图简单地说 , 关系推理只是一种方法论 , 它试图帮助学习者理解不同对象(思想)之间的关系 , 而不是单独地学习对象 。 这有助于学习者根据自己的差异轻松地辨别和记忆物体 。

关系推理系统有两个主要组成部分:主干结构和关系头 。 在代理任务阶段使用关系头来支持底层神经网络主干学习未标记数据集中的有用表示 , 然后将其丢弃 。 在代理任务训练后 , 将主干结构用于后续任务 , 如分类或图像检索 。

- 以前的工作:关注场景内的关系 , 意思是同一对象中的所有元素都属于同一场景(例如 , 篮子中的球);在标签数据集上进行训练 , 主要目标是关系 。

- 新的方法:关注同一对象不同视图之间的关系(内部推理)和不同场景中不同对象之间的关系(交互推理);对未标记的数据使用关系推理 , 关系头是学习底层主干中有用表示的代理任务 。

推荐阅读

- 华硕基于WRX80的主板现身 为AMD Ryzen Threadripper Pro打造

- 微软新版电子邮件客户端截图曝光:基于网页端Outlook

- 曝光 | 小鹏或春节前推送NGP更新,基于高精地图可自动变道

- 基于Spring+Angular9+MySQL开发平台

- 14款华为手机/平板公测EMUI 11:全部基于麒麟980

- AI赋能,让消防、用电更“智慧”

- 荷兰职员哭泣:中国明明说好自研光刻机,却跟日本尼康扯上关系

- 基于安卓11打造!魅族17系列将升级全新Flyme 8

- 谷歌为用户提供了基于AR的虚拟化妆体验

- 挺进云端AI训练&推理双赛道!独家对话燧原科技COO张亚林:揭秘超高效率背后的“内功”