不会编程也能做酷炫视频风格迁移?这个工具冲上Reddit热榜

贾浩楠 发自 凹非寺量子位 报道 | 公众号 QbitAI

这两天 , Reddit上一则关于视频风格迁移的帖子火了 , 发布仅一天就冲上了机器学习社区的热榜第一 。

明艳、华丽的Demo引起了网友们惊叹 。

著名的恐怖片《闪灵》经过处理后 , 变得色彩明艳 , 有了漫画风格:

文章插图

文章插图

而电影《低俗小说》 , 处理效果像极了天主教堂五彩缤纷的玻璃窗:

文章插图

文章插图

大家纷纷留言追问“是不是对CNN的层过滤器进行过修改”?

但楼主却说「我不是程序员 , 也不清楚CNN是什么东西…….」

这就有点不可思议了 , 一个没接触过机器学习的小白 , 是怎么做到效果这么好的视频风格迁移呢?

「一键式」视频风格迁移工具Reedit热帖的楼主 , 是一位纯艺术从业者 , 没学过计算机和编程 。

文章插图

文章插图

但是他却却借助一款「一键式」的傻瓜工具 , 轻松完成了视频风格迁移 。

这款工具名叫Deep Dream Generator 。

熟悉图像风格迁移的读者可能对Deep Dream很熟悉 , 早在2015年谷歌就公布了这个软件 。

最早Deep Dream是为2014年ImageNet视觉识别挑战赛而开发的 , 主要的目的也是识别图像中的人脸和其他目标 。

文章插图

文章插图

但是随后有人发现 , 经过训练的Deep Dream能够反向运行 , 将给定图片的像素特征整合到目标中 。

随后 , Deep Dream开始在艺术创作圈流行 , 由它生成的风格迁移图像颇具梦幻色彩 , 所以被叫做「Deep Dream」 。

文章插图

文章插图

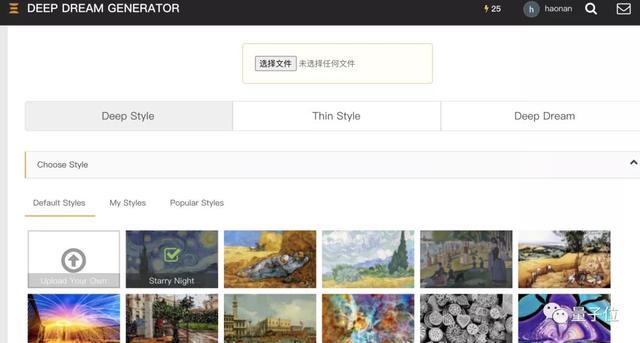

而制作这个工具的团队将Deep Dream做成了简单易上手 , 不需要任何计算机知识 , 能够直接在网页使用的版本 。

使用很简单 , 只需要上传目标图像和「风格」 , 一键点击 , 就能生成 。

文章插图

文章插图

生成的图片效果完全由上传的「风格」决定:

文章插图

文章插图

有了这工具 , 就算是既不懂艺术 , 也不懂编程的小白 , 也能批量生产艺术作品 。

视频风格迁移的两种方法尽管Deep Dream Generator官网上并没有给出任何技术说明 , 但Deep Dream早已开源 , 并且风格迁移已经是深度神经网络应用中轻车熟路的一个领域了 。

一般常见的风格迁移迁移算法由两种基本思路 , 一是优化法 , 第二种是在它之上优化而来的前馈法 。

优化法在这种方法中 , 其实并没有使用真正意义上的神经网络 。

任务中并没有训练神经网络来做任何事情 。 只是利用反向传播的优势来最小化两个定义的损失值 。

反向传播到的张量是希望实现的图像 , 从这里开始我们称之为「复刻」 。 希望转移其风格的艺术品 , 称为风格图像 。 而要将风格转移到其中的图片 , 称为内容图像 。

「复刻」被初始化为随机噪声 。 然后与内容和风格图像一起 , 通过一个预先训练过的图像分类网络的几个层 。

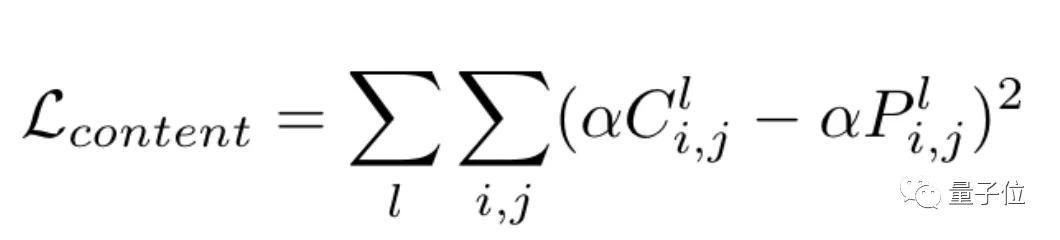

算法使用各个中间层的输出来计算两种类型的损失:风格损失和内容损失 。 在风格上 , 「复刻」与风格图像有多接近 , 在内容上就有有多接近 。

文章插图

文章插图

推荐阅读

- 目前配置全性价比高的手机,我只推荐五款,闭着眼买都不会错

- HTC创始人表态:不会放弃5G手机

- 机器人|万州区举办“中国梦科技梦”机器人编程大赛

- 创始人表态:不会放弃5G手机

- 爆料称三星 Galaxy S21 将取消 microSD 卡槽,一些市场不会附赠充电器

- 详解工程师不可不会的LRU缓存淘汰算法

- 不止玩游戏!肯德基也要出主机:还能做烤鸡?

- 城市|打造数字长三角 上海能做什么?

- 英特尔推出可检测代码错误的ControlFlag机器编程工具

- 可编程3D打印耗材可帮助普通3D打印机轻松实现多材料物品的制作