惠普Z8 G4工作站评测:中小型AI模型训练“神器”( 三 )

文章插图

文章插图

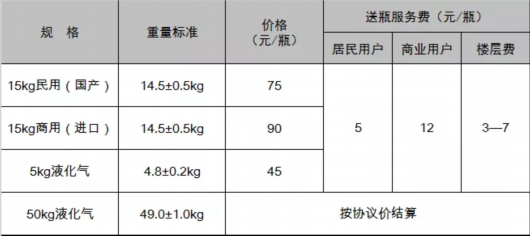

(2)基于PASCAL VOC和MS COCO数据集的目标检测模型训练由训练的结果可以看到 , 在数据量不大的CIFAR-10上的分类模型训练 , 当batch设置为5000的时候 , 仅仅只花费了7分钟的时间 。 在大型数据集ImageNet上 , batch同样设置为5000的时候 , 也只花费了3.5个小时 。 当然这个准确率可能不太高 , 但本次实验主要希望得到的是HP Z8 G4工作站的模型训练能力 , 即计算能力 , 而不是算法的好坏 。

- – 模型介绍与数据集介绍

在本次的试验中 , 我选择了目标检测领域经典的网络模型YOLOv3 , 并将使用它分别在PASCAL VOC和 MS COCO数据集上进行检测模型的训练 。

【惠普Z8 G4工作站评测:中小型AI模型训练“神器”】PASCAL VOC和MS COCO都是目标检测领域比较常用的数据集 。 同时在使用PASCAL VOC数据集的时候 , 我同时选用了PASCAL VOC 2007和PASCAL VOC 2012并将其合并 , 包含了20类物体 , 共计约16万张训练数据 , 2G图像数据 。 而MS COCO比PASCAL VOC的数据更加复杂 , 其中包含了91个物体类别 , 共计约有20G的图像数据 。

- – 模型训练与结果

三、总结通过训练的结果来看 , YOLOv3在较小的PASCAL VOC数据集上训练50020轮的时候 , 只需要花费5个小时的时间 。 在具有20G图像数据的MS COCO上训练50020轮的时候 , 需要花费34个小时 , 相当于1.5天 , 时间相对来说还是比较长的 。 不过因为本次训练只是看模型训练的能力 , 因此整体的训练效率还是比较高的 。

HP Z8 G4工作站所提供的显存真的非常大 。 两块NVIDIA Quadro RTX 8000 , 提供2 x 48G的显存 。 在CIFAR-10分类模型训练过程中 , 我通过不断调整batch大小后发现 , 当batch=512的时候 , 才会产生显存不足的问题 , 从而导致无法正常训练 。

虽然batch的增大会一定程度上提高模型的泛化能力和稳定性 , 但随着batch的增大 , 模型的性能反而会下降 。 因此一般情况batch的设置不会太大 , 常用的设置为32、64和128 。 而48G的显存在最大程度上提供了稳定性和提高batch的可能性 。

最后从整体的使用体验来看 , HP Z8 G4工作站凭借着两块NVIDIA Quadro RTX 8000为整个训练提供了足够的计算能力 。 完全可以满足中小型模型训练的算力需求 。

同时因为其卓越冷却设计和惠普高效的散热解决方案 , 在整个训练过程中并没有出现很大的噪音和很大的热量 , 避免了影响其他同事的工作 。

推荐阅读

- “横屏旗舰”iQOO 7评测:在极致体验的赛道上一路狂奔

- 红米k40pro和iqooneo3哪个好性价比高 参数对比区别评测

- 惠普发布Elite Dragonfly G2与Elite Dragonfly Max等笔记本新品

- 恩杰KRAKEN X73 RGB评测:颜值升级无穷尽

- 可靠实用的最佳拍档 法翼T1执法记录仪体验评测

- 释放耳机无线潜能 飞傲UTWS3真无线耳放评测

- 20分钟电池回血大半!realme真我V15评测:1399元中端王炸全面升级

- 内存大厂跨界之作!芝奇Enki 360一体式水冷评测:高密度冷排稳压18核心

- 首款7GB/s SSD!三星980PRO 1TB评测:永恒的1.8GB/s缓外写入速度

- 华为畅享20se和红米note9哪个好区别在哪 参数对比评测