DeepTech深科技|或能识别从未见过的事物,一种新方法或让AI模型拥有“联想”力( 二 )

因此 , 仅仅用这个超精简数据集对人工智能模型进行训练 , 就可以达到与用MNIST所有图像进行训练的模型几乎一致的识别精度 。

文章图片

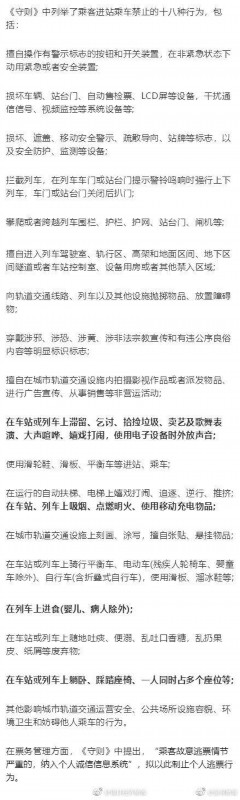

图|MNIST数据集样例

文章图片

图|“蒸馏”后的MNIST精简数据集 。 以上10张图是从MNIST所含6万张图像中提纯出的 , 可以用于训练人工智能模型 , 并且它们在识别手写数字时拥有94%的准确性 。

伊利亚和导师从中受到启发 , 并且认为可以在TongzhouWang的方法上更进一步——既然可以将6万张图像压缩到10张 , 那么为什么不能将它们压缩到5张或更少呢?一旦实现 , 就意味着 , 通过区区几张图象的训练 , 人工智能模型就能掌握从0到9这10个数字的各种手写数字图片 , 从而实现前面所说的N大于M 。

伊利亚很快发现 , 想要达到这个效果的诀窍就是创建混合有多个数字特征的图像 , 然后为它们打上“软标签(让一个数据点同时成为多个类别成员的矢量表示)” , 再来用这些样本训练人工智能模型(类似于前文的马+犀牛混合体) 。

“你可以想象一下数字3 , 它看起来有点像8 , 但一点都不像7 。 ”伊利亚说 。

文章图片

“软标签的目的在于标注这些共同的特征 , 进而以这种方式增加信息密度和维度 。 因此 , 相比于直接告诉模型这个图像是3 , 我们会说 , 这个图像有60%可能是3 , 30%可能是8 , 10%可能是0 。 ”使用这种数据训练出的模型 , 基本可以达到与常规训练方式一样的精度 。

“少于一个”样本学习的局限性当伊利亚和导师成功地使用软标签在MNIST上实现“少于一个”样本学习后 , 他们开始思考这个方法能否用于更广阔的领域 。 人工智能模型从小样本中可以识别出的类别数量是否存在上限?

答案是否定的 。

从理论上来看 , 使用精心设计的软标签 , 甚至只用两个示例就可以承载任意数量的类别信息 。 伊利亚说:“通过两个数据点 , 你就可以分离出一千个 , 一万个 , 甚至是一百万个类别 。 ”

伊利亚和导师通过纯数学方式的推导 , 在论文中证明了这一点 。 他们使用一种最简单的机器学习算法——K-近邻算法(kNN)来表述这一概念 , 该算法使用图形方法来为对象分类 。 值得注意的是 , 他们在kNN算法的基础上进行了开发 , 并将最终的算法称为SLaPkNN(soft-labelprototypekNearestNeighbors) 。

在进一步说明之前 , 有必要以水果分类任务为例 , 简单说明kNN算法的核心逻辑 。

假设我们要训练kNN模型识别苹果和橙子 , 你必须先确定每个水果的特征 , 这里以颜色(X轴)、重量(Y轴)为例 。 这样你就可以将多个苹果和橙子的信息输入kNN模型 。

kNN算法会将所有数据点绘制在一张二维图表上 , 并在苹果和橙子分布点的中间地带绘制边界线 。

文章图片

图|kNN算法原理 。 由图可见 , 坐标轴上分布着红苹果、青苹果和橙子的数据点 。 当模型需要判定黑色点属于哪种水果时 , 它会依据蓝色框选区域内的色彩分布 , 将比例最大的橙色判断为“邻近” , 进而将黑色点归类为橙子 。

为了将kNN算法应用于“少于一个”样本学习 , 伊利亚和导师创建了一系列微型的合成数据集 , 并精心设计了它们的软标签 。

然后 , 他们让kNN算法绘制了它从样本中看到的边界线 , 发现它成功地将样本分成了比数据点更多的类别 。

推荐阅读

- 三星公司发布2021款数字座舱 集成诸多高科技

- 刚有望“出人头地”就被三大科技巨头围剿,“挺川者”新阵地下线

- 谷歌建立新AI系统 可开发甜品配方

- 柔性电子市场广阔,领头羊柔宇科技获更多关注

- 曝LG也将推出卷轴屏手机 你怎么看?

- AI战疫、真5G来了,十大最热门科技应用演绎速度与温度

- 又爆炸!联电科技传来一声巨响,或把8 英寸晶圆市场"炸"了

- 唐山四维智能科技有限公司:双臂机器人引领人机协作新纪元

- 谷歌新款Nest Hub或能追踪睡眠 但外媒提出诸多疑问

- 国家超算郑州中心首批重大科技专项启动