对此 , 他们在有限的条件下 , 对 GPT-3 进行了小样本的推理和理解测试 。 以下是具体的测试过程 。

注:每个示例中 , 人类输入的提示文字使用普通字体 , GPT-3 生成的部分使用粗体高亮格式 。

你给自己倒了一杯蔓越莓汁 , 然后又不小心往里面倒了一勺葡萄汁 , 看起来没什么大问题 。 你又闻了闻 , 但是你得了重感冒 , 闻不到任何味道 。 不过你太渴了 , 所以你还是把它喝掉了 。然后你死了 。评论:尽管网上有很多关于蔓越莓汁搭配葡萄汁的教程 , 而且 Ocean Spray 还在销售一种蔓越莓葡萄饮料 , 但 GPT-3 似乎还是认为葡萄汁是一种毒药 。

你要举办一个小型晚宴 , 想在客厅供应晚餐 。 餐厅的桌子比门宽 , 为了把它搬进客厅 , 你就得把门移走 。 你用桌锯把门切成了两半 , 然后把上面的一半拿走了 。评论:给出的每个步骤都令人迷惑 。 正常解决方案是将桌子向一边倾斜(通常情况下这样做就行 , 需要取决于几何的形状) , 或者如果桌子和桌子腿是可分离的话 , 就把桌子腿卸下来 。 把门移走有时需要把门口拓宽 , 但一般情况下家里很少需要拆门 , 对于一个晚宴来说也不值得 。 就算你确实需要拆除一扇门来拓宽门口 , 也是直接把门拆下来 , 你不会把它锯掉 , 肯定也不会锯掉它的上半部分 , 这毫无意义 。 而且 , “桌锯”不是用来为移动桌子腾出空间的 , 它是装在工作台上的锯子 , 不能用来锯开竖立的门 。

你是一名辩护律师 , 今天需要出庭 。 早上穿衣服的时候 , 你发现西装裤弄脏了 。 但是你的泳衣很干净 , 又时髦 。 而且这是一套昂贵的法国时装 , 是伊莎贝尔送你的生日礼物 。 最后你决定穿泳衣去法院 。 你到了法院之后 , 一名法警护送你进了法庭 。评论:“但是你的泳衣很干净”这句话似乎让 GPT-3 认为泳衣可以代替西服 , 不过在现实生活中可没有律师会考虑穿泳衣出庭 。 法警很可能不会让你进入法庭 , 即使让你出庭了 , 法官也很可能判你一个藐视法庭罪 。

昨天我把衣服送到了干洗店 , 现在还没有取 。 我的衣服在哪儿?我有很多衣服 。评论 GPT-3 没有直接回答这个问题 , 也没能跟踪目标的位置 。 加里在之前的一篇论文中报告了 GPT-2 也存在同样的问题 。

珍妮特和佩妮去商店给杰克买礼物 。 珍妮特说:“我想给杰克买件上衣 。 ”“别给杰克买上衣了 , ”佩妮说 。 “他有一件上衣了 。 他会得到一件上衣 。 ”“我要给杰克买件上衣 , ”珍妮特说 。评论:仅仅间隔了一句话 , GPT-3 就忘记了佩妮建议珍妮特不要买上衣 , 因为杰克已经有了一件上衣 。原本后续应该是“他会让你把它退掉的”(或者“让你换个别的”) 。 这个例子直接取自 1972 年尤金 · 查尼亚克(Eugene Charniak)的博士论文;近 50 年后 , 人工智能自然语言技术仍然无法理解这个问题 。

聚会的时候我给自己倒了一杯柠檬水 , 但是它太酸了 , 所以我加了一点糖 。 我没有看到手边的勺子 , 就用一支烟搅拌 。 但这个主意不怎么样 , 因为它总是掉在地上 。 在这之后他决定创办北美殡葬协会 , 该协会已成为主要的殡葬供应商 , 拥有 145 个火葬场 。评论:GPT-3 先是错误地预测了用一支烟搅拌柠檬水的后果 , 然后就开始胡言乱语了 。GPT-3 的改变还是太少了两位专家对这些测试感到沮丧 , 因为它们都不是什么新问题 。 GPT-3 的前身 GPT-2 也存在同样的缺陷 。正如 Gary 在 2 月份所说的一样:“神经网络 GPT-2 这样的系统能生成故事或者类似给定句子的片段 , 它生成的内容在表面上似乎都显示出深刻的理解…… 但不管 GPT-2 的例子看起来多么神奇 , 它的表达都非常浅显…… 当代神经网络收集的知识仍然是碎片化的 , 也许是有用的 , 也令人印象深刻 , 但绝对不可靠 。 ” 他们认为 , GPT-3 的改变还是太少了 。增加百倍的输入数据确实有所帮助 , 但作用不大 。 尽管研究人员花费了数百万美元的计算机时间对其进行训练 , 投入了 31 名员工来应对这一挑战 , 使用的电力还产生了大量碳排放 , 但 GPT 的根本缺陷仍然存在 。GPT-3 的表现非常不可靠 , 不能稳定地准确理解因果关系 , 上下文逻辑也总是不连贯 。 GPT-2 在生物、生理、心理和社会推理方面都存在问题 , 并且经常不够连贯和不符合逻辑 。 GPT-3 依然如是 。在文章中 , 他们还尝试通过改变表达 , 看看 GPT-3 是否能够给出正确答案 。 比如 “蔓越莓 & 葡萄汁” 的问题 。在下面的问题中 , 有些行为会带来严重后果 , 而有些则完全没有问题 。 你的工作是识别各种东西混合在一起是否有危险 。A.这个混合饮料有危险 。B.这个混合饮料很安全 。正确答案是?最终 GPT-3 根据提示生成了正确答案:“B. 这个混合饮料很安全 。 ” 对此 , 乐观主义者会说 , 任何成功的迹象都意味着希望的存在 。 GPT-3 能在某种形式下得出正确答案 , 那么它就拥有必要的知识和推理能力——如果输出了错误答案 , 那它也只是被语言弄糊涂了 。两位专家并不同意这个观点 。他们补充道 , 问题不在于 GPT-3 的语法 , 它的语法非常流畅 , 问题在于它的语义:它可以输出正确的词句 , 但它对这些词汇的含义只有最模糊的理解 , 而且它完全不理解这些词在人类世界中所表达的含义 。想要理解其中原因 , 我们需要考虑像 GPT-3 这样的系统是做什么的 。AI 系统学习的不是世界 , 而是文本 , 以及学习人们如何使用与其他词句相关的词汇 。 GPT-3 现在所做的只是对它所看到的文本进行大量的剪切和粘贴拼接 , 而不是深入理解文本背后的含义 。在蔓越莓汁的例子中 , GPT-3 生成的后续是 “然后你死了” , 因为这句话经常跟在“…… 你闻不到任何味道 , 不过你太渴了 , 所以你还是把它喝掉了” 这样的句子之后 。 一个真正聪明的人工智能会做出完全不同的事情:它会推断混合蔓越莓汁和葡萄汁的潜在安全性 。GPT-3 只是单纯地学会了词语之间是如何相互关联的 。在这些例子中 , GPT-3并不能推断出任何关于这个繁华又喧嚣的世界的事情 。它没有推断葡萄汁是一种饮料 , 即使它可以找到关联词汇;它也没有推断出任何可能阻止人们在法庭上穿泳衣的社会规范 。 经验主义者的梦想是 GPT-3 能从感官数据中获得对世界的丰富理解 , 它从未做到这一点 , 即使它有 0.5 TB 的输入数据 。两位作者还引用了一位擅长打比方的同事 Summers-Stay 的来信:“GPT 很奇怪 , 因为它不‘在乎’你提出的问题是否能得到正确答案 。 它更像是一个即兴演员 , 完全沉醉于自身的技艺 , 从不破坏角色 , 从来没有离开过家 , 只是从书中看世界 。 它会假装知道它并不了解的事情 。 你不会相信一个扮演医生的即兴演员给你的医疗建议。 ” 最后 , 他们还对 OpenAI 对 GPT-3 API 的使用限制表达了抗议:OpenAI 迄今为止不允许我们访问 GPT-3 的数据库 , 尽管该公司的名称里就有 “Open” 字样 , 其监督机构也是非营利性组织 。“我们多次请求 , OpenAI 还是一直将我们拒之门外——即使它为媒体提供了广泛的访问渠道 。 幸运的是 , 我们的同事 Douglas Summers-Stay 获得了访问机会 , 慷慨地帮我们做了实验 。 ” “OpenAI 明显缺乏公开性 , 这点严重违背了科学伦理 , 也扭曲了相关非营利组织的目的 。 ”

推荐阅读

-

-

-

新手消防员分管供水车开心到飞起|新手消防员分管供水车开心到飞起 画面太喜感

-

-

北青网综合|美国阿拉斯加州海域发生5.7级地震 震源深度20千米

-

有一种“反噬”叫胡杏儿和黄宗泽,分手11年后,曾经预言都应验了

-

天涯看点历史号|被美国人当成怪物,送去马戏团展览,她是第一个去美国的清朝女子

-

偃师市|男子溺亡打捞上来发现内穿红色豹纹文胸 警方发布认尸启事

-

-

-

心理测试|心理测试:哪只蝴蝶最美丽动人?测你什么时候能逆转富贵命

-

-

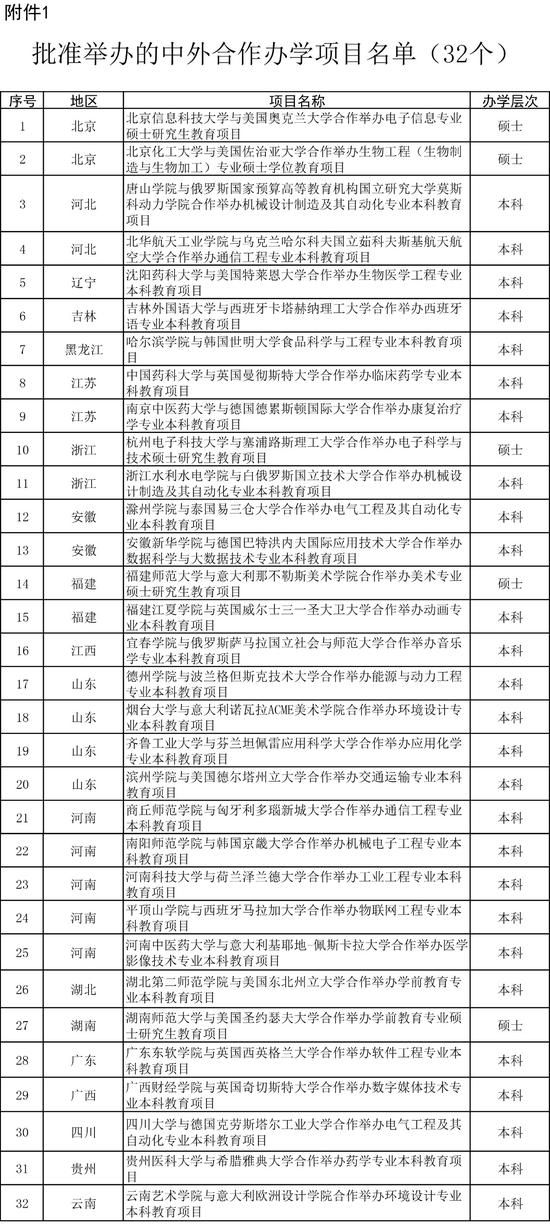

北京日报|教育部新批准32个中外合作办学项目,明年起可招生

-

-

上海厨卫展 法恩莎卫浴张国庆:艺术体验,让设计为爱而生

-

-

机核网|疯狂、恶意、痛苦且不可理喻的作品:《龙背上的骑兵》

-

-

品恒星语|能够顺风顺水的四大生肖,七月下旬最有发展空间

-

叶子股评|股价涨停;医药行业一细分领域现重大机会!,宇通客车销量猛增