йҒҚеҺҶ|иҜҚеөҢе…Ҙзҡ„з»Ҹе…ёж–№жі•пјҢе…ӯзҜҮи®әж–ҮйҒҚеҺҶWord2vecзҡ„еҸҰзұ»еә”з”Ё

жңәеҷЁд№ӢеҝғеҲҶжһҗеёҲзҪ‘з»ң

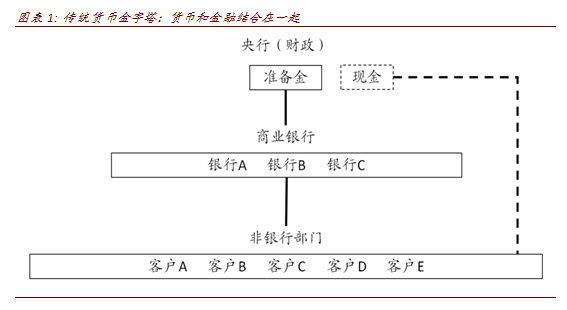

еңЁжң¬ж–ҮдёӯпјҢдҪңиҖ…йҰ–е…ҲдёәиҜ»иҖ…жҷ®еҸҠдәҶ word2vec зҡ„еҹәзЎҖзҹҘиҜҶпјҢ然еҗҺд»Ҙе…ӯзҜҮи®әж–ҮдёәзӨәдҫӢиҜҰз»Ҷд»Ӣз»ҚдәҶеҪ“еүҚз ”з©¶еҰӮдҪ•еҲ©з”Ёз»Ҹе…ё word2vec иҝӣиЎҢжӢ“еұ•жҖ§з ”究гҖӮе…¶дёӯпјҢдҪңиҖ…йҮҚзӮ№д»Ӣз»Қзҡ„йғЁеҲҶжҳҜзҹҘиҜҶеөҢе…Ҙз©әй—ҙзҡ„з”ҹжҲҗиҝҮзЁӢпјҢеҜ№дәҺе…¶е®Ңж•ҙеә”з”Ёж„ҹе…ҙи¶Јзҡ„иҜ»иҖ…еҸҜд»ҘеҸӮйҳ…еҺҹи®әж–ҮгҖӮ

йҡҸзқҖж·ұеәҰеӯҰд№ зҡ„е…ҙиө·пјҢжҜҸдёӘжЁЎеһӢйғҪйңҖиҰҒдёҖдёӘиҫ“е…ҘпјҢиҖҢжҲ‘们зҺ°е®һз”ҹжҙ»дёӯзҡ„еҜ№иұЎпјҲж–Үеӯ—гҖҒеӣҫзүҮпјүзӯүзӯүйғҪдёҚжҳҜж•°еӯ—пјҢи®Ўз®—жңәж— жі•еӨ„зҗҶгҖӮжүҖд»ҘеҰӮдҪ•дёәжҜҸдёӘд»»еҠЎзЎ®е®ҡдёҖдёӘеҗҲйҖӮзҡ„ вҖңиҫ“е…ҘвҖқ е°ұеҸҳеҫ—е°Өе…¶йҮҚиҰҒдәҶпјҢиҝҷдёӘиҝҮзЁӢд№ҹиў«еҸ«еҒҡиЎЁеҫҒеӯҰд№ гҖӮ

word2vec еҒҡзҡ„е°ұжҳҜжҠҠж–Үеӯ—еҸҳжҲҗеҜ№и®Ўз®—жңәжңүж„Ҹд№үзҡ„иҫ“е…ҘпјҢз®ҖеҚ•жқҘиҜҙе°ұжҳҜжҠҠиҝҷдәӣдёңиҘҝжҳ е°„еҲ°дёҖдёӘз©әй—ҙйҮҢпјҢжҲ‘们平时дёәдәҶиЎЁзӨәдҪҚзҪ®еҸҜиғҪжҳҜдёүз»ҙз©әй—ҙпјҢд№ҹе°ұжҳҜ xyzпјҢдҪҶжҳҜеңЁеӣҫзүҮе•ҠгҖҒж–Үжң¬е•Ҡиҝҷз§ҚйўҶеҹҹйҮҢпјҢдёүз»ҙз©әй—ҙдёҚеӨӘеӨҹпјҢе°ұеҸҜиғҪеҺ»еҲ°еҸҰеӨ–дёҖдёӘ N з»ҙз©әй—ҙпјҢеңЁиҝҷдёӘз©әй—ҙйҮҢпјҢе°ұеғҸдёүз»ҙз©әй—ҙйҮҢдәәзҡ„йј»еӯҗиҰҒи·ҹеҳҙжҢЁеҫ—иҝ‘дёҖж ·пјҢжҲ‘们д№ҹеёҢжңӣзӣёдјјзҡ„дёңиҘҝеңЁиҝҷдёӘж–°зҡ„з©әй—ҙйҮҢд№ҹи·қзҰ»иҝ‘пјҢжҜ”еҰӮж–Үжң¬йҮҢзҡ„ вҖңйј»еӯҗвҖқ е’ҢвҖңеҳҙвҖқжҲ‘们е°ұд№ҹеёҢжңӣе®ғ们иғҪжҢЁеҫ—иҝ‘дёҖзӮ№пјҢеӣ дёәйғҪеұһдәҺдә”е®ҳпјҢйӮЈд№Ҳ вҖңйј»еӯҗвҖқ е’ҢвҖңи…ҝвҖқе°ұзӣёеҜ№зҰ»еҫ—иҝңдёҖзӮ№гҖӮ

йЎҫеҗҚжҖқд№үпјҢword2vec жҳҜжҠҠж–Үеӯ—иҪ¬жҚўжҲҗи®Ўз®—жңәеҸҜд»ҘиҜҶеҲ«зҡ„иҫ“е…ҘпјҢжүҖд»ҘиҝҷдёӘжҠҖжңҜжңҖејҖе§Ӣеә”з”ЁгҖҒд№ҹжҳҜеә”з”ЁжңҖеӨҡзҡ„ең°ж–№е°ұжҳҜиҮӘ然иҜӯиЁҖеӨ„зҗҶйўҶеҹҹпјҲNLPпјүгҖӮе…¶е®һеңЁд№ӢеүҚеҜ№дәҺиЎЁеҫҒеӯҰд№ пјҢжҲ‘еҹәдәҺ ICLR е’Ң CVPR еҒҡиҝҮдёӨж¬Ў high-level зҡ„жҖ»з»“пјҢдҪҶжҳҜиҝҷж¬ЎиҝҷзҜҮж–Үз« дё»иҰҒзқҖзңјдәҺ word2vecпјҢд»Һз»ҶиҠӮзқҖжүӢпјҢзңӢзңӢ word2vec дёӯеҸ‘зҺ°зҡ„з©әй—ҙжҳҜеҰӮдҪ•иў«ж”№иҝӣ并дҪҝз”Ёзҡ„пјҢеҗҢж—¶д№ҹзңӢдёҖдёӢеҹәдәҺ word2vec зҡ„еҺҹзҗҶеҸ‘зҺ°зҡ„ж–°з©әй—ҙгҖӮеңЁејҖе§ӢжӯЈйўҳд№ӢеүҚпјҢдёәдәҶйҳІжӯўжңүдәәдёҚжё…жҘҡ word2vec д»ҺиҖҢеҪұе“ҚеҜ№еҗҺж–Үзҡ„зҗҶи§ЈпјҢиҝҷйҮҢ科жҷ®дёҖдёӢжң¬ж–Үдјҡз”ЁеҲ°зҡ„зӣёе…іеҹәжң¬жҰӮеҝөгҖӮ

1гҖҒword2vec з®Җд»Ӣ

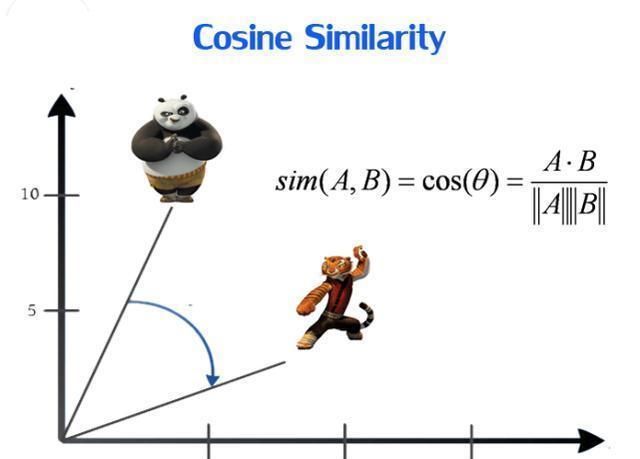

д»Җд№ҲжҳҜ word2vecпјҡWord2Vec жҳҜдёҖдёӘиҝҮзЁӢпјҲжҠҖжңҜпјүпјҢеңЁиҝҷдёӘиҝҮзЁӢдёӯпјҢе°Ҷж–Үжң¬дҪңдёәзҘһз»ҸзҪ‘з»ңзҡ„и®ӯз»ғж•°жҚ®пјҢиҝҷдёӘзҘһз»ҸзҪ‘з»ңзҡ„иҫ“еҮәеҗ‘йҮҸиў«з§°дҪңеөҢе…ҘпјҢиҝҷдәӣеөҢе…ҘпјҲеҗ‘йҮҸпјүеңЁи®ӯз»ғеҗҺдјҡеҢ…еҗ«еҚ•иҜҚзҡ„иҜӯд№үдҝЎжҒҜгҖӮиҝҷдёӘиҝҮзЁӢеҒҡзҡ„е°ұжҳҜд»ҺжҜҸдёӘеҚ•иҜҚжңүеӨҡдёӘз»ҙеәҰзҡ„з©әй—ҙеөҢе…ҘеҲ°е…·жңүдҪҺеҫ—еӨҡз»ҙеәҰзҡ„иҝһз»ӯеҗ‘йҮҸз©әй—ҙгҖӮеҗ‘йҮҸеөҢе…ҘеҸҜд»ҘеңЁзңҹе®һеҜ№иұЎзҡ„ вҖңзҰ»ж•ЈвҖқ дё–з•Ңе’ҢжңәеҷЁеӯҰд№ зҡ„ вҖңеҸҜеҫ®еҲҶвҖқ дё–з•Ңд№Ӣй—ҙжһ¶иө·дёҖеә§жЎҘжўҒпјҢеӣ жӯӨеңЁж•°жҚ®еә“з ”з©¶ж–№йқўе…·жңүе·ЁеӨ§зҡ„жҪңеҠӣгҖӮдёҖзұ»еҜ№иұЎзҡ„еөҢе…Ҙеҗ‘йҮҸжҳҜд»Һ X жҳ е°„еҲ°жҹҗдёӘеҗ‘йҮҸз©әй—ҙпјҢз§°дёәжҪңз©әй—ҙпјҢжҲ‘们йҖҡеёёеҒҮи®ҫе®ғжҳҜдёҖдёӘжңүйҷҗз»ҙ d зҡ„е®һеҗ‘йҮҸз©әй—ҙ R^dгҖӮ

ж–Үз« еӣҫзүҮ

еҰӮдҪ•еҺ»иЎЎйҮҸпјҡеңЁдҪҝз”ЁеөҢе…Ҙзҡ„ж—¶еҖҷпјҢжҲ‘们еә”иҜҘиҖғиҷ‘еҮ дёӘй—®йўҳвҖ”вҖ”еҜ№иұЎзҡ„е“ӘдәӣеұһжҖ§з”ЁеөҢе…ҘиЎЁзӨәпјҹжҲ‘们用зҡ„и·қзҰ»жөӢйҮҸзҡ„ж„Ҹд№үжҳҜд»Җд№ҲпјҹжҪңз©әй—ҙзҡ„еҮ дҪ•жҖ§иҙЁжҳҜеҗҰеҜ№еә”дәҶ X дёҠжңүж„Ҹд№үзҡ„е…ізі»пјҹеҪ“然еҗҢж—¶пјҢжҲ‘们д№ҹиҰҒиҖғиҷ‘и®Ўз®—еҗ‘йҮҸеөҢе…Ҙзҡ„и®Ўз®—жҲҗжң¬гҖӮ

2гҖҒе®Ңе–„ж—§з©әй—ҙ

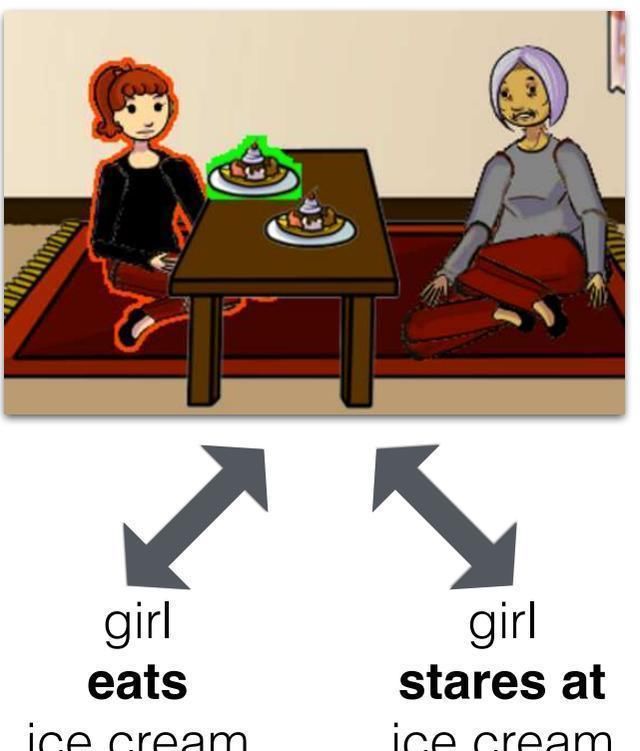

дәҶи§ЈдәҶ word2vec зҡ„еҹәжң¬еёёиҜҶпјҢе°ұеҸҜд»ҘжӯЈејҸиҝӣе…ҘжӯЈйўҳдәҶгҖӮеңЁдёҠдёҖиҠӮиҜҙиҝҮпјҢжҲ‘们еңЁе»әз«ӢдёҖдёӘеөҢе…Ҙз©әй—ҙзҡ„ж—¶еҖҷпјҢжҲ‘们иҰҒиҖғиҷ‘зҡ„жҳҜеҜ№иұЎзҡ„йӮЈдәӣеұһжҖ§йңҖиҰҒеңЁеөҢе…Ҙз©әй—ҙдёӯиў«иЎЁеҫҒгҖӮword2vec еңЁдј з»ҹзҡ„ NLP д»»еҠЎдёӯиЎЁзҺ°еҫ—еҫҲеҘҪпјҢдҪҶжҳҜеңЁдёҖдәӣж–°зҡ„гҖҒиҫғдёәеӨҚжқӮзҡ„д»»еҠЎдёӯпјҢжңүдёҖдәӣеұһжҖ§е°ұдёҚиғҪеҫҲеҘҪзҡ„иў«дҪ“зҺ°дәҶпјҢеӣ дёәжңҖејҖе§Ӣ word2vec жЁЎеһӢжҳҜе®Ңе…ЁеҹәдәҺж–Үжң¬иҝӣиЎҢи®ӯз»ғпјҢиҖҢеҫҲеӨҡе…ізі»жҳҜеңЁж–Үжң¬дёӯеҫҲйҡҫдҪ“зҺ°еҮәзҡ„пјҢжҜ”еҰӮ вҖңзңӢвҖқ е’ҢвҖңеҗғвҖқпјҢеҚ•зӢ¬зңӢиҝҷдёӨдёӘиҜҚпјҢе°ұз®—жҳҜжҲ‘们д№ҹеҫҲйҡҫжғіеҲ°е®ғ们жҳҜжңүиҒ”зі»зҡ„гҖӮ

ж–Үз« еӣҫзүҮ

иҝҷд№ҹдёҚйҡҫзҗҶи§ЈпјҢдәәзұ»еңЁж„ҹзҹҘиҝҷдёӘдё–з•Ңзҡ„ж—¶еҖҷз”ЁеҲ°зҡ„жЁЎејҸдёҚеҸӘжҳҜзңӢпјҢиҝҳжңүеҗ¬гҖҒй—»зӯүзӯүпјҢеҗҢж ·зҡ„пјҢеңЁзңӢзҡ„ж—¶еҖҷпјҢзңӢзҡ„д№ҹдёҚеҸӘжҳҜд№ҰйқўдёҠзҡ„ж–Үеӯ—пјҢиҖҢиҜӯиЁҖеҚҙжҳҜдј йҖ’зҹҘиҜҶзҡ„иҪҪдҪ“пјҢжүҖд»ҘзҺ°еңЁз ”究иҖ…ејҖе§Ӣз”ЁдёҚеҗҢзҡ„ж„ҹзҹҘжЁЎејҸпјҲеЈ°йҹігҖҒеӣҫзүҮпјүжқҘеӯҰд№ иҜӯиЁҖжЁЎеһӢпјҲmulti-modal learningпјүпјҢд»ҺиҖҢи®©иҜӯиЁҖжЁЎеһӢеӯҰеҮәзҡ„еөҢе…ҘиғҪеӨҹжӣҙеҠ е…Ёйқўзҡ„иЎЁеҫҒжҲ‘们дәәзұ»зҡ„зҗҶи§ЈиғҪеҠӣгҖӮ

иҮідәҺжҠҖжңҜеұӮйқўпјҢе…¶е®һеӣһжәҜеҲ°иҜӯиЁҖжЁЎеһӢжңҖејҖе§Ӣиө·жәҗзҡ„йӮЈйҳ¶ж®өпјҢиҜӯиЁҖжЁЎеһӢи·ҹиҝҒ移еӯҰд№ зұ»дјјдәҺдёҖеҜ№е…„ејҹпјҢеҸӘдёҚиҝҮиҝӣе…ҘдәҶдёҚеҗҢзҡ„йўҶеҹҹпјҢд№ҹе°ұжңүдәҶдёҚеҗҢзҡ„еҗҚеӯ—гҖӮжҜ”еҰӮиҜҙеңЁ NLP д»»еҠЎдёӯпјҢиҜӯиЁҖжЁЎеһӢе…Ҳиў«и®ӯз»ғеҘҪпјҢ然еҗҺеҗҺйқўзӣҙжҺҘз”Ёйў„и®ӯз»ғеҘҪзҡ„иҜӯиЁҖжЁЎеһӢжқҘиҝӣиЎҢдёӢйқўзҡ„д»»еҠЎпјҢеғҸдёҚеғҸеҶ»дҪҸдәҶеүҚйқўеҮ еұӮзҡ„иҝҒ移еӯҰд№ пјҲеҰӮжһңиҝҷдёӘзңӢдёҚжҮӮпјҢд№ҹдёҚеӨӘеҪұе“ҚеҗҺйқўзҡ„зҗҶи§ЈпјҢи§үеҫ—ж”ҫдёҚдёӢзҡ„еҸҜд»ҘзңӢзңӢжңәеҷЁд№Ӣеҝғд№ӢеүҚзҡ„ж–Үз« пјҢжңүеҫҲеӨҡеҹәзЎҖж•ҷзЁӢзҡ„пјҢиҝҷйҮҢе°ұдёҚеҒҡд»Ӣз»Қе•ҰпјүгҖӮ

д№ӢжүҖд»ҘиҜҙиҝҒ移еӯҰд№ пјҢжҳҜеӣ дёәеҰӮжһңжғіиҰҒиҫҫеҲ°е®Ңе–„ word2vec з©әй—ҙзҡ„ж•ҲжһңпјҢе…¶е®һе°ұжҳҜзұ»дјјдәҺиҝҒ移еӯҰд№ йҮҢзҡ„е…ЁеұҖ finetuneпјҢжҠҠеүҚйқўзҡ„иҜӯиЁҖжЁЎеһӢпјҲдёҖејҖе§ӢеҶ»дҪҸзҡ„еұӮпјүд№ҹж”ҫиҝӣи®ӯз»ғйҮҢжқҘгҖӮ

дёәдәҶеұ•зӨәеҪ“еүҚз ”з©¶е…·дҪ“жҳҜжҖҺд№ҲеҲ©з”Ё word2vec иҝӣиЎҢжӢ“еұ•еә”з”ЁпјҢиҝҷдёҖиҠӮеҜ№еӣӣзҜҮи®әж–ҮиҝӣиЎҢз®ҖиҰҒд»Ӣз»ҚпјҢд»ҺиҖҢеұ•зӨәеӣҫзүҮе’ҢеЈ°йҹіжҳҜеҰӮдҪ•еҠ ејәе·Іжңүзҡ„ word2vec еөҢе…Ҙз©әй—ҙзҡ„иЎЁеҫҒиғҪеҠӣзҡ„гҖӮеҪ“然иҝҷйҮҢд»Ӣз»Қзҡ„зҹҘиҜҶеөҢе…Ҙз©әй—ҙзҡ„з”ҹжҲҗиҝҮзЁӢпјҢеҺҹи®әж–Үдёӯиҝҳжңүе…¶д»–зҡ„еҲӣж–°зӮ№пјҢеҰӮжһңжңүе…ҙи¶ЈеҸҜд»ҘеҶҚеҺ»жӢңиҜ»дёҖдёӢе®Ңж•ҙи®әж–ҮгҖӮ

2.1 Visual Word2Vec (vis-w2v) [1]

и®әж–Үй“ҫжҺҘпјҡhttps://arxiv.org/pdf/1511.07067.pdf

иҺ·еҸ–дәҶ HпјҲN_H е°ұжҳҜеөҢе…Ҙзҡ„з»ҙеәҰпјүд№ӢеҗҺпјҢиҝҷдёӘ H е°ұдҪңдёәжңҖз»Ҳзҡ„зү№еҫҒеҗ‘йҮҸпјҢеҲ©з”Ё W_O е°Ҷе…¶иҝӣиЎҢжҳ е°„ N_K з»ҙпјҲдёҖе…ұжңү N_K зұ»пјҢиҝҷйҮҢзҡ„ N_K еҗҺйқўи§ЈйҮҠпјүпјҢеҜ№е…¶иҝӣиЎҢ softmax ж“ҚдҪңд№ӢеҗҺпјҢе°ұеҸҜд»ҘзҹҘйҒ“иҝҷж®өж–Үжң¬пјҲw_1-w_lпјүеұһдәҺе“ӘдёҖзұ»дәҶпјҢиҝҷдёҖжӯҘе°ұжҳҜеҒҡдәҶдёҖдёӘеҲҶзұ»гҖӮ

еҰӮжһңдәҶи§Ј NLP д»»еҠЎзҡ„иҜқпјҢH зҡ„иҺ·еҸ–зҡ„第дёҖжӯҘи·ҹе№іж—¶жҲ‘们иҺ·еҸ– embedding зҡ„ж–№ејҸдёҖж ·пјҢеӣ дёәиҝҷйҮҢзҡ„ W_I жҳҜеҲқе§ӢеҢ–дёәдј з»ҹ CBOW зҡ„жқғйҮҚпјҢжүҖд»ҘиҝҷдёҖжӯҘе…¶е®һе°ұжҳҜиҺ·еҸ–иҝҷдәӣиҜҚзҡ„дј з»ҹеөҢе…ҘпјҢ然еҗҺеҜ№е…¶еҸ–е№іеқҮдҪңдёәж•ҙдёӘзӘ—еҸЈжүҖжңүиҜҚзҡ„зү№еҫҒпјҢ然еҗҺеҒҡдәҶдёҖдёӘеҲҶзұ»д»»еҠЎгҖӮ

жҺЁиҚҗйҳ…иҜ»

- 全家жҖ»еҠЁе‘ҳпјҢе…ұеҗҢеӯҰз»Ҹе…ёпјҢи§ӮжҫңеӨ§еҜҢзӨҫеҢәеӣҪеӯҰдәІеӯҗиҜөиҜ»иҺ·еұ…ж°‘еҘҪиҜ„

- 马жҖқзәҜ|гҖҠиҚһйәҰз–Ҝй•ҝгҖӢеҶҚе”ұжңҙж ‘з»Ҹе…ёжӣІгҖҠcolorful daysгҖӢ

- Angelababy|жқЁйў–cosзҺӢзҘ–иҙӨгҖҠдёңжҲҗиҘҝе°ұгҖӢз»Ҹе…ёйҖ еһӢдёҺйғ‘жҒәжҗӯжҲҸ

- жөҒдј |зӣҳзӮ№гҖҠз»Ҹе…ёе’ҸжөҒдј гҖӢдёӯеҚ°иұЎжңҖж„ҹдәәзҡ„еҮ йҰ–жӯҢпјҢдҪ жҳҜеҗҰеҗ¬иҝҮпјҹ

- е…ёйҮҚ|дёүйғЁиҝӘеЈ«е°јз»Ҹе…ёйҮҚжҳ пјҒеҠ©еҠӣеҪұйҷўеӨҚе·Ҙ

- з”өи§Ҷеү§|еӣһйЎҫз”өи§Ҷеү§гҖҠйҖҶжөҒдёҠзҡ„дҪ гҖӢй«ҳеҜҶиҜҙзҡ„з»Ҹе…ёзҡ„7еҸҘиҜқ

- й’ҹжұүиүҜ|й’ҹжұүиүҜ5йғЁз»Ҹе…ёеү§дҪңпјҢйғЁйғЁзЁіи¶…гҖҠеҮүз”ҹгҖӢдёҖеӨ§жҲӘпјҢе“ӘйғЁжҲҗдҪ жңҖзҲұ

- йқўеҢ…|й»Ҝ然й”ҖйӯӮзҡ„иҠқеЈ«йқўеҢ…пјҢзҫҺе‘іпјҒ

- йқўеҢ…|й»Ҝ然й”ҖйӯӮзҡ„иҠқеЈ«йқўеҢ…пјҢзҫҺе‘іпјҒ

- дәҡи§Ҷз»Ҹе…ёеү§|97е№ҙжңҖиҪ°еҠЁзҡ„еӣӣйғЁжёҜеү§пјҢTVBе’Ңдәҡи§Ҷеҗ„жңүдёӨйғЁпјҢеҪ“е№ҙзҶ¬еӨңд№ҹиҰҒиҝҪ