иЎҢдёҡдә’иҒ”зҪ‘|AIиҠҜзүҮзҡ„ж–°йЈҺеҗ‘

жқҺйЈһ еҚҠеҜјдҪ“иЎҢдёҡи§ӮеҜҹ

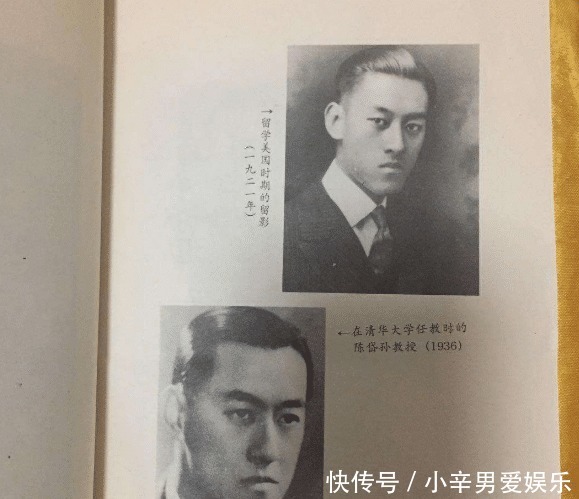

жң¬ж–ҮжҸ’еӣҫ

дәәе·ҘжҷәиғҪе·Із»ҸжҲҗдёәзӣ®еүҚиҠҜзүҮиЎҢдёҡзҡ„дёҖдёӘйҮҚиҰҒй©ұеҠЁеҠӣ гҖӮ еӣһйЎҫдәәе·ҘжҷәиғҪеңЁеҚҠеҜјдҪ“иЎҢдёҡзҡ„еҸ‘еұ• пјҢ жҲ‘们еҸҜд»Ҙжё…жҷ°ең°зңӢеҲ°дёҖжқЎд»Һдә‘еҲ°з»Ҳз«Ҝзҡ„жј”иҝӣи·Ҝзәҝ гҖӮ

жңҖеҲқ пјҢ дәәе·ҘжҷәиғҪдё»иҰҒжҳҜдҪңдёәдёҖз§ҚжңҚеҠЎйғЁзҪІеңЁдә‘з«Ҝ гҖӮ жң¬д»Јдәәе·ҘжҷәиғҪеҹәдәҺеӨ§ж•°жҚ®е’ҢзҘһз»ҸзҪ‘з»ң пјҢ еӣ жӯӨеңЁи®ӯз»ғж—¶еҖҷйңҖиҰҒеӨ§йҮҸзҡ„з®—еҠӣ пјҢ еңЁдә‘з«ҜйғЁзҪІзҡ„ж—¶еҖҷд№ҹйңҖиҰҒз®—еҠӣеҒҡж”Ҝж’‘ пјҢ еӣ жӯӨдә‘з«Ҝдәәе·ҘжҷәиғҪйўҶеҹҹдёӯд»ҘNvidiaдёәд»ЈиЎЁзҡ„GPUеҠ йҖҹдәәе·ҘжҷәиғҪжҲҗдёәдәҶе…іжіЁз„ҰзӮ№ пјҢ еҗҢж—¶д№ҹжңүд»ҘGraphcoreгҖҒHabanaдёәд»ЈиЎЁзҡ„дә‘з«Ҝдё“з”Ёдәәе·ҘжҷәиғҪиҠҜзүҮе…¬еҸёдёҺGPUеҲҶеәӯжҠ—зӨј гҖӮ 2018е№ҙд№ӢеҗҺ пјҢ йҡҸзқҖжЁЎеһӢе’ҢиҠҜзүҮи®ҫи®Ўзҡ„дјҳеҢ– пјҢ дәәе·ҘжҷәиғҪйҖҗжёҗд»Һдә‘з«ҜдёӢжІүеҲ°жүӢжңәзӯүејәжҷәиғҪи®ҫеӨҮз»Ҳз«Ҝ пјҢ еңЁжүӢжңәдёҠеҹәдәҺдәәе·ҘжҷәиғҪз®—жі•зҡ„и¶…еҲҶиҫЁгҖҒзҫҺйўңгҖҒдәәи„ёиҜҶеҲ«зӯүеә”з”Ёд№ҹжёҗжёҗеҫ—еҲ°дәҶдё»жөҒи®ӨеҸҜ пјҢ зӣёеә”зҡ„иҠҜзүҮпјҲIPпјүд№ҹе°ұжҲҗдёәдәҶжүӢжңәSoCдёҠдёҚеҸҜжҲ–зјәзҡ„дёҖйғЁеҲҶ пјҢ й«ҳйҖҡгҖҒиӢ№жһңгҖҒеҚҺдёәжө·жҖқзӯүйғҪжӢҘжңүиҮӘе·ұзҡ„й«ҳжҖ§иғҪдәәе·ҘжҷәиғҪеҠ йҖҹIP пјҢ з”Ёд»Ҙж”ҜжҢҒжүӢжңәдәәе·ҘжҷәиғҪеә”з”Ё гҖӮ

иҖҢйҡҸзқҖдәәе·ҘжҷәиғҪжҠҖжңҜзҡ„иҝӣдёҖжӯҘжј”иҝӣ пјҢ жҲ‘们зңӢеҲ°е®ғжӯЈеңЁиҝӣдёҖжӯҘе’Ңзү©иҒ”зҪ‘з»“еҗҲ пјҢ и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪжӯЈжҳҜиҝҷдёӘдәәе·ҘжҷәиғҪ继з»ӯдёӢжІүзҡ„ж–°еҠЁеҗ‘ гҖӮ

и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪиҠҜзүҮзҡ„еә”з”ЁеңәжҷҜ

и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪиҠҜзүҮпјҲIPпјүзҡ„е·ҘдҪңеҠҹиҖ—еңЁж•°еҚҒжҜ«з“ҰжҲ–жӣҙдҪҺпјҲдҪңдёәжҜ”иҫғ пјҢ жүӢжңәз«Ҝдәәе·ҘжҷәиғҪIPзҡ„е·ҘдҪңеҠҹиҖ—еҫҖеҫҖеңЁж•°зҷҫжҜ«з“ҰеҲ°з“Ұзә§еҲ« пјҢ иҖҢдә‘з«Ҝдәәе·ҘжҷәиғҪеҠ йҖҹеҚЎеҠҹиҖ—йҖҡеёёеңЁж•°зҷҫз“Ұпјү пјҢ еҗҢж—¶еҫҖеҫҖз»“еҗҲдәӢ件й©ұеҠЁжҠҖжңҜ пјҢ еҚіз»қеӨ§йғЁеҲҶж—¶й—ҙи®Ўз®—йғЁеҲҶйғҪеӨ„дәҺдј‘зң зҠ¶жҖҒ пјҢ д»…д»…еңЁеҸ‘з”ҹзӣёе…ідәӢ件时жүҚдјҡеҗҜеҠЁ пјҢ иҝҷж ·е°ұеҸҜд»ҘжҠҠе№іеқҮеҠҹиҖ—йҷҚдҪҺеҲ°жҜ«з“Ұж•°йҮҸзә§д»ҘдёӢ гҖӮ

и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪеҸҜд»Ҙеә”з”ЁеңЁд»Җд№ҲеңәжҷҜдёӢе‘ўпјҹж¶Ҳиҙ№з”өеӯҗйўҶеҹҹдёӯе°ұжңүи¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪзҡ„дёҖеёӯд№Ӣең° гҖӮ еңЁдёӢдёҖд»ЈжҷәиғҪи®ҫеӨҮеҰӮеҸҜз©ҝжҲҙи®ҫеӨҮе’ҢжҷәиғҪзңјй•ңзұ»и®ҫеӨҮдёӯ пјҢ и®ҫеӨҮз”ұдәҺе°әеҜёзӯүеҺҹеӣ з”өжұ е®№йҮҸжңүйҷҗ пјҢ иҖҢиҝҷдәӣи®ҫеӨҮйңҖиҰҒжү§иЎҢжҷәиғҪз”ҹзү©дҝЎеҸ·еӨ„зҗҶпјҲдҫӢеҰӮжҷәиғҪжүӢиЎЁдёҠзҡ„еҝғзҺҮжЈҖжөӢпјүгҖҒжүӢеҠҝиҜҶеҲ«пјҲдҫӢеҰӮеңЁзӣ®еүҚзҡ„HoloLensдёӯ пјҢ еҹәдәҺдәәе·ҘжҷәиғҪзҡ„жүӢеҠҝиҜҶеҲ«жҳҜдё»иҰҒз”ЁжҲ·дәӨдә’ж–№ејҸпјүгҖҒиҜӯйҹіиҜҶеҲ«зӯүзӯү пјҢ еӣ жӯӨйңҖиҰҒйқһеёёй«ҳиғҪж•ҲжҜ”зҡ„дәәе·ҘжҷәиғҪеҠ йҖҹжЁЎеқ— гҖӮ йҷӨжӯӨд№ӢеӨ– пјҢ еңЁжҷәиғҪ家еәӯзӯүйўҶеҹҹ пјҢ и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪд№ҹжңүиҗҪең°жңәдјҡ пјҢ дҫӢеҰӮзӣ®еүҚзҡ„жҷәиғҪй—Ёй”ҒеёӮеңә пјҢ еҠ е…Ҙдәәи„ёиҜҶеҲ«дјҡдҪҝжҷәиғҪй—Ёй”Ғзҡ„з”ЁжҲ·дҪ“йӘҢеӨ§еӨ§ж”№е–„ пјҢ дҪҶжҳҜжҷәиғҪй—Ёй”ҒйҖҡеёёеҝ…йЎ»дҫқйқ з”өжұ дҫӣз”ө пјҢ иҖҢдё”йў„жңҹзҡ„з”өжұ еҜҝе‘ҪиҮіе°‘иҰҒеҚҠе№ҙеҲ°дёҖе№ҙ пјҢ иҝҷж ·дёҖжқҘеҜ№дәҺжү§иЎҢдәәе·ҘжҷәиғҪи®Ўз®—зҡ„жЁЎеқ—е°ұжҸҗеҮәдәҶйқһеёёй«ҳзҡ„иғҪж•ҲжҜ”йңҖжұӮ гҖӮ

йҷӨдәҶж¶Ҳиҙ№з”өеӯҗд№ӢеӨ– пјҢ е·Ҙдёҡеә”з”Ёдёӯд№ҹйңҖиҰҒи¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪ гҖӮ е·Ҙдёҡеә”з”ЁдёӯеҜ№дәҺи¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪзҡ„йңҖжұӮеҫҖеҫҖжқҘжәҗдәҺжҷәиғҪдј ж„ҹеҷЁ гҖӮ иҝҷзұ»дј ж„ҹеҷЁе®үиЈ…еңЁжңәеҷЁгҖҒжңәжў°иҮӮгҖҒз®ЎйҒ“зӯүйҮҚиҰҒзҺҜеўғдёӯ пјҢ йңҖиҰҒиғҪж—¶еҲ»зӣ‘жөӢеҗ„зұ»дҝЎеҸ·е№¶дё”иҝҗиЎҢзӣёеә”зҡ„дәәе·ҘжҷәиғҪз®—жі•жқҘеҲӨж–ӯиҝҗиЎҢзҠ¶еҶө гҖӮ еңЁиҝҷдәӣеңәжҷҜдёӢ пјҢ дј ж„ҹеҷЁеҝ…йЎ»дҫқйқ з”өжұ дҫӣз”ө пјҢ иҖҢи¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪеҸҜд»ҘеӨ§еӨ§еҮҸе°‘з”өжұ ж¶ҲиҖ— пјҢ иҝҷд№ҹж„Ҹе‘ізқҖдј ж„ҹеҷЁжӣҙжҚўз”өжұ зҡ„й—ҙйҡ”еҸҜд»ҘжҸҗеҚҮ пјҢ иҝҷд№ҹе°ұеӨ§еӨ§йҷҚдҪҺдәҶиҝҷзұ»дј ж„ҹеҷЁзі»з»ҹзҡ„йғЁзҪІе’Ңз»ҙжҠӨжҲҗжң¬ гҖӮ

и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪиҠҜзүҮзҡ„жҠҖжңҜи·Ҝеҫ„

зӣ®еүҚ пјҢ и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪиҠҜзүҮеӨ§жҰӮеҸҜд»ҘеҲҶдёәдёүз§ҚжҠҖжңҜи·Ҝеҫ„ гҖӮ

йҰ–е…ҲжҳҜеҹәдәҺж•°еӯ—з”өи·Ҝзҡ„и¶…дҪҺеҠҹиҖ—дәәе·ҘжҷәиғҪеҠ йҖҹжЁЎеқ—и®ҫи®Ў гҖӮ дҪҝз”Ёж•°еӯ—з”өи·Ҝеҗ‘и¶…дҪҺеҠҹиҖ—ж–№еҗ‘зҡ„дјҳеҢ–ж–№жі•йҰ–е…ҲжҳҜд»Һзі»з»ҹжһ¶жһ„еұӮйқўеҒҡдјҳеҢ– пјҢ е°ҪйҮҸеҮҸе°ҸжЁЎеһӢзҡ„дҪ“з§Ҝ пјҢ 并дјҳеҢ–ж•°жҚ®жөҒд»ҘйҷҚдҪҺеҶ…еӯҳи®ҝй—®ејҖй”Җ гҖӮ жӯӨеӨ– пјҢ еңЁз”өи·ҜеұӮйқўеҸҜд»ҘйҷҚдҪҺз”өжәҗз”өеҺӢ пјҢ з”ҡиҮідҪҝз”ЁдәҡйҳҲеҖјйҖ»иҫ‘й—Ёи®ҫи®Ў пјҢ д»ҘйҷҚдҪҺз”өи·ҜиҝҗиЎҢж—¶зҡ„еҠҹиҖ— пјҢ д»ҘеҸҠжјҸз”өжөҒ гҖӮ дҪҝз”Ёж•°еӯ—з”өи·Ҝж–№жі•зҡ„дјҳеҠҝеңЁдәҺеҸҜд»Ҙжӣҙе®№жҳ“ең°дёҺдәәе·ҘжҷәиғҪи®Ўз®—д№ӢеӨ–зҡ„жЁЎеқ—йӣҶжҲҗ并жһ„жҲҗSoC пјҢ иҖҢж— йңҖеңЁж•°жЁЎиҪ¬жҚўдёҠж¶ҲиҖ—йўқеӨ–иғҪйҮҸ гҖӮ

第дәҢжқЎжҠҖжңҜи·Ҝеҫ„жҳҜдҪҝз”ЁжЁЎжӢҹи®Ўз®—жқҘе®ҢжҲҗзҘһз»ҸзҪ‘з»ңзҡ„и®Ўз®— гҖӮ жЁЎжӢҹи®Ўз®—еҫҖеҫҖе’ҢеҶ…еӯҳеҶ…и®Ўз®—зӣёз»“еҗҲд»Ҙе®һзҺ°й«ҳиғҪж•ҲжҜ” пјҢ е…¶е…·дҪ“зҡ„жҖқи·ҜжҳҜзӣ®еүҚдәәе·ҘжҷәиғҪи®Ўз®—дёӯеҫҖеҫҖеӯҳеӮЁи®ҝй—®жҳҜиғҪйҮҸж¶ҲиҖ—жңҖеӨ§зҡ„йғЁеҲҶ пјҢ иҖҢдҪҝз”ЁжЁЎжӢҹи®Ўз®—еҲҷеҸҜд»ҘеңЁеӯҳеӮЁпјҲеҰӮSRAMжҲ–FlashзӯүNVMпјүиҜ»еҮәз”өи·ҜдёӯзӣҙжҺҘеҒҡи®Ўз®— пјҢ иҝҷж ·е°ұзңҒеҺ»дәҶж•°жҚ®иҜ»еҮәеҶҚи®Ўз®—зҡ„жӯҘйӘӨ пјҢ иҖҢеҸҜд»ҘзӣҙжҺҘеңЁеҶ…еӯҳеҶ…е®ҢжҲҗи®Ўз®— гҖӮ дҪҝз”ЁжЁЎжӢҹи®Ўз®—й…ҚеҗҲеҶ…еӯҳеҶ…и®Ўз®—еҫҖеҫҖеҸҜд»Ҙе®һзҺ°еҫҲй«ҳзҡ„иғҪж•ҲжҜ” пјҢ дҫӢеҰӮ欧жҙІзҡ„и‘—еҗҚеҚҠеҜјдҪ“з ”з©¶жңәжһ„IMECе®Јеёғе°ҶеңЁжңӘжқҘж•°е№ҙеҶ…е®ҢжҲҗиғҪж•ҲжҜ”й«ҳиҫҫ10000TOPS/Wзҡ„жЁЎжӢҹи®Ўз®—дәәе·ҘжҷәиғҪеҠ йҖҹжЁЎеқ— гҖӮ дҪҶжҳҜжЁЎжӢҹи®Ўз®—еҜ№дәҺжЁЎеһӢеҫҖеҫҖжңүиҫғеӨҡйҷҗеҲ¶ пјҢ дҫӢеҰӮеҝ…йЎ»еңЁи®Ўз®—зІҫеәҰиҫғдҪҺж—¶д»Қ然иғҪдҝқиҜҒеҮҶзЎ®зҺҮзӯү пјҢ еӣ жӯӨйңҖиҰҒеҫҲеҘҪзҡ„иҪҜ件/硬件еҚҸеҗҢи®ҫи®Ў гҖӮ

жҺЁиҚҗйҳ…иҜ»

- дә’иҒ”зҪ‘|дёҠзәҝеҚҠе№ҙ收иҺ·6700дёҮз”ЁжҲ·пјҢиҝҷж¬ҫиҒҡз„ҰдёӢжІүз”ЁжҲ·зҡ„йҷҢз”ҹдәәзӨҫдәӨAPPжҳҜжҖҺд№ҲеҒҡеҲ°зҡ„пјҹ

- дә’иҒ”зҪ‘|5Gе•Ҷз”ЁдёҖе‘Ёе№ҙпјҢеҚҺдёәдә‘еҗ‘дә’иҒ”зҪ‘дјҒдёҡеӨ§жҠӣз»Јзҗғ

- дә’иҒ”зҪ‘|дёӯеҸ°дә§е“Ғз»ҸзҗҶе®һжҲҳ(14)пјҡдёӯеҸ°дёҺSaaSгҖҒеҫ®жңҚеҠЎе…ізі»

- дә’иҒ”зҪ‘|иЎҢдёҡи§ӮеҜҹ | дҪ жүҖдёҚзҹҘйҒ“зҡ„5Gж¶ҲжҒҜ

- дә’иҒ”зҪ‘|еӨҡеҗҚзҹҘеҗҚдәәзү©жҺЁзү№иў«й»‘пјҢжӢңзҷ»еҘҘе·ҙ马йғҪвҖңдёӯжӢӣвҖқпјҢжҜ”е°”зӣ–иҢЁд№ҹеңЁе…¶еҶ…

- дә’иҒ”зҪ‘|еҸ‘ж”ҫй«ҳеҲ©иҙ·пјҢиҝҳиҰҒзӘғеҸ–з”ЁжҲ·дҝЎжҒҜпјҹиҝҷдәӣйҮ‘иһҚAPPеңЁз§ҖвҖңйҒ“еҫ·еә•зәҝвҖқ

- дә’иҒ”зҪ‘|дёңиҺһе…ҲзҹҘпјҡж•°еӯ—жҷәиғҪпјҢе…Ҳи§үвҖңе…ҲзҹҘвҖқ

- дә‘и®Ўз®—|д»Һдә’иҒ”зҪ‘еҲ°AIеҙӣиө·пјҢдёҠжө·иғҪејҜйҒ“и¶…иҪҰеҗ—пјҹ

- иЎҢдёҡдә’иҒ”зҪ‘,5G|жұҹиӢҸжңүзәҝйЎәеҲ©е®ҢжҲҗеӣӯеҢә5GдҝЎеҸ·ејҖйҖҡжөӢиҜ•

- иЎҢдёҡдә’иҒ”зҪ‘,AIдәәе·ҘжҷәиғҪ|еҹҺеёӮж•ҷиӮІеӨ§и„‘д»ҘвҖң AI+ еӨ§ж•°жҚ®вҖқдёәж ёеҝғ , еј•йўҶж•ҷиӮІеҸҳйқ©