新智元|多智能体强化学习成热点,华为诺亚方舟8篇论文入选

文章图片

新智元报道

来源:ICML

编辑:白峰

【新智元导读】据统计 , ICML2020共提交4990篇论文 , 最后接收论文1088篇 , 接收率仅为21.8% 。 与往年相比 , 接收率逐年走低 , 而作为华为人工智能的桥头堡 , 诺亚方舟实验室还是有8篇论文强势入选 , 凸显公司对基础研究的重视 。

华为诺亚方舟实验室此次有8篇论文被接收 , 创下ICML历届论文接收量新高 。 研究方向涵盖多智能体强化学习 , 神经网络架构搜索 , 1bit神经网络 , 图结构数据上的主动学习 , 记忆增强学习 , 理论样本复杂度分析 。 下面我们就来看下本次接收的几篇代表性论文 。

TrainingBinaryNeuralNetworksthroughLearningwithNoisySupervision

文章图片

本文从学习的角度对二值神经网络上的二值化运算进行研究 。 与经典的手工规则(例如Sign函数)将神经元二值化相比 , 我们提出映射模型(Mappingmodel)来学习从全精度神经元到二值神经元的映射 。 这里 , 每个权值不是独立二值化 , 而是将权值张量作为一个整体来完成二值化 , 充分考虑权值之间的关联性 。

为了帮助训练二值化映射模型 , 我们将传统Sign函数量化的神经元视为一些辅助监督信号 , 其虽然有噪声但仍具有指导意义 。 因此 , 我们引入了无偏估计器以减轻噪声的影响 。 在基准数据集上的实验结果表明 , 所提出的二值化技术具有广泛的有效性 。

多智能体深度强化学习下的Q值路径分解

文章图片

许多现实世界中的复杂场景可以建模为多智能体系统 , 因此多智能体深度强化学习(MARL)作为一种重要的分布式优化技术 , 已成为一个非常活跃的研究领域 。

其中一类重要且普遍的场景为部分可观察的合作式多智能体环境 , 在这种环境中 , 一组智能体根据自己的局部观察和共享的全局奖励信号来学习协调其行为 , 以最大化系统总体收益 。

目前主流解决方案是采用集中式训练、分布式执行范式 。 其中最核心挑战问题在于多智能体信度分配:如何为单个智能体的策略分配属于它自身的贡献 , 从而更好地协调以最大化全局奖励 。

在本文中 , 我们提出了一种Q值路径分解(QPD)的信度分配机制 , 可以将系统的全局Q值自动分解为单个智能体的Q值(如图所示) 。 和先前工作通过显示限制单个Q值和全局Q值的表示关系不同 , 我们首次将累积梯度归因技术运用到深度MARL中 , 通过沿轨迹路径直接分解全局Q值来为智能体进行信度分配 , 并从理论上证明该分配方式下单个智能体的Q值和等于全局Q值 。

我们在具有挑战性的《星际争霸II》微观管理任务上评估了QPD , 表明其与现有SOTA的MARL算法相比 , QPD在同质和异质的多智能体场景中均达到了先进的性能 。

一种基于行列式点过程的多智能体学习算法

文章图片

现有的多智能体算法在对智能体的centralizedjointQ-function做factorization的时候都需要假设每个智能体的Q_i和Q_joint之间的关系 , 例如VDN假设相加性 , Qmix假设单调性 。

本文中 , 我们设计了一种基于行列式点过程的Q_joint的描述方法 , 在不需要做任何假设的情况下 , Q_joint可以通过行列式点过程所描述的行为多样性而自动被factorize成各自的Q_i 。

给定N个物品(Item)的集合Y , 每个物品i有自己的特征向量wi , 这个集合有2N个子集 , 存在一个行列式刻画任意一个子集被选中的概率 。 行列式点过程(DeterminantalPointProcess,DPP) , 将复杂的概率计算转换成简单的行列式计算 , 通过核矩阵(KernelMatrix)L的行列式计算每一个子集的概率 。

推荐阅读

- 小红猪带你看科技|七夕节送女朋友必备左点小艾智能艾灸器X8,3天众筹500万

- 车驰夜幕|详解智慧城市全新方程,开启城市智能非凡时代

- 数字展示在线|更高追求更显专业——明基智能投影E592新品上市

- 北京日报客户端|互动动感单车、智能健身仓……西二环边新增运动休闲好去处

- 小辉搞科技|苏宁易购强化服务引领家电零售新10年,站在累销20亿台丰碑之上

- 产业气象站|5G基站太耗电!三大运营商正式官宣:将智能化关闭5G基站节约电费

- 5g基站|5G基站太耗电! 三大运营商正式官宣: 将智能化关闭5G基站节约电费

- 智玩部落|卖6万5千卢比,诺基亚在印度发布65英寸智能电视:2.25G内存

- 雷科技|苹果坑钱新套路?连戒指都是智能的

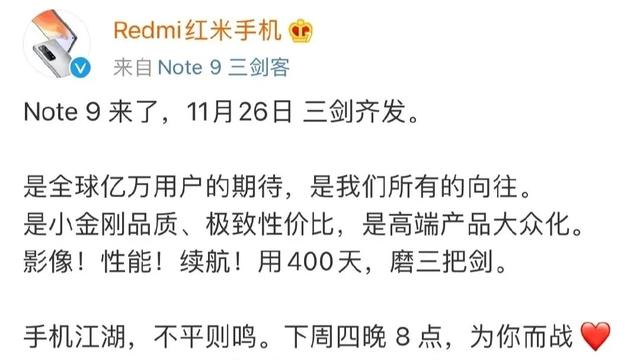

- 智能手机那点事|米粉:本指望靠超大杯降价,现在或很难实现,小米10Pro被曝停产