汽车之心Autobit特斯拉撞卡车问题有解吗?谈谈自动驾驶感知前融合架构的优势和难点

本文插图

编者按:《郭继舜带你读汽车科技》旨在从第一性原理出发 , 尝试拨开迷雾 , 解读热点背后的汽车科技真相 。

本栏目由智能驾驶专家郭继舜博士与汽车之心联合出品 , 内容独家授权汽车之心发布 。

前情提要:由于昨天(6 月 1 日)台湾嘉义的特斯拉 Autopilot 事故 , 我们对 Autopilot 感知系统的安全性以及虚拟激光雷达进行了初步的探讨 , 同时对自动驾驶多传感器感知后融合的架构进行了一些介绍 。

今天 , 我们来谈谈自动驾驶的感知前融合技术 。

同样是特斯拉的新闻 , 根据外媒报道:2019 年 10 月 , 特斯拉收购自动驾驶感知创业公司 DeepScale 。

DeepScale 的优势主要有两个:

第一 , 感知前融合(Early Fusion) , 在做目标检测前利用传感器的原始数据(RAW Data)而不是目标数据(Object Data)做感知融合 , 大大提高感知系统的鲁棒性;

第二 , 在不牺牲性能的前提下 , 通过重新设计神经网络来提升感知系统的效率 , 使深度学习模型在有限算力的嵌入式设备上运行成为可能 。

除了 DeepScale , 国内自动驾驶圈曾经的知名创业公司 Roadstar 也把感知前融合技术作为他们解决方案中重要的技术优势 , 相比于上一期我们提到过的后融合的感知方案 , 前融合的确具备一定的先进性 。

在这里可能需要解释一下:虽然多传感器融合技术从上个世纪 70 年代开始 , 就已经随着声纳信号处理的需求被美国军方提出来了 。

后来在 80 年代 , 又发展出了多传感器数据融合 MSDF(Multi-sensor Data Fusion)技术 , 并且后续理论逐步完善 , 发展出了包括卡曼滤波、贝叶斯估计、D-S 证据推理、神经网络等等多种理论方法 , 但是其应用领域更多是信号处理方面 。

由于算力不足以处理海量的数据 , 所以更多的是从信息论与概率论的角度来对观测值求取统计学上的一致无偏最优估计 。

但在现在算力爆发的条件下 , 在自动驾驶的应用背景下 , 我们在工程实践上更多地会根据实际需要解决的问题 , 来对技术框架进行梳理 , 包括后融合与前融合这些行业内的常用说法 , 可能并不是严谨的学术术语 。

回到前融合技术 , 相比于后融合 , 前融合具有很大的优势 , 简要总结为三点:

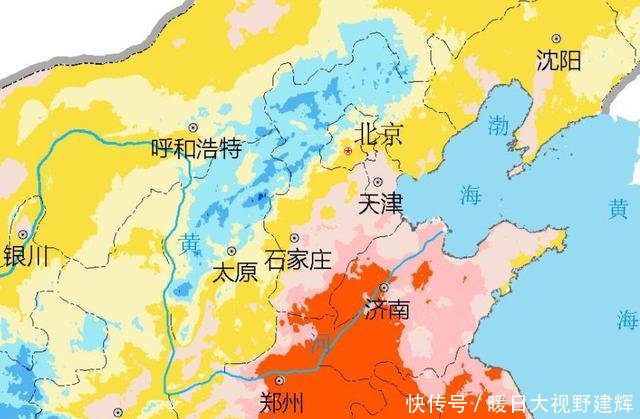

1.后融合感知框架中 , 每个传感器单独识别物体 。

对于大型物体(如货车) , 单传感器识别只能识别到物体的一部分 , 从而容易导致大小及分类识别错误 。

前融合通过将所有传感器原始信息有机组合 , 形成较完整的空间占据数据后 , 通过数据之间的互补能有效降低因部分识别造成的误判 。

2.后融合感知框架中 , 不同的传感器因自身能力限制 , 特定条件下可能发生漏检或误检 。

上述错误会直接输入后续的融合框架中 , 后融合对于已经引入的错误的过滤与纠错能力有限 , 可能无法识别与跟踪特殊物体或者小物体 。

而前融合的数据 , 在融合后能够将数据维数扩展到更加高维的空间 , 包含的信息更加丰富 , 能够让算法的分类边界更加易于训练与实现 , 同时对于小目标的识别率有很大的提升 。

3.后融合感知框架中 , 需要针对不同的传感器训练不同的感知算法 , 最终的感知结果取决于每个算法的性能 , 难以调优 。

前融合感知框架则能够通过一个单一的识别算法模型对融合后的数据进行统一处理 , 优化起来更加方便 。

当前的数据前融合感知的主要手段有两种:

1.传统的基于三维空间理论分析方法 。

首先将图像和激光雷达或者毫米波雷达的信息统一坐标系 , 即空间同步 。

其次对传感器每帧的数据进行校准 , 进行时间同步 。

然后寻找空间之间最佳的线性变换矩阵 , 将图像标定后每个像素的距离信息与点云进行配准 , 或者利用点云和摄像头像素的共线原理将点云投射到摄像头图像中进行融合 。

推荐阅读

- 新华网|法国:周末的汽车电影院

- |2020汽车零部件“双百强”诞生,中国企业规模化能力增强

- 新能源汽车|推动节能减排!新能源汽车助力建设青山绿水活动举行

- ZAKER汽车|帝豪破8万辆,逸动大涨61%,红旗H5第八,1-5月国产轿车销量排名

- 优视汽车|下半年买车可别错过,5款即将上市的重磅新车

- 胖子撩综艺|为什么特斯拉这么受欢迎?自主品牌造不出水平相当的电动汽车吗?

- 车家号|Z世代偏爱国产车,中国品牌将把控未来汽车市场!,近50%

- 汽车车集结号|起步2.0T,买不起卡宴选它,李书福不给大众活路!国产“奥迪Q5”上市

- 汽车之家|不负自己,七月,加油!爱你的日子由朗逸纯电开始,不负时光

- ZAKER汽车|却处处受限于英特尔,浪潮也遭“断供”之痛?市场份额第一