「」算力即权力?黄仁勋与他的 2000 TOPS 自动驾驶运算怪兽 | GTC 2020( 二 )

200TOPS暴打特斯拉HW3.0?

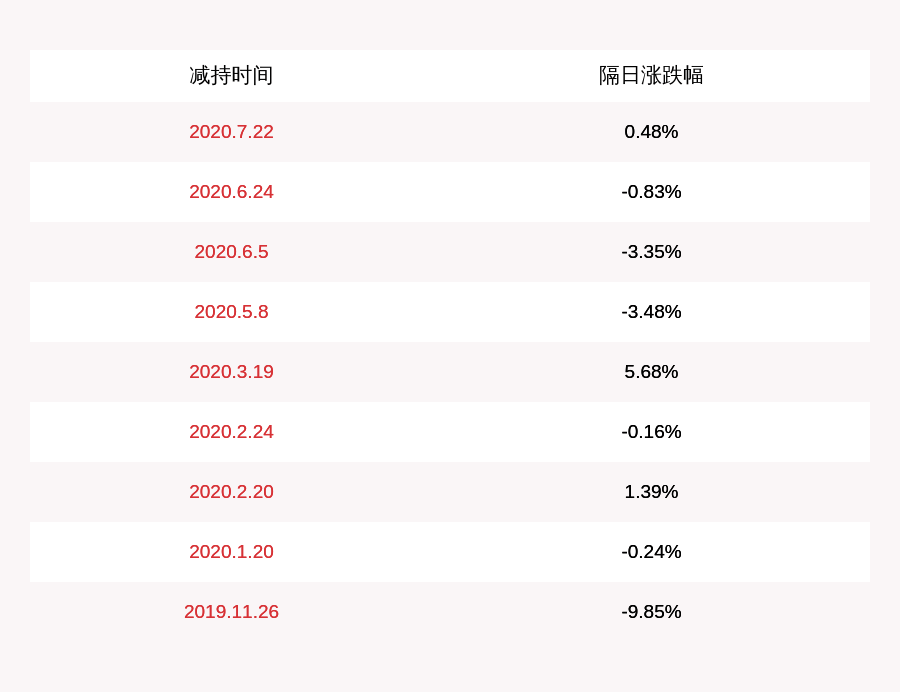

谈到自动驾驶芯片 , 就难免要提到红到发紫的特斯拉HW3.0硬件 。HW3.0整个计算模块可以提供144TOPS的算力 , 功耗需求200W , 基于单个OrinSOC的运算平台提供200TOPS的算力 , 功耗只要45W 。

文章图片

文章图片

如果仅仅从数据上来看 , 2年后交付的OrinSoC确实秒杀已经量产装车半年有余的HW3.0 。

但是只看算力合适么?

答案是不合适 , AI算法不是通用计算 , 算力不等于全部 , 算法效率更重要 。

让我们先回到第一章节提到的TensorCore , 在NVDIA给它起的硬核名字背后其实就一种通用矩阵硬件 。OrinSoC的核心部分实际上就是昨天发布的AmpereGPU内嵌 , 那AI能力同样是TensorCore赋予的 。

HW3.0呢?核心是NPU 。

TensorCore所代表的通用矩阵计算和HW3.0中NPU的直接卷积计算分别是整个行业两种截然不同的方向——二者的差别优劣 , 在这里难以展开 , 需要专门的文章进行阐释 。

事实上 , NVDIA通过大量运算单元的堆砌所提供的高算力支持是一个硬件厂商的本分 , 然而软硬研发分离的结果往往可能导致算法效率得不到最好的落实 , 这也是为什么特斯拉用NPU搭配自家AI算法的做法虽然缺乏通用性 , 但效率更高 。

如何去理解这个事情?

笔者咨询了一位负责NPU算法的资深工程师 , 得到如下回答:

"单纯看TOPS没有意义 , 要看实际计算结果 。打个比方:你的算法好 , 网络加速快 , 你只需要1/5的算力 , 就能得出结果 。要是你的芯片算得快 , 但是无法得出结果 , 那就是在浪费能量 。现在神经网络芯片 , 没有统一标准 , 没有统一架构 , 所以不能用统一Tops值去衡量算力 。"

当然 , 作为一个NPU算法工程师 , 他是认为直接进行硬件计算的NPU搭配极致优化的AI算法是最有效率的做法 。

所以在领略了NVDIA新硬件的血脉喷张之后 , 笔者发现自动驾驶发展核心要素其实还是算法 , 或者说是软硬结合的效率 。

这也是为什么NVDIA在提供Ampere架构产品的时候 , 重点提到了与前一代产品的通用性 , 比如PonyAi基于DriveAGXPegasus平台研发的自动驾驶算法在NVIDA新硬件交付之后可以直接无缝迁移到新平台上 , 继续累计此前所获得的算法效率经验 。

在车载芯片领域 , 英伟达的主要对手是英特尔旗下的Mobileye , 这家以色列公司几乎统治了整个ADAS市场 。至于自动驾驶的研发 , 也少不了Mobileye的身影 , 许多厂商甚至选择大杂烩战略 , 在开发L4系统时用英特尔的CPU搭配英伟达的GPU或SoC 。显然 , 这种架构上的混乱状态严重阻碍了代码的重复利用 , 也加重了整个行业的工作量 。

英伟达的卖点之一就是开发人员可以使用的通用架构 , 从最初的基准开发到仿真再到路测 。更重要的是 , 虽然新款芯片接连问世 , 它们依然保留着兼容性 , 因此在Xavier或更老平台上运行的代码可以直接移至Orin或后续产品 。

展望未来的产品线 , 英伟达将推出OrinADASSoC , 可与摄像头和雷达一起安装在挡风玻璃外壳中 。这款入门级芯片功耗只有5W , 但却能提供10TOPS的性能 , 驱动现有的ADAS功能绰绰有余 。

此外 , 马斯克此前在推特上提到的下一代自动驾驶硬件则需要2-3年的时间 , 自动驾驶领域的头部厂商们的血战 , 即将拉开序幕……你 , 期待吗?

推荐阅读

- 爱集微APP|调查将至?蓝牙配件商Tile指控苹果滥用权力并非法偏袒自家产品

- 苹果|配件商 Tile 指控苹果滥用权力并偏袒自家产品

- 芯片华为被断供背后:一场有关计算力的战争已经开始!

- 澎湃新闻OpenAI与微软押注通用AI:自研超算,算力排世界前五

- 计算新基建开启新计算时代 ,鲲鹏+昇腾构筑新基建坚实算力底座

- 腾讯新闻潜望一线 | 华为云发布政企战略 称算力将成新基建下新生产力

- NVIDIA黄仁勋「厨房演讲」宣布英伟达 GPU 史上最大性能飞跃

- 台积电黄仁勋称英伟达首款安培架构GPU A100由台积电代工

- 智能部署英伟达全新GPU 百度智能云算力再飞跃

- GPU黄仁勋从煤气灶下取出最新GPU:7nm全新安培架构,售价20万美元,训练性能顶6张V100