【算法】小狗Puppy都是狗!DeepMind大招,以视觉为媒介,做无监督机器翻译,效果极好( 二 )

AdaptLayer的作用是改变语言Y的单词嵌入空间 , 使语言Y中的单词嵌入尽可能地与语言X中的单词嵌入相似 。

关于视频编码器 , 作者使用了标准I3D模型 , 再加上一个将输出映射到联合嵌入空间中的线性层 。 编者注:I3D模型可以理解为基于2D卷积网络的增强版 , 全称是Two-Stream Inflated 3D ConvNet , 其论文被2017年CVPR收录 。

f、g、h分别对应语言X、Y以及视频Z的嵌入函数 , L定义为损失函数 。

整个模型的优化目标如上公式所示 , 据作者介绍 , 通过定义上面公式 , 能够将训练策略扩展到多语言情况 。

上述公式L(f,h)定义如下:

NCE定义如下:

通过最小化上述联合损失函数训练模型能够建立两种语言的映射关系 , 即对于给定的x∈X , 能够找到y∈Y 。

实验:“我”的模型更加稳健 在实验部分 , 对比当前能够达到SOTA的基于文本的翻译模型 , 作者发现他们的模型在翻译方面更加优秀 。

在实验过程中 , 作者对视频的转录本进行了token化 , 把每种语言的65536个最常用的单词汇聚到了一个词汇库 。 经过预处理 , 作者使用了word2vec训练单语单词嵌入 , 并在MUVE(作者文章中提出的算法)、MUSE和VecMap模型中使用这些预训练的嵌入 。

在训练时 , 作者从给定的数据集中抽取一个视频片段及其相应的旁白 。 每个训练批包括来自任一语种语言的片段 , 而NCE损失中的每个元素的负值是来自该批中的其他相同语言的元素 。

另外 , 对于视频编码器 , 作者在Kinetics-400数据集上预训练的I3D模型进行微调 , 对于语言模型作者在相应的HowToW-Text数据集上预训练了单词嵌入层 。

作者使用了Adam优化器 , 初始学习率设置为10^-3 , 批处理量为128 , 并在2个Cloud TPU上训练模型200k次迭代 。

在研究能否提高单词翻译质量方面 , 作者将自己的模型另外两个基线进行比较 。 第一个基线(Random Chance)采用的是在不使用视频的情况下检索出的翻译 , 第二个基采用了视频检索(Video Retrieval) , 使用视频创建两种语言之间的并行语料库 。

本文插图

如上图在英语到法语翻译上 , 作者的模型在这两个基准上的表现明显优于基准线 。 另外 , MUVE(第4行)比单独的基础模型(第3行)有了显著的改进(在字典和简单词基准上分别有+19.8%和+30.3%的绝对改进)

那么 , 模型能在多大程度上改进基于文本的单词翻译方法?作者实验了三种无监督方法和一种有监督方法 , 所有的方法都使用了在HowToW-Text上训练的单词嵌入方法 。

本文插图

如上 , 作者在对比英语和法语、韩语和日语之间的翻译结果之后 , 作者的MUVE方法最优 , 英韩和英日之间的翻译比基于文本的方法有着非常大的改进 。

但这也表明了单纯的基于文本的方法更适合“长相”类似的语言 , 如英语和法语 。

本文插图

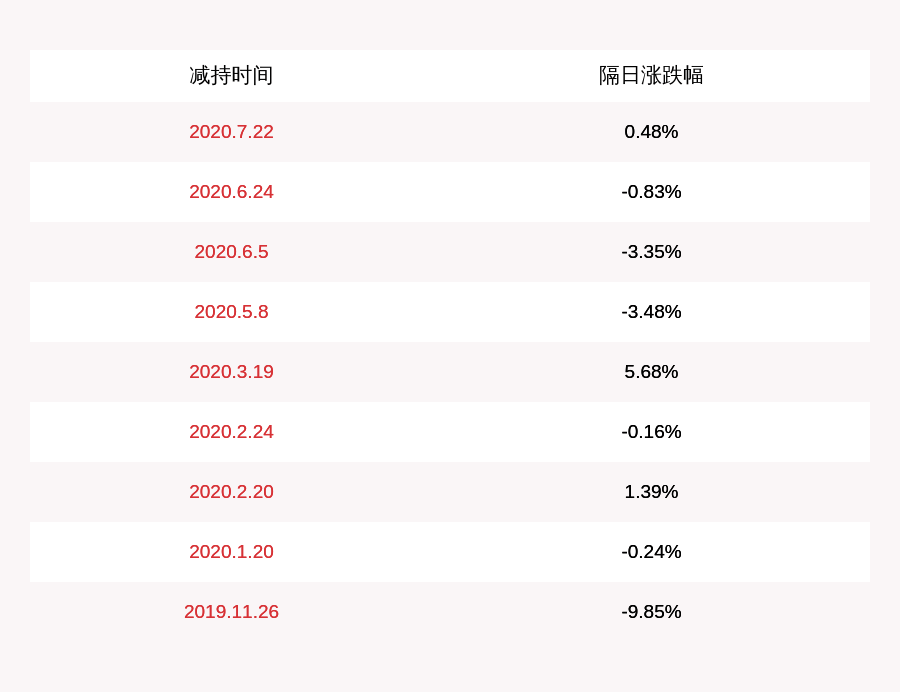

无监督单词翻译的稳健性如何?如上图所示 , 作者展示了MUVE、MUSE[10]、VecMap[4]在英法字典数据集中Recall@10的表现 , 并用JS距离( jensen-shannon , 上表中用~表示)测量异同度 。

结果显示 , 当当语料库相似时(例如Wiki-En和Wiki-FR) , 所有的方法都表现良好 。 当语料库不相似的时候 , MUVE明显优于其他方法 , 也更加稳健 。

本文插图

当训练数据量不同的时候 , 模型表现如何呢?上图展示了用原数据集体量的100%、10%、1%数据训练的结果 , 用 Recall@10衡量时 , 显然作者的方法在低资源(训练语料不足)情况下表现更好 。

推荐阅读

- #大华股份#大华股份AI荣获双目立体匹配算法评测全球排名第一

- #IT168#联芸科技发布新算法,QLC闪存迎来春天

- []俄罗斯数学家:下岗后当黑客,破解老虎机算法,横扫美国赌场捞金

- 「算法」AI芯片和传统芯片到底有何区别?

- 数码狂人@小米众筹女人“好帮手”!6种功能,1S出水,AI算法,白领:爱了

- [机器学习]每周一书《终极算法:机器学习和人工智能如何重塑世界》分享!

- 映维网:概述谷歌 Pixel 4 深度传感 uDepth 工作原理和底层算法

- 『IT知识课堂TB』求最长回文子串算法——马拉车算法

- 【算法】8比特数值也能训练模型?商汤提训练加速新算法丨CVPR 2020

- @小米首款墨水屏电子日历,内置高效番茄算法,还能提醒喝水、吃药