жңҖй…·зҡ„жҳҜпјҢиҝҷдёӘеә”з”ЁзЁӢеәҸжҖ»жҳҜиғҪж„ҸиҜҶеҲ°ж•°жҚ®ж–Ү件еӨ№дёӯзҡ„жӣҙж”№ гҖӮеҰӮжһңж·»еҠ еҸҰдёҖдёӘJSON Linesж–Ү件пјҢLLM Appе°ұдјҡеҸ‘жҢҘзҘһеҘҮзҡ„дҪңз”Ё пјҢ иҮӘеҠЁжӣҙж–°дәәе·ҘжҷәиғҪжЁЎеһӢзҡ„е“Қеә” гҖӮ

жӯҘйӘӨ2пјҡж•°жҚ®еҠ иҪҪе’Ңжҳ е°„дҪҝз”ЁPathwayзҡ„JSON Linesиҫ“е…ҘиҝһжҺҘеҷЁпјҢе°ҶиҜ»еҸ–жң¬ең°JSONlinesж–Ү件пјҢе°Ҷж•°жҚ®жқЎзӣ®жҳ е°„еҲ°жЁЎејҸдёӯпјҢ并еҲӣе»әдёҖдёӘи·Ҝеҫ„иЎЁ гҖӮеҸҜд»ҘеҸӮйҳ…app.pyдёӯзҡ„е®Ңж•ҙжәҗд»Јз Ғпјҡ

...sales_data = https://www.isolves.com/it/cxkf/yy/Python/2023-12-13/pw.io.jsonlines.read( "./examples/data", schema=DataInputSchema, mode="streaming")е°ҶжҜҸдёӘж•°жҚ®иЎҢжҳ е°„еҲ°з»“жһ„еҢ–ж–ҮжЎЈжЁЎејҸ гҖӮеҸҜд»ҘеҸӮйҳ…App.pyдёӯзҡ„е®Ңж•ҙжәҗд»Јз Ғпјҡ

class DataInputSchema(pw.Schema): doc: strжӯҘйӘӨ3пјҡж•°жҚ®еөҢе…ҘжҜҸдёӘж–ҮжЎЈйғҪеөҢе…ҘдәҶOpenAI API пјҢ 并жЈҖзҙўеөҢе…Ҙзҡ„з»“жһң гҖӮеҸҜд»ҘеҸӮйҳ…app.pyдёӯзҡ„е®Ңж•ҙжәҗд»Јз Ғпјҡ

гҖҗеҰӮдҪ•еңЁPythonдёӯдҪҝз”ЁChatGPT APIеӨ„зҗҶе®һж—¶ж•°жҚ®гҖ‘...embedded_data = https://www.isolves.com/it/cxkf/yy/Python/2023-12-13/embeddings(cnotallow=sales_data, data_to_embed=sales_data.doc)жӯҘйӘӨ4пјҡж•°жҚ®зҙўеј•з„¶еҗҺеңЁз”ҹжҲҗзҡ„еөҢе…ҘдёҠжһ„е»әдёҖдёӘеҚіж—¶зҙўеј•пјҡ

index = index_embeddings(embedded_data)жӯҘйӘӨ5пјҡз”ЁжҲ·жҹҘиҜўеӨ„зҗҶе’Ңзҙўеј•еҲӣе»әдёҖдёӘRESTз«ҜзӮ№ пјҢ д»ҺAPIиҜ·жұӮиҙҹиҪҪдёӯиҺ·еҸ–з”ЁжҲ·жҹҘиҜўпјҢ并е°Ҷз”ЁжҲ·жҹҘиҜўеөҢе…ҘOpenAI API гҖӮ

...query, response_writer = pw.io.http.rest_connector( host=host, port=port, schema=QueryInputSchema, autocommit_duration_ms=50,)embedded_query = embeddings(cnotallow=query, data_to_embed=pw.this.query)жӯҘйӘӨ6пјҡзӣёдјјжҖ§жҗңзҙўе’ҢжҸҗзӨәе·ҘзЁӢйҖҡиҝҮдҪҝз”Ёзҙўеј•жқҘиҜҶеҲ«жҹҘиҜўеөҢе…Ҙзҡ„жңҖзӣёе…іеҢ№й…ҚжқҘжү§иЎҢзӣёдјјжҖ§жҗңзҙў гҖӮ然еҗҺжһ„е»әдёҖдёӘжҸҗзӨәпјҢе°Ҷз”ЁжҲ·зҡ„жҹҘиҜўдёҺиҺ·еҸ–зҡ„зӣёе…іж•°жҚ®з»“жһңеҗҲ并пјҢ并е°Ҷж¶ҲжҒҜеҸ‘йҖҒеҲ°ChatGPTе®ҢжҲҗз«ҜзӮ№ пјҢ д»Ҙз”ҹжҲҗжӯЈзЎ®дё”иҜҰз»Ҷзҡ„е“Қеә” гҖӮ

responses = prompt(index, embedded_query, pw.this.query)еҪ“еҲ¶дҪңжҸҗзӨәз¬Ұ并еңЁprompt.pyдёӯеҗ‘ChatGPTж·»еҠ еҶ…йғЁзҹҘиҜҶж—¶пјҢйҒөеҫӘдәҶзӣёеҗҢзҡ„еңәжҷҜеӯҰд№ ж–№жі• гҖӮ

prompt = f"Given the following discounts data: \n {docs_str} \nanswer this query: {query}"жӯҘйӘӨ7пјҡиҝ”еӣһе“Қеә”жңҖеҗҺдёҖжӯҘе°ұжҳҜе°ҶAPIе“Қеә”иҝ”еӣһз»ҷз”ЁжҲ· гҖӮ

# Build prompt using indexed dataresponses = prompt(index, embedded_query, pw.this.query)жӯҘйӘӨ8пјҡе°ҶжҠҠжүҖжңүжӯҘйӘӨж”ҫеңЁдёҖиө·зҺ°еңЁпјҢеҰӮжһңе°ҶдёҠиҝ°жүҖжңүжӯҘйӘӨж”ҫеңЁдёҖиө·пјҢе°ұжӢҘжңүдәҶз”ЁдәҺиҮӘе®ҡд№үжҠҳжүЈж•°жҚ®зҡ„ж”ҜжҢҒLLMзҡ„Python APIпјҢеҸҜд»ҘеңЁapp.py Pythonи„ҡжң¬дёӯзңӢеҲ°е®һзҺ° гҖӮ

import pathway as pwfrom common.embedder import embeddings, index_embeddingsfrom common.prompt import promptdef run(host, port): # Given a user question as a query from your API query, response_writer = pw.io.http.rest_connector( host=host, port=port, schema=QueryInputSchema, autocommit_duration_ms=50, ) # Real-time data coming from external data sources such as jsonlines file sales_data = https://www.isolves.com/it/cxkf/yy/Python/2023-12-13/pw.io.jsonlines.read( "./examples/data", schema=DataInputSchema, mode="streaming" ) # Compute embeddings for each document using the OpenAI Embeddings API embedded_data = embeddings(cnotallow=sales_data, data_to_embed=sales_data.doc) # Construct an index on the generated embeddings in real-time index = index_embeddings(embedded_data) # Generate embeddings for the query from the OpenAI Embeddings API embedded_query = embeddings(cnotallow=query, data_to_embed=pw.this.query) # Build prompt using indexed data responses = prompt(index, embedded_query, pw.this.query) # Feed the prompt to ChatGPT and obtain the generated answer. response_writer(responses) # Run the pipeline pw.run()class DataInputSchema(pw.Schema): doc: strclass QueryInputSchema(pw.Schema): query: strжӯҘйӘӨ9 (еҸҜйҖү)пјҡж·»еҠ дәӨдә’ејҸUIдёәдәҶи®©еә”з”ЁзЁӢеәҸжӣҙе…·дә’еҠЁжҖ§е’Ңз”ЁжҲ·еҸӢеҘҪжҖ§пјҢеҸҜд»ҘдҪҝз”ЁStreamlitжқҘжһ„е»әдёҖдёӘеүҚз«Ҝеә”з”Ё гҖӮ

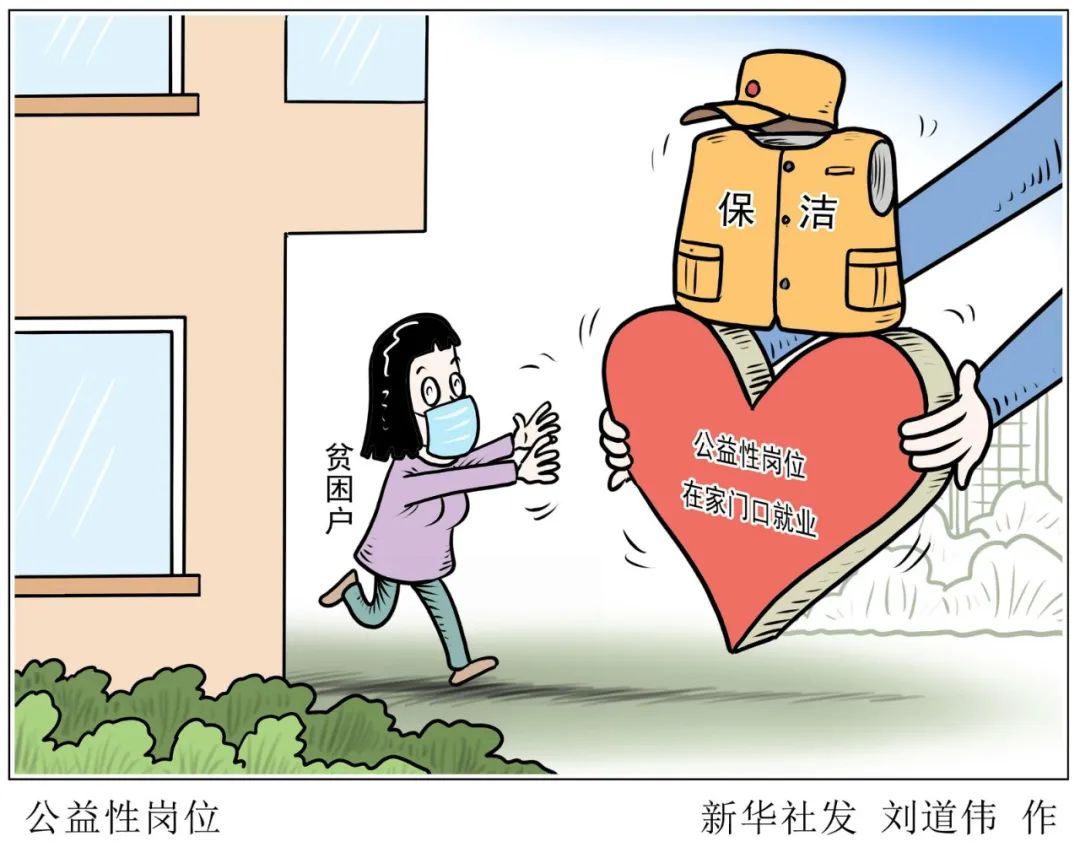

ж–Үз« жҸ’еӣҫ

иҝҗиЎҢеә”з”ЁзЁӢеәҸжҢүз…§README. Mdж–Ү件дёӯ“еҰӮдҪ•иҝҗиЎҢйЎ№зӣ®”дёҖиҠӮдёӯзҡ„иҜҙжҳҺпјҢеҸҜд»ҘејҖе§ӢиҜўй—®жңүе…іжҠҳжүЈзҡ„й—®йўҳпјҢAPIе°Ҷж №жҚ®ж·»еҠ зҡ„жҠҳжүЈж•°жҚ®жәҗеҒҡеҮәе“Қеә” гҖӮ

еңЁдҪҝз”ЁUI(еә”з”Ёж•°жҚ®жәҗ)е°ҶиҝҷдәӣзҹҘиҜҶжҸҗдҫӣз»ҷGPTд№ӢеҗҺпјҢзңӢзңӢе®ғжҳҜеҰӮдҪ•еӣһеӨҚзҡ„пјҡ

ж–Үз« жҸ’еӣҫ

иҝҷдёӘеә”з”ЁзЁӢеәҸиҖғиҷ‘дәҶRainforest APIе’Ңdiscount .csvж–Ү件ж–ҮжЎЈ(з«ӢеҚіеҗҲ并жқҘиҮӘиҝҷдәӣжқҘжәҗзҡ„ж•°жҚ®)пјҢе®һж—¶еҜ№е…¶иҝӣиЎҢзҙўеј•пјҢ并еңЁеӨ„зҗҶжҹҘиҜўж—¶дҪҝз”Ёиҝҷдәӣж•°жҚ® гҖӮ

иҝӣдёҖжӯҘзҡ„ж”№иҝӣйҖҡиҝҮеҗ‘ChatGPTж·»еҠ жҠҳжүЈзӯүйўҶеҹҹзү№е®ҡзҹҘиҜҶпјҢеҸ‘зҺ°дәҶLLMеә”з”ЁзЁӢеәҸзҡ„дёҖдәӣеҠҹиғҪ гҖӮиҝҳеҸҜд»ҘеҒҡжӣҙеӨҡзҡ„дәӢжғ…пјҡ

- ж•ҙеҗҲжқҘиҮӘеӨ–йғЁAPIзҡ„йўқеӨ–ж•°жҚ® пјҢ д»ҘеҸҠеҗ„з§Қж–Ү件(дҫӢеҰӮJsonlinesгҖҒPDFгҖҒDocгҖҒhtmlжҲ–Textж јејҸ)пјҢPostgreSQLжҲ–MySQLзӯүж•°жҚ®еә“ пјҢ д»ҘеҸҠжқҘиҮӘKafkaгҖҒRedpandaжҲ–Debedizumзӯүе№іеҸ°зҡ„жөҒж•°жҚ® гҖӮ

жҺЁиҚҗйҳ…иҜ»

- еҰӮдҪ•йҖүз”Ёй”Ӯз”өжұ еқҮиЎЎд»Ә

- 2023еҖјеҫ—дёҖзҺ©зҡ„жүӢжёёжҺЁиҚҗ

- жҲ‘зҡ„жүӢжңәжҲ‘еҒҡдё»пјҢеҰӮдҪ•дёәAndroidжүӢжңәеә”з”ЁжҚўеӣҫж Үпјҹ

- иҲӘз©әе…¬еҸёиҜҘеҰӮдҪ•йҖүжӢ©пјҢиҒ”еҗҲиҲӘз©әе…¬еҸёеҰӮдҪ•йҖүеә§дҪҚ

- еҫ®дҝЎжҠ•зҘЁиғҪеҰӮдҪ•ж“ҚдҪңпјҢеҫ®дҝЎжҠ•зҘЁеҰӮдҪ•еҝ«йҖҹжӢҝ1000зҘЁ

- еҸ¶еҖ©ж–Үпјҡй”ҷиҝҮиҙ№зҝ”еҗҺеҺ»жҠўй—әиңңзҡ„иҖҒе…¬пјҢеҰӮд»Ҡ62еІҒж— е„ҝж— еҘіе·Із»ҸзҷҪеӨҙ

- йҹ©еӣҪеӨ«дәәеҮәеёӯиҚ·е…°еӣҪе®ҙжӢҝеҮәжҲҳиўҚпјҒз©ҝжіЎжіЎиў–е°Ҹй»‘иЈҷзҫҺеҰӮиө«жң¬пјҢзҫҺзҝ»дәҶ

- еҰӮдҪ•дҝ®еӨҚж„ҹжғ…

- д»ҠеҶ¬еҘіеҸ‘еҲ«зһҺеүӘпјҢдёҚеҰӮиҜ•иҜ•иҝҷеӣӣз§ҚпјҢжҙӢж°”зҳҰи„ёжҳҫж°”иҙЁ

- еҫ®дҝЎйӘҢиҜҒж¶ҲжҒҜиғҪеҰӮдҪ•зңӢе…ЁпјҢдёәд»Җд№Ҳеҫ®дҝЎдә’еҲ еҗҺйӘҢиҜҒж¶ҲжҒҜд№ҹж¶ҲеӨұдәҶ