еңЁеҺ»е№ҙ 10 жңҲзҡ„ google Cloud Next 2022 жҙ»еҠЁдёӯпјҢOpenXLA йЎ№зӣ®жӯЈејҸжө®еҮәж°ҙйқўпјҢи°·жӯҢдёҺеҢ…жӢ¬йҳҝйҮҢе·ҙе·ҙгҖҒAMDгҖҒArmгҖҒдәҡ马йҖҠгҖҒиӢұзү№е°”гҖҒиӢұдјҹиҫҫзӯү科жҠҖе…¬еҸёжҺЁеҠЁзҡ„ејҖжәҗ AI жЎҶжһ¶еҗҲдҪңпјҢиҮҙеҠӣдәҺжұҮйӣҶдёҚеҗҢжңәеҷЁеӯҰд№ жЎҶжһ¶пјҢи®©жңәеҷЁеӯҰд№ ејҖеҸ‘дәәе‘ҳиҺ·еҫ—иғҪдё»еҠЁйҖүжӢ©жЎҶжһ¶гҖҒ硬件зҡ„иғҪеҠӣ гҖӮ

жң¬е‘ЁдёүпјҢи°·жӯҢе®Јеёғ OpenXLA йЎ№зӣ®жӯЈејҸејҖжәҗ гҖӮ

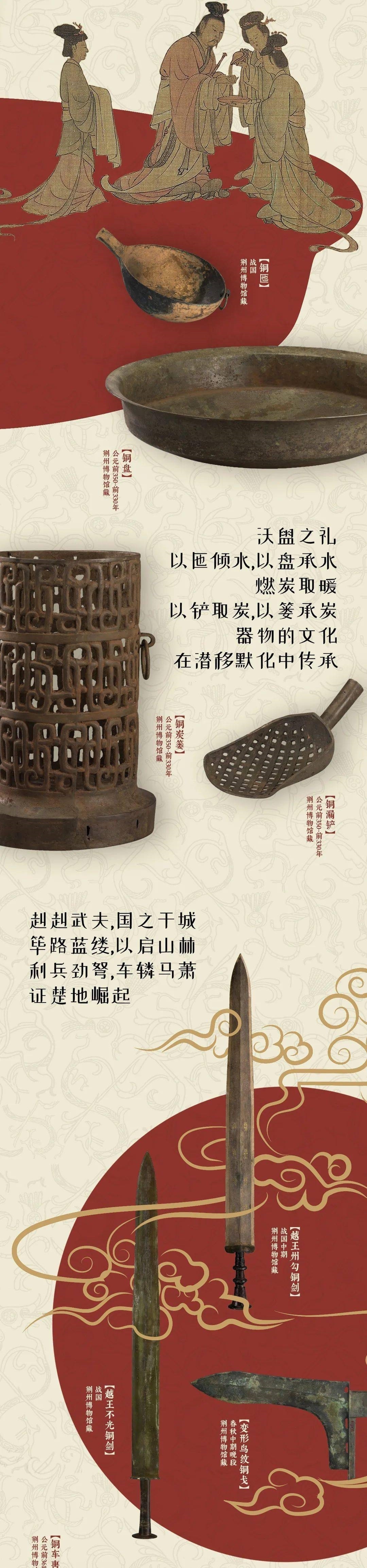

ж–Үз« жҸ’еӣҫ

йЎ№зӣ®й“ҫжҺҘпјҡ

https://github.com/openxla/xla

йҖҡиҝҮеҲӣе»әдёҺеӨҡз§ҚдёҚеҗҢжңәеҷЁеӯҰд№ жЎҶжһ¶гҖҒ硬件平еҸ°е…ұеҗҢе·ҘдҪңзҡ„з»ҹдёҖжңәеҷЁеӯҰд№ зј–иҜ‘еҷЁпјҢOpenXLA еҸҜд»ҘеҠ йҖҹжңәеҷЁеӯҰд№ еә”з”Ёзҡ„дәӨд»ҳ并жҸҗдҫӣжӣҙеӨ§зҡ„д»Јз ҒеҸҜ移жӨҚжҖ§ гҖӮеҜ№дәҺ AI з ”з©¶е’Ңеә”з”ЁжқҘиҜҙпјҢиҝҷжҳҜдёҖдёӘж„Ҹд№үйҮҚеӨ§зҡ„йЎ№зӣ®пјҢJeff Dean д№ҹеңЁзӨҫдәӨзҪ‘з»ңдёҠиҝӣиЎҢдәҶе®Јдј гҖӮ

ж–Үз« жҸ’еӣҫ

еҰӮд»ҠпјҢжңәеҷЁеӯҰд№ ејҖеҸ‘е’ҢйғЁзҪІеҸ—еҲ°зўҺзүҮеҢ–зҡ„еҹәзЎҖи®ҫж–Ҫзҡ„еҪұе“ҚпјҢиҝҷдәӣеҹәзЎҖи®ҫж–ҪеҸҜиғҪеӣ жЎҶжһ¶гҖҒ硬件е’Ңз”ЁдҫӢиҖҢејӮ гҖӮиҝҷз§Қзӣёдә’йҡ”з»қйҷҗеҲ¶дәҶејҖеҸ‘дәәе‘ҳзҡ„е·ҘдҪңйҖҹеәҰпјҢ并еҜ№жЁЎеһӢзҡ„еҸҜ移жӨҚжҖ§гҖҒж•ҲзҺҮе’Ңз”ҹдә§еҢ–йҖ жҲҗдәҶйҡңзўҚ гҖӮ

3 жңҲ 8 ж—ҘпјҢи°·жӯҢзӯүжңәжһ„йҖҡиҝҮ OpenXLA йЎ№зӣ®пјҲе…¶дёӯеҢ…жӢ¬ XLAгҖҒStableHLO е’Ң IREE еӯҳеӮЁеә“пјүзҡ„ејҖж”ҫпјҢжңқзқҖж¶ҲйҷӨиҝҷдәӣйҡңзўҚиҝҲеҮәдәҶйҮҚиҰҒдёҖжӯҘ гҖӮ

OpenXLA жҳҜз”ұ AI / жңәеҷЁеӯҰд№ иЎҢдёҡйўҶеҜјиҖ…е…ұеҗҢејҖеҸ‘зҡ„ејҖжәҗ ML зј–иҜ‘еҷЁз”ҹжҖҒзі»з»ҹпјҢиҙЎзҢ®иҖ…еҢ…жӢ¬йҳҝйҮҢе·ҙе·ҙгҖҒAWSгҖҒAMDгҖҒиӢ№жһңгҖҒArmгҖҒCerebrasгҖҒи°·жӯҢгҖҒGraphcoreгҖҒHugging FaceгҖҒиӢұзү№е°”гҖҒMeta е’ҢиӢұдјҹиҫҫ гҖӮе®ғдҪҝеҫ—ејҖеҸ‘дәәе‘ҳиғҪеӨҹзј–иҜ‘е’ҢдјҳеҢ–жқҘиҮӘжүҖжңүйўҶе…ҲжңәеҷЁеӯҰд№ жЎҶжһ¶зҡ„жЁЎеһӢпјҢд»ҘдҫҝеңЁеҗ„з§Қ硬件дёҠиҝӣиЎҢй«ҳж•Ҳи®ӯз»ғе’ҢжңҚеҠЎ гҖӮдҪҝз”Ё OpenXLA зҡ„ејҖеҸ‘дәәе‘ҳеҸҜд»Ҙи§ӮеҜҹеҲ°и®ӯз»ғж—¶й—ҙгҖҒеҗһеҗҗйҮҸгҖҒжңҚеҠЎе»¶иҝҹд»ҘеҸҠжңҖз»ҲеҸ‘еёғе’Ңи®Ўз®—жҲҗжң¬ж–№йқўзҡ„жҳҺжҳҫжҸҗеҚҮ гҖӮ

жңәеҷЁеӯҰд№ жҠҖжңҜи®ҫж–Ҫйқўдёҙзҡ„жҢ‘жҲҳ

йҡҸзқҖ AI жҠҖжңҜиҝӣе…Ҙе®һз”Ёйҳ¶ж®өпјҢи®ёеӨҡиЎҢдёҡзҡ„ејҖеҸ‘еӣўйҳҹйғҪеңЁдҪҝз”ЁжңәеҷЁеӯҰд№ жқҘеә”еҜ№зҺ°е®һдё–з•Ңзҡ„жҢ‘жҲҳпјҢдҫӢеҰӮиҝӣиЎҢз–ҫз—…зҡ„йў„жөӢе’Ңйў„йҳІгҖҒдёӘжҖ§еҢ–еӯҰд№ дҪ“йӘҢе’Ңй»‘жҙһзү©зҗҶеӯҰжҺўзҙў гҖӮ

йҡҸзқҖжЁЎеһӢеҸӮж•°ж•°йҮҸе‘ҲжҢҮж•°зә§еўһй•ҝпјҢж·ұеәҰеӯҰд№ жЁЎеһӢжүҖйңҖзҡ„и®Ўз®—йҮҸжҜҸе…ӯдёӘжңҲзҝ»дёҖз•ӘпјҢејҖеҸ‘дәәе‘ҳжӯЈеңЁеҜ»жұӮеҹәзЎҖжһ¶жһ„зҡ„жңҖеӨ§жҖ§иғҪе’ҢеҲ©з”ЁзҺҮ гҖӮеӨ§йҮҸеӣўйҳҹжӯЈеңЁеҲ©з”ЁеӨҡеһӢеҸ·з§Қзұ»зҡ„硬件пјҢд»Һж•°жҚ®дёӯеҝғдёӯзҡ„иҠӮиғҪжңәеҷЁеӯҰд№ дё“з”Ё ASIC еҲ°еҸҜд»ҘжҸҗдҫӣжӣҙеҝ«е“Қеә”йҖҹеәҰзҡ„ AI иҫ№зјҳеӨ„зҗҶеҷЁ гҖӮзӣёеә”зҡ„пјҢдёәдәҶжҸҗй«ҳж•ҲзҺҮпјҢиҝҷдәӣ硬件и®ҫеӨҮдҪҝз”Ёе®ҡеҲ¶еҢ–зҡ„зӢ¬зү№з®—жі•е’ҢиҪҜ件еә“ гҖӮ

дҪҶеҸҰдёҖж–№йқўпјҢеҰӮжһңжІЎжңүйҖҡз”Ёзҡ„зј–иҜ‘еҷЁе°ҶдёҚеҗҢ硬件и®ҫеӨҮжЎҘжҺҘеҲ°еҪ“д»ҠдҪҝз”Ёзҡ„еӨҡз§ҚжЎҶжһ¶пјҲдҫӢеҰӮ TensorFlowгҖҒPyTorchпјүдёҠпјҢдәә们е°ұйңҖиҰҒд»ҳеҮәеӨ§йҮҸеҠӘеҠӣжүҚиғҪжңүж•Ҳең°иҝҗиЎҢжңәеҷЁеӯҰд№ гҖӮеңЁе®һйҷ…е·ҘдҪңдёӯпјҢејҖеҸ‘дәәе‘ҳеҝ…йЎ»жүӢеҠЁдјҳеҢ–жҜҸдёӘ硬件зӣ®ж Үзҡ„жЁЎеһӢж“ҚдҪң гҖӮиҝҷж„Ҹе‘ізқҖдҪҝз”Ёе®ҡеҲ¶иҪҜ件еә“жҲ–зј–еҶҷзү№е®ҡдәҺи®ҫеӨҮзҡ„д»Јз ҒйңҖиҰҒйўҶеҹҹдё“дёҡзҹҘиҜҶ гҖӮ

иҝҷжҳҜдёҖдёӘзҹӣзӣҫзҡ„з»“жһңпјҢдёәдәҶжҸҗй«ҳж•ҲзҺҮдҪҝз”Ёдё“з”ЁжҠҖжңҜпјҢз»“жһңеҚҙжҳҜи·ЁжЎҶжһ¶е’Ң硬件зҡ„еӯӨз«ӢгҖҒдёҚеҸҜжҰӮжӢ¬зҡ„и·Ҝеҫ„еҜјиҮҙз»ҙжҠӨжҲҗжң¬й«ҳпјҢиҝӣиҖҢеҜјиҮҙдҫӣеә”е•Ҷй”Ғе®ҡпјҢеҮҸзј“дәҶжңәеҷЁеӯҰд№ ејҖеҸ‘зҡ„иҝӣеәҰ гҖӮ

и§ЈеҶіж–№жі•е’Ңзӣ®ж Ү

OpenXLA йЎ№зӣ®жҸҗдҫӣдәҶжңҖе…Ҳиҝӣзҡ„ ML зј–иҜ‘еҷЁпјҢеҸҜд»ҘеңЁ ML еҹәзЎҖи®ҫж–Ҫзҡ„еӨҚжқӮжҖ§дёӯиҝӣиЎҢжү©еұ• гҖӮе®ғзҡ„ж ёеҝғж”ҜжҹұжҳҜжҖ§иғҪгҖҒеҸҜжү©еұ•жҖ§гҖҒеҸҜ移жӨҚжҖ§гҖҒзҒөжҙ»жҖ§е’Ңжҳ“з”ЁжҖ§ гҖӮеҖҹеҠ© OpenXLAпјҢжҲ‘们жёҙжңӣйҖҡиҝҮеҠ йҖҹдәәе·ҘжҷәиғҪзҡ„ејҖеҸ‘е’ҢдәӨд»ҳжқҘе®һзҺ° AI еңЁзҺ°е®һдё–з•Ңдёӯзҡ„жӣҙеӨ§жҪңеҠӣ гҖӮ

OpenXLA зҡ„зӣ®ж ҮеңЁдәҺпјҡ

йҖҡиҝҮйҖӮз”ЁдәҺд»»дҪ•жЎҶжһ¶пјҢжҺҘе…Ҙдё“з”Ёи®ҫеӨҮеҗҺз«Ҝе’ҢдјҳеҢ–зҡ„з»ҹдёҖзј–иҜ‘еҷЁ APIпјҢдҪҝејҖеҸ‘дәәе‘ҳеҸҜд»ҘиҪ»жқҫең°еңЁд»–们зҡ„йҰ–йҖүжЎҶжһ¶дёӯй’ҲеҜ№еҗ„з§Қ硬件编иҜ‘е’ҢдјҳеҢ–д»»дҪ•жЁЎеһӢ гҖӮ

дёәеҪ“еүҚе’Ңж–°е…ҙжЁЎеһӢжҸҗдҫӣиЎҢдёҡйўҶе…Ҳзҡ„жҖ§иғҪпјҢд№ҹеҸҜжү©еұ•иҮіеӨҡдёӘдё»жңәе’ҢеҠ йҖҹеҷЁж»Ўи¶іиҫ№зјҳйғЁзҪІзҡ„йҷҗеҲ¶пјҢ并жҺЁе№ҝеҲ°жңӘжқҘзҡ„ж–°еһӢжЁЎеһӢжһ¶жһ„дёҠ гҖӮ

жһ„е»әдёҖдёӘеҲҶеұӮе’ҢеҸҜжү©еұ•зҡ„жңәеҷЁеӯҰд№ зј–иҜ‘еҷЁе№іеҸ°пјҢдёәејҖеҸ‘дәәе‘ҳжҸҗдҫӣеҹәдәҺ MLIR зҡ„组件пјҢиҝҷдәӣ组件еҸҜй’ҲеҜ№е…¶зӢ¬зү№зҡ„з”ЁдҫӢиҝӣиЎҢйҮҚж–°й…ҚзҪ®пјҢз”ЁдәҺ硬件е®ҡеҲ¶еҢ–зј–иҜ‘жөҒзЁӢ гҖӮ

гҖҗAIејҖеҸ‘еӨ§дёҖз»ҹпјҡи°·жӯҢOpenXLAејҖжәҗпјҢж•ҙеҗҲжүҖжңүжЎҶжһ¶е’ҢAIиҠҜзүҮгҖ‘AI/ML йўҶеҜјиҖ…зӨҫеҢә

жҲ‘们д»ҠеӨ©еңЁжңәеҷЁеӯҰд№ еҹәзЎҖжһ¶жһ„дёӯйқўдёҙзҡ„жҢ‘жҲҳжҳҜе·ЁеӨ§зҡ„пјҢжІЎжңүд»»дҪ•дёҖдёӘз»„з»ҮеҸҜд»ҘеҚ•зӢ¬жңүж•Ҳең°и§ЈеҶіиҝҷдәӣжҢ‘жҲҳ гҖӮOpenXLA зӨҫеҢәжұҮйӣҶдәҶеңЁ AI е Ҷж Ҳзҡ„дёҚеҗҢзә§еҲ«пјҲд»ҺжЎҶжһ¶еҲ°зј–иҜ‘еҷЁгҖҒruntime е’ҢиҠҜзүҮпјүдёҠиҝҗиЎҢзҡ„ејҖеҸ‘дәәе‘ҳе’ҢиЎҢдёҡйўҶеҜјиҖ…пјҢеӣ жӯӨйқһеёёйҖӮеҗҲи§ЈеҶіжҲ‘们еңЁ ML йўҶеҹҹзңӢеҲ°зҡ„зўҺзүҮеҢ–й—®йўҳ гҖӮ

дҪңдёәдёҖдёӘејҖжәҗйЎ№зӣ®пјҢOpenXLA йҒөеҫӘд»ҘдёӢеҺҹеҲҷпјҡ

е№ізӯүең°дҪҚпјҡдёӘдәәж— и®әд»Һеұһе…ізі»еҰӮдҪ•пјҢйғҪе№ізӯүең°еҒҡеҮәиҙЎзҢ® гҖӮжҠҖжңҜйўҶеҜјиҖ…жҳҜйӮЈдәӣиҙЎзҢ®жңҖеӨҡж—¶й—ҙе’ҢзІҫеҠӣзҡ„дәә гҖӮ

е°ҠйҮҚж–ҮеҢ–пјҡжүҖжңүжҲҗе‘ҳйғҪеә”з»ҙжҠӨйЎ№зӣ®д»·еҖји§Ӯе’ҢиЎҢдёәеҮҶеҲҷпјҢж— и®ә他们еңЁзӨҫеҢәдёӯзҡ„иҒҢдҪҚеҰӮдҪ• гҖӮ

еҸҜжү©еұ•гҖҒй«ҳж•Ҳзҡ„жІ»зҗҶпјҡе°ҸеӣўйҳҹеҒҡеҮәеҹәдәҺе…ұиҜҶзҡ„еҶізӯ–пјҢе…·жңүжё…жҷ°дҪҶеҫҲе°‘дҪҝз”Ёзҡ„еҚҮзә§и·Ҝеҫ„ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- жүӢжҠҠжүӢж•ҷдҪ ејҖеҸ‘дёҖеҘ—д»Јз Ғз”ҹжҲҗеҷЁпјҢеӯҰдёҚдјҡзҡ„жқҘжҖјжҲ‘пјҒ

- и°·жӯҢзңјй•ңдёәд»Җд№ҲеӨұиҙҘ(и°·жӯҢзңјй•ңеҪ•еғҸж—¶й—ҙ)

- дёҙжіүзҠ¶е…ғеәңдәҢжүӢжҲҝеҮәе”® дёҙжіүдәҢжүӢжҲҝ

- ж»ЁжұҹйӣҶеӣўејҖеҸ‘зҡ„жҘјзӣҳ жқӯе·һж»ЁжұҹйӣҶеӣў

- и°·жӯҢжөҸи§ҲеҷЁжҸ’件被йҳ»жӯў и°·жӯҢиў«еұҸи”Ҫ

- vcејҖеҸ‘ vcз•Ңйқўеә“

- и°·жӯҢжөҸи§ҲеҷЁжү“дёҚејҖжҖҺд№ҲеҠһ жөҸи§ҲеҷЁжү“дёҚејҖжҖҺд№ҲеҠһ

- иҫҪжәҗеёӮжҖҘеҚ–дәҢжүӢжҲҝ иҫҪжәҗеёӮең°еӣҫ

- и„‘еҚ’дёӯеә·еӨҚзҡ„дёүдёӘйҳ¶ж®ө и„‘еҚ’дёӯзӯӣжҹҘ

- жіүе·һзҪ‘з«ҷејҖеҸ‘ жіүе·һseo