urllib.request.ProxyHandler({'http':'http://fsdfffs.com','https':'https://fsdfwe.com'})иҝҷж ·е°ұеҸҜд»ҘйҒҝе…ҚеҗҢдёҖдёӘIPи®ҝй—®зҪ‘з«ҷеӨҡж¬Ўиў«е°Ғзҡ„е°ҙе°¬еұҖйқўдәҶ гҖӮ

import urllib.requestproxy_handler = urllib.request.ProxyHandler({ 'http': 'http://127.0.0.1:8000', 'https': 'https://127.0.0.1:8000'})opener = urllib.request.build_opener(proxy_handler) #жһ„е»әд»ЈзҗҶжұ response = opener.open('https://book.qidian.com/info/1014243481#Catalog') #д»ЈзҗҶи®ҝй—®зҪ‘з«ҷprint(response.read)

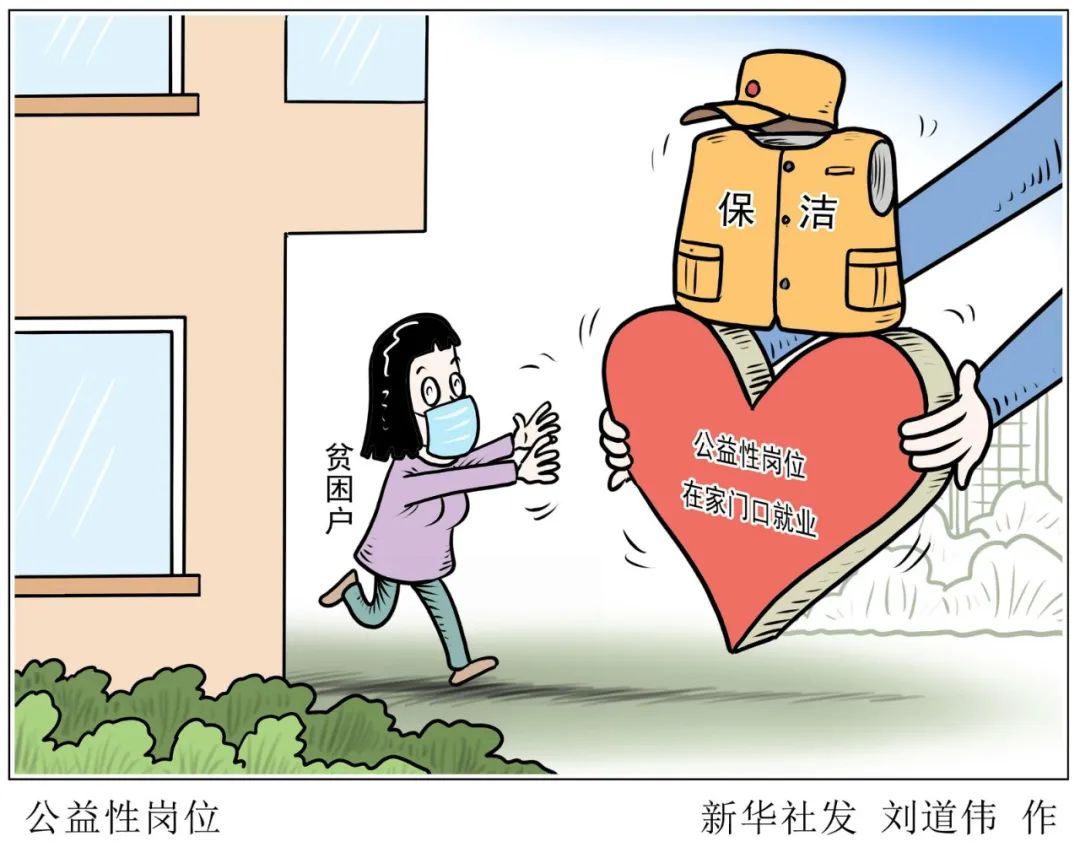

ж–Үз« жҸ’еӣҫ

еҸҜд»ҘзңӢеҮәпјҢз”ұдәҺжң¬дәәдҪҝз”Ёж— з”Ёзҡ„IPеҜјиҮҙй“ҫжҺҘй”ҷиҜҜпјҢжүҖд»ҘжӯӨж—¶еә”иҜҘеӨ„зҗҶејӮеёё гҖӮ

ж–Үз« жҸ’еӣҫ

жҚўдәҶз§ҚеӨ„зҗҶејӮеёёзҡ„ж–№ејҸпјҢдёҚиҝҮжҖ»зҡ„жқҘиҜҙиҝҳжҳҜжҜ”иҫғе…Ёйқўзҡ„ гҖӮејӮеёёжЁЎеқ—дёӯжңүдёӨдёӘејӮеёёй”ҷиҜҜпјҡ

URLErrorпјҢHTTPErrorпјҢе…¶дёӯHTTPErrorжҳҜURLErrorзҡ„еӯҗзұ»пјҢURLError йҮҢеҸӘжңүдёҖдёӘеұһжҖ§пјҡreason,еҚіжҠ“ејӮеёёзҡ„ж—¶еҖҷеҸӘиғҪжү“еҚ°й”ҷиҜҜдҝЎжҒҜпјҢзұ»дјјдёҠйқўзҡ„дҫӢеӯҗ гҖӮ

HTTPError йҮҢжңүдёүдёӘеұһжҖ§пјҡcode,reason,headersпјҢеҚіжҠ“ејӮеёёзҡ„ж—¶еҖҷеҸҜд»ҘиҺ·еҫ—codeпјҢresonпјҢheadersдёүдёӘдҝЎжҒҜпјҢ

import socketimport urllib.requestimport urllib.erroraa=''try: response = urllib.request.urlopen('https://book.qidian.com/info/1014243481#Catalog', timeout=0.1) aa=response.read.decode('utf8')except urllib.error.URLError as e: print(e.reason) if isinstance(e.reason,socket.timeout): print("time out")except urllib.error.HTTPError as e:print(e.reason,e.code)finally: print(aa)йҷӨжӯӨд№ӢеӨ–пјҢе®ғиҝҳеҸҜд»ҘеӨ„зҗҶcookieж•°жҚ®пјҢдёҚиҝҮиҰҒеҖҹеҠ©еҸҰдёҖдёӘжЁЎеқ— http гҖӮimport http.cookiejar, urllib.requestcookie = http.cookiejar.CookieJar #еҲӣе»әcookiejarеҜ№иұЎhandler = urllib.request.HTTPCookieProcessor(cookie) е»әз«ӢcookieиҜ·жұӮopener = urllib.request.build_opener(handler) #жһ„е»әиҜ·жұӮresponse = opener.open('https://www.baidu.com') #еҸ‘йҖҒиҜ·жұӮfor item in cookie: print(item.name+"="+item.value) #жү“еҚ°cookieдҝЎжҒҜеҗҢж—¶cookieеҸҜд»ҘеҶҷе…ҘеҲ°ж–Ү件дёӯдҝқеӯҳпјҢжңүдёӨз§Қж–№ејҸhttp.cookiejar.MozillaCookieJarе’Ңhttp.cookiejar.LWPCookieJarпјҢжғіз”Ёе“Әз§ҚиҮӘе·ұеҶіе®ҡ гҖӮhttp.cookiejar.MozillaCookieJarж–№ејҸ

import http.cookiejar, urllib.requestfilename = "cookie.txt"cookie = http.cookiejar.MozillaCookieJar(file_name)handler = urllib.request.HTTPCookieProcessor(cookie)opener = urllib.request.build_opener(handler)response = opener.open('https://www.baidu.com')cookie.save(ignore_discard=True, ignore_expires=True)#дҝқеӯҳдҝЎжҒҜhttp.cookiejar.LWPCookieJarж–№ејҸimport http.cookiejar, urllib.requestfilename = 'cookie.txt'cookie = http.cookiejar.LWPCookieJar(file_name)handler = urllib.request.HTTPCookieProcessor(cookie)opener = urllib.request.build_opener(handler)response = opener.open('https://www.baidu.com')cookie.save(ignore_discard=True, ignore_expires=True)еҰӮжһңжғіиҰҒйҖҡиҝҮиҺ·еҸ–ж–Ү件дёӯзҡ„cookieиҺ·еҸ–зҡ„иҜқеҸҜд»ҘйҖҡиҝҮloadж–№ејҸпјҢе®ғд№ҹжңүдёӨз§Қж–№ејҸпјҢhttp.cookiejar.MozillaCookieJarе’Ңhttp.cookiejar.LWPCookieJarпјҢжғіз”Ёе“Әз§ҚиҮӘе·ұеҶіе®ҡ гҖӮhttp.cookiejar.MozillaCookieJarж–№ејҸ

import http.cookiejar, urllib.requestcookie = http.cookiejar.MozillaCookieJarcookie.load('cookie.txt', ignore_discard=True, ignore_expires=True)handler = urllib.request.HTTPCookieProcessor(cookie)opener = urllib.request.build_opener(handler)response = opener.open('https://www.baidu.com')print(response.read.decode('utf-8'))http.cookiejar.LWPCookieJarж–№ејҸimport http.cookiejar, urllib.requestcookie = http.cookiejar.LWPCookieJarcookie.load('cookie.txt', ignore_discard=True, ignore_expires=True)handler = urllib.request.HTTPCookieProcessor(cookie)opener = urllib.request.build_opener(handler)response = opener.open('https://www.baidu.com')print(response.read.decode('utf-8'))urllib parseжЁЎеқ—е®ғжҳҜиҙҹиҙЈи§ЈжһҗйЎөйқўеҶ…е®№пјҢжЁЎеқ—дёӢжңүдёҖдёӘurlparseж–№жі•з”ЁдәҺжӢҶеҲҶи§ЈжһҗеҶ…е®№пјҢе…·дҪ“з”Ёжі•еҰӮдёӢпјҡ

urllib.parse.urlparse(url,scheme)URLпјҡйЎөйқўең°еқҖscheme: еҚҸи®®зұ»еһӢпјҢжҜ”еҰӮ http https

жҺЁиҚҗйҳ…иҜ»

- JDKйҮҢйқўиҮӘеёҰдәҶиҝҷд№ҲеӨҡзҡ„exeпјҢдҪ йғҪжҢЁзқҖиҜ•иҝҮд№Ҳпјҹ

- PythonжөҒзЁӢжҺ§еҲ¶иҜӯеҸҘиҜҰи§Ј

- PythonзәҝзЁӢзҡ„з”ҹе‘Ҫе‘ЁжңҹдҪ зҹҘйҒ“еӨҡе°‘пјҢдёҖж–Үеё®дҪ е…ЁйғЁжҗһжё…жҘҡ

- дҪҝз”ЁPython+Fabricе®һзҺ°LinuxиҮӘеҠЁеҢ–ж“ҚдҪң

- PythonеҫӘзҺҜиҜӯеҸҘд»Јз ҒиҜҰи§ЈпјҡwhileгҖҒforгҖҒbreak

- еҮӯеҖҹиҝҷ5жӯҘпјҢжҲ‘30еҲҶй’ҹеӯҰдјҡдәҶPythonзҲ¬иҷ«

- зңҹйҰҷпјҒPythonеҚҒеӨ§еёёз”Ёж–Ү件ж“ҚдҪңпјҢиҪ»жқҫеҠһе…¬

- еҲ«еҶҚз”ЁжүӢж•ІдәҶпјҢиҝҷдёӘе·Ҙе…·еҸҜд»ҘиҮӘеҠЁз”ҹжҲҗpythonзҲ¬иҷ«д»Јз Ғ

- зӣ’马еҸҜд»ҘеҠ е·ҘиҮӘеёҰжө·йІңеҗ— зӣ’马зҺ°еңәд№°дәҶжө·йІңеҰӮдҪ•еҠ е·Ҙ

- дҪҝз”ЁpythonзҲ¬еҸ–жҠ–йҹіappи§Ҷйў‘