дҪ еҘҪпјҢйә»зғҰеё®жҲ‘жҹҘдёҖдёӢRedisйҮҢеӨ§дәҺ10KBзҡ„жүҖжңүkey

жӮЁеҘҪпјҢеё®еҝҷжҹҘдёҖдёӢRedisдёӯй•ҝеәҰеӨ§дәҺ5000зҡ„hash key

жҳҜдёҚжҳҜеҸ‘зҺ°з”Ё--bigkeysдёҚиЎҢдәҶпјҲеҪ“然еҰӮжһңж”№жәҗз Ғд№ҹдёҚжҳҜеӨӘйҡҫпјүпјҢдҪҶжңүжІЎжңүжӣҙеҝ«жҚ·зҡ„ж–№жі•пјҢRedisжҸҗдҫӣдәҶdebug object ${key}е‘Ҫд»ӨиҺ·еҸ–й”®еҖјзҡ„зӣёе…ідҝЎжҒҜпјҡ

127.0.0.1:6379> hlen big:hash(integer) 5000000127.0.0.1:6379> debug object big:hashValue at:0x7fda95b0cb20 refcount:1 encoding:hashtable serializedlength:87777785 lru:9625559 lru_seconds_idle:2(1.08s)е…¶дёӯserializedlengthиЎЁзӨәkeyеҜ№еә”зҡ„valueеәҸеҲ—еҢ–д№ӢеҗҺзҡ„еӯ—иҠӮж•°пјҢеҪ“然еҰӮжһңжҳҜеӯ—з¬ҰдёІзұ»еһӢпјҢе®Ңе…ЁзңӢеҸҜд»Ҙжү§иЎҢstrlenпјҢдҫӢеҰӮпјҡ

127.0.0.1:6379> strlen key(integer) 947394иҝҷж ·дҪ е°ұеҸҜд»Ҙз”Ёscan + debug objectзҡ„ж–№ејҸйҒҚеҺҶRedisжүҖжңүзҡ„й”®еҖјпјҢжүҫеҲ°дҪ йңҖиҰҒйҳҲеҖјзҡ„ж•°жҚ®дәҶ гҖӮ

дҪҶжҳҜеңЁдҪҝз”Ёdebug objectж—¶еҖҷдёҖе®ҡиҰҒжіЁж„Ҹд»ҘдёӢеҮ зӮ№пјҡ

(1) debug object bigkeyжң¬иә«еҸҜиғҪе°ұдјҡжҜ”иҫғж…ўпјҢе®ғжң¬иә«е°ұдјҡеӯҳеңЁйҳ»еЎһRedisзҡ„еҸҜиғҪ

(2) е»әи®®еңЁд»ҺиҠӮзӮ№жү§иЎҢ

(3) е»әи®®еңЁиҠӮзӮ№жң¬ең°жү§иЎҢ

(4) еҰӮжһңдёҚе…ізі»е…·дҪ“еӯ—иҠӮж•°пјҢе®Ңе…ЁеҸҜд»ҘдҪҝз”Ёscan + strlen|hlen|llen|scard|zcardжӣҝд»ЈпјҢ他们йғҪжҳҜo(1)

3 memory usage

дёҠйқўзҡ„debug objectеҸҜиғҪдјҡжҜ”иҫғеҚұйҷ©гҖҒиҖҢдё”дёҚеӨӘеҮҶзЎ®пјҲеәҸеҲ—еҢ–еҗҺзҡ„й•ҝеәҰпјүпјҢжңүжІЎжңүжӣҙеҮҶзЎ®зҡ„е‘ўпјҹRedis 4.0ејҖе§ӢжҸҗдҫӣmemory usageе‘Ҫд»ӨеҸҜд»Ҙи®Ўз®—жҜҸдёӘй”®еҖјзҡ„еӯ—иҠӮж•°пјҲиҮӘиә«гҖҒд»ҘеҸҠзӣёе…іжҢҮй’ҲејҖй”ҖпјҢе…·дҪ“зҡ„з»ҶиҠӮеҗҺйқўжңүж–Үз« дјҡеҲҶжһҗпјүпјҢдҫӢеҰӮдёӢйқўжҳҜдёҖж¬Ўжү§иЎҢз»“жһңпјҡ

127.0.0.1:6379> memory usage big:hash(integer) 318663444дёӢйқўжҲ‘们жқҘеҜ№жҜ”е°ұеҸҜд»ҘзңӢеҮәжқҘпјҢеҪ“еүҚзі»з»ҹе°ұдёҖдёӘkeyпјҢжҖ»еҶ…еӯҳж¶ҲиҖ—жҳҜ400MBе·ҰеҸіпјҢmemory usageзӣёжҜ”debug objectиҝҳжҳҜиҰҒзІҫзЎ®дёҖдәӣзҡ„ гҖӮ

127.0.0.1:6379> dbsize(integer) 1127.0.0.1:6379> hlen big:hash(integer) 5000000#зәҰ300MB127.0.0.1:6379> memory usage big:hash(integer) 318663444#зәҰ85MB127.0.0.1:6379> debug object big:hashValue at:0x7fda95b0cb20 refcount:1 encoding:hashtable serializedlength:87777785 lru:9625814 lru_seconds_idle:9(1.06s)127.0.0.1:6379> info memory# Memoryused_memory_human:402.16MеҰӮжһңдҪ дҪҝз”ЁRedis 4.0+пјҢдҪ е°ұеҸҜд»Ҙз”Ёscan + memory usage(pipeline)дәҶпјҢиҖҢдё”еҫҲеҘҪзҡ„дёҖзӮ№жҳҜ,memoryдёҚдјҡжү§иЎҢеҫҲж…ўпјҢеҪ“然дҫқ然жҳҜе»әи®®д»ҺиҠӮзӮ№ + жң¬ең°гҖӮ

4.е®ўжҲ·з«Ҝ

дёҠйқўдёүз§Қж–№ејҸйғҪжңүдёҖдёӘй—®йўҳпјҢе°ұжҳҜ马еҗҺзӮ®пјҢеҰӮжһңжғіеҫҲе®һж—¶зҡ„жүҫеҲ°bigkeyпјҢдёҖж–№йқўдҪ еҸҜд»ҘиҜ•иҜ•дҝ®ж”№Redisжәҗз ҒпјҢиҝҳжңүдёҖз§Қж–№ејҸе°ұжҳҜеҸҜд»Ҙдҝ®ж”№е®ўжҲ·з«ҜпјҢд»ҘjedisдёәдҫӢпјҢеҸҜд»ҘеңЁе…ій”®зҡ„еҮәе…ҘеҸЈеҠ дёҠеҜ№еә”зҡ„жЈҖжөӢжңәеҲ¶пјҢдҫӢеҰӮд»ҘJedisзҡ„иҺ·еҸ–з»“жһңдёәдҫӢеӯҗпјҡ

protected Object readProtocolWithCheckingBroken() { Object o = null; try {o = Protocol.read(inputStream);return o; }catch(JedisConnectionException exc) {UsefulDataCollector.collectException(exc, getHostPort(), System.currentTimeMillis());broken = true;throw exc; }finally {if(o != null) {if(o instanceof byte[]) {byte[] bytes = (byte[]) o;if (bytes.length > threshold) {// еҒҡеҫҲеӨҡдәӢжғ…пјҢдҫӢеҰӮз”ЁELKе®ҢжҲҗ收йӣҶе’Ңеұ•зӨә}}} }}5.зӣ‘жҺ§жҠҘиӯҰ

bigkeyзҡ„еӨ§ж“ҚдҪңпјҢйҖҡеёёдјҡеј•иө·е®ўжҲ·з«Ҝиҫ“е…ҘжҲ–иҖ…иҫ“еҮәзј“еҶІеҢәзҡ„ејӮеёёпјҢRedisжҸҗдҫӣдәҶinfo clientsйҮҢйқўеҢ…еҗ«зҡ„е®ўжҲ·з«Ҝиҫ“е…Ҙзј“еҶІеҢәзҡ„еӯ—иҠӮж•°д»ҘеҸҠиҫ“еҮәзј“еҶІеҢәзҡ„йҳҹеҲ—й•ҝеәҰпјҢеҸҜд»ҘйҮҚзӮ№е…іжіЁдёӢпјҡ

127.0.0.1:6379> info clientsclient_longest_output_list:xxxxxclient_biggest_input_buf:xxxxxеҰӮжһңжғізҹҘйҒ“е…·дҪ“зҡ„е®ўжҲ·з«ҜпјҢеҸҜд»ҘдҪҝз”Ёclient listе‘Ҫд»ӨжқҘжҹҘжүҫ

redis-cli client listid=3 addr=127.0.0.1:58500 fd=8 name= age=3978 idle=25 flags=N db=0 sub=0 psub=0 multi=-1 qbuf=0 qbuf-free=0 obl=0 oll=0 omem=26263554 events=r cmd=hgetall6.ж”№жәҗз Ғ

иҝҷдёӘе…¶е®һд№ҹжҳҜиғҪеҒҡзҡ„пјҢдҪҶжҳҜеҗ„ж–№йқўжҲҗжң¬жҜ”иҫғй«ҳпјҢеҜ№дәҺдёҖиҲ¬е…¬еҸёжқҘиҜҙдёҚйҖӮз”Ё гҖӮ

жҲ‘дёӘдәәзҡ„жңҖдҪіе®һи·өе°ұжҳҜпјҡ

(1) Redisз«ҜдёҺе®ўжҲ·з«Ҝзӣёз»“еҗҲпјҡ--bigkeysдёҙж—¶з”ЁгҖҒscanй•ҝжңҹеҒҡжҺ’йҷӨйҡҗжӮЈпјҲе°ҪеҸҜиғҪжң¬ең°еҢ–пјүгҖҒе®ўжҲ·з«Ҝе®һж—¶зӣ‘жҺ§ гҖӮ

(2) зӣ‘жҺ§жҠҘиӯҰиҰҒи·ҹдёҠ

(3) debug objectе°ҪйҮҸе°‘з”Ё

(4) жүҖжңүж•°жҚ®е№іеҸ°еҢ–

(5) иҰҒе’ҢејҖеҸ‘еҗҢеӯҰејәи°ғbigkeyзҡ„еҚұе®і

дә”гҖҒеҰӮдҪ•еҲ йҷӨ

еҰӮжһңеҸ‘зҺ°дәҶbigkeyпјҢиҖҢдё”зЎ®и®ӨжҳҜеһғеңҫжҳҜдёҚжҳҜзӣҙжҺҘdelе°ұеҸҜд»ҘдәҶпјҢжқҘзңӢдёҖз»„ж•°жҚ®пјҡ

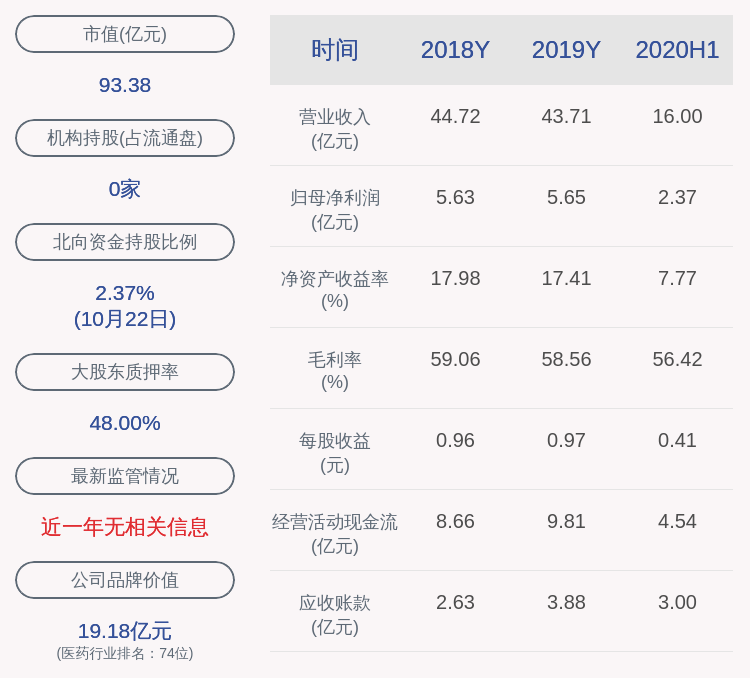

ж–Үз« жҸ’еӣҫ

еҸҜд»ҘзңӢеҲ°еҜ№дәҺstringзұ»еһӢпјҢеҲ йҷӨйҖҹеәҰиҝҳжҳҜеҸҜд»ҘжҺҘеҸ—зҡ„ гҖӮдҪҶеҜ№дәҺдәҢзә§ж•°жҚ®з»“жһ„пјҢйҡҸзқҖе…ғзҙ дёӘж•°зҡ„еўһй•ҝд»ҘеҸҠжҜҸдёӘе…ғзҙ еӯ—иҠӮж•°зҡ„еўһеӨ§пјҢеҲ йҷӨйҖҹеәҰдјҡи¶ҠжқҘи¶Ҡж…ўпјҢеӯҳеңЁйҳ»еЎһRedisзҡ„йҡҗжӮЈ гҖӮжүҖд»ҘеңЁеҲ йҷӨе®ғ们时еҖҷе»әи®®йҮҮз”ЁжёҗиҝӣејҸзҡ„ж–№ејҸжқҘе®ҢжҲҗпјҡhscanгҖҒltrimгҖҒsscanгҖҒzscan гҖӮ

жҺЁиҚҗйҳ…иҜ»

- йҳҝйҮҢе·ҙе·ҙжҖҺд№ҲејҖеә—жіЁеҶҢжөҒзЁӢ еҰӮдҪ•йҳҝйҮҢе·ҙе·ҙејҖеә—жӯҘйӘӨ

- RedisеҺҹзҗҶеҲҶдә«пјҢд»ҺдҪҝз”ЁеҲ°дјҡз”Ё

- RedisеёғйҡҶиҝҮж»ӨеҷЁ

- зҒ«зғ§дә‘зҡ„еҪўзҠ¶еғҸд»Җд№Ҳ д»Җд№ҲжҳҜзҒ«зғ§дә‘,зҒ«зғ§дә‘жҳҜжҖҺд№ҲеҪўжҲҗзҡ„

- еҸҢеҚҒдёҖйҳҝйҮҢе·ҙе·ҙеёӮеҖј еҸҢ11йҳҝйҮҢе·ҙе·ҙиӮЎзҘЁдёӢйҷҚ

- йҳҝйҮҢеұұзҸ зӮүиҢ¶д»Ӣз»Қ

- жҷ®жҙұиҢ¶еҸЈж„ҹдёӯеҪұе“Қе”җдә‘зҡ„еӣ зҙ

- Redisе“ҲеёҢзұ»еһӢ

- зҪ‘з«ҷеј•е…ҘйҳҝйҮҢдә‘ж»‘еқ—йӘҢиҜҒз Ғе®һзҺ°дәәжңәдәӨдә’ж•ҷзЁӢ

- йҳҝйҮҢж—әж—әжҖҺд№Ҳз”Ё йҳҝйҮҢж—әж—әдё»иҰҒеҠҹиғҪ