|当年轻人开始谈论AI伦理

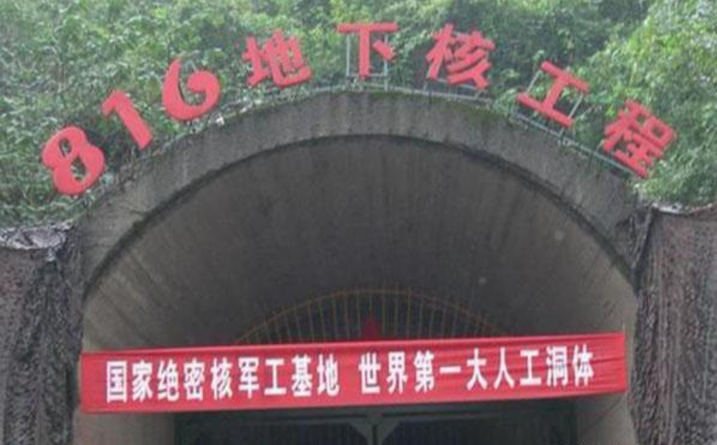

本文插图

图片来源@视觉中国

文丨Alter

赛博朋克的电影里 , 常常可以看到这样的构想:

社会已经被财阀集团所控制 , 人工智能充当了统治的工具 , 所有人的行为都要遵循机器的逻辑、服从算法的规则 。 然后生活在社会最底层的主角 , 找到了其中的漏洞并尝试走出被操控的宿命 。

可能在大多数的认知里 , 类似的反乌托邦世界离我们还很遥远 。 但当人工智能技术从象牙塔走进现实生活 , 与AI伦理有关的议题逐渐成为学术界争论的焦点 , 甚也有一些年轻人也开始思考算法的伦理和风险 。

比如在B站上小有名气的视频博主“在下小苏”制作的一期内容里 , 对DeepFake、人机恋爱等话题进行了讨论, 诸如DeepFake等黑科技被用来恶搞甚至是作恶的时候 , 我们对人工智能应该秉持什么样的态度?一旦“技术中立”被越来越多人抨击 , 我们应该如何处理新时代的人机关系?

或许AI伦理的概念还有些宏观 , 却是与每一个人息息相关的事 。

01 无处不在的算法歧视

人工智能离我们并不遥远 。

当你打开资讯应用时 , 算法会根据你的喜好自动推荐新闻;当你去电商平台购物的时候 , 算法会结合你的习惯推荐对应的商品;当你去求职应聘的时候 , 首先处理简历并进行筛选的可能也是算法;当你去医院看病就医的时候 , 医生可能会利用某个算法模型来判断患病的可能性……

算法正在以前所未有的速度渗透到我们的生活中 。 在支持者眼中 , 算法可以在一些决策中减少人为干预 , 进而提升决策 的效率和准确性 。 可从批判的角度出发 , 算法是否带有人为的偏见 , 人们的命运是否会被算法左右?

遗憾的是 , 算法歧视现象往往是算法落地应用的衍生品 。

亚马逊曾在2014年开发了一套“算法筛选系统” , 目的是在招聘的时候帮助HR筛选简历 , 开发团队打造了500个算法模型, 同时教算法识别50000个曾经在简历中出现的术语 , 然后对应聘者的不同能力分配权重 。

最后开发团队却发现 , 算法对男性应聘者有着明显的偏好 , 如果识别出简历中有女子足球俱乐部、女子学校等经历时 , 就会对简历给出相对比较低的分数 。 这个算法模型最终被路透社曝光 , 亚马逊也适时停止了算法的使用 , 令人深思的却是:为何“没有价值观”的算法开始有了偏见?

无独有偶 , 2018年IG夺冠的喜讯让互联网沸腾的时候 , 战队老板王思聪随即在微博上进行抽奖 , 结果却出人意料:获奖名单中有112名女性获奖者和1名男性获奖者 , 女性获奖者比率是男性的112倍 , 而参与用户的男女比率是1:1.2 。

于是不少网友质疑抽奖算法的公平性 , 甚至有网友主动测试抽奖算法 , 将获奖人数的设置大于参与人数 , 仍然有大量用户无法获奖 。 原因是这些用户被算法判定为“机器人” , 意味着在任何抽奖活动中都没有中奖的机会 。

在算法的黑匣子面前 , 我们看到的大多只有结果 , 却无法理解决策的过程 。 与之相似的案例可能比比皆是 , 不过是鲜有人关注罢了 。

最直接的教训就是互联网 , 硅谷自由的法度诞生了互联网 , 以至于一些原罪被人们选择性忽略 , 最终在20多年后出现了一轮轮对互联网的批判 。 正如纽约时报在《减少互联网是唯一的答案》一文中 , 将互联网归结为带有集权主义意识形态的技术 , 互联网企业被形容为一群驱使着技术的“邪恶魔王” 。

对互联网的批判大概率不会让人们减少互联网的使用 , 却给出了一个思路:为何互联网会从万众仰慕的行业沦为过街老鼠 , 倘若算法的应用和算法歧视现象不被制约 , 又将在未来某一天掀起多大的波澜?

【|当年轻人开始谈论AI伦理】02 根源在于人性的偏见

推荐阅读

- 大京网|有车一族高品位选择,从图拉斯车载香薰开始

- 香薰|有车一族高品位选择,从图拉斯车载香薰开始

- 数评时代|想在5000元档位打开局面?三星Note 20开始大幅降价

- 科学|澳洲母牛开始吃蛇,专家称缺乏营养,是真的吗?这预示着什么?

- 智能手机那点事|发布至今跌至1369,5000mAh+5G+90Hz,OPPO开始发力

- 三月数码帮资讯|雷军开始出手,小米11全系曝光,屏下无望,续航巅峰

- 企业|当我们谈论京东11.11 B端新主场的时候,在谈论些什么?

- 华为|下载速度每秒1TB,苹果、高通等联手预研6G:华为早已开始

- 新机发布|华为20点正式官宣,又有1款华为手机,开始公测最新华为系统了

- 映维网|Oculus Quest v23软件更新正式推出,开始支持90Hz