量子位▲| 已开源,李沐团队提出最强ResNet改进版,多项任务达到SOTA( 二 )

文章图片

这就表明 , 如果一个模型由更多的Split-Attention模块组成 , 那么它的效果会更好 。

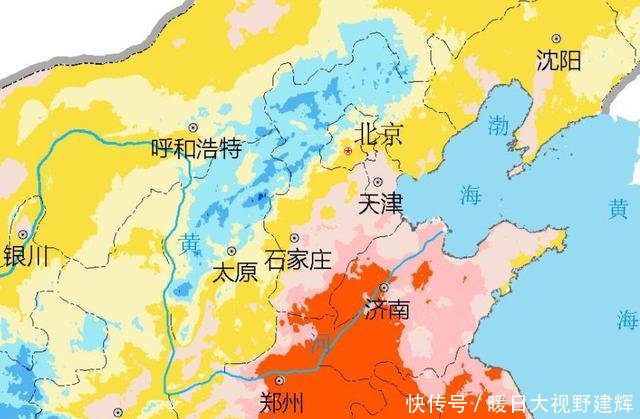

语义分割在语义分割下游任务的转移学习中 , 使用DeepLabV3的GluonCV实现作为基准方法 。

从下表中不难看出 , ResNeSt将DeepLabV3模型实现的mIoU提升了约1% , 同时保持了类似的整体模型复杂度 。

文章图片

值得注意的是 , 使用ResNeSt-50的DeepLabV3模型的性能 , 比使用更大的ResNet-101的DeepLabV3更好 。

ResNeSt:注意力分割网络性能如此卓越 , 到底是对ResNet做了怎样的改良呢?

接下来 , 我们就来揭开ResNeSt的神秘面纱 。

正如刚才我们提到的 , ResNeSt是基于ResNet , 引入了Split-Attention块 , 可以跨不同的feature-map组实现feature-map注意力 。

Split-Attention块是一个计算单元 , 由feature-map组和分割注意力操作组成 。 下2张图便描述了一个Split-Attention块 , 以及cardinalgroup中的split-Attention 。

文章图片

文章图片

从上面的2张图中不难看出 , 都有split的影子 。 比如K(k)和R(r)都是超参数 , 也就是共计G=K*R组 。

除此之外 , 也可以与SE-Net和SK-Net对比着来看 。

其中 , SE-Net引入了通道注意力(channel-attention)机制;SK-Net则通过两个网络分支引入特征图注意力(feature-mapattention) 。

ResNeSt和SE-Net、SK-Net的对应图示如下:

文章图片

研究人员介绍

文章图片

李沐 , 亚马逊首席科学家 , 加州大学伯克利分校客座助理教授 , 美国卡内基梅隆大学计算机系博士 。

专注于分布式系统和机器学习算法的研究 。 他是深度学习框架MXNet的作者之一 。

曾任机器学习创业公司MarianasLabs的CTO和百度深度学习研究院的主任研发架构师 。

李沐有着丰富的研究成果 , 曾先后在国内外主流期刊上发表多篇学术论文 , 其中《DiFacto—DistributedFactorizationMachines》在ACM国际网络搜索和数据挖掘(WSDM)大会上被评为最佳论文奖 。

传送门论文地址:https://hangzhang.org/files/resnest.pdf

GitHub项目地址:https://github.com/zhanghang1989/ResNeSt

—完—

量子位QbitAI·***签约

关注我们 , 第一时间获知前沿科技动态

推荐阅读

- 可可酱75吋量子点电视让孩子健康成长,如何才能健康不伤眼的看电视?TCL

- 中国智能制造网量子通信布局起风了!,多国已未雨绸缪

- 「量子力学」爱因斯坦也束手无策,困扰人类上百年的难题,如今终于有了答案

- 与单观经欧盟瞄准“量子互联网”附相关概念股

- 广东圆梦园孵化城【园区动态】广东省重点领域研发计划量子科学与工程重大专项专家组莅临园区考察指导

- 万微科技2016开源聊天机器人 Blender,更具“人情味”,Facebook

- 「化石」转生将可能是一件真事,量子力学的最新发现,科学家也被震撼

- cnBeta微软研究人员攻克了两个已有20年历史的量子计算问题

- JEECG开源社区Boot 2.2 首个里程碑版本发布,低代码平台,Jeecg

- 星火方块| 碳纳米管荧光量子效率研究取得进展,进展